検索避けの方法|Googleで表示・検索・アクセスされないようにしたい

検索よけといってもrobots.txtやnoindexでグーグルの検索エンジンに引っかからなくする方法やページを削除せずにパスワード保護する方法など、用途に応じた方法が存在します。SEOでも基本的ですが重要なテクニックなので改めておさらいしていきましょう。

2021年12月10日 7:00

「検索避け」には3つのやり方がある。そのうち確実に検索で出なくできるのは……。基本だが重要なテクニックを改めて理解しておこう。

ほかにも、「重複コンテンツペナルティ(なるもの)」「301リダイレクトは1年で外していい件の続報」などなど、あなたのSEO力をアップさせる情報を今回もまとめてお届けする。

1ページ目最後の「大規模サイト移転の事例」や2ページ目最初の「Googlebotがrobots.txtを無視してクロールする場合」も、なかなか興味深いトピックだ。ぜひチェックしてほしい。

- 【SEO都市伝説】重複コンテンツペナルティなるものはグーグルには存在しない

- 【続報】グーグル公式「301リダイレクトは1年経ったら外していいよ」の背景

- 別サイトのサイトマップでも設定できるクロスサイト送信とは?

- グーグルでも検索セントラルへのサイト移転にこれだけ苦労していた!

- 【SEOクイズ】Googlebotがrobots.txtを無視してクロールすることはあるか?

- noindexページの再インデックス促進には内部リンクが役立つ

- 11月のポリシーオフィスアワー: URL変更でアクセス減、YMYLに属するカテゴリ、公的サイトの中古ドメインほか

- WPのウェブストーリー プラグインが日本語で使えるようになった

- 白の背景に白のロゴはNG、グーグルが注意喚起

- Googleにインデックスされないのは品質の水準が以前よりも厳しくなったためか?

- 【December 2021 Product Reviews Update】商品レビューに関するアップデートの2021年12月版をGoogleが実施

今週のピックアップ

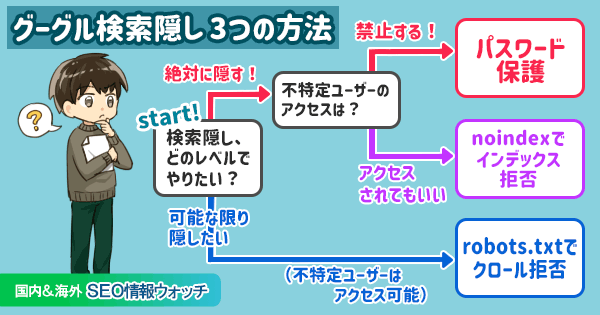

グーグル検索避け3つの方法、確実に検索に表示させないようにするには

目的に応じて使い分ける (#AskGooglebot on YouTube) 海外情報

管理サイトのコンテンツが検索結果に出ないようにするための方法を、グーグルのジョン・ミューラー氏が動画で簡潔に解説した。

次の3つの手段をミューラー氏は提案している:

- パスワード保護

- クロール拒否(robots.txt)

- インデックス拒否(noindex)

ミューラー氏によるそれぞれの解説を簡潔にまとめる。

パスワード保護、つまりパスワードを入力しないとアクセスできないようにする方法は、最も安全だ。検索エンジンのクローラもパスワードなしではアクセスできない。

- 検索結果での表示:防げる

- 不特定ユーザーのアクセス:防げる

robots.txtでクロールを拒否することもできる。(robots.txtに従う)クローラはアクセスできない。

ただし理想的な方法ではない。レアケースだが、コンテンツをクロールしなくてもURLをインデックスする(検索結果に表示する)ことがあるからだ※。

- 検索結果での表示:表示される場合もある

- 不特定ユーザーのアクセス:アクセスされる

※Web担編注 robots.txtでクロールをブロックしていても、他のサイトからリンクが張られるなどした場合には検索結果に表示されることもあると、グーグル公式のrobots.txtの解説にも示されている(ただし次の画像のように検索結果ページ上ではほぼ情報が表示されない)

noindexをrobots metaタグで指定してインデックスを拒否する方法もある。検索エンジンには、クロールした後にインデックスしないように(検索結果に表示しないように)命令できる。ユーザーは依然として普通にアクセスできる。

- 検索結果での表示:防げる

- 不特定ユーザーのアクセス:アクセスされる

推奨するやり方はパスワード保護だ。不特定のユーザーからコンテンツを安全に非公開にできる。

ただし、「コンテンツを非公開にする必要がない場合」「一部のページだけを検索結果に出ないようにするだけでいい場合」には、robots.txtでクロールを拒否したりnoindexでインデックスを拒否したりといったやり方も便利だ。

3つとも設定できるようになっておきたい。達成したい目的に応じて使い分けるといい。

- すべてのWeb担当者 必見!

- 技術がわかる人に伝えましょう

グーグル検索SEO情報①

【SEO都市伝説】重複コンテンツペナルティなるものはグーグルには存在しない

順位が下がったのは品質が原因と思われる (reddit) 海外情報

サイトの検索トラフィックが激減した!

原因は、重複コンテンツペナルティだろう。サイト内の全ページに共通のナビゲーションメニューを設置したことが理由で、重複コンテンツペナルティを受けたのだ。

そう考えるサイト管理者に、グーグルのジョン・ミューラー氏は次のように指摘した:

それが原因かどうかは疑わしい。理由の1つは「重複コンテンツ ペナルティというものは存在しない」ことにある。

検索トラフィックが減った本当の原因はサイト全体の品質にあるのではないかと私には思える。HTMLをいじっても品質は改善できないだろう。

重複コンテンツ自体は、ウェブでは当たり前のように発生する現象だ。原則として重複コンテンツが理由でペナルティ(つまり手動対策)を受けることはない(悪意をもって同じようなコンテンツを複製したりしない限りは)。

特に大規模サイトでは、クロール効率の観点からは重複コンテンツは減らすに越したことはない。だが、順位を下げる「重複コンテンツ ペナルティ」なるものは実際にはグーグルには存在しないということは理解しておきたい。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

【続報】グーグル公式「301リダイレクトは1年経ったら外していいよ」の背景

1年あれば安心、でもできるだけ長く保持したい (#AskGooglebot on YouTube) 海外情報

サイトを移転したときは、どのくらいの期間リダイレクトを保っておけばいいのか?

この質問にグーグルのジョン・ミューラー氏が動画で回答した。

サイト移転の際は、恒久的な移転を意味する301リダイレクトを私たちは推奨している。とはいえ、現実世界では「恒久的」ということはあり得ない。

グーグルは、どんなURLでも数か月に1回はクロールするようにしている(ほとんどのURLはもっと頻繁にクロールしている)。たくさんのURLをクロールしたいのはやまやまだが、実際にはリソースには限りがあるので優先度を付けなければならない。

URLが変わった場合、グーグルのシステムは、数回クロールして同じ結果だったならばその変更を記録する。リダイレクトが数回確認されることを確実にするためには、最低でも1年間はリダイレクトを保持しておくことを推奨している。

付け加えるなら、古いURLを参照しているリンクを新しいURLに更新しておくことも大切だ。自分のサイト内のリンクに関してもだし、外部サイトからの重要なリンクに関してもだ。

今説明したのは簡素化したものだ。1年よりも長くリダイレクトを保っておけるなら、そうするほうがいい。とはいえ、少なくとも1年間はリダイレクトを保持しておけば、ある意味では十分ではある。

リダイレクトは1年を目安に設定しておけば解除したとしてもいいということを2019年の1月にミューラー氏が発言し、さらにリダイレクトを解除してもグーグル検索では評価は引き継がれたままだという(衝撃の)事実を今年の8月にイリェーシュ氏が発言していた。

どうやら1年というのは、リダイレクトを確実に認識するために必要なクロールの回数を確保する意味だったようだ。どんなURLでも1年あれば3〜4回程度は少なくともクロールされるからというのが理由なのだろう。頻繁にクロールされるURLならもっと短い期間、たとえば1か月でリダイレクトを止めても、おそらく転送処理は継続しそうだ。

そうは言っても、可能な限り長い期間リダイレクトを継続しておくことが望ましい。その理由としては、たとえば次のようなものがある:

「1年でいい」と明確に言っているのはグーグルだけであり、グーグル以外の検索エンジンもウェブには存在する。

他サイトから張られているリンクや印刷物に記載したURLをすべて変えてもらうのでなければ、旧URLにアクセスしようとするユーザーはなくならない。

リダイレクトを解除してしまえば、旧URLにアクセスしたユーザーは変更後のURLには自動転送されなくなる。

ドメイン名を手放すと、想定しない悪質な業者がそのドメイン名を使ってよろしくないサイトを作ってしまう可能性がある。

個人的には、サイトを移転した際には、可能な限り旧ドメイン名の契約を保持してリダイレクトするべきだと考えている。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

別サイトのサイトマップでも設定できるクロスサイト送信とは?

14年も前からサポートされていた機能 (Max Prin & John Mueller on Twitter) 海外情報

サイトのXMLサイトマップを別のサイトに配置しておけるって知ってた? 両方のサイトがGoogle Search Consoleで確認済みなら大丈夫なんだよ。

こんな情報をご存じだっただろうか。「クロス送信(Cross Submission)」とも呼ばれる機能だ。

たとえば、次の5つのドメイン名のサイトを管理していたとする:

www1.example.comwww2.example.comwww.example.co.jpwww.example999.comsitemap.example.jp

このとき、5サイトの全URLをまとめたサイトマップを1つ作り、sitemap.example.jpに置いておいて問題ない。もしくは、各サイト用に作った5個のサイトマップをすべてsitemap.example.jpに置くこともできる。

基本的にはそのように「サイトマップを集中管理」するための機能だが、www1のサイトマップをwww2に置いて、www2のサイトマップをwww3に置くなども可能だ(意味があるかは別として)。

ただし条件がある。Search Console経由でサイトマップ送信するときは、すべてのサイトを所有者確認しておかなければならない。第三者が勝手にサイトマップを送信するのを防ぐためだ。

クロスサイト送信は新しい機能ではない。14年近く前の2008年2月にグーグルはサポートを始めた。検索セントラルのサイトマップ技術ドキュメントにもきちんと説明がある。

サイトマップを集中管理するもう1つのやり方に、サイトマップの場所をrobots.txtで指定する方法がある。別サイトに置いてあるサイトマップのURLをrobots.txtに記述すればいい。

たとえば、sitemap.example.jpのrobots.txtに次のように記述できる:

Sitemap: https://www1.example.com/sitemap.xmlSitemap: https://www2.example.com/sitemap.xmlSitemap: https://www3.example.com/sitemap.xmlSitemap: https://www.example999.com/sitemap.xml

この場合、Search Consoleで所有者確認は不要だ。通常、robots.txtを編集できるのはそのサイトの管理権限をもっている人なので、別のサイトに置いてあるサイトマップを参照するのは自らの意思によるものだという証明になる。

クロスサイト送信は特に大規模サイトで役に立つ機能だ。1か所でサイトマップを管理できる利点がある。また、hreflangをサイトマップで設定するときも便利だろう。meta タグで設定するよりも識別しやすくなる。

もしかしたら、グーグルが頻繁にクロールしてくるサイトにサイトマップを集約することで、グーグルが新しいURLを見つけるタイミングを早める効果もあるかもしれない。

Did you know that one website’s XML Sitemaps can be hosted on another site, as long as both properties are verified in GSC? ✅

— Max Prin (@maxxeight) November 24, 2021

It’s a perfectly valid practice called “cross-site submission”. Very useful for agencies when it comes to hreflang tags.

https://t.co/E8Tj8j5b7I pic.twitter.com/ymGBmXcu5Q

You can also just specify it in the robots.txt file - it's sometimes a bit easier than having to fiddle with verification.

— 🧀 John 🧀 (@JohnMu) November 24, 2021

- ホントにSEOを極めたい人だけ

グーグルでも検索セントラルへのサイト移転にこれだけ苦労していた!

移行体験には役立つ情報あり (グーグル 検索セントラル ブログ) 国内情報

サイト移転とコンテンツ再編成の具体的な事例を紹介する。どんな施策を実施してどんな風に検索トラフィックを伸ばしたか、詳細でわかりやすく解説してくれている。

事例の舞台は、グーグルの「ウェブマスターセントラル」から「検索セントラル」への移行と再編成だ。

グーグルは、サイト管理に関連するリソースやツールを「検索セントラル」として提供するように、1年前に変更した。それまでは「ウェブマスターセントラル」という名称を用いていた。リソースの配置や構成も大規模に再編成した。

1周年を迎え、これまでの振り返りを検索セントラルブログで報告している。

名称変更に伴うコンテンツの再編成にはURLのおおがかりな変更も要求された。URL変更を伴うサイト移転は、興味深いと言うべきかそれとも当然と言うべきか、SEOも意識して実行された。

グーグル社内のSEO担当者に相談し(!)、たとえば次のような施策を行ったそうだ:

- 数千ものURLのサイト移行を管理

- 機能しないリダイレクトを特定

- 200 以上のページでタイトル要素と説明文を改善

- 移転は優先度の高いものから開始(読者からの閲覧数が多く優先度の高いドキュメントや、トラフィックを増やす必要があると思われるドキュメントなど)

- トラフィックの最適化を解除するケースもあった(検索で見つけやすくすると勘違いやトラブルにつながりがちなコンテンツなど)

あわせて次のようなことも実行し、ユーザーのニーズをさらに満たすサイトにしていったということだ:

- 既存ドキュメントの再構成

- 新規ドキュメントの追加

- 13言語にわたるブログの移行

- トップページでは、ユーザーが選択した役割に基づいておすすめの記事を表示する新しいウィジェットを配置

こうした改善の結果、次のような成果を得られたという:

2021年1月から2021年10月までのグーグル検索からのトラフィックは、前年同期間と比較して240%増加

検索セントラル ブログ(新サイト)のパフォーマンスは、ウェブマスター セントラル ブログ(旧サイト)を上回る:

- クリック数は159%増加

- インプレッション数は23%増加

Search Console ヘルプセンターから移行した記事のクリック数も増加:

- サイトマップのドキュメントは99%増加

- robots.txtのドキュメントは27%増加

- HTTPSのドキュメントは66%増加

移行に際して得たという次の知見は、筆者たちにも役立つ:

1つの言語で 1つのサイトを移行するだけでも大変なのに、それぞれのパターンをもつ13言語のサイトとJavaScriptで移転するのは、頭が痛くなる作業だった

JavaScriptリダイレクトはmeta refreshリダイレクトと同じようにうまく機能した

RSSは依然として人気があり、追加しなければならなかった

グーグルだからといって特別扱いされることはなく、一般的な企業サイトや情報サイトでも行う基本的なことを地道に行っている印象だ。

ここで紹介したもの以外にも、有用な情報が散見される。ひととおり目を通しておきたい。きっとあなたのサイトにも参考になる良い情報を見つけられるはずだ。

- すべてのWeb担当者 必見!