Googleがキャッシュ保存をできるようにしてください。お願いします【SEO情報まとめ】

Googlebotのクロール効率アップと人間ユーザーへのUX改善の両方に効く、「HTTPキャッシュ標準」を取り入れるよう、グーグルが案内している。なぜこれに意味があるのか、筋道立てて理解しておこう

2025年1月24日 7:00

Googlebotのクロール効率アップと人間ユーザーへのUX改善の両方に効く、「HTTPキャッシュ標準」を取り入れるよう、グーグルが案内している。なぜこれに意味があるのか、筋道立てて理解しておこう。

2025年2回目のこのコーナー、「順位チェックツールに大打撃」「AIクローラーはJSレンダリングできない」といったクロール関連の話題に加えて、「サイトの主目的からズレれたコンテンツでサイト全体に悪影響」「CMSのレンダリング戦略」なども含めた、あなたのSEO力アップに役立つ情報を、今回もまとめてお届けする。

- Googleがキャッシュ保存をできるようにしてください。お願いします

- グーグル、順位チェックツール対策を強化。JS実行できないツールは検索できず

- AIクローラーの弱点? JSレンダリングできないし、非効率的

- Googlebot解体新書: クロールのメカニズムを正しく理解

- “今は”検索上位でも、サイトの主目的からズレれたコンテンツはサイト全体に悪影響のリスク

- 絶対に許せない! AI進化版コンテンツファームで月間数億のアクセスを稼ぐメディア

- AI生成コンテンツからバックリンク→明らかなリンクスパム

- レンダリング戦略とは? グーグル社員がわかりやすく動画で解説

- 「SEOスパムしていない」=「上位表示できる」とは限らないよね? 当たり前だけど

- 中央省庁のサイトがオンラインカジノに!? 放置サイトのハッキングには要注意

- URL検査ツールのスクリーンショットはGoogleが実際に見ている表示

- Google検索とAIは2025年にどのように進化するのか?

今週のピックアップ

Googleがキャッシュ保存をできるようにしてください。お願いします

SEO観点でもUX観点でも重要 (グーグル検索セントラルブログ) 国内情報

Google がキャッシュ保存をできるようにしてください。ぜひともお願いします。

こんなメッセージから始まるのは、グーグル検索セントラルブログが公開したHTTPキャッシュの解説記事だ。

と言っても、「サーバー側でどうキャッシュするか」という話ではない。元記事の冒頭にもあるように、「グーグルがクロール結果をキャッシュできるように、サーバーでHTTPキャッシュ有効になる設定をしましょう」という話題だ。

HTTPキャッシュとは、簡潔にいえば、ウェブページのコピーをブラウザやサーバーなどに一時的に保存して再利用していいかを制御する仕組みだ。

ブラウザの場合、1回アクセスした際に取得した内容をキャッシュとして保存し、次回のアクセスでキャッシュを再利用できれば、ネットワークを介してリソースをウェブサーバーから取得しなくていい。つまり、ページの表示速度が速くなる。また、ネットワーク通信量を削減できる利点もある。

グーグルがあなたのサイトをクロールする際にも同じことが発生する。Googlebotが1回ページをクロールした際に取得した内容をキャッシュできれば、グーグルは大量のページを何回もクロールする必要がない。

しかし、このキャッシュの仕組みは、ウェブサーバー側で「キャッシュしてOK」と指定していないと、ブラウザもGooglebotも利用できないルールとなっている(つまり、毎回サーバーに取得しにいく)。グーグルによると、「1回取得した内容をキャッシュして再利用できる率」がどんどん下がっているとのことだ。そこで「Googleがキャッシュ保存をできるようにしてください」となったわけだ。

この記事をあなたが読んで喜ぶのはグーグルだけではない。というのも、あなたのWebサーバーがキャッシュ可能なレスポンスを返すようにすれば、次のようなメリットを得られるからだ:

- グーグルのクロールによるサーバー負荷が下がる

- キャッシュによって全体のユーザー体験が良くなる(2回目以降のユーザーだけでなく、ネットワーク側でのキャッシュが効く場合もある)

ではキャッシュできるように設定すればいいのだが、「HTTPキャッシュ標準を正しく理解して、効率の良い状態にしよう」というのが、元記事の内容だ。

なぜこうした解説が必要なのか? その事情は次のような感じだ:

キャッシュは「コピー」なので、「大元のサーバーではコンテンツが更新されているのに、キャッシュは古いまま」という状態になる可能性もある。

もしコンテンツが更新されているのであれば、キャッシュを利用せずに最新の内容を取得したい(そして、今度はそれをキャッシュする)。

しかし、更新されているかどうかを調べるには、サーバーにアクセスしなければいけない。それでは毎回アクセスするのと同じで意味がない。

HTTPキャッシュの標準では、「キャッシュのこの状態から変わってたら新しいコンテンツを頂戴」とサーバーにリクエストを投げる仕組みを定めている。それを理解しておこう!

ここから先の詳しい解説は元記事に委ねるが、ざっくりとだけ解説しておこう。

GooglebotもHTTPキャッシュをサポートしている。キャッシュ制御にはいくつもの仕組みがある。Googlebotがサポートしているのは次の2つだ:

ETagとIf-None-Matchの組み合わせLast-ModifiedとIf-Modified-Sinceの組み合わせ

この2つのキャッシュ技術のうち、グーグルの推奨はETag/If-None-Matchだ。結論としては、この仕組みに対応するようにWebサーバーを設定しておくといい。

高速でページを表示するユーザー体験の観点と、Googlebotによるサーバーアクセスの負荷軽減というSEO観点の両方でHTTPキャッシュには利点がある。詳しい内容は元記事を参照してほしい。

※Web担編注 技術的な話になるが、ETagにはinode(アイノード)の情報を含めないように注意してほしい。複数サーバー構成時に重要で、セキュリティ面にも関係するのだが、ここでは詳細には解説しない。エンジニアに確認しておくといいだろう。

- ホントにSEOを極めたい人だけ

- 技術がわかる人に伝えましょう

グーグル検索SEO情報①

グーグル、順位チェックツール対策を強化。JS実行できないツールは検索できず

機械生成トラフィックはスパム行為 (SEMリサーチ) 国内情報

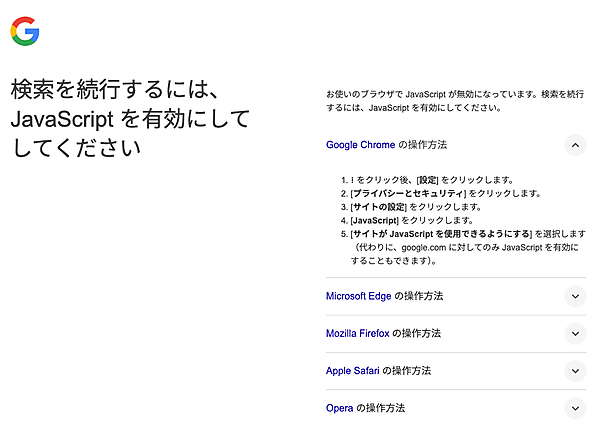

SEO用の検索順位チェックツールに大きな改修が必要となる可能性が高い変更をグーグルが実施した。

具体的には、JavaScriptの実行が検索に必要になった。多くの検索順位チェックツールはJavaScriptを実行できないため検索結果を取得できなくなり、ツールのバックエンドシステム側での改修が必要となる。

この修正で影響を受けるのは、スクレイピングツールや順位チェックツールなどだ。

とはいえ、こうしたツールはグーグル検索に自動生成クエリを送信する。そしてグーグルは、そうした「機械生成トラフィック」はスパムポリシーおよび利用規約で禁止しているのが実情だ。

詳しい背景を渡辺隆広氏が解説している。順位チェックツールの開発者、利用者またそのほかの検索結果スクレイピングツール使用者は読むといい。

うまく動作しなくなってすぐに改修し復旧したツールも多いようだが、こうしたツールの使用はグーグルの規約に違反する可能性があることも認識しておきたい。

- 順位チェックツール使ってるすべてのWeb担当者 必見!

- 技術がわかる人に伝えましょう

AIクローラーの弱点? JSレンダリングできないし、非効率的

クロールも非効率だった (Vercel) 海外情報

- LLMの学習に利用されるAIクローラーの挙動

- 従来の検索エンジンのクローラーの挙動

では、どのように違うのだろうか。クラウドプラットフォームのVercel(ヴァーセル)が大規模なデータをもとに分析した。

AIクローラーはJSレンダリングしない

分析によれば、ほとんどのAIクローラーがJavaScriptを実行しなかった。このAIクローラーには次のものが含まれる:

- OpenAI(OAI-SearchBot、ChatGPT-User、GPTBot)

- Anthropic(ClaudeBot)

- Meta(Meta-ExternalAgent)

- ByteDance(Bytespider)

- Perplexity(PerplexityBot)

- Common Crawl(CCBot、LLMのトレーニングによく使用されるクローラー)

一方で、グーグルのGeminiはJavaScriptを含めてほぼ完全に取得してレンダリングしているようだ。グーグル検索のインフラを利用しているためだろう。また、アップルのAppleBotもJavaScriptをレンダリングした。ブラウザベースのクローラーをAppleBotは使用しているからだと思われる。

コンテンツタイプの優先順位

AIクローラーは、取得するコンテンツの種類に明確な優先度を示した:

- ChatGPTはHTMLコンテンツを優先した(取得リクエストの57.70%)

- Claudeは画像を優先した(取得リクエストの35.17%)

- Googlebotの取得リクエストは比較的均等に分散していた:

- HTML:31.00%

- JSONデータ:29.34%

- プレーンテキスト:20.77%

- JavaScript:15.25%

Googlebotが多様なデータを取得しにいっているのは、グーグルのAIクローラーがモデルのトレーニングのために多様なデータを収集している可能性を示唆していると記事は述べている(もしかしたら、単に検索用クローラー/レンダラーの特性なのかもしれないが)。

AIクローラーの非効率性

データは、AIクローラーの非効率性も明らかにした。404ページやリダイレクトページへのリクエストが多かったのだ:

- ChatGPTからの取得リクエストの34.82%が404ページ

- Claudeからの取得リクエストの34.16%が404ページ

- ChatGPTからの取得リクエストの14.36%がリダイレクトURL

Googlebotからの取得リクエストでは、404ページが8.22%でリダイレクトは1.49%しかない。つまり、AIクローラーは、404になるページやリダイレクトになるページにアクセスしようとする頻度が非常に高く、効率が悪いことがわかる。

404エラーの多さは、AIクローラーが古いリソースをいつまでも取得しようとしていることを示しており、URL処理を改善する必要があることを浮き彫りにした。

サイト所有者とAIユーザーへの提案

分析を踏まえて、記事ではサイト所有者とAIユーザーに次のことを提案している:

AIクローラーによるクロールを希望するサイト ―― AIクローラーはJavaScriptを実行しないため、重要なコンテンツにはサーバーサイドレンダリング(SSR)を実装する。重要でない要素には、クライアントサイドレンダリングを使用してかまわない。リダイレクトとサイトマップの維持など、効率的なURL管理が不可欠。

AIクローラーによるクロールを希望しないサイト ―― robots.txtを使用してクローラーのアクセスを制御するか、WAFなどでAIクローラーをブロックする。

AI(LLM)ユーザー ―― JavaScriptでレンダリングされたコンテンツはAIの応答に含まれない可能性があり、AIが引用するURLは正しくないかアクセスできない可能性があることに注意する。AIツールはキャッシュされたデータまたはトレーニングデータに依存する可能性があるため、AIツールからのデータの鮮度は一貫していない場合があることに注意する。

調査はVercelのネットワーク全体に対するリクエストを対象に行ったもの。対象期間は1か月間(2024年の11月あたりだと思われる)で、その期間におけるクローラーのトラフィック概要は次のとおり:

- GPTBot (ChatGPT): 5億6,900万件

- Claude:3億7千万件

- AppleBot: 3億1,400万件

- PerplexityBot: 2,440万件

- Googlebot: 45億件(Geminiと検索全体で)

※一部のデータはnextjs.orgのみを対象としたもの

- SEOがんばってる人用(ふつうの人は気にしなくていい)

- 技術がわかる人に伝えましょう

Googlebot解体新書: クロールのメカニズムを正しく理解

クロールの仕組み解説記事 (グーグル検索セントラルブログ) 国内情報

Googlebotのクロールについて検索セントラルブログが解説した。

次のことついて基本から説明している:

- クロールとは何か?

- クロールのプロセス

- クロールバジェットの最適化

- Googlebotのクローリング監視

クロールの仕組みの理解はSEOで非常に重要だ。クロールされなければ検索結果に表示されることはない。大規模サイトではクロールの効率化が求められる。SEO初級者にも上級者にも読んでほしい解説記事だ。

- すべてのWeb担当者 必見!

“今は”検索上位でも、サイトの主目的からズレれたコンテンツはサイト全体に悪影響のリスク

検索エンジンのためのコンテンツをみなされてしまう (Lily Ray on Bluesky) 海外情報

過去数年間のコアアップデートとスパムアップデートで順位を下げたサイトに共通してみられる特徴を、経験と実績が豊富なSEOコンサルタントであるリリー・レイ氏が共有した。

After auditing many sites impacted by Google's core/spam updates of the last few years, I often see similar groups of keywords being impacted. Below, I included a slide with examples from my conference talks last year, where I presented about this topic many times. (thread)

— Lily Ray 😏 (@lilyray.nyc) January 15, 2025 at 3:25 AM

[image or embed]

この投稿のスレッドに見解が続くのだが、その内容は次のようなものだ:

多くの場合、順位を下げたページは、以前はそのサイトのオーガニックトラフィックの大部分を占めていたもの。しかしグーグルの「検索エンジンのために書かれたコンテンツ」のカテゴリに該当する内容だった。そのため、グーグルのアップデート時に(ページ単体ではなく)サイト全体のパフォーマンス低下を招く可能性があると私は考えています。

サイト所有者にとって、これは理解し難いことかもしれません。

なぜ、それほど多くのオーガニックトラフィックをもたらすコンテンツが、サイト全体の負債にもなり得るのでしょうか?

私の意見では、それは「コンテンツの目的」に最終的に行きつきます。こうしたコンテンツは、「ウェブサイトの中核となる目的とその主要な提供コンテンツ」にわずかにしか関連していない(あるいはまったく関連していない)場合が多いのです。

したがって、グーグルはそうしたコンテンツを、次のように判断する可能性があります:

このコンテンツは、SEO目的のために存在しているものだ。トラフィックとページビュー以外に顧客にとって真に役立つものではない。

要は、ウェブサイトの軸となる目的にわずかにしか(あるいはまったく)関連性のないコンテンツを公開すると、たとえそのコンテンツが大きなトラフィックを獲得していたとしても、いずれはグーグル検索におけるサイト全体のランキングに悪影響を与える可能性があるということだ。サイトの主目的に合致したコンテンツの作成だけに注力した方がいい。

- すべてのWeb担当者 必見!