グーグルDiscoverの掲載判断には検索のランキング要因と同じものが多い【SEO情報まとめ】

SEO担当者のなかには「Google Discoverからのトラフィック獲得」が役割の人もいるだろう。今回は、そんなDiscover最適化に役立つ情報をお届けする

2023年3月10日 7:00

SEO担当者のなかには「Google Discoverからのトラフィック獲得」が役割の人もいるだろう。今回は、そんなDiscover最適化に役立つ情報をお届けする。要は、「SEOをイマドキの形でやればDiscoverにも好影響」というものだ。

ほかにも、Discoverにも関係する検索評価要因の「誰が・どのように・なぜ」公式情報や、SC+BigQuery、クロール頻度調整、AIチャット、オフィスアワーなどなど、あなたのSEO力(とデジタルビジネス力)に役立つ情報をまとめてお届けする。

- グーグルで上位表示するには「誰が・どのように・なぜ」を明確に表現する

- SCから大量データをBigQueryに毎日エクスポートできる機能が登場

- クロール頻度の抑制に404を使ってはいけない

- グーグル画像検索でEXIF使ってる? ⇒ 使ってないよ!

- AIチャットはウソつき!? でっちあげが得意!? 使い方に要注意

- 2023年2月の2回目のオフィスアワー: robots.txtでのクロール制御、ステージングサイトのインデックス登録、動画SEOのベストプラクティスほか

- 英語版グーグルオフィスアワー28項目の日本語版文字起こし

- レシピサイトなのにレシピ情報はほんの少し、大部分が広告のサイトっていったい

- 2023年「コンバージョン最適化」は死語になる? ユーザー行動もVUCAの時代か

- Google、2023年2月のプロダクトレビューアップデートを展開開始、英語以外の言語にも初適用

- Google、リンクのベストプラクティスを更新。アンカーテキスト、内部リンク、外部リンクに関するアドバイスを追加

今週のピックアップ

グーグルDiscoverの掲載判断には検索のランキング要因と同じものが多い

検索の最適化はDiscoverの最適化にもつながる (グーグル 検索セントラル) 国内情報

- Discoverの掲載判断

- Google検索での評価

この2つで、共通する多くのシステムや要因(シグナル)を利用していることを、グーグルがドキュメントに明示した。

共通していると示しているのは、次の2点:

いずれも、Discoverと検索を解説した次の2つのドキュメントで言及している:

たとえばDiscoverのドキュメントは次のように記載している:

Discover は、Google 検索の一部として、検索が使用するのと同じシグナルとシステムの多くを利用して、ユーザー第一の有用なコンテンツを判断します。そのため、Discover に表示されるようにしたいと考えている方は、Google のアドバイスを参考に、ユーザー第一の信頼できる有用なコンテンツを作成してください。

以前は次のように記載していた:

Google の自動システムは、専門性が高く(Expertise)、権威があり(Authoritativeness)、信頼できる(Trustworthiness)(E-A-T)ページが多くあるサイトのコンテンツを Discover に表示します。この E-A-T の改善をお考えの場合は、Google 検索のアップデートに関してサイト所有者が知っておくべきことに記載されている質問に対して自己評価をされることをおすすめします。検索と Discover は異なるサービスですが、それらのコンテンツに適用される E-A-T に関する原則はほぼ同じです。

ヘルプフル コンテンツ システムのドキュメントには、次の引用内に強調した箇所が追加された:

システムでは、サイト全体のシグナルが生成され、ウェブページのランキングに影響するシグナルの一つとして扱われます(これにはDiscoverも含まれます)。

つまり、ヘルプフル コンテンツ システムはDiscover掲載にも用いられるのだ。

Discoverのランキング要因が変わったということではないので誤解してはいけない。「ユーザーの能動的な意図をふまえた検索」と「特定の意図をふまえずに情報をユーザーに提示するDiscover」では、異なる判断基準がある。しかし、検索で高く評価されるようにコンテンツを作成することが、Discoverでの掲載確率を高めることにもつながることは認識しておくといいだろう。

※共通する2つの要因として示したうちの1つ「有用で信頼できるユーザー第一のコンテンツ」に新たに加わった「誰が・どのように・なぜ」についても、この下で詳しく解説している。そちらも参照してほしい。

- Discover最適化がんばってる人用(ふつうの人は気にしなくていい)

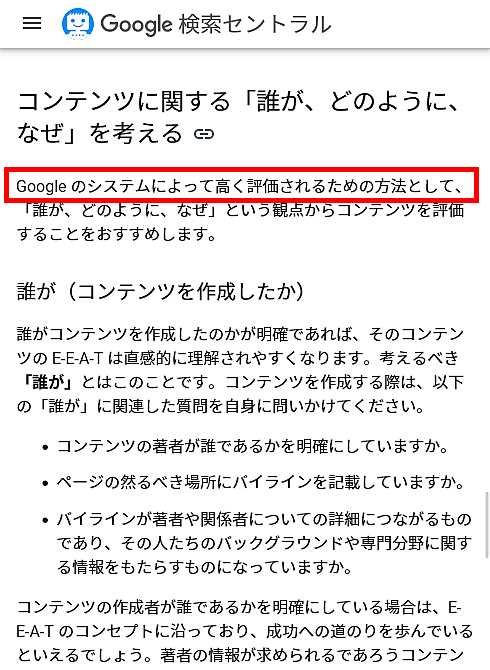

グーグルで上位表示するには「誰が・どのように・なぜ」を明確に表現する

Who・How・Whyの3要素でコンテンツを精査 (グーグル 検索セントラル) 国内情報

有用で信頼性の高い、ユーザーを第一に考えたコンテンツを作成するためのガイダンスを解説するドキュメントに次のセクションが追加された。

グーグル検索で高く評価されるための方法に、「誰が・どのように・なぜ」という観点からコンテンツを精査することをこのセクションは推奨している。

これら 3要素の内容を一言で説明すると、次のようなものだ:

誰が(Who)―― コンテンツの著者が誰であるか(著者名や、そのバックグラウンドや専門分野についての情報などの情報を、コンテンツ内に含める)

どのように(How)―― そのコンテンツをどのように作ったか(レビューで試した商品数、自動化やAIの使用についての情報などの情報を、コンテンツ内に含める)

なぜ(Why)―― なぜそのコンテンツを作ったか、その目的や意図(ユーザーのニーズに応える意図でなければ再考の必要あり)

これらの要素をコンテンツ内で明確に示していたり正しく評価できたりする場合、ユーザーにとってより有用な情報となり、Googleの検索システムによって高く評価される可能性が高くなる。

詳細をドキュメントで必ず確認しておこう。

ただし、「コンテンツを評価する」という流れだが、次のように3点で少し軸が違う点がわかりづらいので注意:

- 「誰が」「どのように」は、問い掛けとコンテンツ内での明示

- 「なぜ」は、問い掛けと確認

- すべてのWeb担当者 必見!

グーグル検索SEO情報①

SCから大量データをBigQueryに毎日エクスポートできる機能が登場

超大規模サイト向け (グーグル 検索セントラル ブログ) 国内情報

Search Consoleに「一括データ エクスポート」が新機能として追加された。この機能を使うと、Search ConsoleからGoogle BigQueryに毎日継続的にデータをエクスポートできる。検索パフォーマンスのデータが対象だ。

一括データ エクスポートには、1日のデータ件数制限を受けないという大きな長所がある。Search Consoleから直接ダウンロードするデータやSearch Console APIには、上限がある。1日に何万ものクエリから何万ページにも検索トラフィックがあるような超大規模サイトには、BigQueryへのエクスポートは非常に有用な機能と言える。

具体的な設定方法はブログ記事とヘルプ記事で確認してほしい。

プリンシプルの木田氏が2分の動画で設定手順を解説している。全体の流れをこちらの動画で事前に把握しておくのもいいだろう。

- 大規模サイトのすべてのWeb担当者 必見!

- 技術がわかる人に伝えましょう

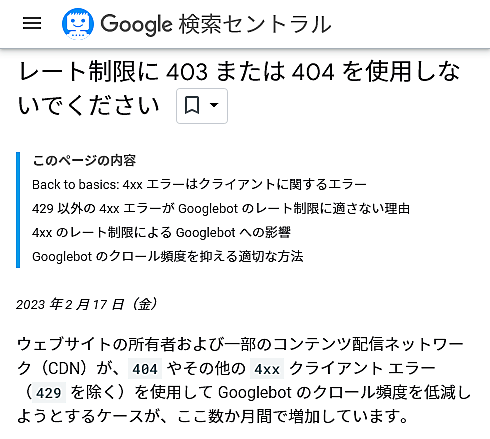

クロール頻度の抑制に404を使ってはいけない

意味がないし、トラブルの原因にも (グーグル 検索セントラルブログ) 国内情報

Googlebotのクロール頻度の制御に403や404を使用してはいけない

検索セントラルブログでグーグルはこのように注意喚起した。

背景にあるのは、「Googlebotのクロール頻度を下げることを意図して404やその他の400番台のHTTPステータスコードを返すサイトやCDNが増えている」ことだ。

そもそも、400番台のステータスコードは「クライアント側(ブラウザやGooglebot)のエラー」を意味するものであり、サーバー側の問題を意味しない。言い換えれば「クロール過多で高負荷がかかっている」というシグナルにはならない。つまりクロール頻度には影響しない。

429。429はクロール頻度に影響する(が、推奨される方法ではない)また、不適切な404は場合によってはトラブルの原因にもなる。

クロール頻度を抑えるための最も適切な方法は、Search Consoleからのクロール頻度の設定だ。もしくは、1日〜2日程度の短期間であれば、500・503・429のHTTPステータスコードを返すという方法も使える。

404などの4xxによるクロール制御の設定に心当たりがあるなら、ブログ記事で詳細を確認してほしい。

- ホントにSEOを極めたい人だけ

- 技術がわかる人に伝えましょう

グーグル画像検索でEXIF使ってる? ⇒ 使ってないよ!

IPTCは使ってる (Gary Illyes & John Mueller on Twitter) 海外情報

グーグルの画像検索では、画像が持つ情報としてEXIFデータを使っているのだろうか?

画像検索の上位表示にEXIFデータは役に立つのだろうか?

答えはノーだ。グーグルは画像検索でEXIFデータを使っていない。ずっと以前はEXIFデータを検索結果に表示したこともあったらしいが、かなり昔の話だ。また、EXIFデータを利用する可能性もありうると言及していた時期もあったが、現在は利用していないとのことである。

グーグルのゲイリー・イリェーシュ氏が明言している:

どこかに明記していたはずだが、現時点でグーグルは検索でEXIFメタデータを使っていない。

I could've sworn we have this document somewhere, but apparently not: Google doesn't use EXIF metadata at the moment. I'll see if we can add this to our Google image best practices somewhere.

— Gary 鯨理/경리 Illyes (@methode) February 18, 2023

(ping me on mastodon instead next time; I only come to Twitter if someone asks me to)

グーグルはEXIFデータを利用していないが、画像のメタデータを一切使っていないわけではない。というのも、グーグルはIPTCデータをライセンス情報表示のために利用しているのだ。画像最適化の手段としてのIPTC利用をジョン・ミューラー氏は推奨している。

サイトで利用している画像が一般的な検索でヒットするなら、ライセンス情報の付与を検討してみるといい。

画像のライセンス情報は、次のどちらかで付与できる:

- 画像ファイル自体にIPTC写真メタデータを埋め込む

- 該当ページのHTMLに構造化データとして埋め込む

If your site's images get found for generic queries, consider licensing them: Add licensable markup to the images (IPTC metadata) or to the landing pages (ImagesObject structured data). Use tagged licensing landing pages for tracking.

— johnmu is not a chatbot yet 🐀 (@JohnMu) February 20, 2023

画像検索からのトラフィックを重視しているなら、EXIFではなく、画像ファイルのIPTCややHTML構造化マークアップを利用してみるといいだろう(ライセンス情報しか含められないが、著作物の権利を示すのは情報の出し手としては正しい姿勢だ)。

- 画像SEOがんばってる人用(ふつうの人は気にしなくていい)