ローカルSEOでは、何に目を向ければトラフィックを増やせるのか。AIの影響も含めて、専門家47人が評価した「ローカルSEOのランキング要因」を一気にお届けする。

新しくなったWeb担で、最初のこのコーナー。今回は「AIではなくSEO」のネタをしっかりお届けする。

マーティン・スプリット氏によるテクニカル監査ガイドとSearch Consoleの制限回避方法×2をチェックしてほしい。

「とはいえAIのことも知りたい」という方も安心してほしい。リリー・レイ氏と平氏の情報をお届けする。

- 【2026年版!?】ローカルSEOランキング要因

- 効果的なテクニカルSEO監査をグーグルが解説

- Search Consoleでサブディレクトリ分割登録して制約回避しサイト分析する方法

- BigQueryを用いたSearch Console一括データエクスポートの詳細と設定方法

- Google DiscoverでAI偽記事がフィードを占有

- GEO、AEO、LLMO ―― 事実と誤解を切り分け、AI検索で勝つ方法

- AI時代SEOはブランド言及最適化へ転換

- 急成長から急転落へ、AIコンテンツ依存サイトの悲惨な結末

- テクニカルSEOが満点なら上位表示できる……わけじゃない

- エンゲージするクリエイティブなYouTubeショート動画のアイデア×25

- #SearchCentalLive Tokyo 2025のQ&Aセッションまとめ

- Search Consoleの分析情報レポートに「クエリグループ」が導入される。検索意図が同じクエリをまとめてレポート

今週のピックアップ

【2026年版!?】ローカルSEOランキング要因

ローカルSEOにもAIの影響が (Whitespark) 海外情報

ローカルSEOのランキング要因の最新版を、ローカルSEOツールを提供するWhitespark(ホワイトスパーク)が公開した。

47名のローカルSEO専門家に聞き取り調査し、187の要因について0点~5点で評価してもらったものを、合計点の高い順にランキングとしてまとめたものだ。

もちろん調査は2026年ではなく2025年の実施だが、元記事で「2026年版」として紹介しているので、ここでもそのまま「2026年版」とした。

調査のポイントを紹介していこう。

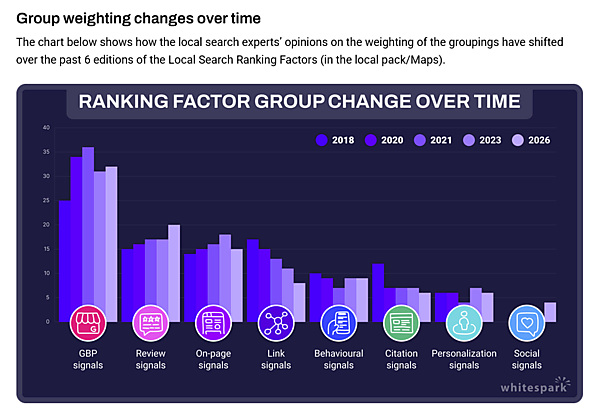

全体的な変化

- 情報系SEOがAIで大きく揺れ動いている昨今だが、ローカル検索は比較的安定している。

- AI検索での可視性が主要なテーマとなり、多くの新要素が追加された。

- レビューシグナルと行動シグナルの重要度が上昇した。

- ソーシャルシグナルが再追加されたことで、オンページ要素とリンク要素の比重がやや低下した。

さらにセグメント別で要因を分析してくれている。それぞれ紹介していこう。

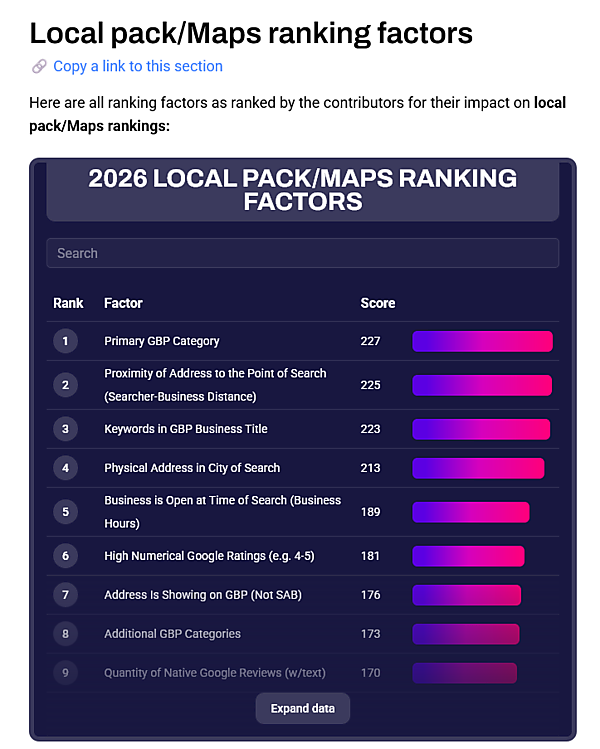

ローカルパック / Googleマップで順位を決める主要因トップ10

- GBPの主要カテゴリ

- 検索地点との距離(検索者と店舗の距離)

- GBPビジネスタイトル内のキーワード

- 検索対象都市内に物理住所があること

- 検索時に営業中であること

- レビューの評価数値が高いこと

- 住所が公開されていること(SABではないこと)

- GBP追加カテゴリ

- テキスト付きレビューの量

- マップのピンの適切な配置

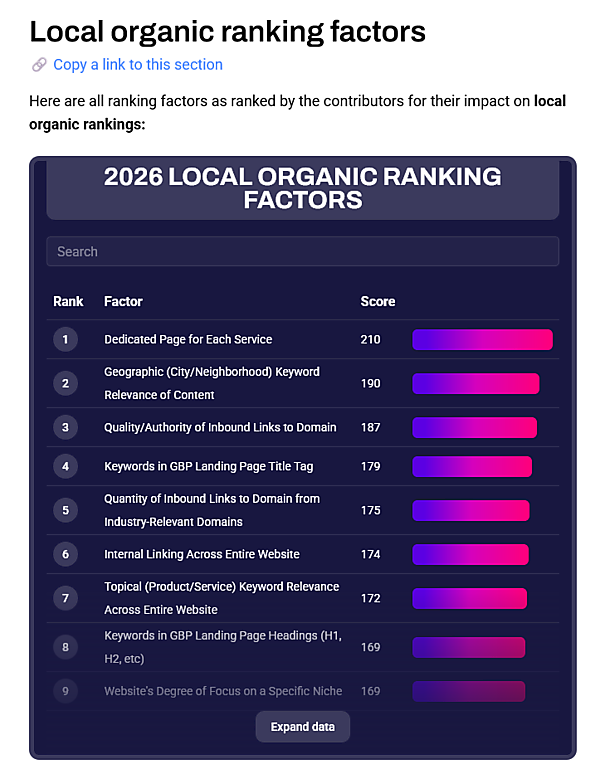

ローカルオーガニック検索で順位を決める主要因

- 各サービス専用ページの存在

- 市区町村・地域キーワードの関連性

- 高品質な被リンク

- GBPランディングページのタイトルタグ/見出しに含まれるキーワード

- 関連業界からのリンクの質

- サイト全体の内部リンク

- 特定のニッチへの明確な焦点

AI検索での可視性(新カテゴリ)

- 専門家が選定した「Best of(おすすめ)」リストなどへの掲載

- 各サービス専用ページ

- 業界で重要とされるドメイン名上での存在感

- 新聞・ブログ・行政・業界団体など構造化されていない引用(言及)の質と権威

- サードパーティレビューサイトの権威性

総括として、AI検索では引用(言及)がリンク以上に重要性を持つ傾向が強い。

コンバージョン要因

- 高評価のグーグルレビュー(4~5)

- レビューテキストのポジティブ度

- 検索者との距離

- モバイル対応サイト

- テキスト付きレビューの量

- 検索時に営業していること

- レビューの新鮮さ

ネガティブ要因

- 「恒久的に閉業」と表示されている

- 主要カテゴリが適切ではない

- 同住所・同カテゴリの別プロフィールの存在

- 低評価レビュー(1~2)

- 「一時的に休業」と表示されている

- マップマーカーの誤配置、サイトのハッキング、営業時間未設定

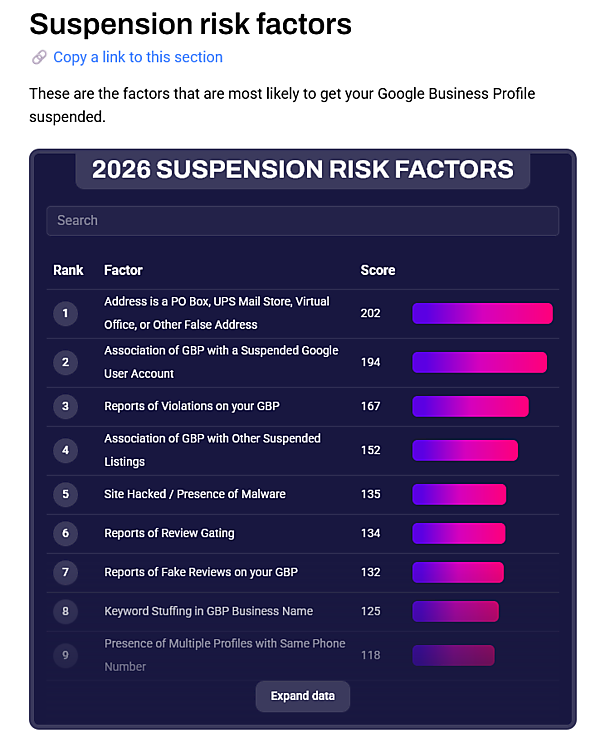

GBPアカウント停止のリスク要因

- 私書箱・バーチャルオフィスや、虚偽住所

- 停止されたグーグルアカウントとの関連

- 違反報告

- 停止されたGBPリスティングとの関連

- サイトのハッキング

- 良いレビューだけを意図的に集める手法

- 虚偽レビュー報告

- GBPビジネス名でのキーワード詰め込み

- 同一電話番号の複数プロフィール

「2年前の調査から大きく変わったこと」・「今回のローカルSEO調査で新たに見えてきたこと」として、次のような点があるという:

AIの影響で引用(言及)が再評価されている

「営業中」「住所表示」の重要度が大幅に上昇

一部のオンページ要素(権威サイトへの外部リンク、サービスページの量など)の評価が低下

タイトルタグの文字数制限はSEO神話であり、グーグルは長さを気にしない

また、ローカルSEOをとりまく環境やAIへの対応として、今後の方向性について、元記事では次のように整理している:

- グーグルのAIモードがローカル検索の未来像である可能性が高い。

- 広告の統合が進めば、AI結果が従来の検索結果を置き換える可能性が高い。

- AI検索で勝つには次のような施策が重要:

- キュレーションされたリストへの掲載

- 高品質な非構造化引用

- 業界ディレクトリの徹底最適化

- セマンティックな最適化

- グーグル以外も含めた広範な評判シグナル

- 簡潔・構造化された高品質コンテンツ

- 地域コミュニティでの活動によるローカル言及獲得

調査の参加者はグーグルの内部情報を持っているわけではない。それでも、長年の実務・調査・テストに基づく観察と経験から要因の重要度を判断している。信頼度は高いのではないだろうか

- ローカルSEOに取り組むすべてのWeb担当者 必見!

グーグル検索SEO情報①

効果的なテクニカルSEO監査をグーグルが解説

SEOのパフォーマンスを向上させるための実践的なヒント (#SearchLightningTalks on YouTube) 海外情報

「効果的なテクニカルSEO監査」の実施方法を、グーグル検索チームのマーティン・スプリット氏が動画で解説した。

要点をまとめる。

技術的監査の真の目的

技術的SEO監査は、単なるエラーのリストではない。その主な目的は、次のことである:

技術的SEO監査の目的は、検索エンジンがウェブサイトをクロール、インデックス、理解するのを妨げたり、干渉したりする技術的な問題を発見すること。

調査結果は、監査対象ウェブサイトの文脈を前提に解釈されなければならない。

技術的監査の真の目的

意味を持つ監査のための3つのステップのプロセスは次のとおり:

問題の特定: ツール、チェックリスト、ガイドラインを使用して、潜在的な技術的問題を見つける。

レポートの調整: 特定のサイトに合わせてカスタマイズされたレポートを作成し、見つかったデータを意味のあるものにする。

実行可能な提案の提供: サイト固有のニーズと優先順位に基づいて推奨を行う

コンテキストの重要性

ツールだけでは不十分であり、コンテキスト(文脈)が重要である:

恣意的なスコアの回避: 一般的なスコアや任意の制限値を含むレポートは解釈が難しく、意味がない可能性がある。

調査結果の優先順位付け: 優れた監査は、「容易に達成できる成果」を優先する。これには、次の2点によって調査結果をグループ化することが必要である:

- 修正にかかる労力

- それがもたらす潜在的な影響力

コンテキストが鍵: ツールによって指摘されたすべての問題が問題であるとは限らない。たとえば、多数の404エラーがあったとしても、コンテンツを削除した後であれば正常な結果である。しかし、説明のつかない404応答の急増は、調査すべき重大な問題である

より深く、協力的なプロセス

価値ある監査を作成するには、次のアクションが重要である:

サイトの理解: まず、サイト固有のテクノロジースタック(技術的な構成や設定)を理解する。

調査結果の検証: サイトとその技術に精通している人々と話し、あなたの評価が彼らの状況にとって妥当で意味のあるものであることを確認する。

サイト固有であること: 監査の焦点はサイトに適応させるべきである。たとえば、

hreflangの監査は国際的なサイトにとっては不可欠だが、日本語でしか運用していないサイトには無関係である。

調査すべき主要領域

監査中にチェックすべき一般的な領域には、次のものも含む:

- ルーティングとネットワークの問題

- HTTPヘッダーとメタデータ

- リダイレクトチェーンまたはループ

- 正規化とリンクの問題

- マークアップとレンダリングの問題

ツールを盲信しない

最も重要なポイントは、ツールを盲信しないこと。成功する技術的SEO監査は、専門知識を駆使して、すべての調査結果が対象のウェブサイトにとって有意義であることを確認し、最大の影響を達成するためにそれらを優先順位付けすることが求められる

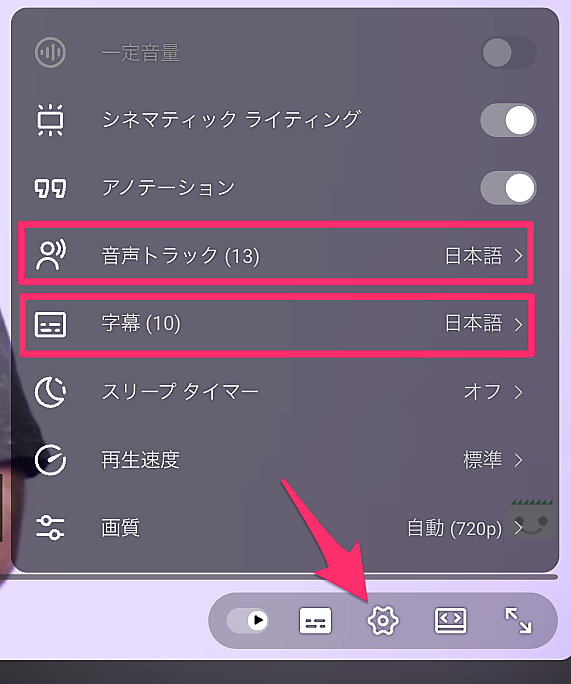

スプリット氏は英語で話しているが、YouTubeの視聴設定で、日本語の字幕と日本語の音声トラック(吹き替え)に切り替えられる。必要であれば、こうした機能も利用して全体を視聴するといい。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

- ホントにSEOを極めたい人だけ

- 技術がわかる人に伝えましょう

Search Consoleでサブディレクトリ分割登録して制約回避しサイト分析する方法

多数のプロパティで分割管理 (Leadership in SEO) 海外情報

Search Consoleには、さまざまな制約があり、場合によっては重大な制限となってしまう場合がある。次のような点に制約があるのだ:

- 保存容量

- サンプリングされた不完全データ

- 1,000行制限

- 2,000 URL/日 API 制限

- 16か月データ上限

- など

ここで紹介する記事では、「サブフォルダやサブドメイン単位で多数のプロパティを作成する」ことで、こうした制約を回避する方法を解説している。Googleアカウントには最大1,000件のプロパティを追加できるため、この仕様を活用し1つのサイトを分割して管理するのだ。

この方法には、次のような利点があるという:

「クロール済み/未インデックス」「発見済み/未インデックス」など、より詳細なインデックス状況が得られる

プロパティごとに 2,000URL/日のAPI制限が独立して適用されるため、インデックスAPIを大幅に拡大できる

クエリ/ページデータの1,000 行制限をプロパティ単位で分散でき、より粒度の高い分析が可能になる

ドメインプロパティのクロール統計レポートと組み合わせることで、大規模サイトのクロール挙動を精密に把握できる

おおまかな設定手順は次のとおりだ:

まずドメインプロパティを1回だけ認証し、その後は自由に子プロパティ(サブフォルダ/サブドメイン)を追加する。

Screaming FrogやSitebulb などでサイトをクロールし、追跡すべき重要セクションを特定する。

収益・トラフィック優先で重要なフォルダから追加していく。

サイトマップインデックスだけでなく、個々のサイトマップもすべてSearch Consoleに登録し、サイトマップ単位のインデックス状況を把握する。

BigQueryにデータを保存して16か月制限を回避する。

さらにSearch Consoleの制限を撤廃するには、必要に応じて「SEO Stack」「SEO Gets」「Indexing Insight」などのツールを検討する。

ただし、次の点には注意してほしい:

インデックスはサイトマップではなく、「コンテンツの質」「内部リンク」「クロールバジェット」「ユーザーエンゲージメント」などによって決まる。

「クロール済み・未インデックス」と「発見済み・未インデックス」は異なる問題を示す。

複数プロパティ化は、大規模サイトがインデックス状況と検索パフォーマンスを高精度で把握するうえで、たしかに極めて有効な手法だ(言い換えれば、1000ページ未満のサイトには関係ない)。

ここでは概要だけを紹介している。大規模サイト運営者でSearch Consoleの制限に不自由を感じているなら、元記事で詳細を確認してほしい。

- 大規模サイトの人だけ(ふつうの人は気にしなくていい)

BigQueryを用いたSearch Console一括データエクスポートの詳細と設定方法

大規模サイトでのSC分析に有用 (JADE) 国内情報

Search Consoleにおける制限を回避する方法として「サブディレクトリ/サブドメイン単位で登録する」手法を、1つ前のピックアップで紹介した。

同じ問題への対応として、「BigQueryへの一括データエクスポート」を使って大規模サイトを分析する方法を解説してくれている記事があったので、紹介する。

BigQueryへの一括データエクスポートは、2023年2月にリリースされた機能だ。匿名化クエリを含む全数データを直接BigQueryに蓄積でき、行数制限がない。

エクスポートのおおまかな手順は次のとおりだ:

Google Cloud プロジェクトを作成し、BigQuery APIなどを有効化

Search Console 用サービスアカウントに BigQuery ジョブユーザー + BigQueryデータ編集者 の権限を付与

Search Console側でCloudプロジェクトIDとデータセット名を設定し、エクスポート開始

初回エクスポートは48時間以内に実行される

これで分析対象はBigQueryになるため、Search Consoleの制約は一切関係なくなるというわけだ。

ただし、BigQueryを使ってのデータ活用には次のような課題もある。そのため、すべての人が簡単にできるわけではない:

- SQLが必須で、誰でも簡単に扱えるわけではない。

- BIツール(Looker Studioなど)のダッシュボード構築・メインテナンスに手間がかかる。

- BigQueryは従量課金制のため、高額請求のリスクがある。

注意点はあるものの、大規模サイトのSearch Console分析には非常に有用な手法だ。詳細な設定手順は元記事を参照してほしい。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

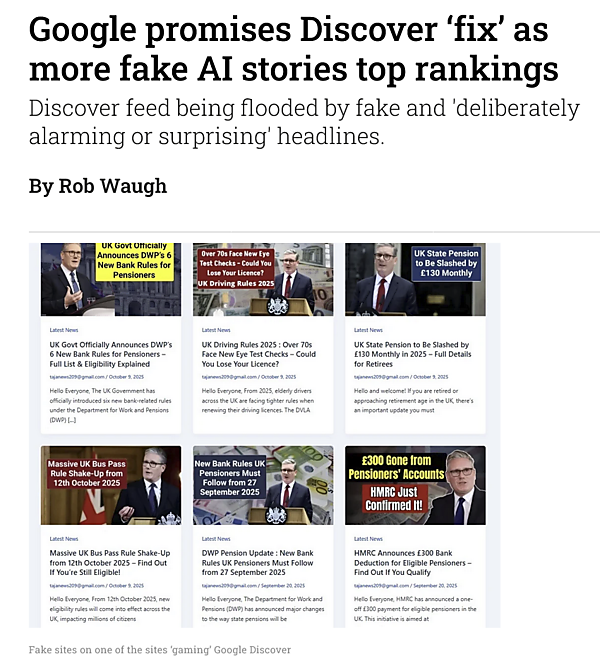

Google DiscoverでAI偽記事がフィードを占有

期限切れドメインを不正利用 (Press Gazette) 海外情報

グーグルのDiscover表示内容が、AIによって生成された偽ニュース記事によって「汚染」されている問題が報告されている。

たとえば、次のような偽ニュースがビューを集めているが、AIコピー検出ツールはこれらを「完全AI生成」と判定しているという:

- 「60歳以上のTVライセンス無料化」といった虚偽のニュースが295万人に表示

- 「バス定期券の規則変更」に関する別の偽記事は185万ビューに達した

期限切れしたドメイン名をスパマーが広告収益を目的に購入し、AIでクリックベイト記事を量産しているらしい。さらに偽トラフィックを使いアルゴリズムを騙す戦術が取られている。フランスでは同様のAIサイトが8,300件以上確認されている。

Discoverは大手ニュースサイトへのグーグルトラフィックの3分の2以上を占める重要な流入源だが、グーグルのポリシーはAI生成コンテンツを明示的に禁止していない。グーグルは大半のスパムを排除していると言いつつも、この手法には新たな対策が必要だと認めている。

筆者自身は、「期限切れドメイン名を不正利用したDiscoverスパムが日本でも横行している」という実態を目にしたことも耳に入れたこともない。とはいえ、そうしたことが発生している可能性は否定できない。グーグルには確実に対処してほしい。

- SEOがんばってる人用(ふつうの人は気にしなくていい)