悪質ページをごっそり削除? 2021年11月のスパムアップデートをグーグルが実施

グーグル検索SEO情報②

悪質ページをごっそり削除? 2021年11月のスパムアップデートをグーグルが実施

首尾は上々か? (金谷 武明 on ツイッター) 国内情報

スパム対策のためのアップデートをグーグルが実施した。グーグル検索のツイッターアカウントによる発表を金谷氏が日本語に訳してリツイートしてくれたものだ:

検索結果の品質を改善する通常業務の一環として、Spam Update をリリースしました。この "November 2021 spam update"のロールアウトは 1 週間以内に完了する予定です。ぜひ今一度ウェブマスター向けガイドラインをご覧頂ければと思います。https://t.co/KJc2MvHzu5 https://t.co/F0GmImYNpc

— 金谷 武明 ★ Takeaki Kanaya (@jumpingknee) November 4, 2021

同様のスパムアップデートを6月にもグーグルは実施している。今回も、ウェブマスター向けガイドラインに違反しているサイトをターゲットにしたアルゴリズム更新だ。正しくSEOを施策していれば影響はないはずだ。

米国のSEOコンサルタントであるグレン・ゲイブ氏によれば、スパム手法でリンクを集めていたサイトのページがアップデート直後に数千ページにわたって、ごっそりとインデックス削除されたとのことだ。スパムアップデートの首尾は上々らしい。

Re: the Nov Spam Update: Client that's complained about 60K+ spammy links for a while (cloaked spam content w/links to their site) emails me last night, "ALL OF THOSE SPAMMY PAGES WERE DEINDEXED!" Very interesting... Only 4 pages indexed on one of the sites now (from thousands): pic.twitter.com/50CWI0zEAS

— Glenn Gabe (@glenngabe) November 5, 2021

In addition, a query that yielded tens of thousands of spammy pages w/cloaked links now just returns 1 page (see screenshot). So the Nov Spam Update seems to be working... If you've seen many spammy links leading to your site, check them today. They might be gone. :) pic.twitter.com/vHgkAMDU0H

— Glenn Gabe (@glenngabe) November 5, 2021

SEOの世界では、スパム的な手法によって上位表示できても、一時的なものでしかない。結局はグーグルにみつかり、対策される。ビジネスの永続を考えるならば、スパムには決して手を染めてはいけない。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

ソーシャルシグナルや検索結果CTRはグーグル検索のランキング要因なのか?

グーグル社員の皮肉が込もった回答 (John Mueller on Twitter) 海外情報

次の2つは、グーグルがランキング要因に使っているかどうかが絶えず議論になる。

- ソーシャルシグナル(URLの共有数やいいねの数など)

- 検索結果でのクリック率

これらの疑念についてグーグルのジョン・ミューラー氏がツイッターで見解を述べている。それぞれ別ツイートなので、1つずつ紹介する:

ソーシャルシグナルは、直接的あるいは間接的にSEOに影響するのか?

この質問に対してミューラー氏は次のように返した:

あなたのサイトの検索での露出の改善に役立つアドバイスをツイッターで私があなたに与えたら、それはSEOに対するソーシャルシグナルの間接的な効果ということになるのだろうか?

If I give you advice on Twitter which helps improve your website's visibility in search, would that be an indirect effect of social signals on SEO?

— 🧀 John 🧀 (@JohnMu) November 7, 2021検索結果でのクリック率はランキング要因なのか?

この質問に対しては、次のように返した:

もし仮にクリック率が検索ランキングを推進させるものだとしたら、検索結果はすべてのクリックベイトになってしまうだろう。そんなことが起きるとは思わない。

※筆者注: 「クリックベイト」とは、クリックを誘導するために、キャッチーなタイトルで“釣る”手法If CTR were what drove search rankings, the results would be all click-bait. I don't see that happening.

— 🧀 John 🧀 (@JohnMu) November 4, 2021

どちらの返信にも皮肉っぽいニュアンスが伴っているように思えるし、事実のなかのある側面を説明しているだけにも見える。

ソーシャルでの状態はなんらかの目的でグーグルが利用していることは考えられる。たとえば、新しいURLの発見や、今話題になっているトピックの識別だ。だが、単にシェアが多いとかいいねが多いといった、簡単に操作される指標を単純に利用しているということはないだろう。

検索結果のクリック率をグーグルはたしかに見ている。たとえば、新しいアルゴリズムや機能の導入をする際のテストにおいてだ。改良がユーザーに好まれるかどうかを判断する材料としてクリック率のデータを参考にすることがある。だが、こちらもただ単にたくさんクリックされたからそのページの順位を上げるというような、悪用してくださいと言わんばかりの利用方法ではないだろう。

少なくともグーグルは、多くの人が5分で考えつくような単純な形では、ソーシャルシグナルも検索結果のCTRも利用していないようだ。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

「SEOスパムはダメでも効果がなくなるだけ」と思ってたら、やっぱりマイナスもある模様

無効化したら何も残っていないとしたらサイト全体が価値なし (Search Engine Roundtable) 海外情報

「SEOスパム的な手法は、みつからなければ効果があるし、いまはみつかっても無効化されるだけ」といった話を聞いていたら、そろそろ本格的に疑ってかかる必要がありそうだ。

現在のグーグルは概して言えば、不正なスパムリンクを認識したら、それを無効化する。積極的に順位を下げる処置(俗に言うペナルティ)を与えることはめったにない(ただし、スパムの程度がひどければ、最終的には手動の対策が控えている。

しかし実際には、アルゴリズムレベルでも単なる無効化だけにとどまるとは限らないようだ。

検索エンジンを騙すスパムを実行している明らかなパターンが見られた場合は、サイト全体を信用しなくなることがある。

このように、グーグルのジョン・ミューラー氏はオフィスアワーでコメントしている。

またツイッターでは次のようにも言っている:

スパムや低品質シグナルによる無関係な効果を無視するように実行したあとに、残っているものに有益性を見出すのが困難だとしたら、サイト全体が怪しいと私たちのアルゴリズムは結論付けることがある。

This is the case for many spam & low-quality signals -- we'll work to ignore the irrelevant effects, but if it's hard to find anything useful that's remaining, our algorithms can end up being sceptical with the site overall.

— 🧀 John 🧀 (@JohnMu) November 1, 2021

スパムしかやっていないと判断されたサイトは、その時点ですべてが価値なしとしてみなされるのだ。たとえ本当に関連性があり品質が高いコンテンツがあっても、それさえも無視されてしまうかもしれない ―― そうした判定がアルゴリズムに含まれていたら逃げようがない。

「実害がなければスパムがバレても恐れるに足らず」という考えは通用しないと思っておくほうがよさそうだ。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

Search Analytics APIがDiscoverとGoogle ニュースをサポート

さらに正規表現もサポート (グーグル 検索セントラル ブログ) 国内情報

Search Analytics APIで、次の2つのパフォーマンスレポートのデータを入手できるようになった:

- Discover

- グーグル ニュース

ブラウザでアクセスするSearch Consoleの管理画面ではDiscoverとグーグルニュースのパフォーマンスレポートを確認できていた。しかしAPI経由では、これらのデータを取得できていなかった。

Discoverとグーグル ニュースからのトラフィックが多いサイトのウェブ担当者には、待ちに待った機能拡張だろう。

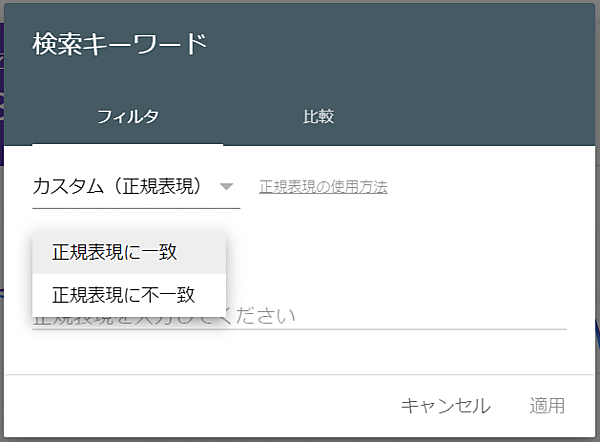

あわせて、クエリとページのディメンションで正規表現をサポートするようになった。こちらも、ブラウザの画面では利用できるようになっていた正規表現によるフィルタをAPIでも利用できるようにするもので、次の2つの演算子が追加された:

includingRegexexcludingRegex

正規表現を使えば、条件を指定してのデータ抽出が容易になる。

- Search Analytics APIを利用しているすべてのWeb担当者 必見!

- 技術がわかる人に伝えましょう

Spectreはなぜ危険なのか? そしてSharedArrayBufferを安全に使うには? グーグル社員が詳細に解説

難解だが有用な内容 (Tender Surrender) 海外情報

今年の3月に「SharedArrayBuffers の使用に必要な新しい要件」という件名のメールがSearch Consoleから届いたサイトがある。Spectreと呼ばれる、コンピュータCPUの脆弱性が発見されている。SharedArrayBuffer という仕組みがその脆弱性の影響を受けるので対応を要求する内容だった。

この問題の根本にある背景とその対処方法をグーグルのえーじ氏が個人ブログで解説した。大きくは、次のトピックに触れている。

- Spectreとは何か? どうして危険なのか?

- ヘッダーでの対処方法

SharedArrayBufferを安全に利用する方法

技術的に非常に高度な解説だ。2部構成で、しかもそれぞれが長い。それでも、詳しい背景と適切な対処方法を知るうえできわめて有用だ。特に、大規模サイトのウェブ担当者なら必読だろう。社内のエンジニアにも共有してあげるといい。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

- 技術がわかる人に伝えましょう

海外SEO情報ブログの

海外SEO情報ブログの

掲載記事からピックアップ

「品質」に関する記事を2本、今週はピックアップ。

- Google、検索品質評価ガイドラインの最新版(2021年10月19日付)を公開。重要な変更点は何か?

著者とサイトの情報公開をいっそう重視。

- すべてのWeb担当者 必見!

- コンテンツの品質とは記事だけを意味しない、サイト全体を見てGoogleは品質を判断する

ユーザー体験に関わる要素はすべて品質に含まれる。

- すべてのWeb担当者 必見!