今日は、ちょっとSEO的な話題を。robots.txtの内容を変えても、実はグーグルはすぐにはそれを反映してくれません。その説明と、「いますぐこのrobots.txtに更新」させる方法を解説します。

念のためにおさらいしておくと、robots.txtとは、グーグルなどの検索エンジンをはじめとする「機械的にWebページの内容を取得する」プログラムに対して、「このページは機械的にアクセスしていいよ」「このページはダメ」と指示する仕組み。

Webサイトのルートディレクトリに「robots.txt」というファイル名のテキストファイルを置いて、そこに指示を書きます。

たとえば検索エンジンにクロールしてほしくないページがあれば、robots.txt内で「Disallow(不許可)」という命令とともに指定しておくと、(robots.txtを尊重するシステムならば)それに従ってくれます。

ただ、このrobots.txt、グーグルはクロールのたびにチェックしているわけではありません。実際のrobots.txtを取得するのはだいたい1日に1回、または、数百ページクロールごとぐらいです。

つまり、robots.txtを修正しても、グーグルが前回取得したrobots.txtをキャッシュして使っている間は、その修正はすぐには反映されないということです。

でも、「今すぐに新しいrobots.txtを読み込んでほしい」という場合もあるでしょう。

そういうときはどうすればいいのでしょうか。

実は、ウェブマスターツールにそうした機能があります。

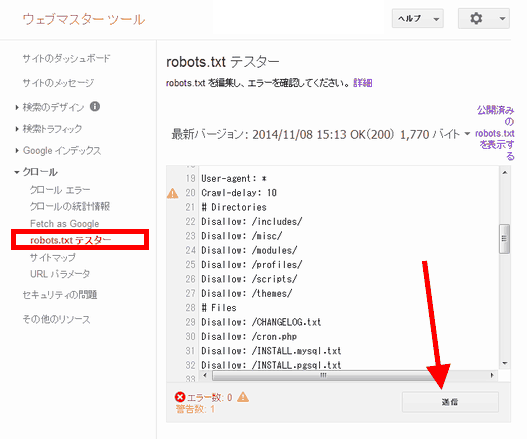

robots.txtファイルを更新したら、ウェブマスターツールで自分のサイトの[クロール]>[robots.txtテスター]を開いて、[送信]ボタンをクリックします。

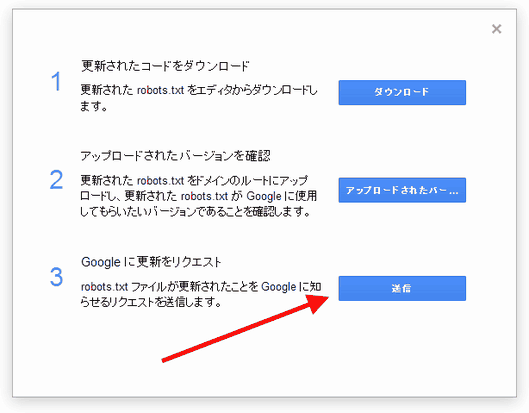

すると、ダイアログボックスが表示されるので、[アップロードされたバージョンを確認]で正しいrobots.txtになっているのを確認してから、[送信]ボタンをクリックします。

これで、robots.txtファイルが更新されたことをグーグルに通知できます。

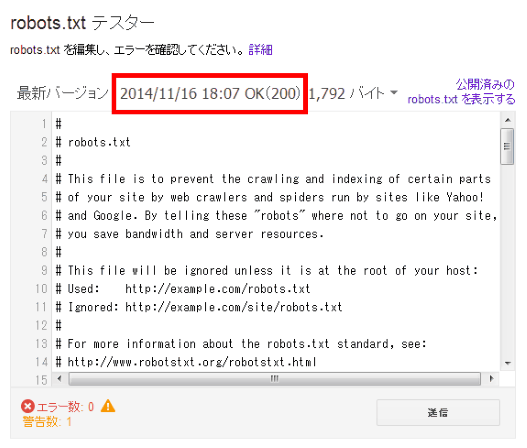

グーグルが最新のrobots.txtを認識しているかどうかは、同じくウェブマスターツールの[robots.txtテスター]で、上に表示されているバージョンの日付やrobots.txtの内容で確認できます。

ちなみに、robots.txtについては長らくrobotstxt.orgが標準的な参照先とされていましたが、グーグルはrobots.txtの仕様に関するドキュメントを公開しています。

- Robots.txtの仕様(Google Developers)

https://developers.google.com/webmasters/control-crawl-index/docs/robots_txt

まだ英語版しかないようですが、かなり詳しく書かれていますので、robots.txtについて知りたい方は読んでおくといいと思います。