グーグルの検索結果で「GOOGLE GUARANTEED(グーグル保証)」というバッジ(認定マーク)を表示するという、驚きの試験プログラムの情報が入ってきた。

と言っても通常のウェブ検索ではなく、ローカル検索のビジネスリスティングの話だ。グーグルの審査を受けたローカルビジネスの仕事に満足いかなかったら費用をグーグルが返金するというこのプログラム、日本ではまだのようだが、どうなっていくのだろうか。

今週は、ほかにも良質な情報が多い。特に、「YouTube埋め込みやいいね!ボタンをカンタンに遅延読み込みできるiframeのlazyload」「世界トップ580万サイトをもとにウェブの現状を分析した貴重なレポート」は必見だ。

あなたのSEO力をアップさせる情報を、ぜひしっかりと把握しておいてほしい。

- robots.txtをrobots.txtでブロックしたらどうなる?

- 特殊なファイルをrobots.txtでブロックすべきか?

- Search Consoleは複数の手段で所有者確認すべし

- グーグル社員がクロールバジェットを徹底解説

- iframeもYouTube埋め込みもFacebookボタンも簡単に遅延読み込み。HTMLに14文字追加するだけ

- 404ページへのアクセスで自動ブロックする仕組みがGooglebotに影響してしまう場合は

- AMPページで測定すべき成功指標をGoogleアナリティクスで設定する方法

- 大手経済誌がWebストーリーのTIPSを語る

- 【必見・保存版】世界トップ580万サイトをもとにウェブの現状を分析した貴重なレポート

- Google Discoverのヘルプ記事が大幅に刷新、E-A-Tへの言及を追加

- ネイティブLazy-loadのしきい値をChromeが改良。ビューポートからの距離を短くし、遅延読み込みが適用されやすく

今週のピックアップ

グーグル検索結果で“グーグル保証”マーク表示、月々5000円から!?

顧客が満足できなかった場合グーグルが代わりに返金 (Search Engine Land) 海外情報

グーグルの検索結果で「グーグル保証」の認定マークを表示できるとしたら、あなたはいくら払うだろうか?

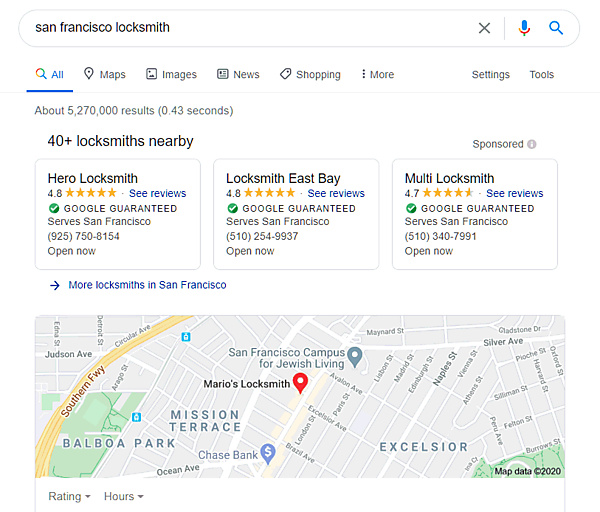

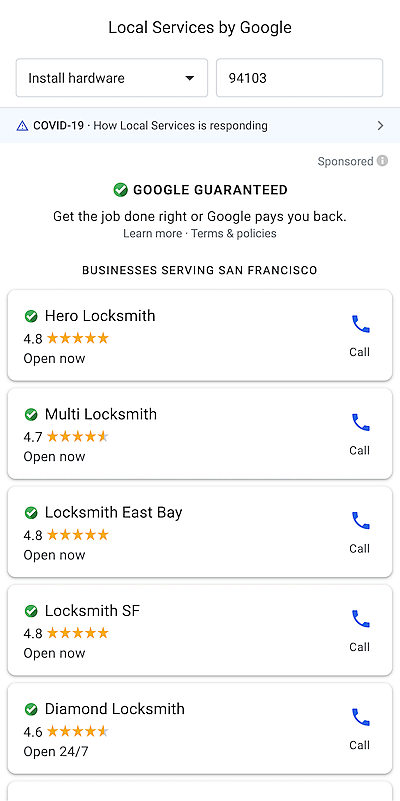

「GOOGLE GUARANTEED(グーグル保証)」というバッジをローカル検索のグーグル マイビジネス リスティングに表示する月額50米ドル(約5300円)の有料サービスをグーグルが試験的に始めたようだ。

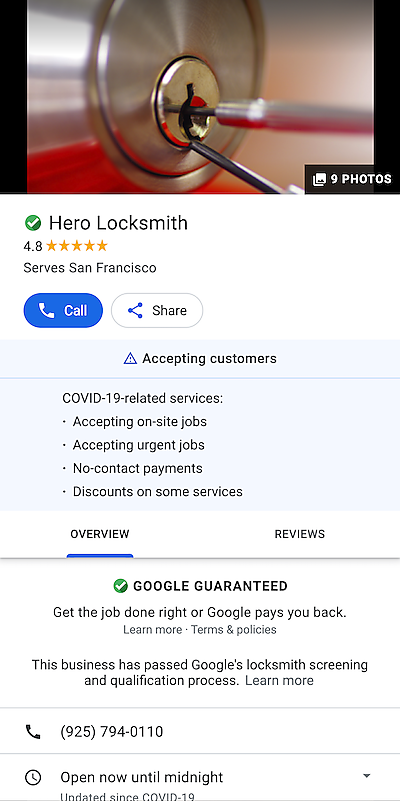

Google Guarantee(グーグル保証)のサービスは、米国とカナダにおいて、鍵修理・クリーニング・水漏れ修理など特定の業種を対象に提供されている。このプログラムはローカル検索広告サービスに含まれれている。したがって広告を出稿している必要があり、さらにグーグルの審査・認定というハードルがある。

しかしこのプログラムに参加すると、グーグル経由で申し込まれたサービスに顧客が満足しなかった場合、グーグルが料金を顧客に返金してくれるようになる。つまりグーグルによる返金保証だ。もちろん、ビジネスリスティングで保証マークが表示されるようになる。

今回の試験提供では、広告出稿する必要はなく、その代わりに月額料金を支払うらしい。どういった業種が対象になるのかまではわからない。

日本で提供されるかもまったく不明だが、月々5000円だったらグーグル保証のサービスをあなたは利用したいだろうか?

- ローカルSEOがんばってる人用(ふつうの人は気にしなくていい)

グーグル検索SEO情報

robots.txtをrobots.txtでブロックしたらどうなる?

robots.txtクイズに挑戦 (Gary Illyes on Twitter) 海外情報

前回に続いて、グーグルのゲイリー・イリェーシュ氏が出題したrobots.txtクイズを紹介する。

質問 次の記述のように、Googlebotがrobots.txtをクロールするのをrobots.txtでブロックしたらどうなるか?

User-agent: Googlebot

Disallow: /robots.txt- 回答①: Googlebotは通常どおりクロールする

- 回答②: Googlebotはクロールしない

正解は①だ。robots.txtをrobots.txtでブロックしても機能しない。robots.txtの仕様に従うクローラはrobots.txtの記述を命令として必ず適用する。しかし、ブロック対象としてrobots.txtは例外だ。

検索エンジンはサイトにアクセスする際にまずrobots.txtの内容を確認する。イメージ的には、robots.txtを見たら「robots.txtを見てはダメ」と書かれていたけれど「もう遅いよ! 見ちゃったよ!」といった感じだろうか。

回答者の3分の2強が正解していた。さほど難しくなかったようだ(同じ質問をジョン・ミューラー氏に以前に聞いたことがあったので筆者は正解できた)。

question from @rich_falconer :

— Gary 鯨理/경리 Illyes (@methode) July 18, 2020

'''

What happens if you do this in robots.txt?

User-agent: Googlebot

Disallow: /robots.txt

'''

- ホントにSEOを極めたい人だけ

特殊なファイルをrobots.txtでブロックすべきか?

CSSはブロック禁止、php.iniと.htaccessはブロック不要 (#AskGoogleWebmasters on YouTube) 海外情報

特殊なファイルのクロールをrobots.txtでブロックすべきかどうかという質問にグーグルのジョン・ミューラー氏が動画で回答した。

具体的には次の3種類のファイルだ。

- *.css(CSSファイル全般)

- php.ini

- .htaccess

Googlebotのクロールをブロックするとしたら次のような記述になるだろう。

User-agent:Googlebot Disallow: *.css$ Disallow:php.ini$ Disallow:.htaccess$

しかし、このとおりに記載するべきではない。

というのも、原則的にCSSはブロックしてはいけないからだ。GooglebotがCSSにアクセスできないとそのページを正しくレンダリングできない。ランキングに悪影響が出る可能性がある。

一方で、php.iniと.htaccessはブロックする必要はない。そもそもこれらのファイルは外部からのアクセスが禁止されている。robots.txtでブロックしていようがしていまいが、もともとGooglebotはアクセスできないはずだ。

というよりも、もしGooglebotに限らず外部ユーザーがアクセスできたとしたらセキュリティ上大問題だ。robots.txtでなんとかしようとするのではなく、Webサーバーの設定をしっかりと確認するべきだろう。

- ホントにSEOを極めたい人だけ

Search Consoleは複数の手段で所有者確認すべし

備えあれば憂いなし (John on Twitter) 海外情報

Search Consoleのサイト登録に関する重要なTIPSをお伝えする。それは、次のようなものだ:

サイトの所有権は、複数の方法で確認しておくことをおすすめする。たとえば、確認用metaタグとDNSによる確認の併用だ。

グーグルはサイト確認状態が保持されているかを定期的にチェックしている。このおかげで、たとえば退職した人がSearch Consoleを見られなくするなどできるのだが、意図的ではなく確認状態が失われてしまったら問題が発生する。

1つの手段(metaタグだけ)で所有確認していると、それが失われるとSearch Consoleにアクセスできなくなってしまうのだ。未確認の状態が短期間であれば気にすることはないだろうが、もし長期にわたってサイト確認に失敗するとひょっとしたらその期間のデータが手に入らなくなるかもしれない。

そういった状況を避けるためにも、複数の方法でサイト所有を確認しておくのがいいと、グーグルのジョン・ミューラー氏は解説している。もし何らかの原因で、1つの確認手段が無効になったとしても、別の手段でGoogleは所有権を確認できる。いわばバックアップだ。

確認手段の種類と設定はヘルプ記事で参照できる。

- すべてのWeb担当者 必見!

グーグル社員がクロールバジェットを徹底解説

難易度高 (アユダンテ コラム) 国内情報

グーグルのマーティン・スプリット氏がクロール バジェットについて動画で詳細に解説した。アユダンテのコガン・ポリーナ氏が日本語に書き起こしてくれた。

次の関連トピックに触れている。

- クロールバジェットとは

- クロール頻度とクロールの必要性とは

- クロール頻度とクロールの必要性の判断条件

- ETag、HTTPヘッダー、Sitemap.xmlの最終更新日など

- クロールバジェットに注意するべきサイトの規模

- クロールバジェットの「問題」

- コンテンツの品質とクロール頻度の関係

- サーバーがGoogleに試されているときのサーバーログ

- サイト移転のポイント

- クロールバジェットとサイトの構造

- レンダリングへの影響

- リソースのキャッシュ

- サイト業種とクロールバジェットの関係

- Googlebotのクロールを手伝う基本的な方法

- 良く起こりえる課題

- クロール頻度を上げるための設定があるか

技術的に高度な内容も多く含まれているが、テクニカルSEOに強くなりたければ読むといい。

オリジナルの英語で聴きたい人のために動画も埋め込んでおく。

- ホントにSEOを極めたい人だけ

- 技術がわかる人に伝えましょう