この記事はパンダ・アップデートによって変化した重複コンテンツの問題を広範に扱った長文の記事で、4回に分けてお届けしている。2回目となる今回は、重複コンテンツ問題を解決する手段を見ていこう。

パンダ・アップデート対応版

IV 重複問題の解決に役立つ方法

説明の順番が適当でない感じがするかもしれないが、具体例の解説に進む前に、重複コンテンツに対処する方法をいくつか紹介しておきたい。そうしておけば、各事例を修正するための適切なお薦めツールを、混乱を招くことなく紹介できるだろうから。

ここで紹介するのは、次の12種類の方法だ。

- 重複ページを削除する

- 301リダイレクト

- robots.txt

- meta robotsタグ

- URL正規化タグ(rel="canonical")

- URLの削除(グーグル)

- パラメータによるブロック(グーグル)

- URLの削除(Bing)

- パラメータによるブロック(Bing)

- 「rel="next"」と「rel="prev"」

- link rel="syndication-source"

- サイト内リンクの構造

- 何もしない

それぞれについて詳しく解説していこう。

IV-1 重複ページを削除する

最も簡単な重複コンテンツ対処法はもちろん、該当するページを削除して404エラーを返すことだ。

そのコンテンツが本当に訪問者や検索エンジンにとって何の価値もないものなら、また重要な被リンクやトラフィックもないなら、すっきり削除してしまうのが完璧に有効な方法だ。

IV-2 301リダイレクト

ページを削除するもう1つの方法は、301リダイレクトを使うやり方だ。

404エラーと違って、301リダイレクトは訪問者に(人間でも検索ロボットでも)、該当ページが別の場所に恒久的に移動されたことを伝える。訪問者が人間の場合、ブラウザは自動的にリダイレクト先のページを表示してくれる。SEOの観点から見ると、被リンクが持つ信頼度の大部分は新しいページにも渡される。

重複コンテンツの正規URLがはっきりしていて、そのコンテンツがトラフィックや被リンクを獲得しているなら、301リダイレクトは有効な選択肢になり得る。

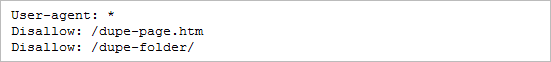

IV-3 robots.txt

もう1つの選択肢は、人間の訪問者には重複コンテンツが見えるようにしておくが、検索エンジンのクローラーは締め出してしまうというものだ。

これを実現する方法として最も古く、おそらく最も簡単なのがrobots.txtファイル(普通はルートディレクトリに置かれる)を使うやり方だ。たとえばこんな感じになる。

robots.txtが持つ長所の1つは、フォルダ全体、場合によってはパラメータ付きのURLさえ比較的容易にブロックできることだ。

短所は、ちょっと強力過ぎて、時には信頼性に欠けるソリューションだという点だ。robots.txtはクローラーがまだアクセスしていないコンテンツをブロックするのには効果的だが、すでにインデックス化されているコンテンツを削除する方法としては有効ではない。

主要な検索エンジンもrobots.txtの多用を嫌っているようで、一般に重複コンテンツ対策としてはrobots.txtを推奨していない。

IV-4 meta robotsタグ

HTMLの<head>要素内でmeta robotsタグ(またはmeta noindex)を使って、ページ単位で検索ロボットの行動を制御することもできる。最も簡単な指定は次のようになる。

このディレクティブは検索ロボットに対して、あるページをインデックス化しないように、あるいはそこにあるリンクをたどらないようにと指示する。ついでに、僕はこちらの方がrobots.txtよりも若干SEOと親和性が高いと思うし、プログラムで動的に生成できるので、より柔軟な使い方ができることも多い。

meta robotsタグのcontent属性値として、上の例で挙げた「noindex, nofollow」以外によく使われるのが「noindex, follow」だ。こうしておくと、そのページはインデックスに追加されないが、ページ上にあるリンクは検索ロボットにたどってもらうことができる。サイト内検索の結果表示のようなページではこれが役に立つ。検索のしかたによって何通りも生成されるURLのうち、ある形式のものはブロックすべき(これについては後で説明しよう)だが、それでも製品ページへのリンクはたどってもらわなければ困るだろう。

ここで一言。「index, follow」というmeta robotsタグをページに追加する必要はまったくない。すべてのページは、(他の方法でブロックされていなければ)何もしなくてもインデックス化され、リンクもたどってもらえるので、そうするように指示するのは無駄なのだ。

IV-5 URL正規化タグ(rel="canonical")

2009年、検索エンジン各社が手を組んで、rel="canonical"というURL正規化タグを作り出した。単に「rel="canonical"」とか「カノニカルタグ」と呼ばれることもあるこのディレクティブを使うことで、ウェブマスターはすべてのページについて正規バージョンのURLを指定できるようになった。

このタグは(meta robotsタグと同様に)HTMLページの<head>要素内に置かれる。簡単な例を次に示そう。

検索ロボットがカノニカルタグのあるページにやってくると、そこへたどりつくのに使ったURLが何であれ、正規のURLをそのページのURLとみなす。だから、たとえば検索ロボットが上に挙げた例のようなカノニカルタグが書かれているページにたどりついたURLが「www.example.com/index.html」だったとしても、そのページのURLは正規化指定されているURLと比べると「index.html」が付いている非正規URLなのでので、検索エンジンは余計な非正規URLをインデックス化しない。流れ込んでくるリンクジュースも、通常はカノニカルタグを通じて引き渡されているようだ。

ここで指摘すべき重要な点は、ウェブサイトのあらゆるテンプレートに対して、どれが正しい正規ページなのかを明確に把握しておく必要があるということだ。サイト全体を1つのページで正規化したり、間違ったページで正規化したりすると、悲惨な結果を招く可能性がある。