本編の原稿には間に合わなかったが、パンダアップデートの日本語サイトへの実施をグーグルが公式に発表した。

渡辺隆広氏が「Googleパンダアップデート 傾向と対策 通販、求人、旅行、不動産 など」の記事を公開しているし、SEO Japanでも「パンダアップデート日本上陸に勝利するために読みたい16の記事」というまとめを公開しているので、もしまだ対応していないようならば、参考にしてほしい。

ひどい悪徳SEO業者の実例と、だまされないために必要なこと

知らなかったでは済まされない (High Rankings Advisor)

完全なホワイトハットSEOで有名なHigh RankingsのCEOであるジル・ウォーレン氏が、ペンギンアップデートで大きな痛手を負ったサイト管理者の相談を受け、そのサイトを診断した。すると、次のようなことが発見できた。

無関係で質の低い大量のリンクがあった。それらは、スパムブログ、記事投稿サイト、見せかけだけの登録型ディレクトリなどから張られていた。

それらのリンクは、アンカーテキストのバリエーションが2~3種類しかなく、すべてトップページへのリンクだった。

短期間に集中的にリンクを増やした形跡がある。

これらは、サイトのWeb担当者自身が行ったことではなく、依頼したSEO業者が行った行為である。どうやらそのWeb担当者はウェブの知識とスキルに乏しく、SEO業者にすべて任せっきりだったようだ。

さらに悪いことにこのSEO業者は、クライアントのサイトのブログに、コンテンツに価値がなく文章も文法的に間違いだらけの記事を掲載し、自らのサイトにリンクを張っていたようだ。

これらの事実をウォーレン氏によって知らされたWeb担当者は、リンクを外すようにそのSEO業者に頼んだのだが、次のような返事が返ってきたそうだ。

リンク先の情報を提供するのはブラックハットのリンク販売会社がやることだ。

そのうえ次のように脅してきた。

今契約を解除したらさらにアクセスが落ちるしショッピングカートが適切に動作しなくなる。

そもそもアンカーテキストでつかわれていたキーワードは、誰も検索しないような(検索回数が非常に少ない)無価値のキーワードだったそうだし、ショッピングカートに関する脅しは意味不明である。

ウォーレン氏は、「どんなまっとうなSEO会社に尋ねたとしても、このSEO業者は間違いなくSEOスパムだという答が返ってくるだろう」と、そのWeb担当者に伝えたのだが、信じがたいことに、その後連絡が途絶えているそうだ。

ここまでひどい例ではないが、クライアントの知識不足をいいことにスパム的な施策を行うSEO業者の被害に遭ったサイトの例を、筆者もいくつか見たことがある。

そのSEO業者は、かつてはスパム手法で上位表示を達成できていた時代があったため、それが実績になっていて、なおさらたちが悪い。事例に出したサイトも、ペンギンアップデートが導入されるまでは、グーグル検索から多くのアクセスを集めていた。

外部のSEO会社にSEOを依頼するときは、任せっきりにしてはいけない。どんなことをやっているのか必ず報告を受け、自分の目でそれが正しいのかどうかを確かめよう。

自分の本業がSEOではないとしても、最低限のSEOの知識は身に付けておかなければならない。

「グーグル ウェブマスター向けガイドライン」と「検索エンジン最適化スターターガイド」、そしてこのコーナーの毎週の更新は必ず読むことを強く推奨したい。

日本語で読めるSEO/SEM情報

内部要因SEOの重要性が増しているという噂は本当か?

以前から重要 (SEOのホワイトハットジャパン)

「内部施策の重要性が増す」という検索キーワードでトラフィックがあったことをアクセス解析ツールで発見し、本当にそうなのかどうかについて自分なりの見解を語った記事。

次のように結論づけている。

内部施策の重要性が増しているのではなく、内部施策は元々重要である

筆者もそう思う。ペンギンアップデートを含めて作為的なリンクに対して警告が出されるようになってきたために、SEOに取り組む人たちのなかで被リンク至上主義だった一部の人が内部要因に目を向けるようになった。ただそれだけだというのが実際のところではないだろうか。

グーグルに適した内部対策を施策するにはグーグル自身が公開している『検索エンジン最適化スターターガイド』(PDF)を読むといい。

このガイドが作られたのは2年近く前なのに、今でも立派に通用する内容だ。被リンクがどうのこうの言う前に、まずこのガイドを穴が空くくらいよく読むべきだ。

特に一般企業のウェブ担当者は、たとえ外部にSEOを委託している場合であっても、ここに書いてあることを十分に理解しておいてほしい。そうすれば自社のサイトにふさわしいSEOを施策してもらえているかどうかを判断する助けになる。

これさえできればあなたもアルファブロガーになれる? 良質なブログ記事を書くための10個の秘訣

記事にかける時間はたった30分 (バズ部)

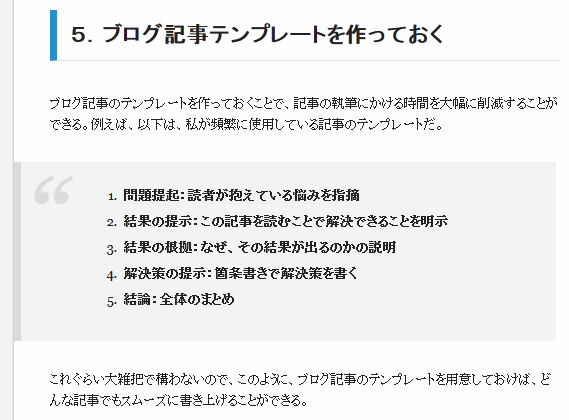

有益なブログ記事を短い時間で書き終えるために、日々実践しているというライティングの秘訣を10個解説した記事。10個の秘訣は次のとおりだ。

- アイデアのリストを作る

- 良いアイデアが浮かんだ時はすぐに書く

- タイトルを先に決めておく

- 書くべき内容を箇条書きでまとめておく

- ブログ記事テンプレートを作っておく

- リスト形式で書いて行く

- 時間を制限して書き上げる

- 手が進まない時は他の作業を優先する

- 目標時間を決めて毎回タイムを計測する

- 目標を立ててエンジョイする

アイデア練り→タイトル決めといった最も重要な部分もさることながら、記事の構成パターンを決めておくという部分も、文章書きが苦手な人には役にたつだろう。

最後をこのように締めくくっている。

良質なブログ記事を継続的に書き続けるためのコツは、簡潔に言うと、良質な情報や経験を自動的にインプットする仕組みと、そのインプットを効率的にアウトプットする仕組みを用意することだ。

筆者もブログを毎日書き続けて5年半がたとうとしているが、この意見には100%同意できる。10個すべてを確実に実践するのは容易ではないかもしれない。正直に言えば筆者も全部はできていない。しかしできるところから始め少しずつカバー範囲を広げていってはいかがだろうか。

hタグがSEOに重要な理由

ランキングを直接的に上げるためではない (SEO Imagination!ブログ)

こちらも内部要因のトピックになるだろうか。見出しタグ(hタグ)の適切な使い方について解説している。

hタグをいじったからといって目に見えて検索結果でのランキングが上昇するということはないが、文章の論理構造を検索エンジンに的確に伝えるためにhタグが大切な要素であることは間違いない。

順位アップに関しては間接的に貢献することがあり得るというぐらいで、そもそも公開する文書として論理構造をしっかりと表現して、読む人にわかりやすいページにするために見出しを適切に使うのが良いだろう。

hタグの本来の正しい使い方を、こちらの記事であらためて学び直してほしい。

グーグル推奨のHTML&CSSコーディングガイドライン最新版

理想的かつ現実的とのこと (グーグル ウェブマスター向け公式ブログ)

グーグルは、HTMLとCSSのコードの書き方についての推奨ガイドラインの最新版(リビジョン2.2)を公開した。現実的なコードの書き方と理想的なスタイルの両方を基軸とできるように設計されているとのことである。

実はこのガイドラインは今年の4月に公開されたものである。英語版しかないが主要な部分をこのコーナーで公開直後に解説したので参考にしてほしい(また、こちらやこちらでは和訳が提供されている)。

ただし、公開時のリビジョンは2.1だったので、わかる人はこちらの情報を参考に差分を確認するといいだろう。

ホットなトピックでナチュラルリンクを獲得する方法

ブランド構築にも役立つかも (SEOとその周辺)

グーグルにはQDFと呼ばれるアルゴリズムがある。簡単に言えば、QDFとは「ホットな(そのときに話題になっている)トピックに関する検索がなされたときに、より新しいコンテンツを上位に表示する」仕組みだ。

このQDFを巧みに利用してユーザーが求めているコンテンツを作成し検索結果での露出を高めて自然なリンクを大量に獲得しようというのが、こちらの記事のテーマである。

旬な話題をネタにするため継続的なリンクの増加にはつながりにくいし、ツイッターやフェイスブックなどのソーシャルメディアでの言及にとどまりブログやサイトからのリンクまでに至らないかもしれない。また、元記事の最後のほうに書かれているように、ただ二次情報を流せばいいわけではない。

しかし、単なる情報を加工しただけの2次情報では人々の心を動かさない。リンクは集まらない。

独自の情報、考察、切り口などが絶対に必要なのだ。

しかし人々が求めているトピックを探しそれに対するコンテンツを作り出すには参考になるプロセスである。それに、一時的だとはいえ多くの検索トラフィックやはてなブックマークを繰り返し集めることに成功すれば、ブランド構築に貢献することも考えられる。

日々のネタ探しに困っている方にはヒントになるだろう。挑戦してみよう。

海外SEO情報ブログの

海外SEO情報ブログの

掲載記事からピックアップ

グーグルが検索結果に出したいコンテンツは何なのかとrobots.txtの細かな仕様を解説した記事を今週はピックアップ。

- 検索エンジンが求めているのは“付加価値”、オリジナルなだけでは足りない。

他のサイトにはない価値ある独自の情報 - robots.txtでAllowを使うのはどんな時?

AllowはDisallowと組み合わせて