生成AI、つまり人工知能(AI)と大規模言語モデル(LLM)は、コンテンツマーケティングとSEOに創造的破壊をもたらし、ワークフローや戦略へのアプローチの仕方を根本的に変えた。マイク・キング氏のような専門家がSEOにAIを活用する101のやり方を紹介しているように、その可能性は計り知れず、今も拡大し続けているのは明らかだ。

だが残念なことに、生成AIが急速に普及したことで、特にコンテンツの独創性や品質の点で課題が噴出している。適切な検証を行わなければ、生成AIの出力はサイトの評判や信頼を損なうリスクがあり、メリットよりデメリットの方が大きくなりかねない。

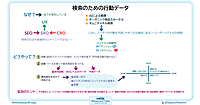

しかし、今や生成AI時代なのだから、この記事で紹介する、

SEOの業務フローに生成をAI取り入れるための包括的なプロセス

フレームワークに沿って生成AIに対して効果的なプロンプトを自動生成するスプレッドシート(無料で利用可能、日本語化済み)

すでにChatGPTと連携しているSEOツール3選

検証システムを導入しながら生成AIの可能性を最大限に引き出す方法

を理解し、生成AIとともにあなたのSEO業務を次の段階へと進めてみてほしい。

生成AIには限界があり、それを理解することが重要だ

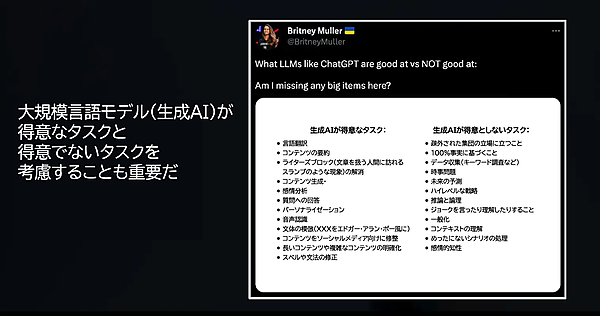

生成AIは強力なツールだが、あらゆるタスクに適しているわけではない。誤りを回避し、これらのツールを責任を持って使用するには、生成AIの限界を理解することが重要だ。

ブリトニー・ミュラー氏が強調しているように、ChatGPTのような生成AIが得意とする特定のタスクもあれば、生成AIで自動化すべきではないタスクもある。

生成AIを使用すべきでないタスクには注意!

生成AIを使用すべきでないシナリオには、次のようなものがある:

機密性が高い、または重要な意思決定 ―― 「高い精度が求められるタスク」や「機密データが関わるタスク」を自動化するために生成AIを使用してはならない。たとえば、法律や医療に関する推奨事項に関して重大な結果をもたらす誤りを回避するには、人間の専門知識が必要となる。

影響の大きいクリエイティブな作業 ―― 独自のブランドキャンペーンの作成など、「独自性」や「創造性」が最も重要視される場合、生成AIでは平凡な結果やつまらない結果が生成される可能性がある。

機密性の高いデータを取り扱う環境 ―― 機密情報や極秘情報を生成AIと共有すると、セキュリティ上のリスクを引き起こすおそれがある。機密データは常に匿名化し、重要な詳細情報が漏れないようにしよう。

SEOの業務フローに生成AIを取り入れる3つの方法

では、生成AIが得意な分野ならばSEOの業務フローでどんどん使えばいいのだろうか?

実際に生成AIを使うにあたっての流れを、「プロンプト」「プロンプトライブラリ」「SEOツールとの連携」という3つのポイントで考えてみるのはどうだろうか。

1. プロンプトを与える

生成AIを最大限に活用するには、何よりも適切な質問・指示が大切だ。正確なプロンプトを与えることにより、明確で関連性が高く、実行可能な結果が得られるほか、時間の節約になり、同じことを何度も繰り返す手間を減らせる。

「SEOに生成AIを使う」となると、次のような指示をChatGPTに投げようとする人もいるのではないだろうか?

title要素のアイデアをいくつか教えて

しかし、生成AIは万能ではない。そのため、単に「title要素のアイデア」とだけ言っても、良いものがでるとは限らない。次のように指示してみるのはどうだろうか?

ホワイトジーンズのカテゴリーページ用に、SEOに最適化されたtitle要素を5つ生成して。

対象者はジーンズを購入する可能性がある人で、興味を引く描写的なトーンにすること。

各title要素は50文字以内で、検索結果に合わせて最適化してほしい

このプロンプトなら明確で正確なので、生成AIからは1回目で希望に近い結果が得られるだろう。

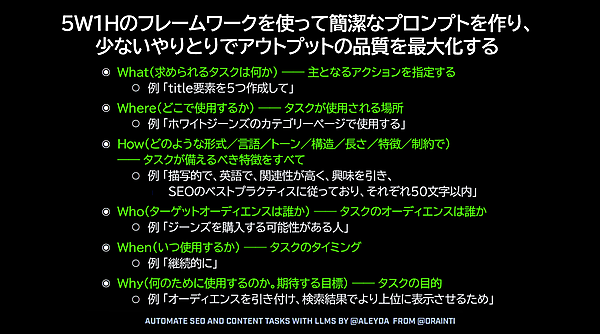

これは、生成AIに指示する簡潔なプロンプトのなかに重要な要素をしっかりと入れ、何回もやりとりしなくても良い結果を引き出す「5W1Hのフレームワーク」を使った例で、効果的なアプローチの1つだ。

「5W1Hのフレームワーク」では、生成AIへの指示プロンプトにおいて、次の点を明確に示すのがポイントだ:

求められるタスクは何(What)か? 主となるアクションを指定する。

例:「最適化したtitle要素を5つ作成して」どこで(Where)使用するか? コンテキストまたは場所を定義する。

例:「ホワイトジーンズのカテゴリーページで使用する」どのような(How)形式にするか? トーン、言語、構造、制約などの詳細を伝える。

例:「描写的で、英語で、関連性が高く、興味を引き、SEOのベストプラクティスに従っており、それぞれ50文字以内」ターゲットオーディエンスは誰(Who)か? 対象となるオーディエンスを特定する。

例:「ジーンズを購入する可能性がある人」いつ(When)使用するか? タイミングや頻度に言及する。

例:「継続的に」なぜ(Why)使用するのか? 目的や目標を述べる。

例:「オーディエンスを引き付け、検索結果でより上位に表示させるため」

2. プロンプトライブラリを作成する

カスタマイズしたプロンプトのライブラリを作成することで、一貫性を確保し、時間を節約できるほか、反復的なタスクについて当て推量を減らせる。

プロンプトライブラリを効果的に構築して使用する方法として、押さえておくとい良いポイントがある。次の3点だ:

再利用可能なプロンプトを作る:

title要素やmeta description、コンテンツのアウトラインの生成など、繰り返し発生するタスクを特定する。

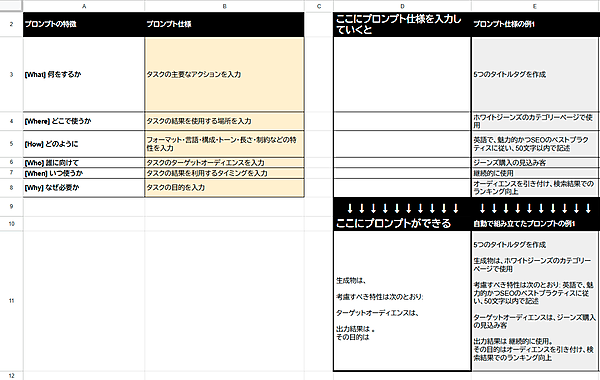

5W1Hのようなフレームワークを使用して、一貫して信頼性の高い結果が得られる明解なプロンプトを作る。

プロンプトを整理して、素早くアクセスできるようにする:

プロンプトをタスクの種類別に分類する(例: コンテンツの作成(リンク先は日本語記事)、テクニカルSEO、競合分析 など)。

プロンプトの保存、タグ付け、検索には、GoogleスプレッドシートやNotionなどのツールを利用する。私のSEOプロンプトジェネレーターを自由にコピーしてもらって構わない(日本語版はここから)。

チーム全体でワークフローを標準化する:

チームとプロンプトライブラリを共有し、特に共同プロジェクトで一貫した出力が得られるようにする。

各自のニーズに合わせてライブラリを改良し、拡張するようチームメンバーに促す。

たとえば、meta descriptionを作るために毎回新しいプロンプトを作るのではなく、再利用可能なテンプレートを作っておくといい。その場合、次のようなテンプレートが考えられる:

[ページ/トピック]のmeta descriptionを書いて。興味を引くトーンで、キーワード[キーワード]を盛り込み、160文字未満にすること

3. SEOツールとChatGPTを連携させる

プラットフォームにChatGPTの機能を組み込むSEOツールが増えている。こうした統合により、既存のワークフローを離れることなく、インサイトや推奨事項を生成できる。

優れたAI搭載SEOツールと具体的なアプリケーションをいくつか紹介しよう。

SEOTesting.com

SEOTesting.comはプラットフォームにChatGPTを組み込んでおり、コンテンツの最適化とレポート作成のタスクを簡素化している。この統合により、カスタマイズ可能なリアルタイムの提案が可能だ。

SEOtesting.comの主なユースケースは、次のようなものだ:

メタデータが不足していたり、弱かったりするパフォーマンスの低いページを特定する。

インサイトを用いて、不足しているキーワードの追加やtitle要素の言い換えなどによりメタデータを改善し、キーワードの検索意図に近づける。

Horseman

SEOクローラーのHorsemanは、技術的な精査とコンテンツの推奨事項を組み合わせることで、メタデータの最適化とキーワード抽出の問題に対応している。

Horsemanの主なユースケースは、次のようなものだ:

meta descriptionの生成 ―― メタデータが不足しているページのdescriptionを自動生成し、最も関連性の高いキーワードと一致させる。

キーワード抽出 ―― ページコンテンツを分析し、上位に表示されているキーワードや不足しているキーワードを特定し、メタデータに組み込むことを提案する。

テクニカルSEOのインサイト ―― ノーコードのAIインターフェースを使ってスクレイピングし、クロール中に特定されたテクニカルSEOの問題を解決するための実行可能な推奨事項を取得する。

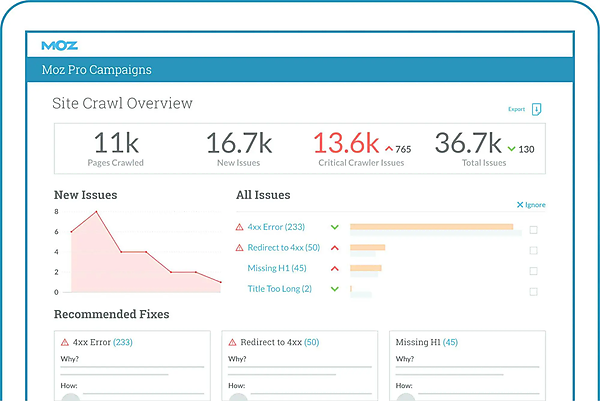

もちろんMoz ProのSite Crawlも

より包括的なソリューションを探しているなら、Moz ProのSite Crawlを試してみよう。Horsemanはメタデータの最適化とキーワード抽出に重点を置いているが、MozのSite Crawlはリダイレクト、クロールエラー、メタデータの欠落など、より幅広い問題を特定し、その影響に基づいて修正に優先順位を付けている。

独自のRogerbotクローラーにより、複雑なウェブサイトでも網羅的に精査できるため、迅速な問題解決に役立つ実用的な知見を得られる。

Numerous.ai

Numerous.aiは、GoogleスプレッドシートにChatGPTへの指示を書けば結果に反映される仕組みをもっている。

指示を1つ書いてあとは他のセルにドラッグして拡げるだけで、「キーワードの分類」「感情分析」「コンテンツの書き換え」などを一度に操作できる。反復的なタスクを大規模なデータセット全体に広げる場合に最適なツールだ。

Numerous.aiの主なユースケースは、次のようなものだ:

検索意図の分析 ―― キーワード一括分析を実施して、検索意図を、

- トランザクション[取引]型

- インフォメーション[情報収集]型

- コマーシャル[商業]型

- ナビゲーション[案内]型

などに分類する。

小規模なタスク向けに、GoogleスプレッドシートとNumerous.aiを統合することで、迅速かつアクセスしやすいソリューションを提供している。

もちろんMozのMoz APIも

ただし、より大規模な作業や重要な作業には、Moz APIのようなツールが不可欠だ。Moz APIを使うと、データベース内のキーワードの検索意図について最新のスコアを取得でき、影響の大きなプロジェクトやエンタープライズ規模のプロジェクトで強固な基盤になる。

次のようなタスクを大量に処理したい場合には最適だ:

キーワードの分類 ―― 大量のキーワードリストから親カテゴリや主題を検出し、効率的に整理する。

コンテンツの一括生成 ―― 複数のページのtitle要素、meta description、h1要素、FAQを一度に生成する。

テンプレートの書き換え ―― 既存のコンテンツテンプレートを書き換えて、異なるカテゴリ、場所、またはリスティングごとに独自性を出す。

自動化と人の専門知識のバランスを取る

自動化は強力な味方だが、万能ではない。生成AIはワークフローの効率化やインサイトの生成に優れているが、正確性や倫理、ブランドガイドラインとの整合性を確保するには、人による継続的な監督が不可欠だ。

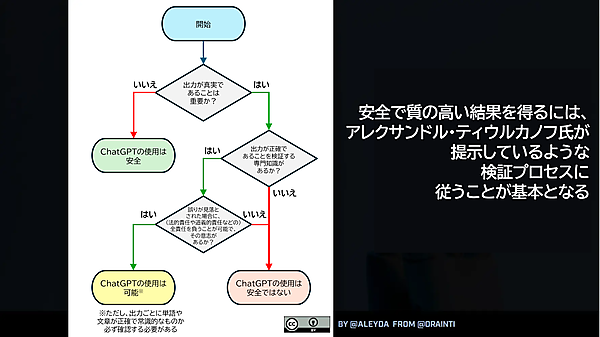

高品質な成果を得るには、検証プロセスが欠かせない。アレクサンドル・ティウルカノフ氏が強調しているように、AIの出力を信頼性のある実用的な結果にするには、専門家の検証と改良が鍵となる。

たとえば、生成AIはメタデータやFAQを一括生成できるが、さらに人がレビューすることで、関連性、独自性、SEOのベストプラクティスとの整合性を確保できる。私は生成AIをパートナーだと考えたい。次のような役割分担をしているイメージだ:

- 生成AI → 大変な作業を処理する役割

- 私(人間) → 最終結果へと導く役割

自動化と人による入力との適切なバランスの取り方を、いくつか紹介しておこう:

出力がブランドに合っているかを確認する ―― 生成AIはコンテンツをすばやく生成できるが、ニュアンスに欠けるため、君の「ブランドボイス」を十分に伝えきれないこともある(リンク先は日本語記事)。出力が君のメッセージに沿っており、君のオーディエンスに響くものであるか常に確認しよう。

倫理的な懸念や偏見がないか監視する ―― 生成AIには背景情報が足りないため、意図せず「偏った内容」や「文化的配慮に欠けるコンテンツ」を生成してしまう可能性がある。人がレビューすることで「インクルーシビティ(社会的包括性)」を確保し、「倫理規範」を順守できる。

品質と具体性を高める ―― 生成AIの出力は、ときとして「広範で汎用的すぎる」場合がある。こうした出力を洗練させることで、最終的な成果物がユーザーの期待と品質基準を満たすものになるよう改善できる。

ファクトチェック(事実確認)をする ―― AIは「古い情報」や「誤った情報」を生成することがある。事実を検証することで正確性を担保できる。

盗用などの潜在的リスクを回避する ―― 生成AIの出力は学習データのパターンに基づいているため、重複コンテンツにつながる可能性がある。品質を維持するために、ツールを使って「独自性」をチェックし、結果を改善しよう。

総括:全体として生成AIを機能させるには、徹底的な検証プロセスが必要

ChatGPTのようなAIツールは、SEOの業務フローを変革できる。ただしそれは、人の専門知識と強力な検証プロセスを組み合わせた場合だけだ。

ここで紹介したテンプレート、リソース、プロンプトライブラリを試してみたり、他のツールを調べたりして、SEO戦略を改善してほしい。