Search Consoleの一括データエクスポート機能の使い方をグーグル社員が解説

グーグル検索SEO情報②

Search Consoleの一括データエクスポート機能の使い方をグーグル社員が解説

まずは基礎編 (Google Search Console Training on YouTube) 海外情報

Search Consoleでは、検索パフォーマンスのデータをグーグルのBigQueryに毎日継続的に一括エクスポートできる。これは、今年の2月に提供された機能だ。

この機能の使い方をダニエル・ウェイズバーグ氏が動画で解説した。

シリーズになるらしく、まずは基礎編。トピックは次のとおり:

- 一括データエクスポート機能の概要

- 一括データエクスポートの開始手順

- 一括データエクスポートの管理

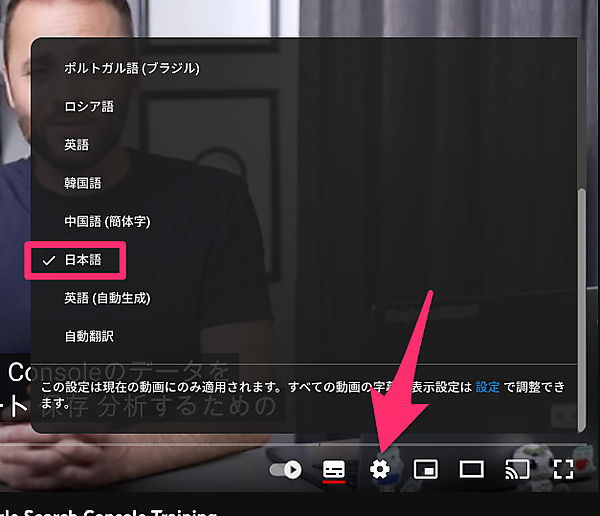

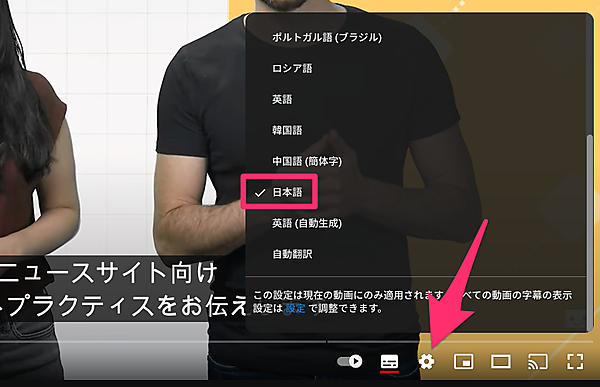

大量のデータを分析する必要がある大規模サイトのウェブ担当者は視聴するといい。なお、ウェイズバーグ氏は英語で話しているが、日本語字幕を利用できる。歯車アイコンから「字幕」⇒「日本語」を選択すると字幕を日本語に切り替えられる。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

- 解析担当者に伝えましょう

ロシアのサイトから大量のスパムリンクが! どうすればいい?

無視してかまわない (Google SEO office-hours) 海外情報

2023年5月の英語版オフィスアワーで次の質問があった:

私のサイトには、ロシアのウェブサイトから多くのリンクがあります。こうしたリンクをどのようにブロックすればいいですか?

これらのリンクは、検索でのランキングを下げることで私のサイトに害を与えようとしているのだと思います。

グーグルの社員(スパム対策チーム)からの回答は次のとおりだ:

私たちのアルゴリズムは通常、インターネット上のスパムやゴミリンクを認識して無視するのに非常に優れた仕事をする。そうしたリンクが大量にあっても、本当に心配する必要はない。ただ私たちのシステムに処理を任せ、自分のウェブサイトの改善に焦点を当てるだけでいい。

今のグーグルはスパムサイトからのリンクを自動的に無効化してくれる。ほとんどの場合は無視できる(はずだ)。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

SEO視点では、最適なリンク本数は何本?

ユーザー視点で考える (John Mueller on Twitter) 海外情報

グーグルのジョン・ミューラー氏が、ツイッターで次のような質問を受けた:

SEOに従うなら、1つのページには内部リンクと外部リンクを何本設置すべきですか? サイト管理者に役立つデータはありますか?

ミューラー氏は次のように答えた:

リンクがゼロなのはどうかと思うが(URL発見などの問題もあるため)、リンクの数が1本がいいのか10本がいいのか100本がいいのかは、私ならばユーザーにとってどうかで判断する。

More than zero. I'd focus on your users in that regard.

— John Mueller (official) — #StaplerLife · #Is (@JohnMu) May 19, 2023

質問したのはSEOを始めたばかりの人だろう。思考が完全に検索エンジンに向いてしまっている。

内部リンクにせよ外部リンクにせよ、重要なのは「それがユーザーにとって意味のあるものかどうか、役立つものかどうか」だ。本数は重要ではない。

ただし、どこからもリンクされていないページは「URLの発見」という点で不利だ。グーグルがページを発見し、最低限の関連性を理解できるように、最低1本のリンクを確保していくほうがいいだろう。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

ニュースサイト向けSEOのベストプラクティス

ニュースサイト運営者は要チェック (Google Search Central on YouTube) 海外情報

ニュースサイト向けのSEOのベストプラクティスを、グーグル検索チームのダニエル・ウェイズバーグ氏とチェリー・プロマウィン氏が動画で解説した。

キーポイントを簡潔にまとめると次のとおりだ:

グーグルの検索結果には、ニュースコンテンツがさまざまな形式で表示される(テキスト、画像、動画、リッチリザルトなど)

SEOのベストプラクティスとして、E-E-A-T(経験、専門知識、権威、信頼性)が重要である

正確な公開日と構造化データは、検索結果での認識性を向上させる

画像と動画は、関連性があり有益でなければならない

ニュースポリシーへの準拠は、グーグルニュースへの掲載に不可欠である

マネタイズを優先するあまりユーザーエクスペリエンスを損なってしまわないようにする

リンクしたページと関係性があれば開示するといった透明性を推奨する

ニュースサイトの運営者は視聴して詳細を学ぶといい。

こちらの動画も日本語字幕を利用できる。

- ニュースサイトのすべてのWeb担当者 必見!

JSレンダリング時にGooglebotが外部APIを呼び出すのを防ぐにはどうすればいい?

robots.txtでブロック、CSRは要注意 (Google SEO office-hours) 海外情報

2023年5月の英語版オフィスアワーのQ&Aをもう1つ紹介する。JavaScriptに関するものだ。

質問は次のとおり:

ウェブページのJavaScriptをレンダリングする際に、Googlebotが外部APIを呼び出すのをどうやれば防げますか?

こちらが回答だ:

robots.txtでAPIをブロックすることができるが、注意が必要だ。クライアントサイドレンダリングを使用しており、ページのコンテンツがこれらのAPIに依存している場合、Googlebotはコンテンツを表示するためにAPIにアクセスする必要がある。そうしないと、Googlebotがそれらのページを見たとき、そのコンテンツがページに表示されない。

robots.txtを使用してアクセスを制御できない外部ドメイン名のURLについては、JavaScriptでこれらのAPIを読み込む際に、ページをリクエストしているのがGooglebotならばAPI読み込みをスキップするようにできる。

なかなか難しい問題だ。外部のAPI呼び出しに回数の制限があったり費用が発生したりする場合、今のGooglebotはインデックス時にJavaScriptの実行も含めてレンダリングするため、影響がでてしまうのだ。

そのAPI呼び出しで取得するコンテンツが重要ではないのならば、プログラム側で制御したりrobots.txtで制御したりするのもいいだろう。ただしその場合も、インデックスすべきコンテンツのレンダリングに影響しないように配慮する必要がある。

しかし、APIで取得する内容がページの主要なコンテンツなのであれば、そうもいかない。この場合は、Googlebot のクロール頻度を下げる方法の公式解説を参考に、クロール頻度を下げるしかないのかもしれない。

- 技術がわかる人に伝えましょう

海外SEO情報ブログの

海外SEO情報ブログの

掲載記事からピックアップ

検索トラフィックに大きな影響を与えるかもしれない、来るべきアップデートに関する記事をピックアップ。

- Google、AIと検索を融合したSearch Generative Experience (SGE) を発表

AIチャットと検索の融合

- ホントにSEOを極めたい人だけ

- Googleヘルプフルコンテンツシステムが数か月後にアップデート、「隠れた宝石」コンテンツを上位表示する

埋もれたコンテンツが日の目を見るか?

- SEOがんばってる人用(ふつうの人は気にしなくていい)