ペナルティサイトをライバルサイトに転送するネガティブSEOは可能か?

海外のSEO/SEM情報を日本語でピックアップ

ペナルティサイトをライバルサイトに転送するネガティブSEOは可能か?

グーグルはうまく対処できるらしい (Google Webmaster Central office-hours hangout)

よろしくないSEO施策でペナルティを受けたサイトがあるとする。そのサイトから301リダイレクトを使って別のドメイン名のサイトに転送すると、元サイトが受けていたペナルティも、最終的には引き継ぐことになる。つまり、301リダイレクトでペナルティから逃げることはできない。

これを逆手にとって、ペナルティを受けたサイトを、ライバルサイトに301リダイレクトするように設定したらどうなるだろうか? 健全なはずのライバルサイトにペナルティの"濡れ衣"を着せることができるだろうか? いわゆるネガティブSEO(逆SEO)だ。

グーグルのジョン・ミューラー氏が、英語版のオフィスアワーでこの質問に答えた。

この問題に対しては、私たちは非常によく対処できている。

もしあなたが普通のウェブサイトを運営していて、だれか見知らぬひとがペナルティを受けたサイトをあなたのサイトにリダイレクトしたとしても、私たちのアルゴリズムを間違わせることは決してないだろう。

原理的には可能だが、グーグルはそうしたことが起きることを理解しており、対策をとっていて、それがうまくいっているということだ。

今後も「まったく問題ないはず、100%安全」というわけにはいかないだろうし、ひょっとしたら何らかの悪影響が一時的にはあるかもしれない。だが通常は心配しなくてもいいようだ。

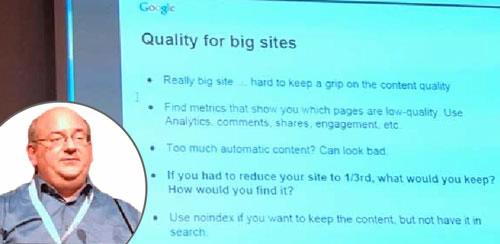

大規模サイトのコンテンツ品質を保つ方法

もし3分の1に規模を縮小するなら何を残すか? (SMX Milan 2014)

大規模サイトの品質を保つ方法のヒントを、グーグルのジョン・ミューラー氏が説明していたので紹介する。

11月13日~14日に伊ミラノで開催されたSMX Milan 2014カンファレンスに参加してきた(先週このコラムを休んだのはそのため)。

そのなかで、カンファレンス参加者から事前に募ったウェブサイトを診断するセッションがあり、そこで登壇していたミューラー氏が解説したものだ。

本当に大きなサイトでは、コンテンツの質を保つのは難しい。

どのページが質の低いコンテンツなのかを示す指標を見つけるといい ―― アクセス解析やコメント、ソーシャルの共有、エンゲージメントを利用する。

自動生成コンテンツが多すぎると質が低くみえる。

もしサイトの規模を3分の1に縮小しなければならないとしたら、何を残すか? どうやってそれを見つけるか? ―― こういったことを考えるといい。

残しておきたいが検索結果には出したくないコンテンツがあるなら、noindex metaタグを使う。

大規模サイトのウェブ担当者は参考にするといい。

HTTPSのサイトが2年前と比べて300%増加

HTTPSがウェブの世界の流れ (Ilya Grigorik on Google+)

HTTP Archiveの調査によると、アクセス数が多い上位300サイトのHTTPS採用率は、2年前の4%から13%に増加したそうだ。

ウェブのセキュア化と高速化を啓蒙している米グーグルのイリア・グリゴリック氏がGoogle+でこのニュースを共有した。「300%以上への増加」だと、グリゴリックは変化を強調している。

グーグルの望みどおり、HTTPSは着実に浸透しているようだ。

グーグルはHTTPSをランキング要因にしている。しかしHTTPS化によるランキング上昇は非常に微々たるものであるらしく、HTTPSによって明らかに検索トラフィックが増えたという話をいまだに聞いていない。

だが、HTTPSがウェブのトレンドになっていることは確かだ。SEO観点ではなく、ユーザーのプライバシー保護とデータの改ざん防止、サイトの正当性の証明のためにHTTPSの採用を前向きに検討していいのではないだろうか。

あなたのサイトのコンテンツが検索結果に出てこない理由

robots.txtでクロールをブロックしていませんか? (Google Webmasters on Google+)

米グーグルウェブマスターのGoogle+公式アカウントが、管理サイトのコンテンツが検索結果に表示されないトラブルについてのTIPSを投稿した。

自分のコンテンツが検索結果に表示されない問題をウェブマスターはしばしば経験します。

多くの場合、robots.txtの記述でコンテンツをクロールできなくなってしまっていることが原因です。

あなたのサイトではこうしたことが絶対に起きないように注意してください。

robots.txtに関する詳細はこちらから ⇒ http://goo.gl/35PSFR

たとえば、robots.txtで、

User-agent: *

Disallow: /imagesのように記述していたら、imagesフォルダに保存している画像は検索結果には出てこなくなる。

この場合は画像だが、もし間違ってDisallow: /としていたら、サイトのすべてがクロールされなくなってしまう。

検索結果に出なくなってしまったときには、まず自分のサイトのrobots.txtを確認してみるといいだろう。

robots.txtとあわせて、検索結果に表示されないよくある不注意な間違いは、noindex robots metaタグだ。最近も、これが原因で発生したトラブルの相談が日本のヘルプフォーラムにあった。

検索結果に出てこないときは、ペナルティを疑う前にこうした技術的な設定ミスがないかをまず調べよう。

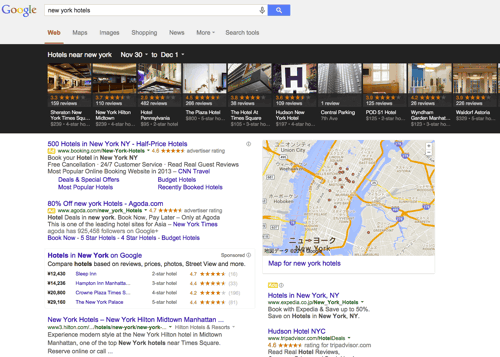

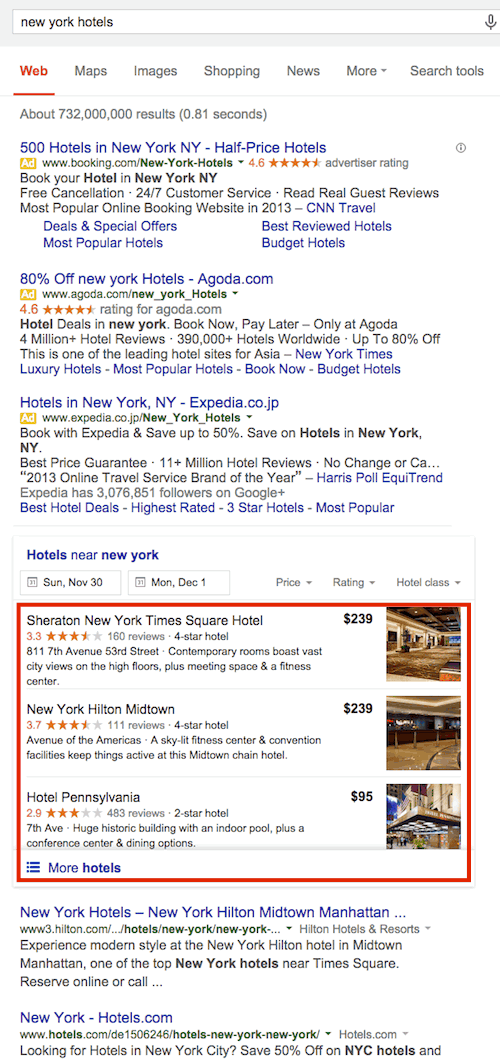

米グーグル、ローカルカルーセルを廃止

日本では見られなかった (Search Engine Land)

米グーグル(google.com)は、ホテルやレストランなどを表示するローカルカルーセルを廃止したようだ。新しい形式では、3つの結果(「3 Packs」と呼ばれる)が縦に並びサムネイル画像が付く。

ローカルカルーセルは結局日本には導入されずに終わってしまいそうだ。今のところ、写真付きの3 Packsも日本では確認できていない。

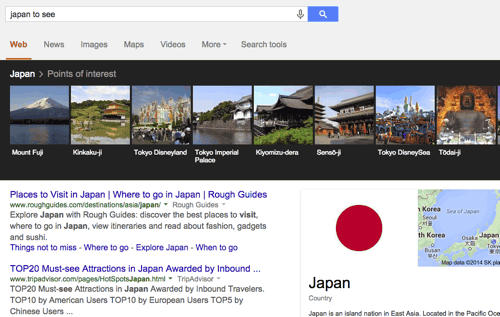

なおナレッジグラフのカルーセルは依然として出現する(ローカルカルーセルとナレッジグラフのカルーセルの違いは以前に説明した。ナレッジグラフのカルーセルは日本でも出てくる)。

SEO Japanの

SEO Japanの

掲載記事からピックアップ

SEO Japanを運営するアイオイクス社の社員さんが参加したClick Z Live Chicagoカンファレンスのセッションレポート記事を今週は2本ピックアップ。

- Click Z Live Chicago-パンダ、ペンギン、そしてペナルティ。Googleの最新のアルゴリズムを知ろう。

近年導入されたメジャーなアップデートとそのリカバリ方法 - Click Z Live Chicago-次世代のWebサイト・ユーザビリティとSEO。最高のユーザー体験を提供するための方法とは。

米国発のUX向上策を学ぶ