お待たせしたね。同一サイト内における複製コンテンツ(Duplicate Content、重複コンテンツともいう)の問題について、シンプルかつスマートな、図解付きの解説がいま求められている。これを上司に(技術チームに、という方が可能性あるかな)見せることができれば、本当に前向きな変化に不可欠な「なるほど!」が得られるんじゃないかと思う。

根本的な問題は、同じコンテンツをもつ複数のページがサイト内にできてしまうということだ。コンテンツの複製にはそれなりの理由が考えられる。プリント用のページ(洗練したCSSなら解決できる)だとか、書式やナビゲーションを変えたページだとか、サイト内のさまざまなエリアで利用できるということで、1つのページに複数のバージョンがあるだとか、常にいたるところで問題を引き起こす、コンテンツのページ分割だとか。今日は、最も一般的な例を、ブログの世界から取り上げることにしよう。

まず、よく使われる典型的なブログには、複製コンテンツの大きな問題が2つある。

投稿ごとに、複製コンテンツがブログのメインページに掲載される。

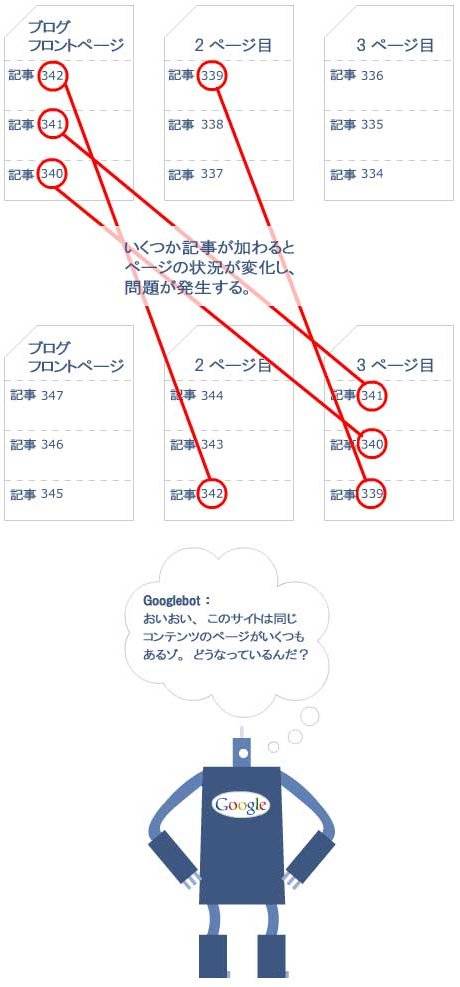

ブログのメインページでページ分割が行われると、検索エンジンのインデックス化によって複製コンテンツが生じる。

第1の問題を図解すると次のようになる。

メインページの各コンテンツとそっくり同じものが記事ページに掲載されていることがわかると思う。そしてこれは当然のように、面倒な複製コンテンツ問題を生み出す。検索エンジンは、どちらのコンテンツをランク付けすればいいのか? 全般的に見て、おそらくメインページの方がリンクジュースが豊富でPageRankも高いと思われるけど、個々の記事ページのほうが絞り込みでは勝っている。この問題を楽観的にとらえれば、少なくとも頻繁に更新するブロガーの場合、メインページのコンテンツは比較的早くページの下に移動していく(最終的には姿を消す)。でも、ページ分割が行われる場合はどうなるのか?

それが第2の問題だ。

その通りだ、怒ってるねGooglebotさん! このブログは、掲載されている大量の複製コンテンツによって、幾重にもトラブルを抱えている。ところで、Googleがページ分割された各ページを定期的に訪問してくれない場合は、さらに厄介なことになる。というのも、複製コンテンツが、実際に今ある数以上に増加してしまう可能性があるからだ。たとえば、Googlebotが3日間訪問するとして、1日1ページずつ、新たにページ分割されたページを収集していくと仮定する。この場合、同じブログ記事が検索エンジンのインデックス中で四重に複製されることになりかねない。ページ分割されていった各ページに1つずつ、そして、記事ページ自体に1つという具合に。

でも、良い知らせもある。個人的な見方だけど、GoogleもYahoo!もMSNもこうした複製パターンをブログで何度も経験していて、この問題についておそらく、割合にうまい回避方法を見つけ出していると思う。ただ、SEOmozがこの問題を抱えていた当時(2007年2月のサイトリニューアル前)と問題を解消してからとでは、古いブログ記事への検索からのトラフィックが約25%増加したことは、言っておくよ。

とは言うものの、サイト内における複製コンテンツの問題は、ブログシステムにだけあるのではない。同様の問題は、あらゆる形式や規模の「ブログ」に見つかるだろう。たとえば多くのニュースサイトで、プリント用のページを設けるのが一般的になっている。掲示板サイトは、クロール可能なリンクからアクセスできる投稿について、複数のコピーが作られる可能性がある。またかなりの数のEコマースサイトで、まったく同一の製品ページが複数のカテゴリで扱われており、それぞれに異なるURLが用いられている(時々これは最悪の悪夢となる)。

それで、これをどう修正すればいいのだろう? 話はカンタン(えっと、そうだな、まったく簡単というわけではない)。

上のイラストで、良い解決策を2つ挙げているけど、それぞれの使いどころを心得ておく必要がある。ちょうどサイトを開設するところで、最初から対策を行える場合は、メタタグで「noindex」をお薦めする。すでにできあがっているサイトについては、コンテンツのさまざまなバージョンに対して、たくさんの内部リンクや外部リンクが張られていると思うので、301リダイレクトを選ぶことになる。

SEO業者の中にはクローキングの利用を進言してくるところもある。この問題では、クローキングが非倫理的だとか、検索エンジンの精神に反しているだとか主張することは難しい。考え方としては、検索エンジンのみを対象に301リダイレクトを使う。このリダイレクトですべてのリンク人気をオリジナル版に転送し、オリジナル版を正規のソースとして確立する。他方、人間の訪問者に対しては、それまでと同様にたとえばプリント用フォーマット(そのほか、それぞれユニークな方法)でコンテンツを表示する。問題を回避してコンテンツを配信するもっといい方法があるはずだと僕は信じているのだが、こうした稀なケースの場合にはね……。

願わくばこの記事が、複製コンテンツへの不安を一部でも解消するとともに、サイト改良の重要性をチームの人に説得するの上で、少しでも貢献できればと思っている。複製コンテンツに関してもっと基本的な解説が必要な場合は、この問題に関して絵解きガイド(日本語版記事)があるからチェックしてみて。