「1ページの文字数」「キーワード出現比率」――イマドキのSEOでは非常識なこうした解説をグーグルがオンライン講座で示していたと話題になった。

すでに当該記述は削除されたようだが、「ちゃんとしたSEO」の理解がまだまだ正しく浸透していないことがわかるできごとだ。

ピックアップは「実用SEO情報」から少し外れたが、ほかの記事はあなたのSEO力アップに役立つ情報を揃えているので安心してほしい。

「CWVと順位」「コンテンツの品質」「タイトルリンク制御」などのほか、海外SEO情報ブログからピックアップの「headタグに記述してはいけないHTML要素」の情報もけっこう重要なので、ぜひチェックしてみてほしい。

- 上位表示ページはLCPが良好!? コア ウェブ バイタルはランキングに本当に影響するのか?

- コンテンツの品質を高めるのに「複数著者」は悪くない手段?

- グーグル検索のタイトルリンク制御には「見出し」が重要

- 貴社サイトのSearch Consoleデータ更新が止まる2つの状況

- 社内のSEO知識レベルを上げるためにSEO好きとしてやってみたこと

- 4月のオフィスアワー: 301リダイレクトの評価引き継ぎ、サーバー障害の検索順位への影響、サイトの他ページと一貫性のないデザインなど

- グーグル、画像サイトマップと動画サイトマップの拡張タグサポートを一部終了

- SpamBrain ―― グーグルが活用しているAIベースのスパム対策システム

- 完全非公開のディスカッションをグーグル検索が主催、何が話されたのか?

- headタグの中に記述していいHTML要素と記述してはいけないHTML要素

- 3xx、4xx、5xxのHTTPステータスコードを返すページをGoogleは無視しインデックスしない

今週のピックアップ

グーグルが公式に「SEO的には、文字数300語以上・KW出現率2%以下」と示してプチ炎上

完全に誤り (Gianluca Fiorelli on Twitter) 海外情報

グーグルは、オンライン講座としてデジタルマーケティングとECサイト運営の知識とスキルを養うためのコースを提供している。修了するとグーグル認定の資格も取得できる。

SEOの専門家を目指す人も受講対象で、カリキュラムにはSEOに関する内容もある。ところが、その内容に目を疑うような解説が含まれていたそうだ。次のような記述だ:

「キーワードの詰め込み」を避けるには:

- ページには300ワード以上書く

- 上位表示を狙うキーワードの出現率を2%以内に収める

So... On Connect GT (the biggest and oldest Italian SEO forum founded by @giorgiotave), Emanuele Ricci subscribed to the Digital Marketing & E-commerce Certificate by Google on Coursera.

— Gianluca Fiorelli (@gfiorelli1) May 9, 2022

Seriously... "write more than 300 words"? and "keyword density"?

cc: @dannysullivan pic.twitter.com/7qdWKlJ1vs

「1ページの文字数」も「キーワード出現率」も、どちらもグーグル検索のランキング要因ではまったくない。にもかかわらず、グーグル公認の講座にこのような記述が堂々と載っていたのだ。

この件に関してグーグルのダニー・サリバン氏は次のように発言している:

このコンテンツを作ったチームには、私も検索チームも関与していない。

検索チームの人間としては、書かれているような制限や「(キーワード)密度」のようなものを推奨することはない。

この記述は信じるべきではない。ちゃんと伝えておく。

検索チームとしての推奨は、「検索エンジン最適化(SEO)スターター ガイド」を参考にすることだ。

I'm not on the team that produced that, nor are they part of the Search team. As someone from the Search team, we don't recommend any limiits or "density" or anything like that. This can be ignored; I'll pass it on. Our advice from Search is here. https://t.co/zjvjWismrV

— Danny Sullivan (@dannysullivan) May 9, 2022

その後間もなく、オンライン講座から当該記述が削除されたようだ。

So, @21Interferenze sent me an update about the SEO part of the Digital Marketing course by Google on Coursera, and they quit the keyword stuffing part. Screenshot below ⬇️

— Gianluca Fiorelli (@gfiorelli1) May 11, 2022

cc: @rustybrick @dannysullivan pic.twitter.com/moX3VRKI5L

SEOに関する誤った情報をグーグル自身が教えたのは少々残念だ。

もちろん、グーグルの組織規模や部署の多様さを考えると、「本来あるべきSEO」を完全に浸透させるのが非常に難しいのはわからないでもない。また、問題が発覚した時点ですみやかに対応したのは、純粋にすばらしいと思う。

このコーナーの記事を読んでくださっている方々は、「ちゃんとしたSEO」の情報を正しく伝えていくことを心がけてほしい。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

グーグル検索SEO情報①

上位表示ページはLCPが良好!? コア ウェブ バイタルはランキングに本当に影響するのか?

FIDとCLSには相関なし (Advanced Web Ranking Blog) 海外情報

- ウェブページの表示パフォーマンスはGoogle検索のランキングにどれぐらい重要なのか?

- 検索順位1ページ目掲載と相関するコア ウェブ バイタルの指標は?

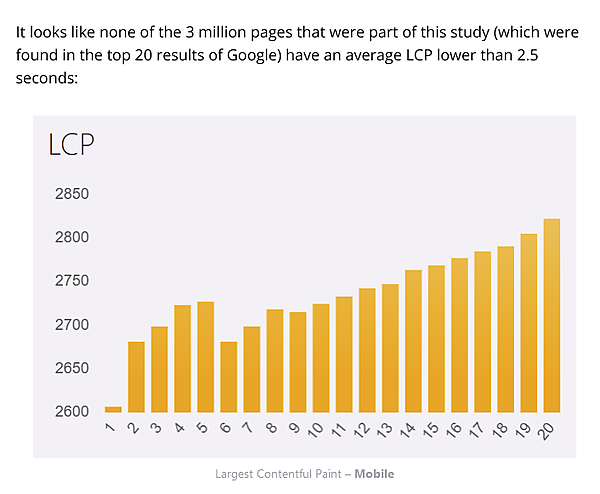

こうした疑問に答える調査データがでてきた。Advanced Web Ranking(アドバンスト ウェブ ランキング)が、検索結果上位20位の200万ページを対象に、ランキングとコア ウェブ バイタルの相関関係を調査したものだ。

特筆すべき発見を次のようにまとめている:

検索順位が上がるほど、LCPが良好

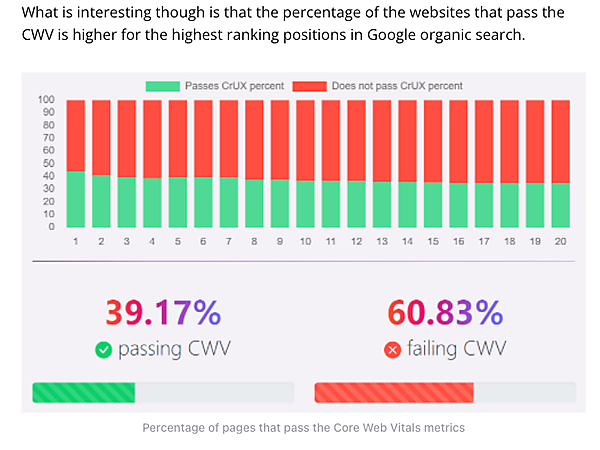

調査対象ページの39%がコア ウェブ バイタルが合格で、61%は不合格だった※

PCでコア ウェブ バイタルに合格しているページの80%は、スマホでも合格していた

コア ウェブ バイタルはランキング要因だが、リンクやコンテンツ、検索意図との関連性ほどには重要ではない

コア ウェブ バイタルの3指標のうち、多少なりともランキングと相関関係が認められたのはLCP(最大コンテンツの描画)だけだった。調査対象のなかで検索20位以内だったページはどれもLCP「良好」のしきい値2.5秒より数値が悪かったものの、検索ランキングとLCPにはある程度の相関関係がみられた。

一方で、他のコア ウェブ バイタル指標であるFID(初回入力遅延)とCLS(累積レイアウト変更)では、順位との相関関係はみられなかったそうだ。

コア ウェブ バイタル全体では、若干の相関関係が認められたようだ(順位が上の方がコア ウェブ バイタルに合格しているページが多い)。とはいえ、有意な相関関係があるとは言い難いように思う。

相関関係と因果関係は別ものなので、コア ウェブ バイタルが目に見える程度にランキングに本当に影響しているかどうかは、この調査だけでは断定できない。それでも、CWVが順位に影響していたとしても、度合いは軽微なようだ。グーグルの発表どおりだ。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

コンテンツの品質を高めるのに「複数著者」は悪くない手段?

NYTに倣え (Glenn Gabe on Twitter) 海外情報

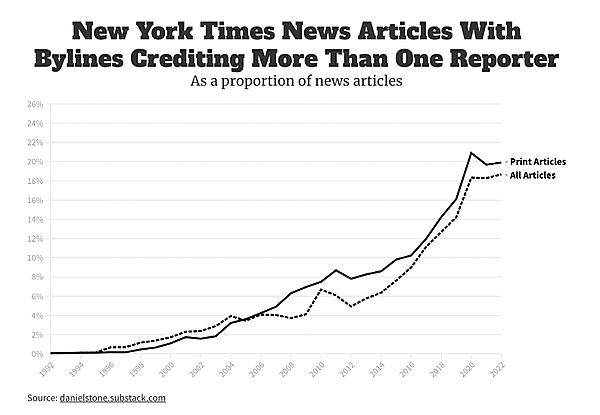

米国大手のニュースメディアであるニューヨーク・タイムズでは、複数の記者が執筆する記事が近年増えているそうだ。

記者が複数の記事の比率は、20年前は2%に届くか届かないかだったのに対して2022年は18%に伸びている。10倍近い増加だ。

トップページ(一面)に露出している記事に限って言えば、複数の記者による記事の率はさらに高く、50%に達しているそうだ。

米国で著名なSEOコンサルタントのグレン・ゲイブ氏は、この状況に次のようにコメントしている:

SEO視点で考えると、高品質なコンテンツを作成しさらに話題を広く網羅することに複数の著者が役立つなら、それは賢い一手だ。

SEO-wise, if multiple authors help you create higher-quality content & cover a story more thoroughly, then it's a smart move -> Analysis: ~20% of New York Times articles in 2022 have bylines with multiple reporters, up from <2% in 2000 https://t.co/54xYKOBAjO pic.twitter.com/3mEiV22v8v

— Glenn Gabe (@glenngabe) May 13, 2022

複数人体制でコンテンツを作る利点はたしかにありそうだ。1人だけよりも、情報の厚みが増すだろうし、異なる視点からの見解もコンテンツに含められそうだ。より適切な表現も使えるだろう。

複数人でのコンテンツ作成では、人手不足が障害になるかもしれないが、高品質なコンテンツを作成するために試してみたい。

ただし勘違いしてはいけない。「複数の著者」だから高品質になるわけではない。複数の著者の視点や経験をコンテンツに反映させることで「幅広い論点やトピックをコンテンツで網羅」できれば品質が高まる可能性があるということだ。

単に「記事に複数の著者を割り当てれば評価が上がる」なんてことは、絶対にない。中身の薄いコンテンツならば10人の著者がいても低品質なままだ。

- すべてのWeb担当者 必見!

グーグル検索のタイトルリンク制御には「見出し」が重要

メインの見出しだと識別できるようにする (グーグル 検索セントラル) 国内情報

グーグル検索では、検索結果に表示されるページタイトルを「タイトルリンク」と呼ぶ。タイトルリンク生成のアルゴリズムをグーグルは2021年8月に大幅にアップデートした(9月に改良版アップデートも実施している)。

このアップデートにより、<title> タグではないタイトルリンクが表示される検索結果が以前よりも(劇的に?)増えた。

<title> タグの記述が不適切だとグーグルが判断する場合にタイトルリンクが特に修正されやすいのだが、もう1つ、グーグルによるタイトルリンク書き換えが起こりやすい状況がある。それは、次のものだ:

- 見出しの使い方が不適切な場合、タイトルリンクの修正が起こりうる

この処理に関する情報を、タイトルリンクの技術ドキュメントのトラブルシューティング セクションにグーグルは追加した。

次の説明が増えている(読みやすく改行を追加):

明確なメインの見出しが見つからない

大きく目立つ見出しが複数あり、ページのどのテキストがメインの見出しであるかが明確でない場合に、この問題が発生します。

たとえば、1つのページに、同じスタイル設定または見出し要素を使用した 2つ以上の見出しがあります。Google検索では、大きく目立つ見出しが複数あることが検出されると、最初の見出しがタイトルリンクのテキストとして使用される場合があります。

メインの見出しは、ページ上の他のテキストと区別でき、ページで最も高い視認性を持つ見出しとして目を引くようにすることを検討してください(例: フォントを大きくする、見出しをページで最初に目立つ <h1> 要素に配置する)。

新しいアルゴリズムの特徴として、次のものがある:

- <title> タグの記述ではなく、ページ上の見出しをタイトルリンクとして検索結果に表示するようになった。

<title>はページ上には現れないので、ユーザーが実際に見るページの見出しと検索結果のタイトルを一致させるためだ。

そのページでメインとなる大見出しがどれなのかを明確に識別できるように構成しておくと、タイトルリンクの制御に役立つ。大見出しであることをマークアップレベルで確実に伝えるために、<h1>タグを使うことが推奨される。また、視覚的にも見出しであることが判別できるように<h1>のスタイルを調整することも大切だ。

ちなみに、見出しが複数ある場合は、最初の見出しがタイトルリンクに使われる場合が多いことも知っておこう。

- すべてのWeb担当者 必見!

貴社サイトのSearch Consoleデータ更新が止まる2つの状況

長い間利用がないとき (John Mueller on Twitter) 海外情報

SEOに携わる者として、Search Consoleにはしばしばアクセスしていることだろう。しかし、登録済みサイトであってもSearch Consoleのデータ収集が停止する場合があるというのはご存じだろうか?

Search Consoleのデータ収集が停止する条件を、グーグルのジョン・ミューラー氏がツイッターでの質問への回答で解説している:

Search Consoleのデータをだれも利用していない場合が続くと、グーグルはデータ収集を停止する。

しかし、たとえば「2年」のような明確な時間基準があるわけではない。

Search Consoleでサイトを確認した確認手段(metaタグや HTMLファイルなど)が削除された状態がしばらく続くと、そのサイトのデータ収集を停止する(かなり確度が高い)

サイト確認済みの状態であっても、非常に長い間利用されていないとデータ収集を停止する(場合もある)

リソースを無駄づかいしないために、Search Consoleで利用されていないサイトのデータは収集しないようにしているようだ。利用していない期間が長く続くと、再度プロパティ登録しても過去のデータを入手できないことがある。

ただ、この件に関してミューラー氏は詳細まで具体的に解説しているわけではないため、次の点であいまいさは残っている:

ミューラー氏が提示した2つ目の状況(長期間利用されていない)は、「metaタグやHTMLファイルなどのサイト確認の方法が残っているが、どのグーグルアカウントのSearch Consoleにもそのサイトがプロパティ登録されていない状態」を指すのか「Search Consoleにアクセスがない状態」を指すのか不明瞭。

「Search Consoleにアクセスがない状態」の意味の場合、公式なSearch Console APIによるデータ取得が「アクセス」扱いされるかどうかが不明瞭。

If it's not verified, then we definitely stop collecting data at some point. If it is verified and not used at all for a really long time, to me, that seems safe to pause too. IMO it's better to put the processing "budget" into things that are known to be useful.

— 🐝 johnmu.xml (personal) 🐝 (@JohnMu) May 11, 2022

- ホントにSEOを極めたい人だけ