人間が書いたコンテンツをグーグルがスパム判定するのは間違い?

グーグル検索SEO情報②

人間が書いたコンテンツをグーグルがスパム判定するのは間違い?

人間が書いたからといって役に立つコンテンツとは限らない (John Mueller on Twitter) 海外情報

次のような見解をツイッターに投稿した人がいた:

グーグルのスパム対策アップデートは、人間が書いた多くのコンテンツの順位を下げた。このアップデートはユーザーにとって有益であるに違いないが、アルゴリズムにはさらなる改善が必要だ。

元ツイートが「どう見ても良質なコンテンツなのにスパム扱いされていることがある、もっと改善すべきだ」という意見ならば、もちろん改善すべきだろう。

しかし、「ツールで自動生成したコンテンツをスパムとして排除するのは然るべきだが、人間が書いたコンテンツは評価を下げるべきではない」ということを意味している可能性もある。

この投稿を目にしたグーグルのジョン・ミューラー氏は、ツイートの意図を後者だと受け取ったようで、次のようにコメントした:

人間の手によって書かれたものだからといって、それが役に立つ良いコンテンツとは限らない。

私なら、

- 人々が友人に勧めるような

- 独自で

- すばらしい

- 魅力的な

そんなコンテンツを作ることに注力するだろう ―― 技術的に問題ないという状態を目指すだけでなく。

Just because something is human-written doesn't make it helpful & good content. I'd really focus on making things awesome, unique, compelling, that people recommend to friends - not just something that's technically ok.

— johnmu: nothing is permanent, use 302 always 💫 (@JohnMu) October 23, 2022

「人間が書いたコンテンツ=高品質コンテンツ」とは言えないのは、わざわざ言うまでもないことだ。人間が書いたとしてもユーザーの役に立たない低品質なコンテンツは山のようにある。スパムと判定されることさえある。

コンテンツの質に対するグーグルの誤判定ならば声をあげるべきだ。しかしそうでないならば、「読者からみたページの価値」を高めていくことが最も意味のあることだろう。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

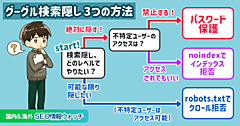

【SEOクイズ】noimageindexタグとmax-image-preview:noneタグの違いは?

まったく別の機能を持つmetaタグ (John Mueller on Twitter) 海外情報

少し上級のSEOクイズだ。

サイトに掲載している画像の検索での扱いに関してグーグルに指示をする次の2種類の

metaタグの違いを、あなたは説明できるだろうか?

<meta name="robots" content="noimageindex"><meta name="robots" content="max-image-preview:none">

これは実際にはクイズではなく、グーグルのジョン・ミューラー氏がツイッターで聞かれた質問だ。

違いも何も、両者の働きはまったく異なる:

noimageindex―― そのページにある画像をインデックスさせない。max-image-preview:none――max-image-previewを使うと検索結果にプレビューとして表示する画像の大きさを指定できる。値にnoneを設定すると画像プレビューなしになる。

質問者は画像をインデックスさせたくなかったようだ。にもかかわらずmax-image-preview:noneを設定していた。効果が出ないのは変だとしてミューラー氏に相談したのだ。実際には、noimageindexを設定しなければならなかった。

グーグルがサポートするすべてのrobots metaタグは検索セントラルサイトの技術ドキュメントで確認できる。

- ホントにSEOを極めたい人だけ

ECサイトの在庫切れページで204を返すのは正しいやり方か?

素直に404を使う (John Mueller on Twitter) 海外情報

ECサイトの管理者がグーグルのジョン・ミューラー氏に質問した:

ECサイトで「在庫切れだが再入荷の予定がある」場合は、HTTPステータスコードとして404と204のどちらを返したほうがいいですか?

ミューラー氏は次のように答えた:

204は、一般的ではなく不適切に思える。

なぜ404ではなく204を使おうとするのかな?

質問者は理由を次のように説明する:

3〜6か月に何回か在庫切れして後日再入荷する商品があります。在庫切れ時点で404を返して再入荷したときに200に戻すよりも、在庫切れ時点では204を返したほうが再インデックスされやすいのではないかと考えました。

状況を把握したミューラー氏は、次のように回答している:

そういう状況なら、(404でも204でもなく)200を返して構わないと思う。私が理解している限りでは、204は基本的に、空っぽのページをユーザーに向けて作成するものだろう。あなたがやりたいことではないはずだ。

検索結果から削除したいなら404を返す。在庫切れでもユーザーの役に立つなら200でいい(ただし、ソフト404として検索結果から消えるかもしれないが)。

204 seems like a bad & unorthodox choice -- why would you use that instead of a 404?

— johnmu: nothing is permanent, use 302 always 💫 (@JohnMu) October 24, 2022

HTTPステータスコードの204は、コンテンツなし(No Content)を意味する。質問者の場合は「在庫がない」のであって、「ページのコンテンツがない」わけではない。204はふさわしくないだろう。

もっとも、グーグル検索では、204を返しても最終的には200とおそらく同じ扱いになると思われる。なぜなら、200番台はどれも同じ処理になるからだ。HTTPステータスコードの処理を説明した技術ドキュメントでは、次のように解説している:

HTTP ステータス コードにはそれぞれ異なる意味がありますが、多くの場合、リクエストの結果は同じです。たとえば、リダイレクトを示すステータス コードは複数ありますが、その結果はいずれも同じです。

(中略)

サーバーがレスポンスで

2xxステータス コードを返した場合、レスポンスで受信したコンテンツのインデックス登録が検討される可能性があります。

204に関しては、次のようにも記載している:

Search Console は、サイトのインデックス カバレッジ レポートに

soft 404エラーを表示する場合があります。

結論としては、在庫切れで204を返す必要はまったくない(さらに言えば、本来の204の用途としても適切ではない)。

グーグル検索に限って言えば、それ以外の状況でも204を使う場面はないだろう。

- ホントにSEOを極めたい人だけ

- 技術がわかる人に伝えましょう

Search Consoleの検索パフォーマンスの制限をグーグルが解説

プライバシーフィルタリングと1日あたりデータ行上限 (グーグル 検索セントラル ブログ) 国内情報

Search Consoleの検索パフォーマンスデータのフィルタリングと制限の詳細について、グーグルのダニエル・ウェイスバーグ氏がブログで解説した(ウェイスバーグ氏は検索リレーションチームでSearch Consoleの開発を担当している人物)。

検索パフォーマンスのレポートは、100%完全なデータを提供するわけではない。たとえば、次のような制限がある:

プライバシー フィルタリング ―― 2~3か月間で数十人しか検索していないクエリは、プライバシー保護のため表示しない(合計の数値には含まれている)

(1 日あたりの)データ行の上限 ―― データは最大1000行までしか表示・エクスポートできない(概要データは制限なし)。ただし、APIを使えばサイトごとに1日あたり5万行まで取得可能

こちらの記事ではこの 2 つの制限について説明している。検索パフォーマンスレポートで定期的にデータ管理しているならば読んでおきたい。さもないと、データの乖離に頭を悩ませることがあるかもしれない。

念のために確認しておくと、検索パフォーマンスは、検索結果における次のデータを計測するのに非常に有用なレポートだ:

クリック数: ユーザー が Google 検索結果をクリックしてプロパティに移動した回数。

表示回数: ユーザーが Google の検索結果でプロパティを表示した回数。

CTR(クリック率): クリック数を表示回数で割った値。

掲載順位: URL、クエリ、またはウェブサイトの一般的な検索結果の平均掲載順位。

もし、レポート上の各数値の意味を具体的に把握していなかったならば、上記のようなものだと理解しておいてほしい。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

現在の Google検索における機械学習の重要性とは?

ランキングだけじゃなくすべてのプロセスにAIが関与 (JADE) 国内情報

Google検索における機械学習について、JADE創業者の長山一石氏が解説記事を書いた(長山氏は、グーグルの検索チームで以前に働いていた)。

グーグル自体は長らくAIテクノロジーを牽引する存在であるが、驚くべきことに検索においては、2015年までAIを本格的に利用することはなかったそうだ。当時の検索部門のトップがAIについて懐疑的だったためらしい。しかしその後、グーグルなかでも機械学習を最も推進する人物にトップが交代すると一転してAIを大々的に活用し始めた。

グーグル検索のAI利用と聞くと、次のような技術を思い浮かべる人も多いだろう:

- RankBrain

- BERT

- MUM

どれも主にランキングプロセスに関わるAIだ。

だが長山氏によれば、AIによる機械学習は現在、検索のすべてのプロセスに関わっているとのことである。機械学習の全面的な採用により起きた変化として長山氏は次のような例を挙げている。

Google は、URL発見やクロールの初期段階でより正確な予測を行うことができるようになりました。

ここ数年、Webページがインデックスに登録されていないという話を耳にするようになりました。これは、どのページをクロールしてインデックスに登録するかを予測して決定する仕組みが導入された結果だと思います。

これまでのシステムでは、特定の URL の品質をインデックスに登録する前に確実に予測することが難しく、実際にインデックスしてみないと検索結果に表示する価値があるページか否かわからないものも多くありました。

しかし今では、機械学習のスコアリングに基づいて、ページがランキングに値するかしないかを予測できるようになったと感じます。

「何がランキングのシグナルなのか」という議論は、基本的に無意味になりました。

機械学習以前からこう言った議論は生産的ではありませんでしたが、現在はさらにそうです。どんなシグナルでも、それがどれくらいの重みを割り当てられるか、ということはハードコードされておらず、常に検索クエリやドキュメント全体に影響を与えるシグナルはありません。検索結果ハックすることはさらに難しくなっています。

何をキーとして学習が行われるのか、を考えながら構造を作っていくことが重要になりました。

(中略)

自然検索の側では、多くの場合、これらのキーは URL をベースにしたものになります。だから、URL を再構築したり、ドメインを変更したりすることの影響は、以前よりもさらに大きくなっているということができます。

機械学習をベースにした検索への移行はSEOへのスタンスにも影響を与えそうだ。動物に例えて長山氏は説明している。

いかにして(AIの)モデルを飼い慣らすか、が非常に重要になってきています。適切な量の食べ物を適切なタイミングで食べさせ、適切な量の鞭とニンジンを与えて飼い慣らし、愛を与えていれば、モデルは必ずいい結果を返してくれます。皆さんが、うまくモデルを飼い慣らすことができるように祈っています。

- SEOがんばってる人用(ふつうの人は気にしなくていい)

海外SEO情報ブログの

海外SEO情報ブログの

掲載記事からピックアップ

グーグル検索の新機能を2つ紹介する。

- Googleマルチサーチが日本語環境にやってきた

画像検索+テキスト検索

- SEOがんばってる人用(ふつうの人は気にしなくていい)

- Google画像検索で写真のクレジット情報を構造化データで指定できるように

盗用に抑止効果あり?

- オリジナル画像を大事にしているすべてのWeb担当者 必見!