グーグルがtitleタグを書き換える理由

海外のSEO/SEM情報を日本語でピックアップ

グーグルがtitleタグを書き換える理由

お願いだから勝手に変えないで (Search Engine Land)

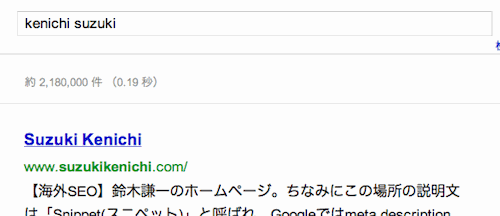

グーグルは、検索結果ページに表示するページのタイトルを、元ページのtitleタグの記述を使わずに彼らが適切だと判断したタイトルに書き換えることがある。少なくとも1~2年前からある仕様で、ここ数か月、書き換えられるケースが特に増えてきている印象がある。

検索者にとってわかりやすく、注意を引くように書き換えてくれるのならありがたいのだが、サイト管理者が入念に考えて付けたtitleタグを完全に無視してまったく望まないタイトルに変えてしまうことも多いのが困りものだ。

どんな場合に書き換えが起こりやすいのだろうか? SEMのカンファレンスでグーグルの社員が語ったというtitleタグを書き換える原因となる要因が下の3つだ。

titleタグが検索キーワードに対して曖昧なとき(重要なキーワードがtitleタグから抜けていることと推測される)。

会社名やサイト名がないときは、終わりに付け足すことがある。

titleタグにキーワードを入れすぎているときは、いくつかを削除することがある。

ここには含まれていないが、アンカーテキストにも影響を受けるようだ。またtitleタグが同一のページが多い場合、titleタグの記述がない場合も書き換えられやすい。

しかし、こうしてヒントとなる情報が出てきているものの、グーグルによるtitleタグ書き換えを確実に防ぐ方法を筆者は知らない。もし有効な防御手段をご存知ならぜひ教えてほしい。

検索順位が下がったときに原因を調べる手順

原因発見のためのプロセス (Google Webmaster Central Channel on YouTube)

検索順位が大きく下がってトラフィックが落ち込んでしまったときに、その原因が何かをどうすれば調べられるのだろうか? その診断プロセスを、グーグルのマット・カッツ氏がビデオで解説した。

まずsite:コマンドで自分のドメイン名を指定してグーグル検索して(例:site:example.jp)、検索結果から完全に消えているか一部だけは検索結果に出るのか調べる。この方法を使えば一部がインデックスされているか見分けることができる。

スニペットが表示されないとしたら、robots.txtでクローラをブロックしているかもしれない。リンクが張られていてそのページの存在は分かっているけれどそのページの中身を見ることができないためスニペットが表示されなくなっているのだ。

検索結果に警告メッセージが出ていれば、ハッキングされていたりマルウェアに感染したりしていることが分かるだろう。ハッキングされたサイトやマルウェアに感染したサイトには訪問したいと思わないだろうからトラフィックが減るのは当然だ。

次にやるべきことは、Googleウェブマスターツールに警告メッセージが届いていないか確認することだ。今は昔と違ってかなり数多くの種類のメッセージを送るようになっている。たとえば隠しテキスト、パークドメイン、ドアウェイページなど、さまざまなガイドライン違反を知らせるメッセージがあるので、確認するといい。

特に問題もなくメッセージもないようならウェブマスター向け公式ヘルプフォーラムに投稿するといい。優れたユーザーたちが調べるのを手助けしてくれるだろう。

また、順位が下がっているのはあなたサイトだけなのか、それとも他の多くのサイトも同様に順位が下がっているかも調べてほしい。自分のサイトだけの場合は、ガイドライン違反を犯しているかもしれないし、あなたのサイトのサーバーの問題ということも十分ありえる。みんなに特定の変動が起こっているようならアルゴリズム変更の可能性が高い。

他の検索エンジンでも調べてみてそちらでも検索結果に出ないようなら、(グーグルではなく)あなたの側に問題がありそうだ。たとえば、サイト公開前に外部のユーザーに見られないようにrobots.txt、noindex meta タグなどを設置していて、公開した後もそのままだったということがありえる。

ウェブマスターツールのFetch as Googlebotも利用してほしい。Fetch as Googlebotを使うと、実際にその場でグーグルのクローラとしてページを見に行ってくれるので、その結果におかしなところがないか見てみるといい。ハッキングされていたり、noindexタグが入っていたり、ハッカーのサイトに向けたrel="canonical"を埋め込まれたりしていて驚くことがある。すごい例としては、ユーザーには普通のページを見せるが検索エンジンには違う内容を見せるクローキングをしていたのだが、処理が失敗していてGooglebotに完全に空っぽのページを見せてしまっていて、それをFetch as Googlebotで発見したケースもあった。

サイトに変更を加えたり、サーバーを変えたり、デザインを大きく変えるたりすることでもランキングが大きく下がることがある。DNSを変更する、ホスト名を変更する、こういったことが原因になることもある。高度なAjaxを展開した結果、検索エンジンがクロールできないなんてこともありえるだろう。

こういったことをすべてチェックすれば何が起こっているか判断できて再審査リクエストを送るべきかどうかも分かるだろう。ガイドラインに違反していたのならば、再審査リクエストを送信することで、手動によるペナルティなのかアルゴリズムによる自動ペナルティなのかも分かる。もし手動ペナルティならば、問題の箇所を確かに修正したことをしっかりと再審査リクエストで伝えるべきだ。ガイドライン違反が修正されればすぐに状態は良くなるだろう。もしそうでなければまだ問題が残っているということだ。

また、ここ最近は、ウェブマスターツールのメッセージでだけでなく、再審査リクエストに対する返信でも、より詳しい情報を伝えるようにしていることを知っておいてほしい。

アフィリエイトリンクだけのサイトはインデックスから消える

対岸の火事ではない (Hacker News)

グーグルにインデックス削除されたサイト管理者が、あるフォーラムに投稿したところ、グーグルのウェブスパムグループのトップであるマット・カッツ氏がコメントを付けた。

アマゾンのアフィリエイトリンク以外には実質的に何もない自動生成したサイトをキミは運用している。(3つのURLを例に挙げて)これらのページは、関係のないキーワードを詰め込んで文字どおり何百といったリンクを自動的に生成したページだ。

アフィリエイトサイトでアフィリエイト用の文面を取り除くと独自のコンテンツがまったくないとしたら、それはガイドラインに違反しておりペナルティの対象になりやすい。

こうしたアフィリエイトサイトに限らず、どんどんインデックスから消えていっているサイトはさまざまある。その多くが、プログラムを使って大量に自動生成されたページ、データベースやAPIから既成の情報を引っ張ってきだだけで他のサイトにも存在するコピーコンテンツばかりのページといった、独自のオリジナルコンテンツを所有しないサイトだ。

そしてこれは、日本も決して例外ではない。楽してページ数を増やそうという企みはもはや通用しなくなっている。そして今後はオリジナリティに加えて、クオリティも問われる時代に入っていることを認識しておかなければならない。

なおここでピックアップしたスレッドでは、マット・カッツ氏は他にもたくさんの有益な情報を、まるで個別サポートしているかのように書き連ねている。英語でのディスカッションだが頑張ってマット・カッツ氏のすべての発言を読んでみてほしい。

プレイス検索のアルゴリズムが変わった

近いほうが有利に!? (Google Places Optimization Blog)

グーグルのプレイス検索や地図検索においては何が上位表示の要因になっているかがなかなか解明しきれていない。こちらの記事では、最近発生した大きな順位変動を分析して中心部からの距離が今まで以上に重要な要因になったようだと推測している。

それまで上位に表示していた店舗がいくつも「7パック(ローカル結果が7つリスト表示されること)」から外れたりプレイス検索との統合がなくなったりしており、調べてみると中心部から遠い店舗という共通項が発見できたとのことだ。

「中心部から近いサイトを上位に、遠いサイトをランク外に」、もしこれが事実なら、店舗や会社の物理的な場所をそうやすやすと変えることはできないから、中心部から離れた場所で地域ビジネスを営んでいる店舗にとっては厳しい状況になるかもしれない。

Bingは meta keywords タグを見ていた、でもその理由は……

逆SEO要因 (Search Engine Land)

Bingは、グーグル同様に meta keywords タグを無視している。少なくとも、かつて公式にそうコメントした。だがその後Bingのシニアプロダクトマネージャのデュアン・フォレスター氏は「1,000個ほどある指標のうちの1つである」と発言していた。

この件に関して、Search Engine Landのダニー・サリバン氏がフォレスター氏に直接問い合わせたところ、真相が判明した。

確かにBingはmeta keywords タグを見ている。しかしそれは順位を上げるための指標としてではなく、スパムを発見するための指標としてだった。どういうことかというと、検索エンジンスパマーは、meta keywords タグにキーワードを詰め込む傾向が強い。時にはそのページとはまったく無関係なキーワードを記述する。したがって meta keywords タグをスパマーかどうかの判断材料に使えるのだ。

極端に言えば、「スパム扱いされたかったら meta keywords タグにページと無関係なキーワードを記述しろ」ということになる。さすがにこれは言い過ぎだとしても、ランキングを上げる目的でmeta keywords タグを利用するのはやめよう。記述しなくても問題にならないし、記述するとしても対象としているキーワードを2~3個入れれば十分だ。

少なくとも、キーワードをいくつ書くべきか、複合キーワードは1つ1つに分けたほうがいいのか、カンマのあとにスペースは必要なのかなど、meta keywords タグのために頭を悩ませるのは時間のムダだ。

SEO Japanの掲載記事からピックアップ

SEO Japanの掲載記事からピックアップ

一般企業で社内SEOを担当している人とSEO専門会社で働いている人に参考になる記事を今週はピックアップ。

- 新任SEO担当者に必須のチェックリスト20項目

これは良いリスト - SEOは終わらずともSEO業者は終わる

本当に「価値」を提供できなければね