A/Bテストの結果がよくありません。どうしたらよいでしょうか?

テストパターンが負けるのはよくあることです。結果をどう活かすのか、どうすれば勝率をあげられるのか、を考えてみましょう。

テストなのだからダメでもいい

A/Bテストの結果、「こうするとより結果が良くなるのでは」と思って作ったテストパターンのほうが、オリジナルよりも成績が悪くなってしまうことは、珍しいことではありません。

もちろん、自分の仮説が否定された形になるため、そういうときは正直ガッカリするものです(笑)。でも、そこはテストですから、「だめだということがわかってよかった」「早く検証することが大切」と気持ちを切り替えて次に進みましょう。

ダメだった事例も山ほどある

A/Bテストをしてみた結果、良いだろうと思ったものが悪かった例をいくつか紹介しましょう。

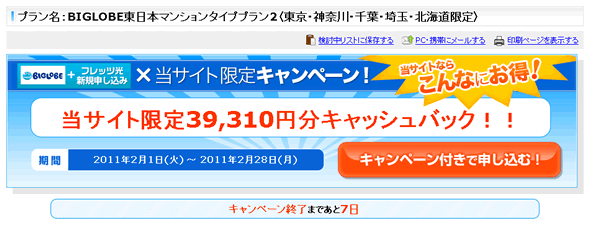

ここで紹介するのは、「キャンペーンの期限を強調しすぎると、コンバージョンレートが低下した」例です。

ECナビにはプロバイダ比較サイトがあり、そこではいくつものISP(インターネット接続プロバイダ)の情報を掲載しています。お客さまに合ったプロバイダを選んで、そのプロバイダのサイトに移動して契約してもらうことがゴールですから、サイトのコンバージョン点は、プロバイダの申込みページへのリンクをクリックしてもらうことになります。

ときには、プロバイダごとに期間限定のキャンペーンを実施していることがあることに着目した担当者は、次のような仮説を立てました。

キャンペーン終了までのカウントダウンをより目立たせ、日にちだけではなく時間でもカウントダウンすれば、追い立てられてたお客さまはより申し込む率が高くなるのではないか。

そこで、以下のようなパターンでテストを実施しました。

- オリジナル

図1 通常の表示

図1 通常の表示 - テストパターン

図2 キャンペーン情報の下にキャンペーン終了までのカウントダウン表示を追加

図2 キャンペーン情報の下にキャンペーン終了までのカウントダウン表示を追加

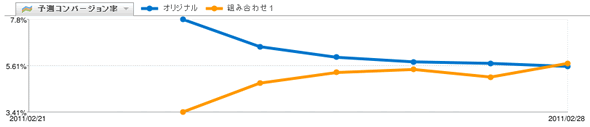

しばらくテストしてみたところ、次のような結果となりました。

他にも同様のテストをしてみました。

- オリジナル

図3

図3 - テストパターン

図4

図4

こちらでも、同様に次のような結果となりました。

そう、「クリック率が高くなるだろう」と想定したカウントダウンありのパターンのほうが、申し込みリンクをクリックされる率が低かったのです。このように、テストパターンのほうが成績が悪くなることは珍しくありません。

ただし、この件ではおもしろい発見もありました。キャンペーン終了前6日間のクリック率の変化を調べてみたところ、次のようになったのです。

キャンペーン終了の前日のみ、オリジナルとテストパターンのクリック率がほぼ拮抗していたのです。このことから、次のような新たな仮説が生まれました。

お客さまは急かされて不快になっているのではないか?

「あと10日もある」と、アクションを先延ばしにする理由をわざわざ与えているのではないか?

テスト結果が悪くても、コンバージョンレートをアップするための施策につながればよいのです。たとえばこの場合、「キャンペーン終了まで24時間未満になったら、カウントダウンを目立たせるとコンバージョン数が向上するのではないか」といったものです。

関係者を説得するチャンス

実は、上記の事例では、テスト実施前からこの結果が想定されていたのですが、あえてテストを行った例でした。

というのも、その前に、次のような議論が交わされていたのです。

プランニング(またはディレクション)担当者:

カウントダウンしたらきっとコンバージョン上がるよ! 入れてよ!

開発者:

いやーそれはないでしょ、逆に悪くなりますよ。

複数の関係者の意見が対立する、よくあることですね。この場合、開発者は自分の意見に自信があったのですが、それを証明するために、あえてA/Bテストを行ったのです。

こうしたもの以外にも、「私だったらこする! 私がユーザーならこう思う!」という意見と「調査結果からして、こちらの可能性が高い」という意見が対立することもあるでしょう。いずれにせよ、お互いに自分の意見を主張するのではなく、「ではユーザーの行動に聞いてみましょう

」とA/Bテストを実施することで、双方が納得できる形で物事を進められるようになるのです。

お客さまを理解するチャンス

また、テスト結果がオリジナルを下回るということは、少なくとも「ビジネス上好ましくない結果にお客さまを誘導してしまう」ということを意味します。または「お客さまはそれを望んでいない」といえることもあるでしょう。

お客さまに対して「試す」といえば失礼な話かもしれませんが、既存業界の商品企画でも、接客業でも、さまざまなトライをするものです。むしろ当然、いえ、試す努力をしなければ失礼だといってもいいでしょう。

A/Bテストは仮説の検証手段です。検証結果がいつも好ましい結果となるわけではありません。「仮説が否定されること」は、「仮説が証明されること」と同じくらい起こりうることです。

良いデザインができるようになるためにするべきことは、「自分が考えぬいた完成品をリリースする」ことではありません。「仮説をたてて試す」→「フィードバックを得る」→「その結果から仮説をたてて試す」→「フィードバックを得る」→「さらにその結果から仮説をたてて……」という改善施策の回数を多くしていくのが大切なのです。

成功確率をあげるには

A/Bテストを利用して一定期間でパフォーマンスを向上させるには、次の2通りの方法があります。

- A/Bテストの回数を増やす

- A/Bテストの勝率を上げる(仮説精度を向上する)

とはいえ、結果が出るまでの時間は一定ですから、貼り付いてテストを行っても意味がありません(テスト回数はさほど増やせない)。つまり、主に「率」をあげる努力をしていくこととなります。

仮説の精度を向上するのに必要なのは、有効な情報を集めることです。そのためには、次のような情報をアクセス解析から導き出すことがポイントとなります。

ユーザーはどのような人か?

直前に何を見ている(何を期待してページに来ている)のか?

どこが大きな障害になっているのか?

コンバージョンするケースはどのような場合か?しないケースはどのような場合か?

仮説は他社の事例などからヒントを得ることが可能ですが、それだけではROIが高いとはいえないでしょう。あくまでも、御社の商材(サイト)に対して御社のユーザーがどのような状態にあり、どのような行動をするかの情報を集め、そこから考えていくのが重要なのです。

まとめ

A/Bテストには、成功事例と同じくらい、失敗事例があります。複数の仮説が証明・否定されることで、今まで思いもしなかった発見があります。それはテストを重ねた人だけが知ることができるものです。

失敗が積み重なることがあるかもしれませんが、基本(仮説立て)に立ち返り、トライしてみて下さい。