東京大学のAI(人工知能)研究者、松尾豊教授の研究室発のAI開発スタートアップ、ELYZA(イライザ)は、日本語での論理的思考能力を強化した大規模言語モデル(LLM)「ELYZA-Thinking-1.0-Qwen-32B」を開発した、と5月1日発表した。研究や営利目的での利用が可能な形で一般公開した。複雑な論理的思考を行う能力を向上させたReasoning Model(推論モデル)となる。

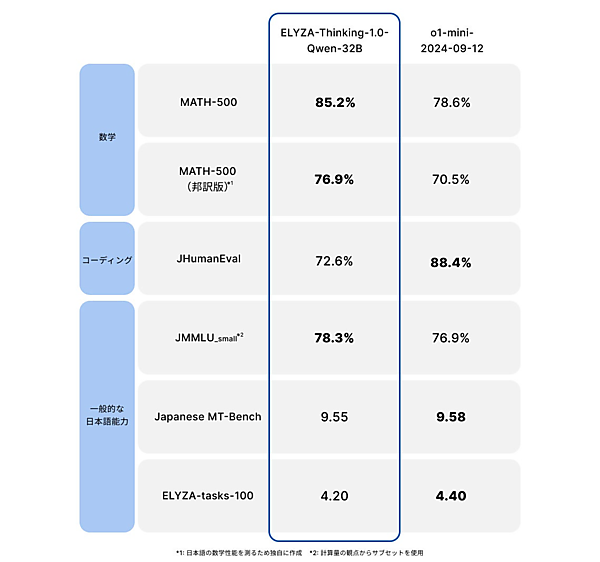

米国OpenAIの「o1/o3」シリーズ、中国DeepSeekの「DeepSeek-R1」と同様のReasoning Model。思考の連鎖(Chain of Thought)=CoT=と呼ぶ手法を使い、問題を段階的に処理して回答を生成する。ELYZA-Thinking-1.0-Qwen-32Bは、比較的軽量な320億パラメータのモデルだが、OpenAIの「o1-mini」に近い性能を達成。特に数学系のベンチマークのスコアでは上回った。

高度な論理的思考能力を備えるReasoning Modelに日本語を追加学習するのではなく、非Reasoning Modelに能力を付与したのが特徴。中国アリババが公開している非Reasoning Model「Qwen2.5-32B-Instruct」に対し、日本語の追加事前学習と長い思考過程を伴うデータでチューニング(Supervised Fine Tuning)=SFT=することで日本語の論理的思考能力を高めた。

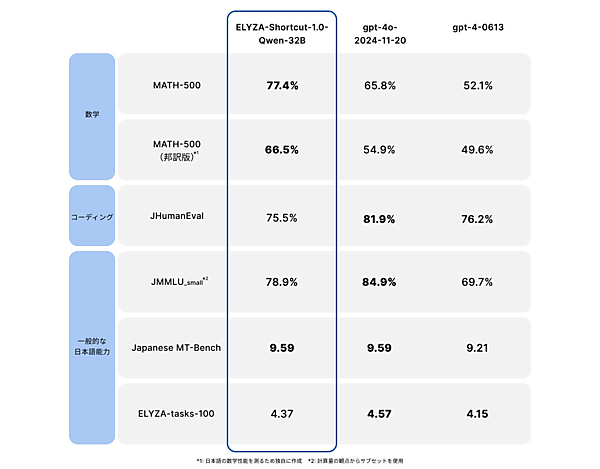

ELYZA-Thinking-1.0-Qwen-32Bと併せて「ELYZA-Shortcut-1.0-Qwen-32B/7B」も公開した。Reasoning Modelの学習用に探索された多くの問題、思考過程、回答のセットから思考過程を除いた問題と回答のペアを使用してSFTを行った。思考過程を省いて回答を返すように訓練したモデルで、Shortcut Modelと名付けた。320億と70億パラメータの2種類のモデルがある。

- この記事のキーワード