SEO Japan

コアウェブバイタル(Core Web Vitals)で重要視される3つの指標!SEO視点でサイトを最適化する方法

インハウスSEOとは何?メリット・デメリットや実践のステップ、注意点を徹底解説

サイト設計でSEO効果を最大化!企業担当者が知りたい基本の手順や注意点を解説

ブランドとリンクの比率(BLR)の革命:メンションが重要になった理由

複数のAIプラットフォーム時代を先行するCMO・SEO担当者になるには(Part2)

複数のAIプラットフォーム時代を先行するCMO・SEO担当者になるには(Part1)

【Webサイトリニューアル・移行の秘訣】プロが語る12個の注意点

【437名調査】BtoB製品選定プロセスは生成AI普及でどう変わった?AI利用者64.5%が他ソースも確認、ただし最初の手段はWeb検索74.4%

AIを使って優れたコンテンツを書く方法(7つのベストプラクティス)

AIを使って優れたコンテンツを書く方法(7つのベストプラクティス)

この記事は、Backlinkoの「How to Use AI for Writing Exceptional Content(7 Best Practices)」を翻訳したものです。ここ最近のGoogleコアアップデートでは、事例やユーザーが生成したコンテンツなど、体験に根ざしたコンテンツが評価されやすい傾向が見られます。

体験コンテンツを効率よく制作する際に、AIはもはや欠かせません。AIを活用することで、インタビュー設計やリサーチの下準備を、短時間で質を保ちながらまとめられます。

以前に翻訳した記事「役に立つコンテンツを作る10の方法 + 事例とチェックリスト」とも通じるところがありますが、AIの提案を鵜呑みにして採用するだけのコンテンツではサイトの資産にならないでしょう。

読者リサーチの進め方や設問づくり、AIを活用した編集方法など、実務で再現しやすい手順が紹介されているので、自社のワークフローを見直すヒントとしてぜひご活用ください。

生成AIが発達した現代において、文章を書く人間が、敢えてAIを一切使わない理由は考えにくいですよね。

それはまるで、大工に「ドリルを使うな」と言うようなものです。確かにドリルがなくてもデッキは作れます。でも、わざわざそうする理由はあるでしょうか?

ライターは昔から、自分の技術を磨くために新しいツールを取り入れてきました。

AIに限らず、どんな技術でも我々の行動原理は「楽をしたい」という気持ちです。

画期的なツールが開発される度、「全部を自動でやってくれるはずだ」と期待してしまうのです。そして、そこそこの内容でよければ、AIはまさに最適な解決策になります。

でも、本当に優れたコンテンツを作るのは簡単ではありません。どんなツールを使っても同じです。

実際、この記事を書くとき私はAIをたくさん活用しました。

それでも完成までに40時間以上かかったのです。

なぜでしょうか?

それはAIを使ったことで、自分のコンテンツをもっと良くできると気づいたからです。そしてこれは、あなたにも同じように当てはまります。

私はコンテンツチームに、普段どのようにAIを執筆や編集に活用しているのかを聞きました。

シニアライターのYongi Barnardさん、Kate Starrさん、Shreelekha Singhさん、そしてシニアエディターのChris HannaさんとChris Shirlowさんが、それぞれのワークフローや知見を共有してくれました。

本記事ではその内容を随所で紹介していきます。彼らのような優秀なメンバーのおかげで、Backlinkoは月間およそ80万セッションものトラフィックを生み出しているのです。

ここから紹介するのは、AIがサポートしてくれる7つの普遍的なライティング手法です。

まずは、執筆プロジェクトの計画から見ていきましょう。

1. AIを使って読者を定義する

読者を深く理解していなければ、どれほど優れたアイデアも伝わらずに終わってしまいます。

AIを使えば、読者リサーチがぐっと簡単になります。

何千件もの実際の会話を数分で分析できるため、これまでのように何週間もかけてインタビューやアンケートを行う必要はありません。

オーディエンスリサーチをより速く行う方法

この記事を題材に、私は「人々がAIを使って執筆することをどう感じているのか」を調べてみました。

率直な意見を集めるなら、最適なのはRedditです。

実際に「reddit using ai to write good content」とGoogle検索したところ、数十件ものスレッドが見つかりました。

※SEOJapan補足:「Reddit」

アメリカの巨大掲示板型ソーシャルメディアのこと。ユーザーが投稿したコンテンツに対して投票できる記事、質問、意見交換などのコミュニティサイト

コミュニティの議論をいくつか集めて、PDF としてエクスポートしました。

そこで私はClaudeに次のような指示を出しました。

「AIを使って良質なコンテンツを書く」ことをテーマに調査をしています。そこで関連するRedditスレッドを5つ添付しました。これらの会話を分析し、以下の観点で表を作成してください。

・Desires(欲求):人々は何を達成したいのか?

・Pain points(課題):どんな問題や壁に直面しているのか?

・Objections(懸念):どんな不安や抵抗を示しているのか?

それぞれの項目には、ディスカッションからの引用も添えてください。

その結果には本当に驚かされました。

分析の結果、自分では気づかなかったパターンが見えてきました。

さらに、読者の生の感情や言葉をそのまま捉えた引用も含まれていました。

そのおかげで、私の文章は実際の体験に根ざしたものになったのです。

もちろん、私のやり方をそのまま真似する必要はありません。たとえばシニアライターのKate Starrは、読者リサーチに複数の情報源を活用しています。

Kate Starrさんのコメント

「私はよくAIにいろいろなデータを入力します。たとえば、Googleの『People Also Ask(PAA)』の内容や、クライアントとの会話記録などです。大切なのは、ターゲットとなる読者が自分の課題を語っているリアルな会話を見つけることです。

最近も、コンサルティングコールの記録をもとに詳しいカスタマーペルソナを作成しました。その結果、私たちのコンテンツ戦略全体を組み立てるうえで大きな助けとなりました。」

AIを活用するうえで大切なのは、次の3点です。

- 膨大な読者データを短時間で処理する

- 人の目では見逃しがちなパターンを見つける

- 実際の発言を引用し、得られた洞察をリアルな体験と結びつける

ヒント:興味深いコミュニティの議論をまとめたフォルダを作成しましょう。興味深いスレッドを見つけたら、すぐに保存しましょう。その情報が将来のコンテンツに役立つかもしれません。

※SEO Japan補足:「People Also Ask(PAA)」

「関連する質問」や「他の人はこちらも質問」といった文言で、Googleの検索結果画面上に検索キーワードに関連した質問と回答を表示する機能

2. AIを使って独自の視点を見つける

業界内で人気のコンテンツを参考にして、そのアイデアをアレンジするのは簡単です。実際、それはAIがデフォルトでやっていることでもあります。

では、もっと良い方法は?

他のコンテンツや多くのLLM(大規模言語モデル)が見落としがちな視点を探すことです。そうすることで、文章がより新鮮で読者を惹きつけるものになります。

ここから、その方法を3つのステップで紹介します。

ステップ1:ソース資料を集める

まずは、テーマに関する上位3〜5件ほどの投稿を探しましょう。

対象はSNSの投稿でも、記事でも、アクセスできるならメールでもかまいません。

たとえば私は「AIライティング」に関する投稿を3件ピックアップし、Googleドキュメントにまとめてからテキストファイルとして書き出しました。

ステップ2:AIに要約とアイデア出しを任せる

ステップ1で集めた資料をAIに入力し、全体を整理した分析を作ってもらいましょう。

そのとき使えるプロンプト例がこちらです。

[トピック]に関する記事をいくつか共有しました。これらを分析し、以下の観点で詳細に整理してください。

共通パターン

・繰り返し登場するアプローチを3〜4点挙げる

・記事の具体例を含める

・記事全体の構成や表現方法に見られる傾向をまとめる

前提

・各記事で当然のように扱われている前提を3〜4点抽出する

・論理や証拠が不足している部分を指摘する

・裏付けが足りない主張を見つける

不足している視点

・取り上げられていない重要な観点を3〜4点挙げる

・読者のニーズで十分に対応されていない部分を指摘する

・さらに深掘りできるテーマを明らかにする

注目すべき要素

・独自性のある、または効果的なアプローチを示す

・強い根拠や具体例を取り上げる

・記事の核となる構成や表現の工夫がみられる箇所を特定する

こちらが「AIを活用した執筆」の出力結果です。

| カテゴリ | 詳細 |

| 共通パターン | ・戦略性より機能差に注目したツール比較が多い ・基本的な「入力と出力」のワークフロー事例 ・「効率化できる」といった抽象的メリットの提示に偏る ・プロンプトエンジニアリングの重要性ばかりを強調 |

| 前提 | ・AIを使えば使うほどコンテンツは良くなる ・読者はすでにAIの基礎を理解している ・単一の手法で誰にでも通用するという想定 ・倫理的な懸念は簡単な免責事項で対処できると考えている |

| 不足している視点 | ・品質を検証するための仕組みや指標 ・ツール選択のための戦略的なフレームワーク ・人間とAIが協働した具体的事例 ・アプローチ別のコストと効果の比較 |

| 注目要素 | ・ある記事では詳細なワークフロー図を掲載 ・別の記事では失敗事例のミニケーススタディを紹介 ・複数の記事で丁寧な倫理ガイドラインを提示 ・ある記事ではAI出力の品質に関する独自の調査結果を提示 |

分析が終わったら、見つかった改善点をもとにAIに新しいアイデアを提案してもらいます。

このとき、Claudeが本記事に対して返してきた提案がこちらです。

AIライティングを考えるうえで提案された3つの切り口はこちらです。

1.戦略フレームワーク型

ポイント:執筆内容に合わせてAIツールをどう選び、どう使うかを体系的に整理する

メリット:ツールをやみくもに試すのではなく、根拠ある判断ができるようになる

違い:単なるツールリストを超え、判断基準やワークフローを明確に示す

2.品質管理型

ポイント:AIを使いながらもコンテンツの品質を保つための具体的な手順

メリット:プロのライターが最も気にする「品質維持」という課題に応える

違い:ツール利用の説明にとどまらず、品質を測定・改善するプロセスに重点を置く

3.現実チェック型

ポイント:AIの強みと限界を率直に見極める

メリット:読者が現実的な期待値を持ち、ありがちな失敗を避けられる

違い:理論上の効果ではなく、実際の事例やケーススタディを取り上げる

ステップ3:切り口を分析してブラッシュアップする

AIが最初に出力した切り口がそのまま使えることもあります。

しかし多くの場合では、魅力的なアイデアを見つけるためには、AIとのやり取りを何度も重ねる必要があります。

この記事も、そのプロセスを経て形になりました。

確かにツール比較や基本的なワークフローを解説する記事は豊富にありましたが、AIをどう戦略的に活用すべきかという枠組みを提示しているものはほとんどありませんでした。

さらに深く掘り下げていくと、もっと根本的なことに気づきました。

誰もが「執筆を楽にする」ことに注目していたのです。ツールやプロンプト、ショートカットなど。

でも、そこには見逃されている現実がありました。

優れたコンテンツを作ることはAIを使っても、使わなくても難しいものです。

そこで私は自分の切り口をこう定めました。AIをうまく使いながらも、良質なコンテンツをつくるために必要な努力は不可欠であるという視点です。

プロのヒント:最初に得られた気づきは、より良い切り口へ発展することがよくあります。初期の分析にとらわれず、思考を広げていくことを恐れないでください。

3. AIを使ってアウトラインを作成する

優れたコンテンツの多くは、綿密な計画から始まります。ところが、多くのライターはこの工程を省きがちです。

その結果、何時間も同じところをぐるぐる書き直したり、依頼の趣旨から大きく外れてしまったりするリスクがあります。

そのため私たちのチームでは、しっかりしたアウトラインを作らずに下書きを始めることはありません。

AIを活用すれば、そのアウトライン作成がずっと楽になります。

関連記事: コンテンツブリーフとは? (+3つのテンプレート)

AIとの協働によってアウトラインを強化する

AIにアウトラインを丸ごと任せたくなるかもしれませんが、それでは独自の視点が失われてしまいます。かといってAIを使わなければ、得られるはずの有益な洞察を逃してしまいます。

では、より良いアプローチは?

AIを「考えを深めるための相棒」として活用することです。

当社のシニアエディターであるChris Shirlowも、アウトライン作成の段階でAIを戦略的に取り入れることの重要性を強調しています。

Chris Shirlowさんのコメント

「私はまず、自分の競合分析をもとにアウトラインを作成します。その後、AIを使って潜在的な不足を洗い出します。例えば、メールマーケティングのガイドのアウトラインを作成した際に、AIが私の発想になかった自動化の章を加えるよう提案してくれたことがありました。」

重要なのは、自分自身のリサーチから始めることです。そうすることで、土台にしっかりとした専門性が宿ります。そのうえでAIを活用すれば、考えをさらに洗練させ、広げることができます。

たとえば、この記事では、私は最初に以下のようなラフな構成メモを用意しました。

- ニーズ(需要)

- 想定読者

- 切り口

- 構成

- リサーチ

- 執筆

- 図やビジュアル要素

- 付加要素

- 編集

次に、いくつかの参考資料を添えてClaudeにプロンプトを与えました。

私は今『AIを活用してより良いコンテンツを書く方法』に関する記事を執筆しています。概要と大まかなアウトラインは準備済みです。このアイデアのきっかけとなった記事も添付しました。

この進め方に対する、あなたの第一印象を聞かせてもらえますか?

以下はClaudeの分析(私が要約したもの)です。

強み

・AIの位置づけ:代替手段ではなく大工にとってのドリルのように「便利な道具」として紹介

・現実的な期待感:コンテンツ作成が依然として難しいことを認めている(40時間の例)

・普遍的な焦点:特定のAIツールやプロンプトに依存せず、基本原則を強調することで記事の価値を長持ちさせている

・信頼性:具体的なケーススタディや著者自身の経験を取り入れている

改善すべき点

・構成面:似通った要素(たとえば「読者」と「リサーチ」)は統合を検討する

・実装面:AIが実際に各手法をどう強化できるか、より具体的な事例を加える

・メタ視点:この記事そのものをAIを活用しながら書いている、という背景をより明確に示す

・バランス:記事の完成度を高くするために、AIの限界についての説明も盛り込む

AIが最初に出したアウトプットを出発点に、協働が始まりました。

Claudeは、各要素の呼び方を「ヒント」ではなく「プラクティス」とするよう提案してくれました。

その後も、私たちは各プラクティスの下位構造について互いに意見を交わしました。

途中でH2の見出し案を出してくれましたが、多くは私の意図と合わず、採用しませんでした。

それでも長いやり取りを重ね、文書に戻って修正する時間を挟みながら、最終的に納得できるアウトラインにたどり着きました。

以下は、その議論を通じて構造がどのように発展していったかの流れです。

| 項目 | バージョン1 | バージョン2 | バージョン3 | バージョン4 |

| ニーズ(需要) | 深掘り調査:表面的な情報にとどまらない | まずはユーザーの声を聞く | 読者像を定義する | AIを活用して読者像をさらに具体化する |

| 読者 | 読者理解:深く共感されるコンテンツを作る | 読者マップを作成する | 独自の切り口を見つける | AIを活用して、自分では気づかない独自の切り口を発見する |

| 切り口 | 戦略的な立ち位置:独自の切り口を探す | 独自の切り口を深める | 明確なアウトラインを作成する | AIを活用してアウトラインを作る |

| 構成 | ストーリー設計:明確で説得力のある流れを構築する | コンテンツ全体の流れを整理する | 扱うテーマをリサーチする | AIを活用してテーマをリサーチする |

| リサーチ | 証拠や事例を用いてアイデアを具体化する | 説明するだけでなく、実例で示す | 魅力的なコンテンツを書く | AIを使って魅力的なコンテンツを書く |

| 執筆 | 声と文体:独特の存在感を醸し出す | 自社(自分)のブランドボイスを見つける | 読者に役立つ補足要素を加える | AIを活用して補足要素を充実させる |

| 強化 | 強化要素:コンテンツのインパクトを高める | 効果的な強化要素を加える | 読者に響くように文章を編集する | AIを活用して下書きを編集する |

| 編集 | 洗練と最適化:パフォーマンスを高めるために仕上げる | 完成版をしっかりと仕上げ、磨きをかける |

この繰り返しのプロセスによって、次の改善ができました。

- 行動が具体的に伝わる見出しに書き直せた

- 「AIを活用して…」という統一フォーマットを導入し、SEO対策にもつながった

ではここから、AIをどう使えばリサーチを通じてアウトラインを実際のコンテンツに仕上げられるのかを見ていきましょう。

4. AIを使ってテーマを調査する

リサーチは、いつの時代も優れた執筆の基盤です。

インターネットが普及する前は、図書館でカタログや学術誌、教科書を何時間もめくるのがリサーチの定番でした。

やがてデジタルの登場がその流れを大きく変えましたが、同時に「情報過多」という新しい課題も生んだのです。

今や、数百万もの情報源に一瞬でアクセスできる時代です。

ブログ記事、学術論文、オンラインコミュニティでの議論、専門家のインタビュー、分析データの情報は無数にあります。

しかし、それをすべて処理する時間はあるでしょうか?

そこでAIの出番です。

AIなら数千件もの情報を数秒で読み込み、見落としかねない重要な洞察を拾い上げてくれます。

ここからは、AIを効果的に活用する方法を探っていきましょう。

一次調査におけるAIの活用

インタビューや生データの収集、アンケート調査などを行うことで、他に模倣が難しい独自性のあるコンテンツを生み出せます。

重要なのは、AIを「分析だけ」に使うのではなく、リサーチ全体の流れに組み込んで活用することです。

より良いリサーチ質問の計画を立てる

リサーチの質は、適切な質問をすることにかかっています。

例えば、この記事を書く際、私は当初、自分のAIに関する体験だけを例にしようと考えていました。しかし、それだけでは不十分だと感じました。

そこで、私はClaudeと議論を始めました。

私:自分の考えだけでは限界があると感じています。編集チームに「AIをどう使っているか」を調査すれば、もっと多くの視点を加えられるかもしれません。

AI:それは、記事の説得力を大幅に高める方法です。複数の執筆者がAIの課題にどのように対応しているかを示せば、理論だけの説明よりもはるかに説得力が増すでしょう。

検討すべきこと:

・求めている具体的な知見は何か

・それを集める最も効率的な方法は何か

・メンバーが参加しやすくするにはどうすればよいか

Claudeのフィードバックを踏まえ、私は何度も調整を重ねながら調査質問を組み立てました。

この手法を試してみたい場合は、以下のテンプレートを参考にしてください。

具体的な質問を作成する前に、この研究アプローチを評価してください。

・対象:調査/インタビューを行う対象を説明

・目標:調査を通じて何を知りたいのか

・方法:データの収集方法

・期間:制約条件

そして、次のポイントを洗い出してください。

・潜在的な問題

・見落としている可能性のある視点や機会

・効率を改善する方法

次に、リサーチで使う質問の作成です。

トピックに関する[アンケート/インタビュー]用の質問の作成を手伝ってください。

考慮すべき点

・対象者:参加者について記述する

・時間的制約:予想される所要時間

・主な目的:2〜3の主要な目標を挙げる

・必要な出力:最終的に作りたいもの

質問の構成は以下のようにしてください

・焦点は絞りつつ、自由に答えられるオープンな形にする

・短時間で答えやすい内容にする

・具体例を求める質問にして明確さを保つ

最後に、用意した質問をテストしてみましょう。

これが私の下書きの質問です。次の点について分析してください。

・質問がわかりやすいか、混乱を招かないか

・誘導的・偏った表現になっていないか

・抜けている部分やカバーしきれていない内容がないか

・質問の順序や流れが論理的かどうか

例:

AIとの何度かのやり取りを経て、当初の「チームに調査をする」というアイデアは次のように変わりました。

- 条件分岐を使い、焦点の定まった調査

- 必要な内容を明示する具体例

- 親しみやすく協調的な導入文

- AI利用に関する具体的なプロンプト

その結果、チームから有益な知見を得られ、この記事を強化することができました。

専門家インタビューを最大限に活かす

インタビュー相手としっかり向き合いながら、細かな情報まで取りこぼさずに記録したい。そんなとき、AIが役立ちます。

まずは会話を録音することから始めましょう(もちろん相手の同意は必須)。自然な対話を心がけ、気になる話題は深掘りしてみてください。その後はAIを活用して、会話の中から価値ある洞察をすべて抽出します。

以下に、いくつか簡単なプロンプトを示します。

インタビューの準備

トピックに関する専門家インタビューの準備を手伝ってください。

提供した背景資料を確認したうえで、以下を提案してください。

・取り上げるべき主な議論のテーマ

・各テーマに関連する追加質問

・尋ねるべき具体的な事例やケース

・検証すべきデータや数値

録音を処理する

トピックに関する専門家インタビューの文字起こしを共有しました。以下を行ってください。

1.主なポイントをわかりやすく要約する

2.具体的な例やケーススタディを抽出する

3.独自の洞察や視点を見つける

4.印象的な引用を抜き出す

5.不明確で追加確認が必要な箇所を指摘する

インサイトの検証

以下はインタビューから得られた私の主要な所見です。これについて、次の観点でチェックしてください。

1.結論が文字起こし内容によって裏づけられているか

2.自分が勝手に置いてしまっている前提はないか

3.読み手に理解してもらうために補足すべき文脈は何か

4.別の見方や解釈の余地があるかどうか

生データを理解する

リサーチの難しさは、データを集めること自体ではなく、その中から意味のあるストーリーを見つけ出すことにあります。

編集チームがAI活用に関する調査を終えたとき、私はまさにこの課題に直面しました。

回答を素早く処理したい、でも同時に大切な気づきを漏らさず拾いたい、この両立が必要だったのです。

そのために私がAIを使ってどのように回答を分析したのかを以下で紹介します。

全体像を把握する

AIの活用に関するチームのアンケート回答を共有しました。以下を行ってください。

1.回答全体に共通するパターンを特定する

2.他と異なるユニークな使い方や意外なアプローチを記録する

3.詳細に語られている具体的な事例を強調する

4.深掘りすべき潜在的なテーマを提案する

詳細を掘り下げる

特定のプラクティスについて、以下を分析してください。

1.メンバーごとに異なる取り組み方

2.成功事例として特に効果があった使い方

3.共通する課題や制約

4.言及された具体的なツールやプロンプト

5.注目すべき作業フローの違い

補足資料の抽出

このトピックに関する回答から、以下を行ってください。

1. 重要なポイントを裏付ける、説得力のある引用を見つける

2.明確な成果を伴う具体的な事例を特定する

3.共有された興味深いAIプロンプトを記録する

4.補足として有効なビジュアルや図表を提案する

この分析により、チームのメンバーはそれぞれ異なる場面でAIを活用していることが分かりました。リサーチを得意とする人もいれば、編集に強みを持つ人もいます。

全員に共通していたのは、AIはあくまで慎重に扱うべきであり、全面的に依存すべきではない、という認識でした。

プロのヒント: AIを使ってデータを分析する前に、そのプロジェクトにとって「価値あるインサイト」が何を意味するのかを明確に定義しておきましょう。そうすることで、AIは最も重視すべき点にフォーカスして分析してくれます。

二次調査にAIを活用する

これまで二次調査といえば、論文やレポート、議論を何時間もかけて読み込むことを意味していました。

しかし、今は違います。

AIによって、既存の情報を整理・活用する方法そのものが変わりました。

ここからは、いくつかの活用例を紹介します。

音声・動画コンテンツから価値ある情報を引き出す

優れたインサイトの多くは、長時間のポッドキャストやカンファレンス講演の中に埋もれています。

創業者たちは舞台裏の物語を共有し、専門家は自分たちのフレームワークを明かし、業界のベテランはまだ記事にしていないトレンドについて語ります。

しかし、何時間もの動画を視聴するのは現実的ではありません。

ここでAIが時間を節約してくれます。

実際に私は、EC成長戦略に関する記事を執筆する際、創業者インタビューからAIを使って有益なインサイトを抽出しました。

まず、Who Is Elijah の創設者が 2,000 万ドルの収益を達成するまでの道のりを語るポッドキャストを見つけました。

次に、Rev AIを使用してインタビュー全体を文字起こししました。

19,000語の文字起こしをすべて読む代わりに、私はClaudeに次のようなプロンプトで会話を分析させました。

私はeコマースの成長戦略に関する記事を書いています。この創業者インタビューを分析して、以下の点を整理してください。

1.成長を促した重要な意思決定を特定する

2.具体的な数値や成果を抽出する

3.彼らのプロセスに関する独自の洞察を見つける

4.各論点を裏付ける説得力のある引用文を抜粋する

この分析により、業務効率に関する興味深い事実が明らかになりました。

- 彼らはチームを44人から21人に削減した

- 専門職のフルタイム採用から代理店との提携に移行した

- システムをゼロから再構築した

- 利益が出ていなかったキャンペーン(-60%)を成功に導いた

この1つのポッドキャストから、説得力のあるケーススタディと、読者が実践できる実用的な教訓の両方を得ることができました。

複雑な文書を整理・活用する

学術論文や業界レポートには貴重なデータが含まれています。しかし、その多くは難解で専門用語が多く、実務に落とし込むのは簡単ではありません。

当社のシニアライターである Shreelekha Singh は、AIに十分な文脈情報を与えることで、より質の高いリサーチ結果を引き出しています。

Shreelekha Singhさんのコメント

「ヘルスケアについて執筆するとき、私は必ず記事の具体的な目的と進め方をPerplexityと共有します。

その際『予測ではなく、測定可能な成果に焦点を当てた、エビデンスに基づく分析が必要』と明確にアウトラインに記します。

こうした詳細な文脈を与えることで、AI はより関連性の高い研究論文やケーススタディを見つけてくれます。」

もう一つの例

情報獲得についての記事を書くとき、私はGoogleの特許出願を理解する必要がありました。

ところが、その文書は高度な専門用語で書かれており、読むだけで気が遠くなるようなものでした。

途方に暮れる代わりに、私はAIを活用してこの複雑な資料の理解を助けてもらいました。

特許出願書をClaudeにアップロードし、「情報利得シグナル」について質問したのです。

するとClaudeは、「UserActionSignals」や「ClickSatisfaction」といった指標を平易な表現で説明してくれました。

その結果、Googleが新しい情報を評価・テストするプロセスを短時間で理解できました。

この方法は、以下のような資料にも有効です。

- 学術論文や研究資料

- 技術文書

- 業界レポート

- 法律関連の文書

- 調査データ

要するにAIを「学習のパートナー」として考えてみてください。100ページに及ぶ文書でも数秒で読み、要点を平易な言葉で説明してくれる頼れる存在です。

5. AIを使って魅力的なコンテンツを作成する

大規模言語モデル(LLM) は、最小限のプロンプトで非常に優れた出力を生成します。

しかし、自分らしい読者を惹きつける文章を書くとなるとAIはやや物足りないのが実情です。

私は2021年からAIを使った執筆を試していますが、モデルには「既定の書き方」があると感じています。

AIが好むのは、対比的な表現です。「これは違う。しかし、これは正しい。」といった書き方です。

また、「transform(変革)」「game-changing(画期的)」「leverage(活用)」「optimize(最適化)」といったフレーズをよく使います。(これらの言葉自体に問題があるわけではありません。)

AIには「すべてをリスト化してしまう」癖があり、もしプロジェクト全体を書けるなら、それも箇条書きにしてしまうでしょう。

もしAIの出力に満足できないことが多いなら、もっと良い成果を得る方法をお伝えします。

優れた参考資料を準備する

AIに与える文脈が具体的であればあるほど、生成される文章はあなたのスタイルに沿ったものになります。

つまり、自分の執筆スタイルを明確に定義することを意味します。

その方法としては、以下の要素を含む詳細なガイドラインを用意するとよいでしょう。

- 読者ペルソナ

- 読解レベル(学年・難易度の目安)

- 見出しの型

- 文章全体のトーン

- 具体例

- 読者を引き込む導入

ガイドラインに加えて、執筆サンプルとして使用できる完璧な記事や章を作ることを目標にしてください。

ガイドラインと具体例が揃えば、AIから得られる出力にも納得感が増します。

たとえば私の場合、ClaudeでBacklinko専用のプロジェクトを作成しました。そこには2万語以上の参考資料が含まれています。

新しい会話を始めるときも、Claudeは常にこの文脈を踏まえた状態で応答してくれます。

スタイル要件を何度も説明する必要はありません。

ヒント: AIツールにプロジェクト機能がない場合は、必要なリソースをPC内のフォルダにまとめて保存しておきましょう。必要なときにチャットでそれらを呼び出して使えます。

段階的に文脈を積み上げる

AIとの会話は、コンテンツの発展に合わせて進化させるべきです。

この記事のセクションを例に挙げましょう。私は「AIを活用した執筆」という専用チャットを立ち上げ、以下を共有しました。

- 概要

- これまでの記事草稿

- チームアンケートの回答

- このセクションの目標

そのうえで、次に「補足要素」に関するパートを書く際は、新しいチャットを立ち上げつつ、この完成済みセクションを参考資料として利用する予定です。

この段階的なアプローチにより、AI は各セクションの固有のニーズに適応しながら一貫性を維持できます。

シニアライターのShreelekhaも同じ手法を活用しています。

Shreelekha Singhさんのコメント

「私は、執筆のテーマや作業内容ごとに、異なるプロジェクトを作成します。こうすることで集中力を維持でき、AIにも各タスクに必要な文脈を正しく与えられるのです。」

利用しているLLMによっては、この「セクションごとに進める方法」がクレジットの節約につながります。長いチャットは使用量を消費してしまうためです。

プロのヒント:プロジェクトの最初の10%は、自分でゼロから書き上げましょう。そうすることで文章全体のトーンが定まり、AIに明確な方向性を与えるため、出力の質が向上します。

AIとの雑然としたやり取りを受け入れる

最良のAIライティング成果は、対話を通じて生まれます。

未完成のアイデアを共有し、その提案に疑問を投げかけ、さらに深く考えるよう促しましょう。

たとえば、このセクションを執筆するとき、私はAIにアウトラインの肉付けを依頼しました。しかし、最初の回答をそのまま受け入れたわけではありません。

「特定のトーンでプロンプトする」といった一般的な助言にとどまるのではなく、AIの標準的な文体とBacklinkoのスタイルの違いを具体例で示すよう求めました。

このプロセスを通じて、具体的なフレーズや表現のパターンを見つけることができました。

たとえば、私の冒頭フックはAIとの協働によって次のように進化しました。

文ごと、アイデアごとにやり取りを重ねるうちに、思わぬ金脈を掘り当てることができるかもしれません。

面倒ではありますが、一人で進めるよりずっと良い結果につながります。

必要なときに適切な事例を探す

大規模言語モデル(LLM)は、執筆を強化するための関連する事例やケーススタディを提案することに優れています。

シニアライターのShreelekhaも、行き詰まったときにAIを使って事例を洗い出しています。

Shreelekha Singhさんのコメント

「私はまず、説明しようとしているコンセプトと、必要としている事例の種類を説明します。AIは、私が考えもしなかった視点を提案してくれることが多く、その後のリサーチにつなげられるのです。」

私がよく使うプロンプトテンプレートは次のとおりです。

「私は[コンセプト]について説明しています。[特定の側面]を示す事例が必要です。できれば[業種/企業の種類]の例をお願いします。事例は[望ましい結果]を示すものである必要があります。」

例えば、データ可視化について執筆している際、コンテンツでチャートを効果的に活用している企業の事例が必要でした。AIにこれらのパラメータを与えると、AIはHubSpotのマーケティングの現状レポートを見るよう提案しました。これは、まさに複雑なデータを誰にでも理解しやすくするという私の主張を示す好例になりました。

しかし、AIの提案をそのまま受け取ってはいけません。より深く調査するための出発点として活用しましょう。私がAIの提示した事例を扱うときは、必ず以下を行います。

・事実関係を自分でもう一度確認する

・背景や前提などの追加文脈を集める

・代替となる事例と比較検討する

・それが本当に自分の主張に合致するかどうかを評価する

Chris Shirlowは、次のようにバランスの取れたAI活用の重要性を語っています。

Chris Shirlowさんのコメント

「重要なのは、まずは自分自身のアイデアやリサーチを出発点にすることです。そして、そのコンセプトを広げたり新しい視点を見つけたりするためにAIを使います。決してAIにコンテンツの方向性を決めさせてはいけません。」

6. AIを使ってコンテンツ資産を作成する

チェックリストや計算ツール、インフォグラフィックなどのコンテンツは、記事を「読むもの」から「役立つツール」へと変えてくれます。

うまく活用すれば、複雑な概念を整理して理解を助けたり、学習をサポートしたり、意思決定の道しるべとなったりします。

かつては、これらのリソースを作るにはデザイナーや開発者が必要でした。

しかし今では、AIを使えばこうしたスキルがなくても作成可能です。

ビジュアル要素を取り入れる

読者の多くは文章をすべて丁寧に読むわけではありません。

ざっと流し読みしたり、拾い読みをしたりしながら、アイデアを導くための視覚的な手がかりを探します。

MITの研究によると、人間の脳はわずか13ミリ秒で画像を処理できるとのことです。これはテキスト処理の最大600倍の速さに相当します。

以前は、プロレベルのグラフィックを作成するには次のような手間がかかりました。

- デザインソフトを使いこなす

- デザインの基本原則を理解する

- 各ビジュアルに何時間も費やす

- 高額なデザイナーを雇う

しかし、今ではその必要はありません。

AIを活用すれば、魅力的なビジュアルを数秒で作成できます。

たとえば、当社の「マーケティングの 4P」の記事では、シニアライターの Yongi Barnard が、パーソナライゼーションが重要な理由を図解で説明しています。

ビジュアルは、一目で説得力のあるストーリーを伝えます。

これを再現するには、まずデータを準備しましょう。

次に、AIに対して条件(パラメータ)を指示します。

次の 3 つのパーソナライゼーション統計を示すグラフィックのデザイン設計を手伝ってください。

1.消費者の80%は、ブランドがパーソナライズされた体験を提供すれば購入意欲が高まる

2.マーケターの48.2%は、パーソナライゼーションがクリック率を最も改善すると答えている

3.顧客の66%は、企業に自分のニーズを理解してもらうことを期待している

以下の条件を取り入れてください

・シンプルでミニマルなデザイン

・割合を表すプログレスサークル

・コントラストのために暗い背景に明るいテキストを配置

・各統計の下に短く明確な説明

・出典を記載するためのスペースを確保

あとは、最後の仕上げの微調整(色、余白など)を行うだけです。

プロのヒント:データ可視化だけを考えるのではなくAIを活用して次のようなものも作成しましょう。

・プロセス図

・比較チャート

・タイムライングラフィック

・コンセプト図解

・機能の分解図

シニアエディターのChris Hannaは、このように述べています。

Chris Hannaさんのコメント

「今の優れたライターは、プロデューサーのように考えます。『この概念をどうすれば視覚的に伝えられるか?』『言葉で説明するのではなく、どう見せられるか?』と自問するのです。

AIは、デザインの専門家にならなくてもそれを可能にしてくれます。」

実用的なチェックリストを作成する

手順をチェックリスト化すると、コンテンツの実用性が高まります。

ただし、効果的なチェックリストは単なる箇条書きでは不十分です。必要なのは次の要素です。

- 複雑なプロセスを分解する

- 手順を最適な順序に並べる

- チェック項目に検証を含める

- 参考リンクを追加する

- ユーザーごとの利用シナリオを考慮する

ここで AI が役立ちます。

重要なのは、下書きを書いた後に AI に指示を出すことです。

こうすることで、大規模言語モデル(LLM)はコンテンツ全体のコンテキストを理解し、より詳細で関連性の高いチェックリストを作成できます。

たとえば、当社のシニアエディター Shannon Willoby は、ブログの始め方に関する記事を書くために 12 か月分のチェックリストを作成しました。

彼女はAIに記事の内容に基づいたチェックリストを作成させました。とてもシンプルですが効果的です。

以下は、そのまま使えるテンプレートです。

私は[トピック]に関する記事を書きました。これをもとに、以下の点を含む包括的なチェックリストを作成してください。

・各主要ステップを分解すること

・重要な判断ポイントを盛り込むこと

・必要となるリソースを明記すること

・陥りがちな失敗例を明示すること

・進捗を確認する方法を提案すること

インタラクティブツールを構築する

計算機や分析ツール、意思決定ツリーのようなインタラクティブな仕組みは、記事を「知識の共有」から読者がすぐに活用できる「実用的なソリューション」へと変えてくれます。

しかもこれは、どの業界でも応用可能です。

たとえば「生産性」をテーマに記事を書くなら、読者がプロジェクトの作業量を調整できる「作業容量チェッカー」を提供するのも一案です。

もしあなたがウェルネス分野のライターであれば、読者が健康的な生活習慣を身につけられるように「習慣積み上げプランナー」を開発することも考えられます。

また、ガーデニングの専門家であれば、季節ごとの植え付け時期を計算できるツールを提供するのも良いでしょう。

私は「EC成長戦略」に関する記事で、AIを活用してインタラクティブな利益計算ツールを作成しました。

数式を並べて解説するのではなく、読者がシナリオを操作して、売上原価(COGS)や送料、マーケティング費用といった要素が利益にどう影響するかを体感できるようにしました。

その最大のメリットは?

これらのAI設計ツールは、Calculator Studio のようなノーコードプラットフォームを使って実現できます。手順は以下のとおりです。

- コンテンツにおける計算ニーズを特定する

- AIに計算ロジックと数式の構築を依頼する

- ユーザーインターフェースを設計する(モックアップもAIで作成可能)

- お好みのノーコードツールで構築する

たとえば利益計算ツールを作成した際、私は AI に次のように指示しました。

EC事業者が自社の収益性を把握できるような計算ツールを作りたいと考えています。以下の機能を含めてください。

・売上原価(COGS)、配送費用、マーケティング費用といった主要な指標を入力できること

・粗利益率と純利益率を計算できること

・損益分岐点の分析を表示できること

まずはシンプルに始めましょう。

ひとつの問題を的確に解決できる基本的な計算ツールのほうが、ユーザーを混乱させる複雑なツールよりも優れています。

7. AIを使って下書きを編集する

編集は、「良いコンテンツ」と「卓越したコンテンツ」を分ける工程です。

しかし、以下のように、質の高い編集はコストや時間の面で負担が大きくなりがちです。

- 編集者に時間単位で依頼すると費用がかかる

- フリーランスの場合は請求できる作業時間が減る

- 長いレビュー工程を待たなければならない

- 自分で編集すると見落としが起きやすい

AIは、この状況を変えます。

編集者が下書きを確認する前に、迅速で偏りのないフィードバックを得たり、異なるバージョンを試したりすることができます。

では、効果的に実践する方法をご紹介しましょう。

まず戦略的な観点を取り入れる

すぐに細部の編集、たとえば文法チェックや表現のブラッシュアップに取りかかりたくなるかもしれません。

ですが、まずは全体像から見ることが大切です。

ここでは、Chris HannaがAIを使って戦略的な編集を行う方法をご紹介します。

Chris Hannaさんのコメント

「まず、草稿、アウトライン、そして概要をClaudeに渡します。そしてこう尋ねます。『何が足りないか? 論点を強化できる部分はどこか? どの部分により多くの根拠が必要か?』」

AIは次のように役立ちます。

- あなたの記事を成功例と比較する

- 繰り返しや抜けている部分を指摘してくれる

- 構成全体の改善点を提案してくれる

こうした方法を取れば、修正作業の時間を大幅に減らせます。削ったり書き直したりする段落へのブラッシュアップに時間をかけるのは無駄ですよね。

簡易的な品質チェックを行う

記事の構成が固まったら、体系的な品質チェックを作成してください。

あなたのコンテンツが主要なエンゲージメント指標を満たしているかを確認することが狙いです。

Backlinkoでは、読みやすさを測る3つの指標をチェックしています。

- 単文段落の割合:1文のみで構成されている段落の割合。

- 視覚的要素の密度:1,000語あたりに含まれる視覚的要素(画像や図解など)の数。密度が高いほど、読みやすさが向上する。

- 学年レベル:誰でも理解しやすいように、中学1年生程度(Grade 7)以下のレベルを目安にしている。

AIはこれらを瞬時に計算し、具体的な修正方法を提案してくれます。方法は次のとおりです。

- 目標とする指標をAIと共有する

- 記事の一部を貼り付ける

- 分析と具体的な修正の両方を依頼する

数値的な指標だけでなく、AIを使って次のような点もチェックしましょう。

- 冗長なアイデアや表現

- 受動態の多用

- 文や段落間のつながりの適切さ

- ブランドのトーンやメッセージの一貫性

- 技術的な正確性

重要な要素をテストする

コンテンツの中には、とりわけ重要な部分があります。

見出しは、クリックされるかどうかを決定します。

導入部分は、読者が読み進めるかどうかを決めます。

行動喚起(CTA)は、最終的にコンバージョンにつながるかどうかを左右します。

これらの要素は、特に注意を払う価値があります。

たとえば見出しなら、まず3~5個の候補をリストアップします。

そして、執筆しているトピックをGoogleで検索し、検索結果をスクリーンショットで残します。

スクリーンショットをClaudeにアップロードし、自分のタイトル案が上位記事とどう比較されるかを尋ねます。

するとClaudeは、当社のタイトル方針、ベストプラクティス、差別化のポイントを踏まえて提案してくれます。

シニアライターのYongiは、導入文に似たような手法を使っています。

Yongiさんのコメント

「3つの異なる導入文を書き、その中でどれが一番効果的に読者を引き込めるかをAIに尋ねます。その後、『なぜそうなのか』をAIと議論し、好奇心を刺激できているか、テーマとの関連性があるか、感情的な共鳴を生み出せているかといった観点で検証します。」

次のような点もテストできます。

- セクション間のつながり

- 事例

- 根拠の配置

- 技術的な説明

- 結論部分の主張

AIと人間の編集バランス

AIを使えば編集はスピードアップしますが、人間の判断は依然として不可欠です。

そのための実践方法は次のとおりです。

- 幅広い分析と迅速な修正のためにAIを活用する

- AIの提案に対して自分の判断を適用する

- 見出しや導入文など重要な要素は複数のパターンを試す

- 技術的な正確性は自分で確認する

- 自分らしい文体や視点を維持する

Chris Shirlowも、このAIと人間の役割分担を支持しています。

Chris Shirlowさんのコメント

「AIは潜在的な問題をより早く特定するのに役立ちます。しかし、実際に読者にとって役立つ変更かどうかを判断するには、依然として人間の専門知識が必要です。」

「頑張る」よりも「賢く」書き始めよう

今週取り組む予定の執筆プロジェクトを1つ選んでみましょう。

紹介した実践法の中から、1つだけ試してみてください。たとえば、読者のリサーチやアウトライン作成を手伝わせるなどです。

成果を感じ始めるのに必要なのは、それだけです。

これらの方法を実践する準備はできましたか?ぜひブログ投稿の書き方ガイドをご覧ください。

AIを使ったテクニックと実証済みのライティング原則を組み合わせ、検索で上位表示され、コンバージョンにつながるコンテンツを作成する方法がわかります。

BacklinkoはSemrushの所有です。私たちは、実践的な経験に裏打ちされた世界クラスのSEOインサイトをお届けすることに尽力しています。特に記載がない限り、このコンテンツはSemrush Inc.の従業員または有償契約者によって執筆されています。

SEOJapan編集部より:

AIを活用してコンテンツを制作する際は、効率化だけでなくよりよいコンテンツ制作のための壁打ち相手として活用することが大切です。

成果を左右するのは、AIが抽出した提案や示唆を、編集者が判断・検証し、他にはない独自の視点を加えられるかどうかです。

「効率化だけでなく差別化」したコンテンツをAIを活用して制作するという姿勢が、これから一層求められてくるでしょう。

役に立つコンテンツを作る10の方法 + 事例とチェックリスト

この記事は、Backlinkoの記事「10 Ways to Create Helpful Content + Examples and Checklist」を翻訳したものです。

好きか嫌いかは別として、私たちは常に、Googleのランキングに左右されています。

Googleのランキングシステムは、あるサイトを高く評価して上位に表示させる、あるいはサイトの評価を低くし、検索結果(SERPs)から表示されなくすることもあります。

とはいえ、ランキングシステムの全部が悪い話というわけではありません。

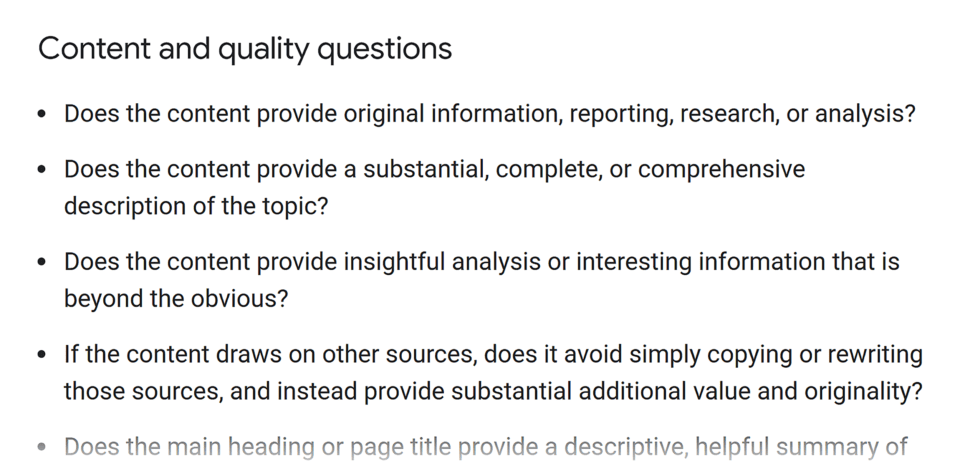

Googleは、「役に立つコンテンツ」について、詳細なコンテンツ評価ガイドラインを出しています。

Backlinkoでは、このガイドラインに沿ってコンテンツを制作しています。

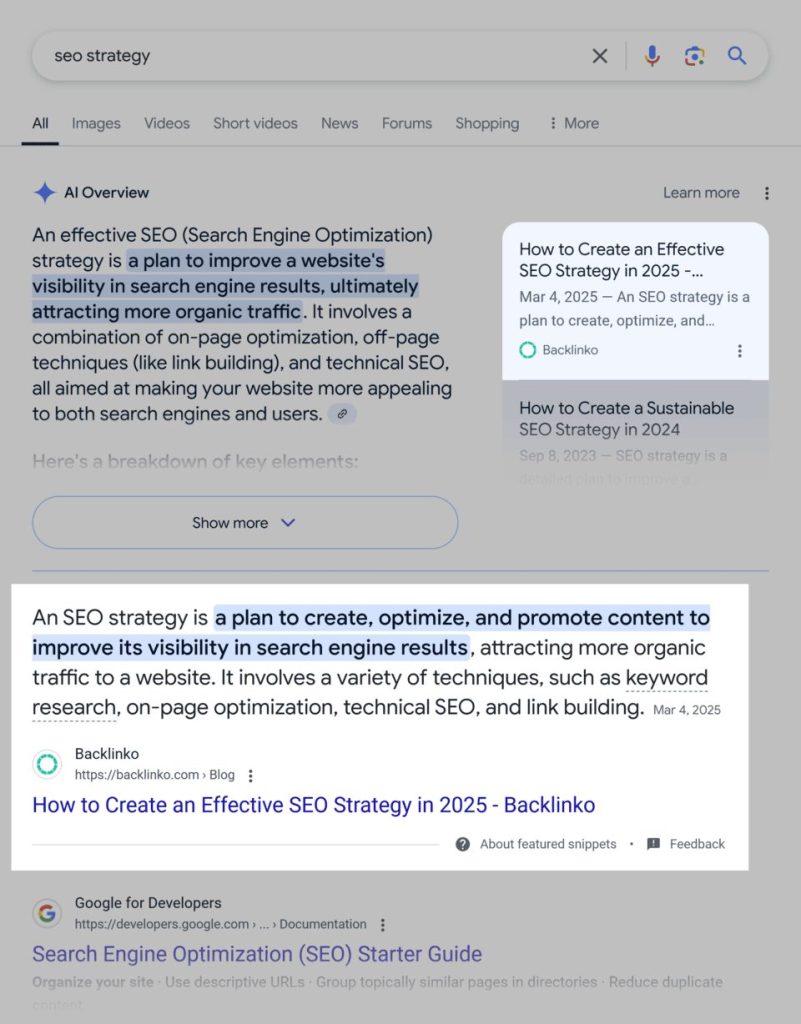

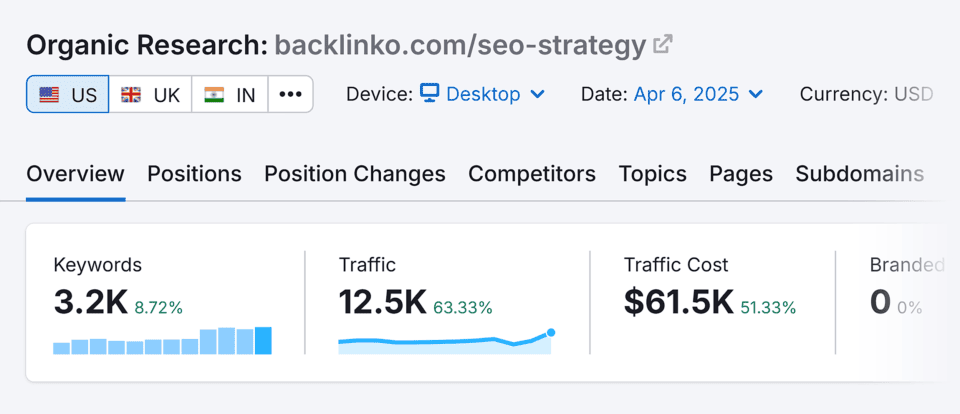

たとえば、私たちの「SEO戦略ガイド」は検索結果で圧倒的な上位を獲得しています。

そして3,200以上のロングテールキーワード(※)で順位を獲得しています。

これは偶然ではなく、私たちは、公開する全ての記事がGoogleの「ヘルプフルコンテンツ」の基準を満たし、更に評価されるよう目指しています。

この記事を読み終えた時には、きっとGoogleに評価される「ユーザーを第一に考えたコンテンツ」を作るための10のポイントが身につけられるでしょう。

さらに、この記事では実際に高評価を受けているサイトの事例と、コンテンツの品質をチェックできる無料チェックリストも公開しています。

Google目線になって、役に立つコンテンツが何なのかを解き明かしていきましょう!

Googleが考える「役に立つコンテンツ」とは?

「役に立つコンテンツ」とは、検索ユーザーが欲しい情報を的確に提供するコンテンツのことです。

情報を探している時、選択肢を比較している時、購入を検討している時などのユーザーの状況に関わらず、欲しい情報を常に提供できるコンテンツということです。

つまり、役に立つコンテンツとは、人々のために書かれたコンテンツであり、検索エンジンのために書かれたコンテンツではないということです。

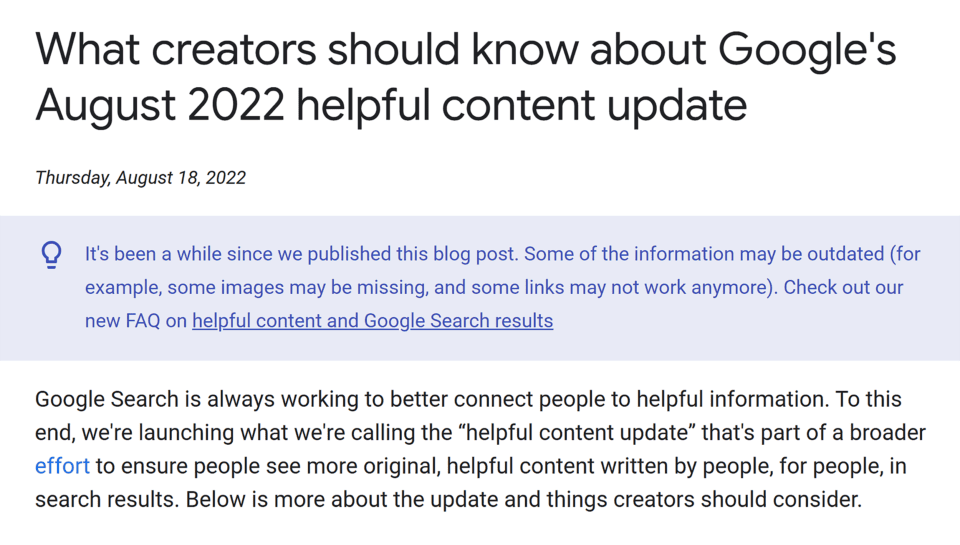

では、Googleの「Helpful Content Update(HCU)」とは何だったのでしょうか?

2022年に初めて導入されたこのアップデートは、「ユーザーを第一に考えたコンテンツ」を評価し、検索エンジン向けに作られたページを排除するためのものでした。

※SEO Japan補足:HCUとは Helpful Content Update(ヘルプフルコンテンツアップデート) の略です。Google が 2022 年に導入したアルゴリズム更新で、「人を第一に考えた役に立つコンテンツ」を評価し、検索エンジン向けに作られた低品質なページを順位下落やインデックス削除の対象にすることを目的としています。

Googleによれば、役に立つコンテンツには以下の特徴があります。

- 専門知識に基づいた、信頼できる情報を出すこと

- 競合コンテンツと比較しても高い価値を提供すること

- トピックに対する一次情報や実体験を示していること

- ユーザー体験が満足できるものであること

- 単なる検索順位目的ではなく、それ以上の目的があること

Googleはsite-wide classifierを使用し、個別のページ単位だけではなく、ドメイン全体でもWebサイトを評価しています。

つまり、低品質なコンテンツが大量にあると、優れた個別のページまで評価が下がってしまう可能性があるのです。

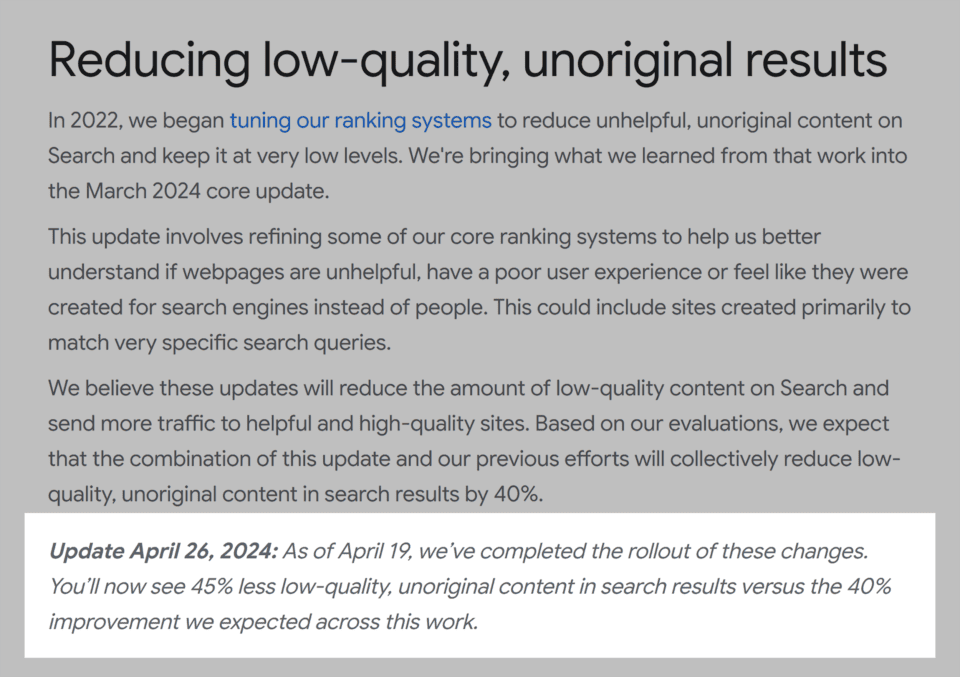

このアルゴリズムは2023年末から2024年初頭にかけて大きく変更され、多くのサイトが大幅にオーガニックトラフィックを失いました。

Googleは、この時検索結果から低品質コンテンツを45%削減したと発表しています。

※SEO Japan補足:site-wide classifier・・・GoogleがWebサイトを評価する際、ページ単位とサイト単位両方のシグナルを参照する仕組みのことです。

上記のアルゴリズムアップデートによって、特に大きな影響を受けたのは以下のようなサイトです。

- 実際の商品やサービスを持たない、コンテンツのみのサイト

- トラフィック獲得だけを目的に記事を作成しているサイト

- コンテンツが薄く、収益化(アフィリエイト等)に偏ったサイト

HCUの影響をめぐって、「果たしてこれは役立つアップデートだったのか?」という議論が広がりました。

そして、順位の下落やインデックス削除が本当に妥当だったのかという点も問われました。

しかし現実として、検索結果での表示はGoogleが決定しているのです。

ランキングを決めるのも変えるのもGoogleなので、そのガイドラインに従うことは必要不可欠です。

2024年3月時点で、Helpful Content Updateは単独のアップデートではなくなり、Googleのコアランキングシステムに統合されました。

結論として言えるのは、「役に立つコンテンツ」は、検索結果で生き残るために必要不可欠であるということです。

Googleが評価する役に立つコンテンツを作る10の方法

はっきり言って、優れたコンテンツを作ることは大変な作業です。

しかしそれは、高い検索順位や適切なターゲットからのトラフィックという成果につながる可能性があります。

1. 実体験を盛り込む

コンテンツを一瞬で「役立つ」ものにする方法があります。

それは、実際の体験談や事例(AIが生成したものではなく、実際のもの)を加えることです。

どうしてでしょうか?

なぜなら、あなたが「そのテーマについて深く理解している」と実際の体験談や事例によって示すことができるからです。

これは、Googleの E-E-A-Tガイドライン(Experience, Expertise, Authoritativeness, Trustworthiness=経験・専門性・権威性・信頼性)が重視する要素です。

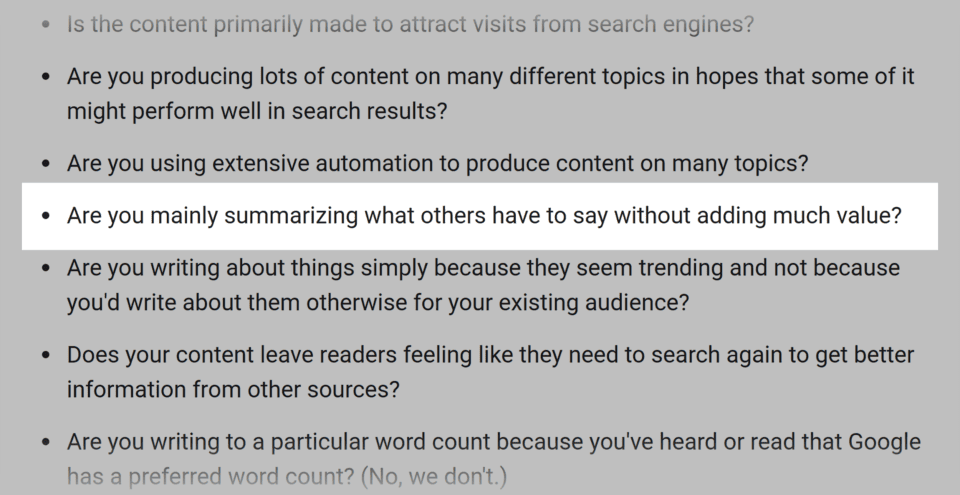

Googleは、自社サイトにおいて「よくある使い回しのアドバイスは避けるべきだ」と明言しています。

「新しく価値を付け加えず、他の人が言っていることをまとめているだけになっていませんか?」

つまり、似たり寄ったりの成功体験だけでなく、失敗も含めた自分の経験を盛り込むことが、検索エンジンに評価されるコンテンツを作ることに繋がると考えられます。

そして、それはユーザーが「読みたい」と思えるコンテンツになります。

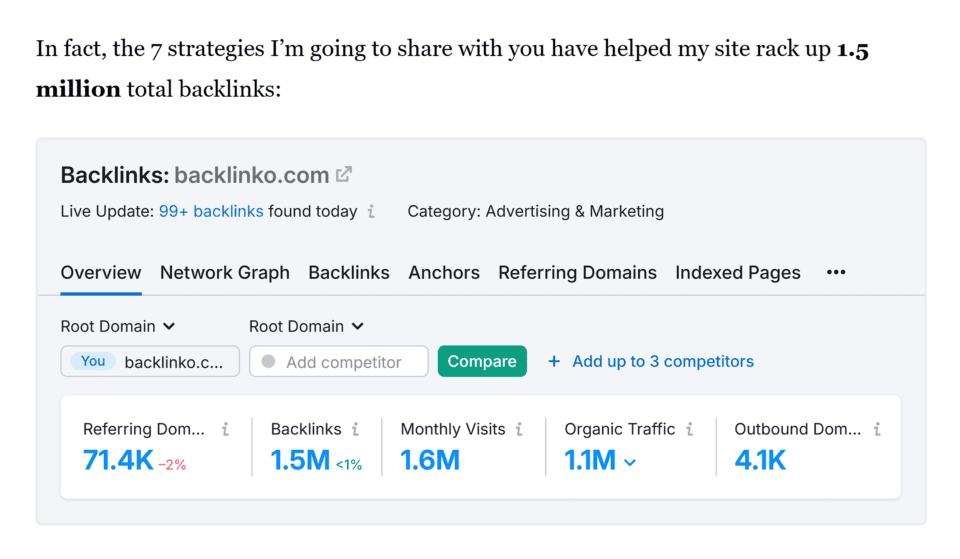

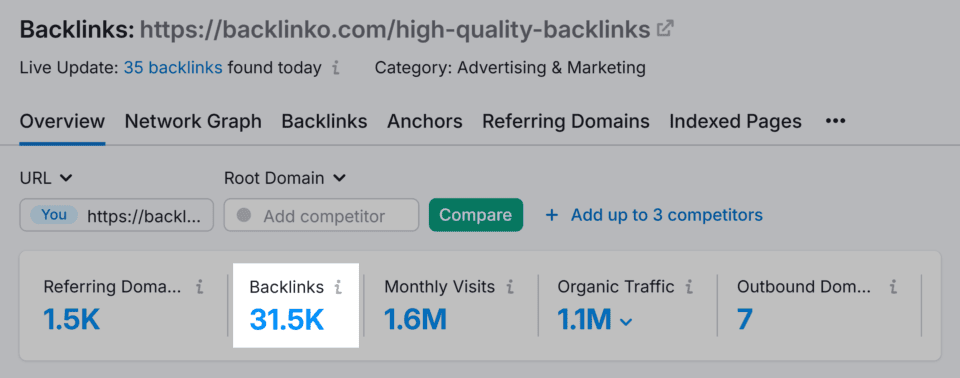

例として、Backlinkoの創設者Brian Deanによる「被リンクガイド」を見てみましょう。

Brianは「良いコンテンツを作りましょう」や「ブロガーに働きかけましょう」といったありきたりなアドバイスだけでは終わらせませんでした。

代わりに、彼が実際に行って効果があった具体的な手法を公開しました。

たとえば、

- 実際に使った外部連絡用メールテンプレート

- 実際の成果を示すスクリーンショット

- ステップごとの手順書

- 推奨ツールの紹介

- 実際のトラフィックデータ付き事例

その結果、読者は「実際に経験した人から学んでいる」という感覚になります。

そしてこの被リンクガイドは何年も高い検索順位を維持し、31,500件以上の被リンクを獲得しました。

プロのヒント:

- 経験談を共有する際は、必ず具体的な成果と数値を明記しましょう。

- 「これは効果がありました」だけではなく、どのように・どの期間で・どんな数字が出たのかを説明する必要があります。

- 可能であれば写真やスクリーンショットを添えて信頼性を高めましょう。

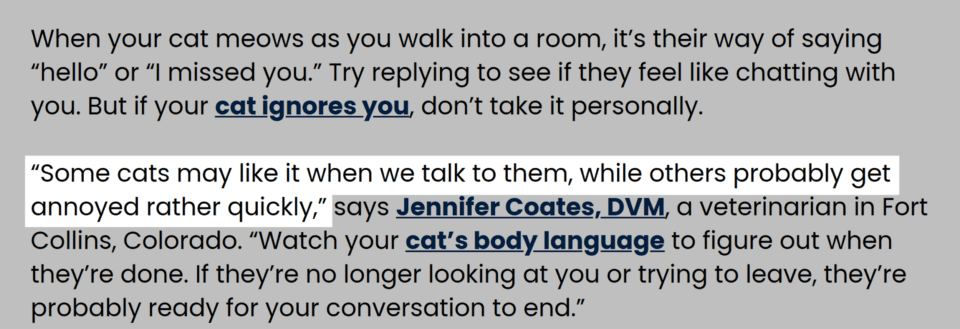

2. 専門家の見解や引用を追加する

専門家の意見や引用は、コンテンツに権威性と新たな視点を加えてくれます。

また、他では得られない知見を提供することは、Googleの「役に立つコンテンツ」の基準を満たすことにもつながります。

たとえ自分がテーマに関して経験がある場合でも、専門家の意見を加えれば新たな視点が加わり、コンテンツはもっと幅広く役立つものになります。

専門家の引用がもたらす主な効果は

- 主張の信頼性を高める

- 独自性のある洞察を提供する

- 競合が簡単に真似できないコンテンツを作る

ペット用品会社「Chewy」のコンテンツは良い例です。

この記事には、認定獣医師や動物行動学者によるコメントが何度も含まれています。

その結果、記事の権威性と信頼性が高まっています。

専門家の意見を得る方法

- メール・電話・ビデオ通話による独自インタビュー

- LinkedInやX(旧Twitter)、業界フォーラムで専門家に直接コンタクト

- 業界イベントに参加して人脈を築く

- メディア取材仲介サービスの活用

例:Numeral社のグロース責任者Nate Matherson氏は次のように語っています。

”ブログ記事を書くとき、私はよく、週刊SEOポッドキャスト「Optimize」のためにSEO業界のリーダーたちから専門的な見解を集めます。

例えば、ポッドキャストでGraphiteのCEOであるイーサン・スミス氏にインタビューした後、彼のトピックオーソリティ※に関する引用のひとつを、同じテーマのブログ記事で再利用しました。”

※SEO Japan補足:トピックオーソリティ…トピックオーソリティとは、特定のトピックに関して、ウェブサイトやコンテンツがどれだけ専門性、信頼性、権威性を持っているかを指す概念です。

3. 検索意図(Search Intent)に合ったコンテンツを作る

検索意図を理解し、それに沿ったコンテンツを作ることは、役に立つコンテンツの基本です。

例えば「蛇口の水漏れ修理方法」と検索した人が求めているのは、

明確な手順ガイドであって、配管工業者のサービスページではありません。

検索意図に沿ったコンテンツは、ユーザーの目的達成(蛇口を自身で修理する)を助け、その結果、Googleにとっても「役立つ」と評価されます。

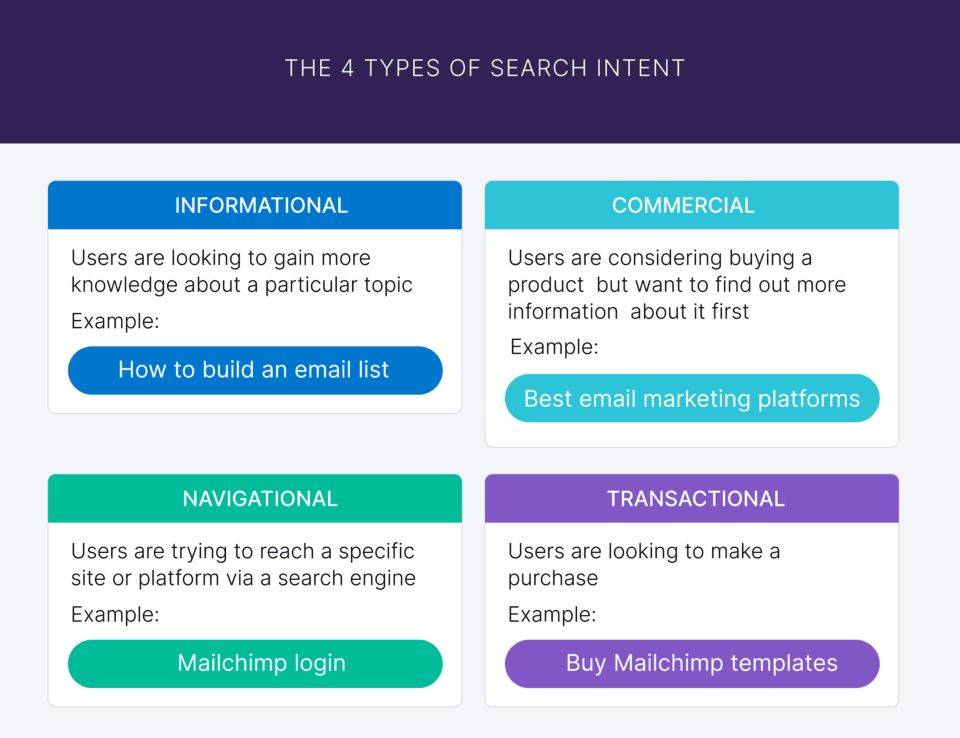

検索意図の4タイプ

- 情報型(Informational)…知識を求める 例:「蛇口の水漏れ 修理方法」

- ナビゲーション型(Navigational)…特定サイトへ行く 例:「Home Depot 配管」

- 商用調査型(Commercial)…比較・検討する 例:「おすすめ タンクレス給湯器」

- 取引型(Transactional)…購入する 例:「Moen タッチレスキッチン水栓 購入」

あなたのコンテンツは、本当に検索意図に合った「ユーザー第一」の内容になっていますか?

迷ったときは、Googleが示す次のポイントを確認してみましょう。

”あなたのコンテンツを読んだ人は、「目的を達成するのに必要な知識が十分に得られた」と感じられるでしょうか?”

”あなたのコンテンツを読んだ読者は、満足のいく体験ができたと感じるでしょうか?”

これらの質問のいずれかへの答えが「NO」であれば、そのコンテンツは検索意図を完全には満たしていません。

検索意図に沿ったコンテンツ作成のポイント

- ターゲットキーワードで上位表示されているページを分析する。

- 検索結果の上位ページで一番多く使われているコンテンツの形(ガイド、リスト、動画など)を把握する。

- キーワード調査ツールで各用語の検索意図を確認し、関連する質問やトピックを特定するためにキーワード調査ツールを使用する。この作業にKeyword Magic Toolが役立つ。

- 特定の質問に答える明確な見出しを使用する。

- 読者が記事を読み終えた後にすぐ行動できるように、明確な行動指針や参考情報を含める。

- メインテーマに関連する小さなテーマや読者が抱える典型的な悩みも漏れなくカバーすることで、トピカルオーソリティ(テーマにおける権威性)を示す。

※SEO Japan補足:Keyword Magic Tool…Keyword Magic Tool とは、SEOやコンテンツマーケティングのためのキーワード調査ツールで、Semrush(セムラッシュ)が提供しています。

4. 信頼できる情報源を使う

すべてのサイトにとって、高品質で信頼できる情報源を使用し、引用することは重要です。これにより、読者と検索エンジンの両方に対し、あなたの情報が正確で検証可能であることを示せます。

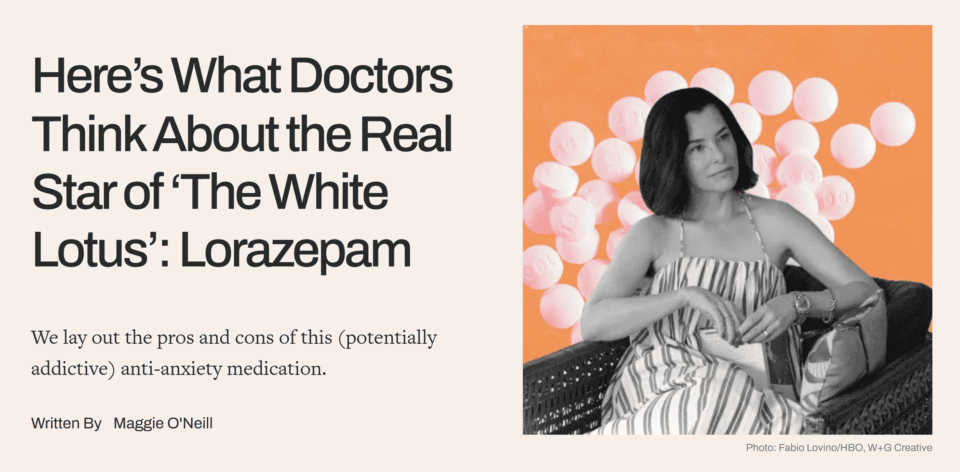

健康系メディア 「Well+Good」 の記事は、その好例です。

このメディアでは、薬の安全性に関する記事で、以下のような情報源を引用しています。

- 認定を受けた精神科医

- 精神医学および行動科学の大学教授

- 査読済み(※)の医学ジャーナル

- 信頼性の高い医療機関や政府系サイト(.govドメイン)

※.govドメイン:アメリカ合衆国の政府機関が使用するトップレベルドメイン(TLD)です。

信頼できる情報源を選ぶ際のポイント

- 分野で権威のある機関や人物(有名大学、大手メディア、業界リーダー)を優先する

- 公開日を確認し、最新情報であることを確かめる

- 引用は必ず一次情報源に基づくこと

- 資金提供や組織的背景による偏りがないかを確認する

GoogleのE-E-A-Tガイドラインでは、「信頼性(Trustworthiness)」が特に重視されます。

そして、信頼性は「確かな情報源に基づいている」ことを示すのが最も早い方法です。

5. その分野で執筆経験のあるライターを起用する

役に立つコンテンツを作る上で、ライターの経験値は非常に重要です。

そのため、ジェネラリスト(何でも書けるが専門性が浅い人)よりも、その分野での実務経験や知識を持つライターを優先的に起用しましょう。

専門分野に明るいライターが書くコンテンツには、以下のような様々なメリットがあります。

- 実務経験からしか得られない具体的で深いアドバイス

- 他では得られない専門性の高い情報

- 信頼を築くリアルな事例やケーススタディ

例えば、Harvard Health Publishing の記事は、医師自身が執筆しています。

執筆者は優れた資格を持ち、臨床経験、研究の資格、そして医療分野における専門知識があります。

こうした専門性は、YMYL(Your Money or Your Life)領域、つまり健康や金融など読者の生活に直結するテーマでは特に重要です。

経験豊富なライターは、美容でも旅行でも、どんなブログジャンルでも力を発揮します。

例えば、旅行ブログのFamily Vacationistは、取り上げる旅行先に実際に訪れたことのあるライターを起用しています。

彼らが教えてくれる、現地を知る人ならではのアドバイスを見れば、独自性の高い情報の重要性がよくわかります。

例えば、子どもにぴったりのアトラクションや、テーマパークで一番おいしい食べ物、どのホテルに泊まると良いか、そしてその理由に関する独自のアドバイスなどが、このライターでなければ書けない情報として挙げられます。

Family Vacationistは、ライターの経歴をプロフィール欄でしっかり紹介しています。

その中には、これまでに掲載された関連メディアや出版物の情報も含まれています。

他にも、すでに経験豊富なライターがいる場合でも、専門家によるレビューのプロセスを導入することで、コンテンツにもう一層の信頼性を加えることができます。

- 専門家によるファクトチェック体制を導入

- 記事内にチェックした専門家の資格や経歴を明記

- 編集方針ページでレビュー体制を公開

例えば住宅サービス会社の「Angi」は、記事に専門家のレビューを入れ、その専門家の経歴をプロフィールとして掲載しています。

専門家によるレビュー担当者には、その資格を強調する経歴も記載しています。

専門分野のプロに依頼することは、読者や検索エンジンに「このサイトはキーワード順位だけを目的にしているのではなく、正確で本当に役に立つコンテンツを届けようとしている」ということを示すことになります。

プロのヒント:

- 専門分野、経験レベル、出版歴ごとに分類された専門家レビュアーのデータベースを作成しましょう。新しいコンテンツが必要になったときに、誰にレビューを依頼すればよいかが明確になります。

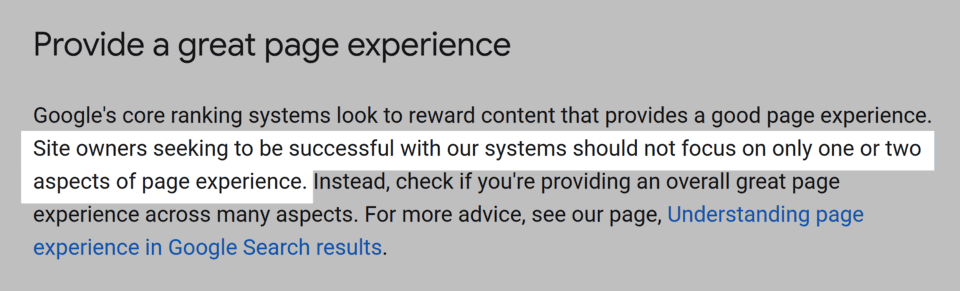

6. ページ体験(Page Experience)を最適化する

いかに役に立つコンテンツであっても、ページの読み込みが遅い、操作しにくいとなれば、ユーザーは離脱します。

Googleも「最低限の改善では不十分」と明言しています。

つまり、ページ体験は部分的にではなく、総合的に最適化する必要があります。

最適化のステップは次の通りです。

現状のパフォーマンスを分析する

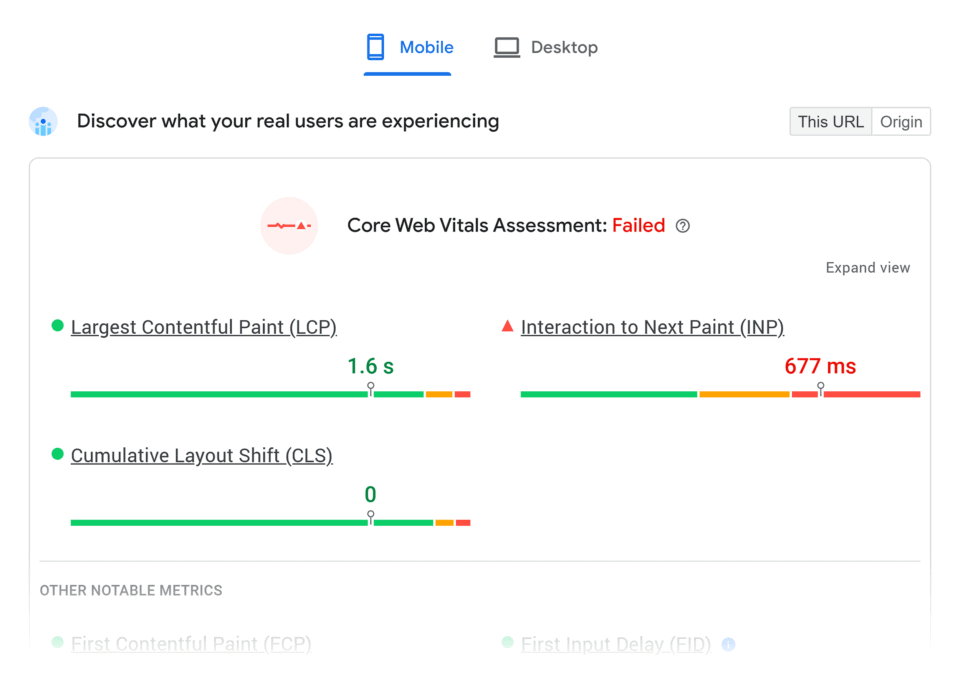

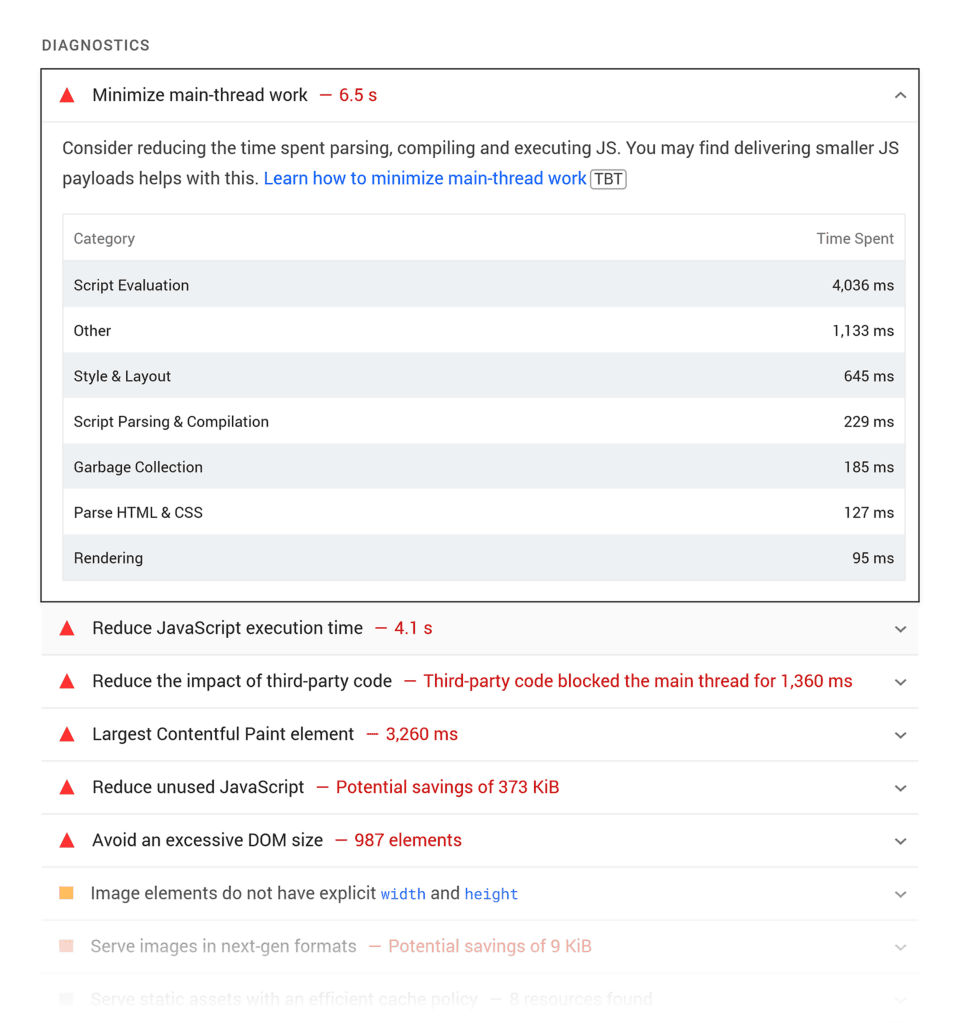

- PageSpeed Insights や Google Search ConsoleのCore Web Vitalsレポートで基準となる指標を設定

- 特に以下の指標に注目してください。

- Largest Contentful Paint(LCP)…主要コンテンツの表示時間

- Interaction to Next Paint(INP)…ユーザー操作への応答速度

- Cumulative Layout Shift(CLS)…レイアウトのズレの少なさ

基準をクリアできなかった場合は、これらの指標を改善するために、ツールの指示や提案に従ってください。

改善例としては、不要なJavaScriptや、サードパーティコードの削除などがそれに該当します。

プロのヒント:

- SemrushのSite Auditのようなツールを使用して、サイトの技術的パフォーマンスに関する週次のアップデートを受け取りましょう。

読み込み速度、検索エンジンに正しく巡回されるかどうか、リンク切れ、大きなファイルなど、ページエクスペリエンスに影響を与える問題について、自動的にアップデートを受け取ることができます。

※Semrush…SEO,広告、SNS、コンテンツマーケティングなどの領域で競合分析を補助するツール。Site Auditとは、Semrushに含まれる自サイトのチェック機能。

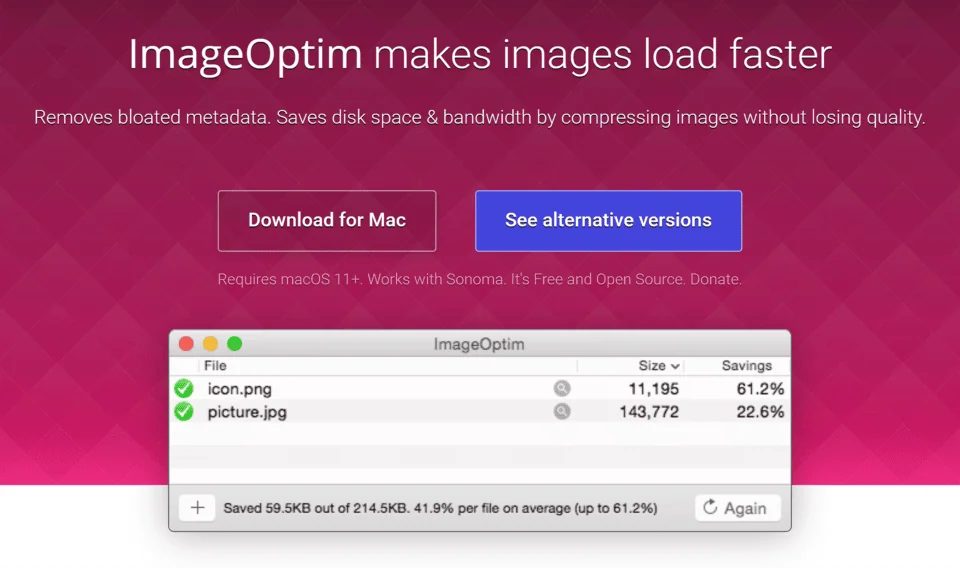

画像の最適化

TinyPNG、ImageOptim、またはCMSに組み込まれた最適化ツールなどを使用して、画質を損なうことなく画像を圧縮してください。

これにより、画像がページの読み込み速度を低下させるのを防げます。

TinyPNG:TinyPNG(Tinify)とは、Web上でPNGやJPEG画像を圧縮できる無料のオンラインサービスです。

ImageOptim:Macで使える無料の画像圧縮ソフトです。画像のファイルサイズを小さくすることで、Webサイトの表示速度を向上させることができます。PNG、JPG、GIF、SVGなど、様々な画像形式に対応しています。

すべてのデバイスタイプでテストする

サイトが、デスクトップ、タブレット、さまざまなモバイル画面サイズで機能するレスポンシブデザインになっていることを確認してください。

Chrome DevToolsまたはBrowserStackを使用して、利用者の多いデバイスやブラウザでサイトがどのように動作するかテストしてください。

モバイルでは指でタップできるボタンやリンクなどの操作できる箇所に特に注意してください。

ボタンやリンクが、誤ってクリックされることなく簡単にタップできることを確認してください。

Chrome DevTools:Google Chromeに搭載されたウェブ開発者向けツールで、サイトの構造やデザイン確認、動作テスト、速度測定、モバイル表示のシミュレーションなどができます。

BrowserStack:BrowserStackは、クラウド上で実機の様々なデバイスやブラウザ環境を再現し、Webサイトやアプリをテストできるサービスです。

セキュリティを改善する

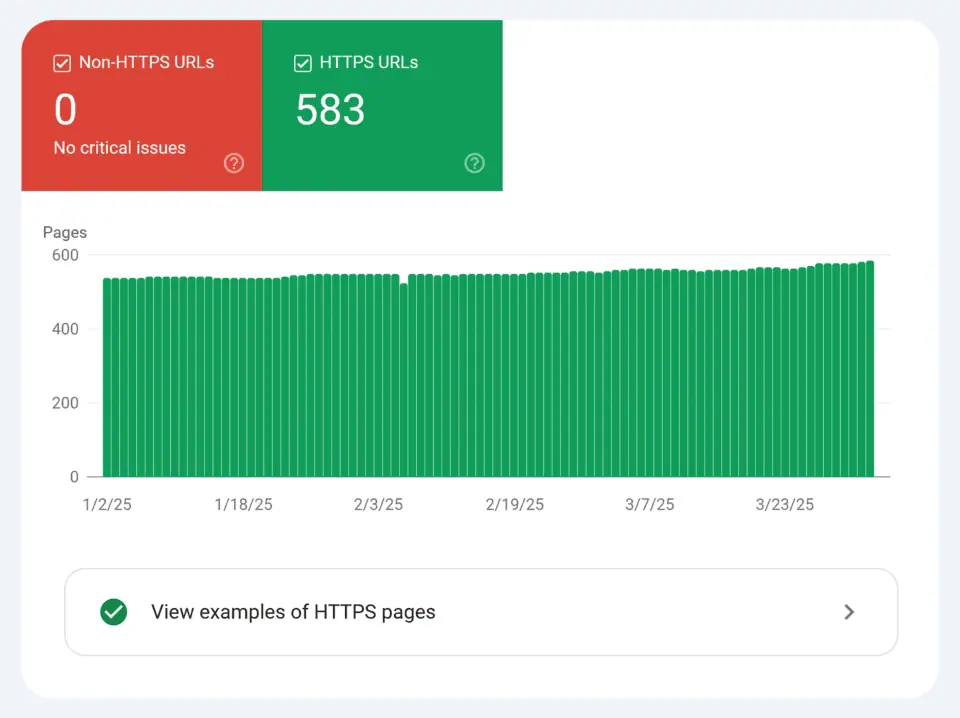

サイト全体でHTTPSを使用して、ユーザーの信頼を築き、Googleの安全なブラウジング要件を満たしてください。

Google Search ConsoleのHTTPSレポートは、ページが安全かどうかを確認できます。(安全でない場合はどのように修正すればよいかがわかります。)

また、適切なSSL証明書を設定し、すべてのリソースが安全に読み込まれるようにする必要があります。

スクロールせずに見える範囲のコンテンツを最適化する

Web訪問者の注意を引くために、ページの最初に表示されるコンテンツ(つまり、スクロールする前にWebページに表示されるファーストビュー)の読み込みを優先してください。

そして、訪問者を一番重要なコンテンツや情報へ案内します。

特にモバイルデバイスでは、画面を開いたときに最初に表示される領域より下に押し下げてしまう不要な要素は最小限にしてください。

収益化とユーザー体験のバランスを取る

ディスプレイ広告を使用する場合は、それらがレイアウトのずれを引き起こしたり、コンテンツを圧迫したり、読者にとって障害(※利用を妨げる要因)を生み出したりしないようにしてください。

広告が読み込まれる際にコンテンツがジャンプするのを防ぐために、レイアウト内に広告用のスペースをあらかじめ確保してください。

7. 情報価値(Information Gain)を追求する 〜SERPsに新しい価値を加える〜

Googleは公式に「※情報価値(information gain)」をランキング要因とは明言していません。

しかし、検索結果に新しい情報や独自の価値を加えることは、Googleの「役に立つコンテンツ」の理念と一致します。

情報価値とは、既にある内容の焼き直しではなく、読者が他では得られない情報を提供することです。

これまで紹介してきた「実体験」や「専門家の引用」も情報価値の一種ですが、他にも次の方法があります。

※SEO Japan補足:「情報価値(information gain)」とは、コンテンツが、同じトピックに関する他の記事にすでに存在する情報に加えて提供する新しい情報の量を指します。 これは、検索エンジンが、既存の検索結果(SERP)にない独自の視点や有用な知識を提供する記事を評価しようとする概念です。コンテンツが、ユーザーがすでに読んだ可能性のある情報を考慮し、それに加えて何が「新しい情報」であるかを判断することで、検索結果全体の情報の重複を解消するのに役立ちます。 簡単に言えば、情報価値が高いコンテンツとは、単に他の記事より優れているだけでなく、検索結果に新たな価値を加える記事であると言えます。

- 独自調査:ユーザーや業界へのアンケート結果を公開

- 独自フレームワーク:自社独自の評価基準や分析手法を開発

- 製品テスト:公式仕様ではなく、実際の使用感や性能を公開

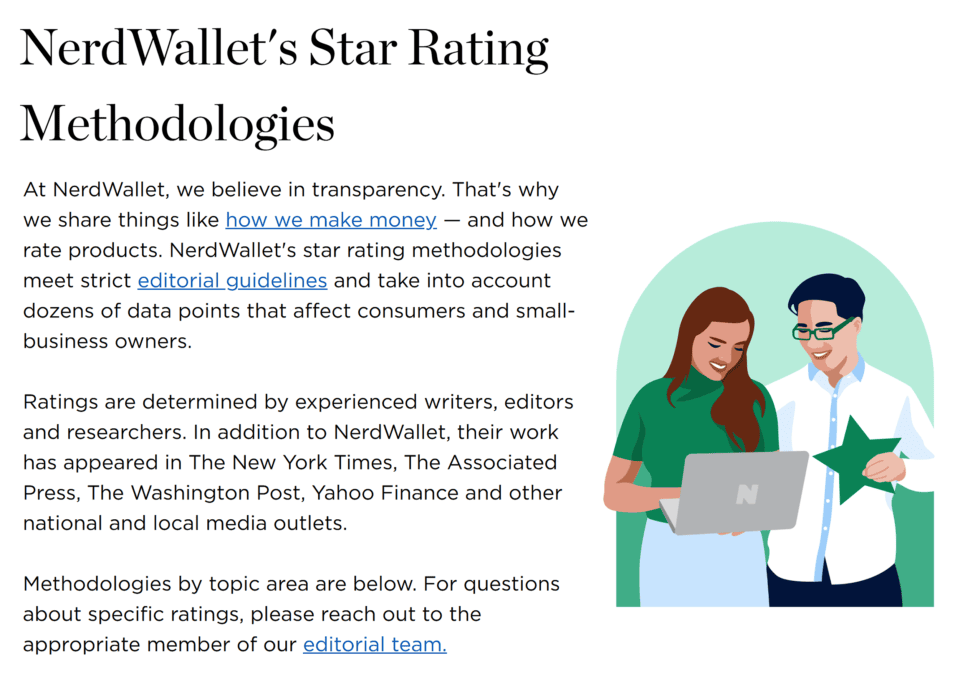

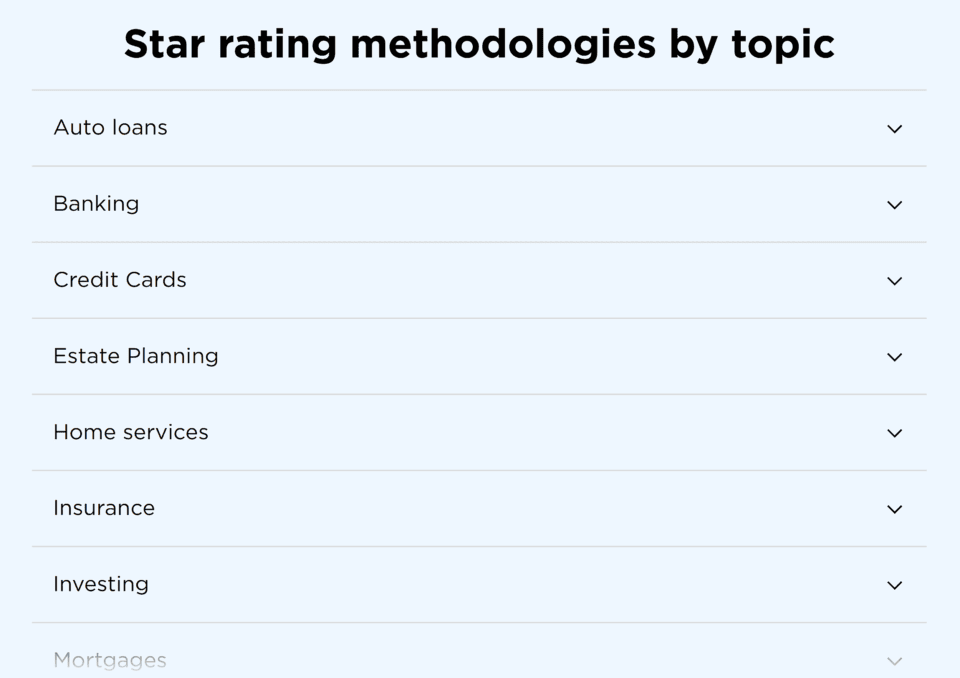

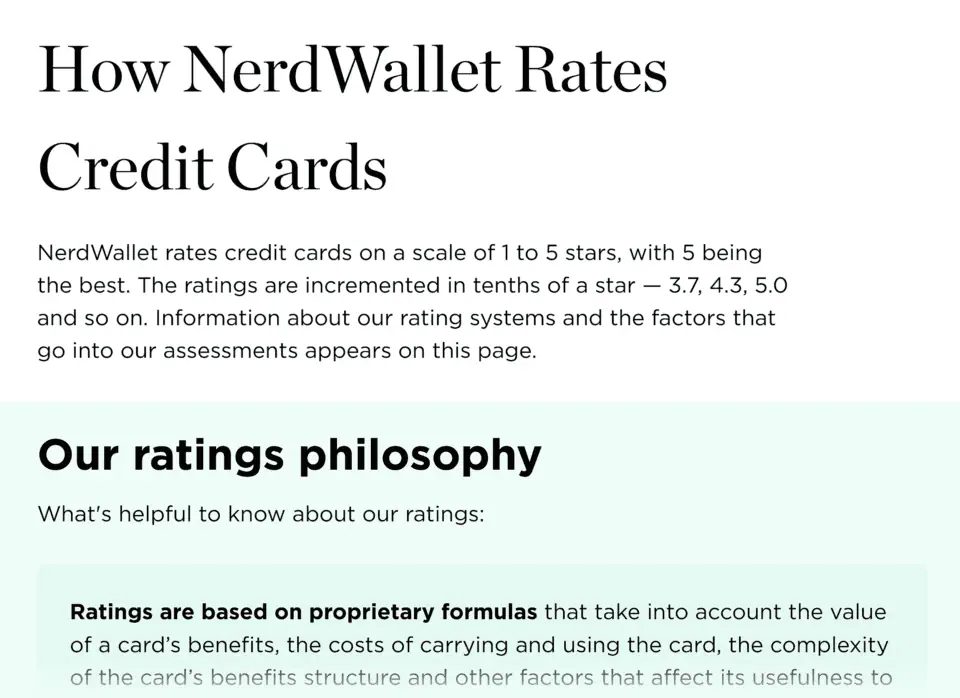

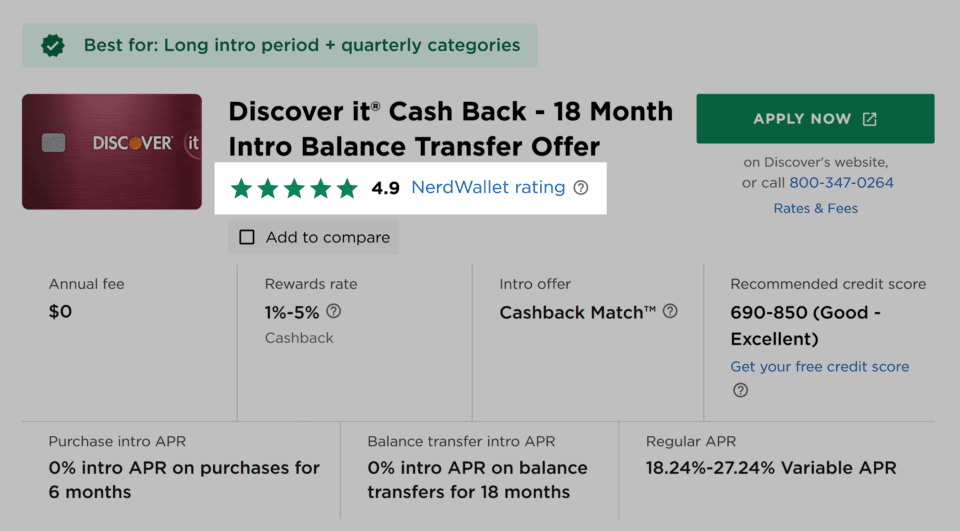

たとえば、金融サイト「NerdWallet」は、さまざまな金融商品を徹底的にレビューするために多大な努力を払っています。

彼らのレビューコンテンツが評価されているポイントは、金融商品のカテゴリごとに、レビューの評価基準を分けている点です。クレジットカードと住宅ローンでは、重要視される要素が違うためです。

さらに、評価基準の重み付けや計算方法を詳細に公開しています。

これにより、星評価の信頼性が高まり、読者は納得してクレジットカードを選択できます。

これらの評価は、読者が自分のニーズに最も合った商品を選ぶ手助けとして、NerdWalletのさまざまなレビューに掲載されています。

例えばクレジットカードの場合は次のようになります。

このように、情報価値を提供するには、時間や費用の投資が必要ですが、その分、競合が簡単に真似できないコンテンツが作れます。

8. 既存コンテンツを更新する

新しい記事を作ることが常にベストとは限りません。

むしろ、既存コンテンツを最新かつ包括的に更新する方が、少ない労力でより大きな成果を得られる場合があります。

Googleは、鮮度と正確性を保っているコンテンツを高く評価します。

また、古い記事を改善すると、順位やトラフィックが急上昇することもあります。

実例を挙げると、筆者がPositional社のブログ記事(タイトルタグに関する記事)を9か月間ほぼ放置していたところ、順位が停滞していました。

しかし記事を刷新し、最新情報を追加したところ、順位が急上昇し、その後も安定しました。

更新時の優先ポイント

- 統計や事例を最新データに差し替える

- 画像・レイアウトを改善し、読みやすさを向上

- 新しい専門家コメントや研究結果を追加

- 古くなったアドバイスを修正または削除

- 検索意図の変化に合わせて内容を調整

注意:見出しの日付だけ更新して中身を変えない「見せかけ更新」は逆効果です。

Googleは実質的な価値追加がある更新しか評価しません。

9. 有用なグラフィックや動画を作成する

「役に立つコンテンツ」は、文章だけを意味するわけではありません。グラフィックや動画も、読者の理解やエンゲージメントを高める重要な要素です。

ビジュアル作成のポイント

- 複雑な内容をわかりやすく説明するために使う

- 一般的なストック画像ではなく、オリジナルの図表やスクリーンショットを使う

- 動画はテキストの内容をなぞらず、オリジナルの付加価値を持たせる

- 重要なポイントを強調するコールアウトボックスを使用

コールアウトボックス(callout box)とは、文章中の重要な情報や注意点、補足説明などを目立たせるために囲みや背景色をつけたボックスのことです。

Backlinkoでは、コンテンツのビジュアル面を重要視しています。

私たちが、結果を強調したり、Webサイトのパフォーマンスを示したりする際に、さまざまな分析プログラムからのスクリーンショットを使用します。

私たちのカスタムグラフィックは、重要なポイントを説明し、複雑なトピックをより理解しやすくします。

また、記事全体を通して読者の関心を維持する役割も果たします。

私たちは、データ量の多いトピックをより理解しやすくするために表を使用しています。

そして、コンテンツの読みやすさと記憶の定着性を向上させています。

また、文章を区切り、さらに価値を加えるためにコールアウトボックスも使用しています。

この記事で言う「プロのヒント」のようなものです。

ビジュアル要素は、コンテンツをより魅力的にし、アイデアを明確に伝える効果を高めます。

それらは直帰率を改善するのにも役立ちます。

10. AIライティングツールを戦略的に使う

AIライティングツールは優れたアシスタントになり得ますが、人間のライターの代わりにはなりえません。

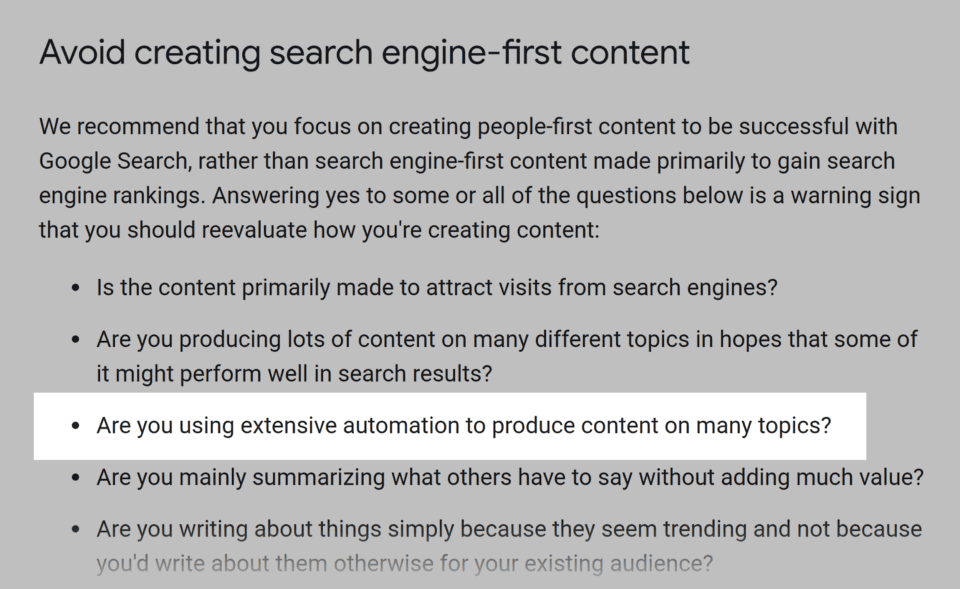

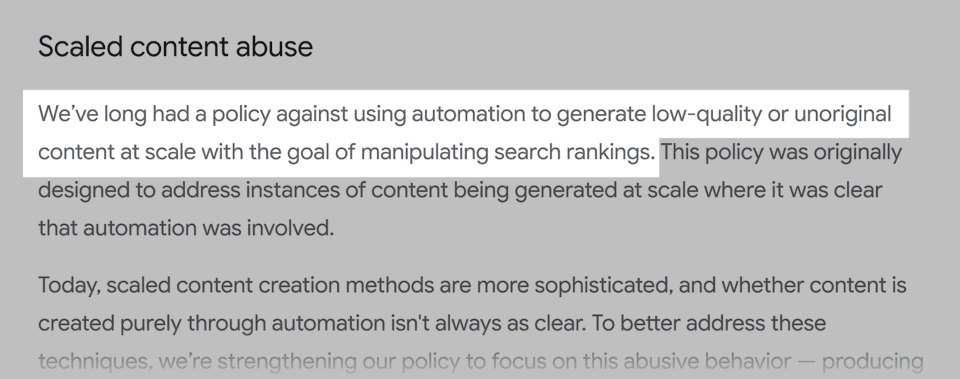

実際、Googleは「多くのトピックに関するコンテンツを大規模に自動生成すること」について、警告しています。

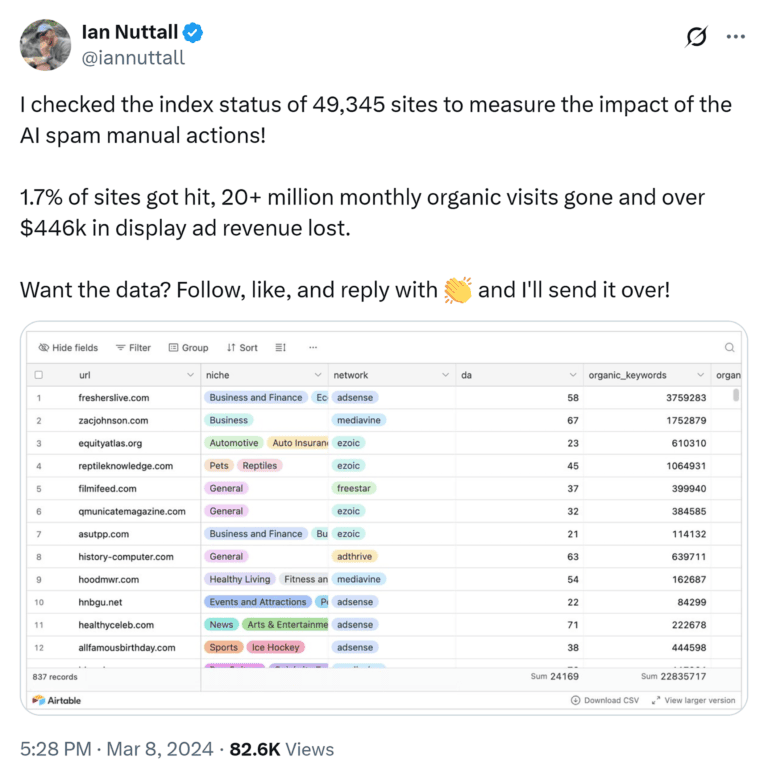

Googleは2024年3月のアップデートで、大量の低品質AI生成コンテンツをターゲットにしました。

その結果、大量のAI記事があるサイトで、インデックス削除や順位急落などの問題が発生しました。

ただし、Googleは「どのように作られたかに関わらず、高品質なコンテンツは評価する」とも述べています。

しかし、AIに出力させたコンテンツの評価は、未だグレーゾーンの域を出ません。

あなたが考える、「高品質で人間が編集したAIコンテンツ」は、Googleの考えるものと一致しない可能性があります。

また、ランキング操作のために低品質で独創性のないコンテンツをAIで作成することは避けてください。

「低品質で独創性のないコンテンツ」には以下を含みます。

- 専門家の関与なしにAI生成記事を公開すること

- 専門知識なしで記事全体を作成すること

- 検証なしに事実に関する主張をAIに依存すること

- 実質的な価値がないのにキーワードだけを狙ってコンテンツを生成すること

幸い、Googleからの評価を保ちつつAIコンテンツツールを活用する方法は数多くあります。

AIをコンテンツの制作に活かす方法として、以下が挙げられます。

- 調査論文を要約する、または重要なポイントを作成すること

- 上位表示されているコンテンツに基づいて、構成案を提案すること

- ブログ記事、メールマーケティング、ニュースレターなどの下書きを作成すること

- 明確さを向上させる、文法の問題を修正する、またはより良い表現を提案すること

- コンテンツのトピックアイデアや切り口を生成すること

重要なのはAIを土台として使い、必ず自分の経験・専門性・検証を加えることです。

これがGoogleのE-E-A-T基準を満たす鍵です。

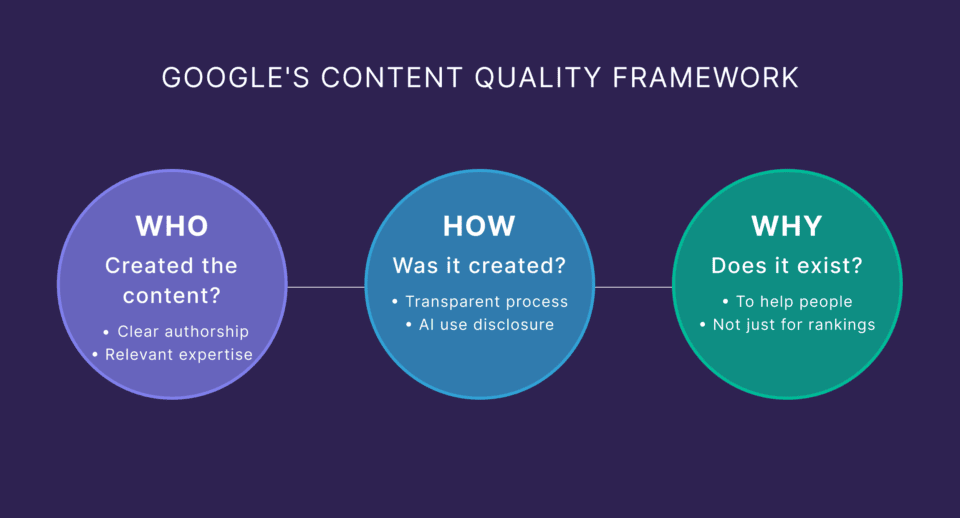

ボーナスコンテンツ:Googleの「Who-How-Why」フレームワークでコンテンツの有用性を評価してみる

Googleは、コンテンツの有用性を自己評価するために「Who-How-Why」フレームワークを推奨しています。

「誰が」そのコンテンツを作成したのか?

「Who(誰)」という質問は、専門性と信頼性に焦点を当てています。

Googleは、コンテンツの背後にいるチームについての明確な情報を確認したいと考えています。

これには、ストラテジスト、ライター、編集者、ファクトチェッカー、そして専門家レビュアーが含まれます。

- 関連する経験や資格を強調した詳細な著者プロフィールを追加する

- 読者が期待する記事には必ず明確な署名(byline)を入れる

- 署名を著者ページにリンクし、追加の背景情報を提供する

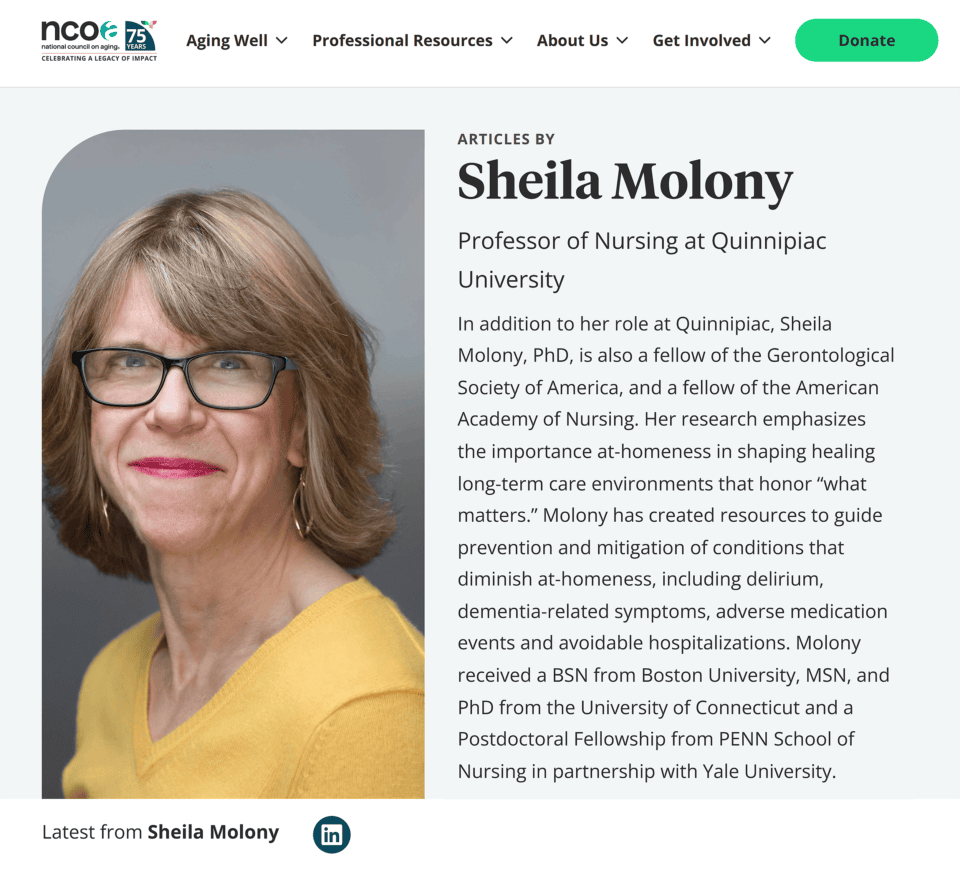

例:全米高齢者協議会(NCOA)は、医療資格や教育背景を持つ著者の情報を記事内で明確に提示し、信頼性を高めています。

そのコンテンツは「どのように」作られたのか?

「How(どのように)」という質問は、プロセスにおける透明性に関するものです。

Googleが知りたいのは次の点です。

- どのような調査やテスト方法を使用したのか?

∟テストの期間・項目・比較条件などを具体的に記載しているか?

- AI補助を使用したのか?(もし使用したなら、どのように?)

∟人間の監修は入っているか?どのような監修をしたか?

製品テストを実施した場合は、その方法論を説明してください。

単に「10個の製品をテストしました」と言うだけでは不十分です。

テストについて、具体的に説明しましょう。

例えばNCOAでは、記事ごとにテストデータを強調しています。「調査に何時間費やしたか」「何人の専門家に取材したか」を公開しています。

「なぜ」そのコンテンツが存在するのか?

「Why(なぜ)」という質問は非常に重要で、ランキングに悪影響を与える可能性が高い部分です。

コンテンツを作る目的によって、そのコンテンツが役に立つものになるか否か、ある程度判別できるはずです。

- このコンテンツは主に人々を助けるためのものですか?(良い)

- 主に検索トラフィックを集めるためのものですか?(悪い)

独自な価値を提供することなく、キーワードでの順位獲得だけを目的としてコンテンツを公開している場合、Googleはいずれそれを見抜きます。

たとえ検索エンジンが存在しなかったとしても、人々にとって価値のあるコンテンツを作成してください。

人々が直接探し求めるようなコンテンツです。

例えばNCOAのレスパイトケア(介護者の休息支援)に関する詳細なガイドは、オンラインでもオフラインでも、読者にとって価値のあるものです。

「役に立つコンテンツ」を作るフレームワークを上手に使って、価値のあるコンテンツを生み出しましょう

検索順位やトラフィック等の結果を得るためだけに、SEOのチェック項目を埋めるためだけにコンテンツを作成することはやめましょう。

検索結果で上位に表示されているサイトは、ユーザーを本当に助けているサイトです。

このガイドにある10の戦略を活用することで、Googleに本当に価値があると認めるコンテンツを作ることができます。

そのコンテンツがトラフィックを集めるのは、システムを使いこなしているからではなく、順位にふさわしい価値があるからです。

まだダウンロードしていない場合は、私たちの「役に立つコンテンツチェックリスト」をダウンロードしてください。

続いて、コンテンツギャップ分析ガイドを確認し、これらの原則を適用できる箇所を探してください。

これにより、効果を最大化するための注力ポイントがわかり、検索結果ページ(SERPs)で存在感を発揮し、次回のGoogleアップデートにも耐えられるようになります。

BacklinkoはSemrushが所有しています。私たちは、実践に基づいた世界トップレベルのSEOノウハウをお届けすることに情熱を注いでいます。特に記載がない限り、このコンテンツはSemrush Inc.の社員または外部の契約ライターによって執筆されています。

SEO Japan編集部より:

ユーザーにとって「役に立つコンテンツ」を見極め、作ることは、大変に時間と手間のかかる作業です。

それ故に、他サイトやAIには簡単に真似できない価値を生み出すことができ、検索エンジンもユーザーも、常にコンテンツにはその価値を求めています。安易に数を作るのではなく、情報にいかに付加価値を出せるのか?を考え抜いたコンテンツを作る事が求められています。

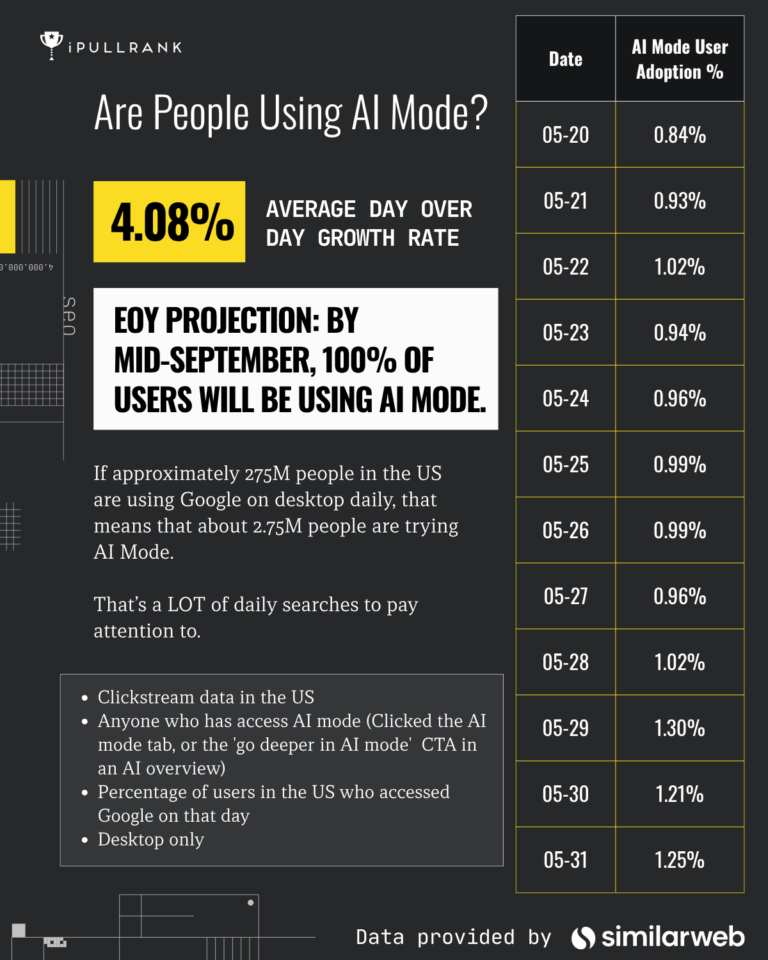

【初期データからの示唆】GoogleのAI Mode経由の流入傾向

この記事は、2025年7月3日にiPullRank社にて公開されたGarrett Sussman氏の「Referral Patterns in Google AI Mode: Understanding the Early Data」を翻訳したものです。前回投稿した「レリバンスエンジニアリング入門:検索の未来」の翻訳後、アメリカにて公開されているAI Modeの初期データをまとめた記事として、iPullRank社よりご共有いただきました。

AI Modeが、従来のGoogle検索結果のクリック率と、どのくらいギャップがあるのか、どのようにサイトが出力されるかなど、気になる方はぜひ一読ください。

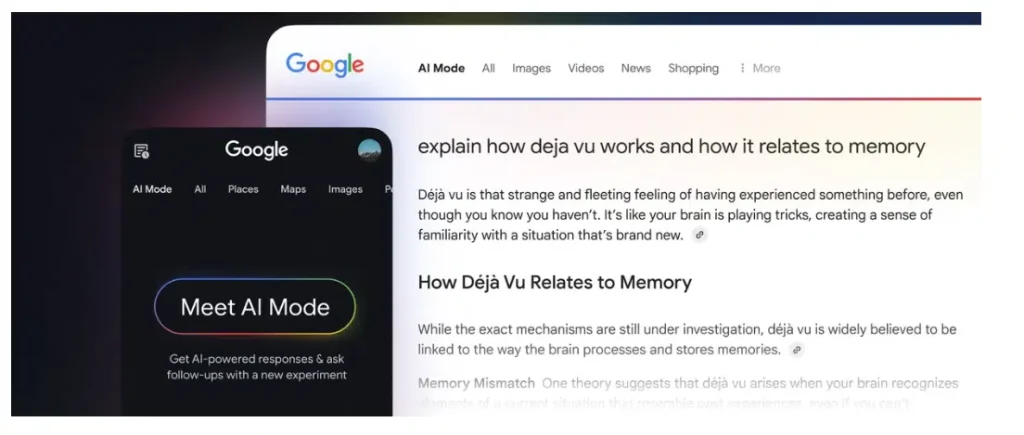

※SEOJapan補足:「AI Mode」 GoogleのAI Modeは、現在アメリカ・インドで展開されている次世代の検索体験です。従来の検索結果とは異なり、ユーザーの質問を理解して対話形式で回答を生成します。(2025年7月18日時点で日本では未展開)

AI Modeの分析に至った背景

私はあの日、ミッションインポッシブルのワンシーンのように、天井から飛び降り、スマートにGoogleのデータセンターに侵入しました。そして、昨今SEO界隈を騒がせているGoogle検索の「AI Mode」の秘密を解き明かし、ここで発表しようと思います。

・・・私がトム・クルーズだったなら、本当にそうしたでしょう。

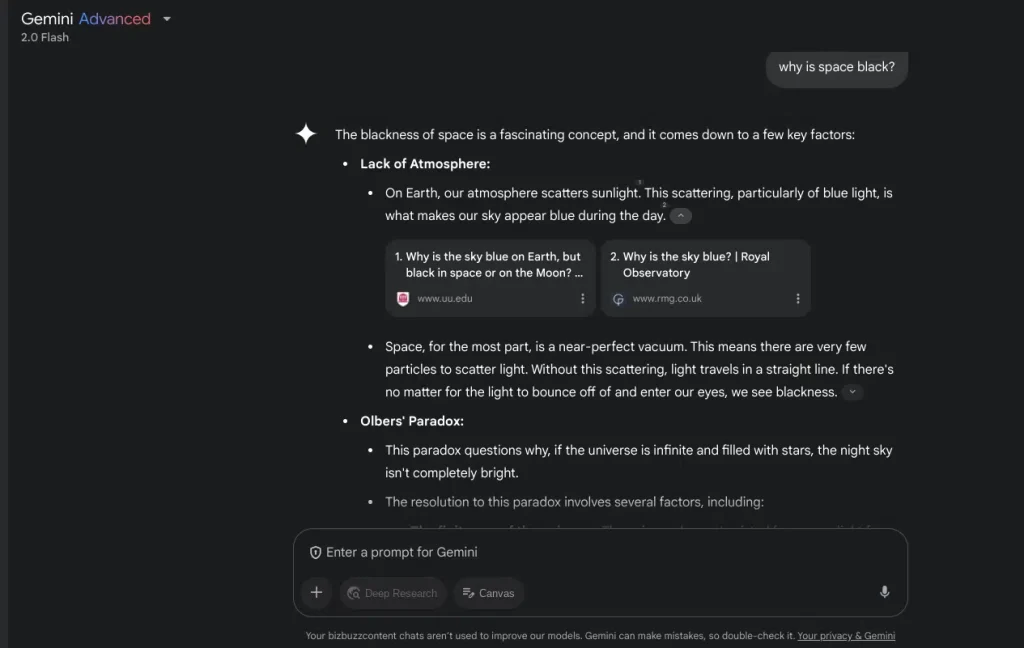

しかし私はスパイではなく、iPullRank社のアナリストです。今回、我々はSimilarweb社と共にAI Modeについて分析を行いました。

初回レポートにおいて、Similarweb社は、10万人超のAI Modeに関する日次データ(以下の指標)をElias Dabbas氏および当社チームに提供してくれました。(データ期間:AI Modeの一般公開日が行われた5月20日から6月19日まで)

- セッションあたりの検索回数

- リファラルの割合

- リファラル経由の平均滞在時間

- リファラル経由の平均ページビュー

- ユーザーあたりのセッション数

- 検索クエリの長さの平均

- ユーザー数 と アクティブ日数

- リファラルシェア

※SEOJapan補足:

リファラルの割合(リファラル経由の流入が全体に占める割合)検索クエリの長さの平均(検索時に入力されたキーワードの平均単語数、または文字数)リファラルシェア(特定のリファラル経由の流入が全体リファラル流入に占める割合)

現時点で、これらのデータを取得できるデータプロバイダー(データ提供会社)はごくわずかです。AI Mode(および他の大規模言語モデルベースのデータセット)は、分析方法において特有の性質があります。AI Modeは、出力に一定のばらつきが生じる点に加え、特定のクエリや検索意図について十分な情報が得られないため、全体傾向を捉えるような高度な分析が求められます。

人々がAI Modeを使い始めると、あらゆる検索ジャーニーは、より解析が困難で複雑になるでしょう。たとえば、私が娘のために新しい自転車を検索するときと、あなたが自宅の住宅ローンについて検索する時とでは大きく異なります。Google が検索結果のパーソナライズ化を進めると仮定するなら、特定のトピックセットを再現することは、あまりに細かく、徒労に終わるかもしれません。

つまり、私たちはある程度根拠のある仮説を立てるための傾向を探っています。また、AI Modeの結果は、従来のSEOの結果と一部重なる部分が出てくる可能性があることも、あらかじめご理解ください。

AIによって確率的な結果が導き出されるまでにはさまざまなプロセスがありますが、結局のところ、それはGoogleが検索内容に基づいて最適な答えを導き出す仕組みに加わった、ひとつの複雑な要素にすぎません。

AI Modeデータのコンテクスト化

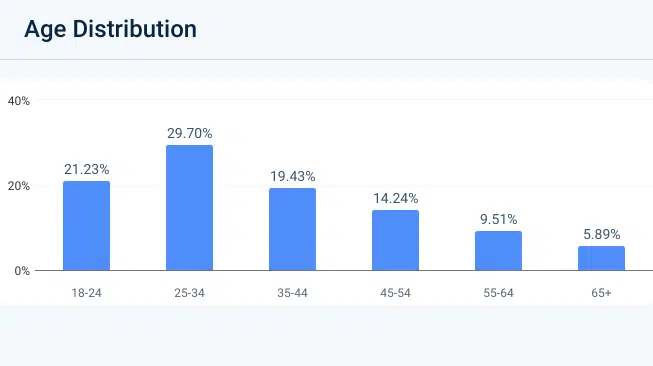

誰がAI Modeを使用しているのか?

具体的なユーザー層(デモグラフィック)に関する情報はないものの、いくつか妥当な仮説を立てることは可能です。AI Modeは、検索のデフォルトではありません(そして「デフォルト」であるかどうかは重要です)。

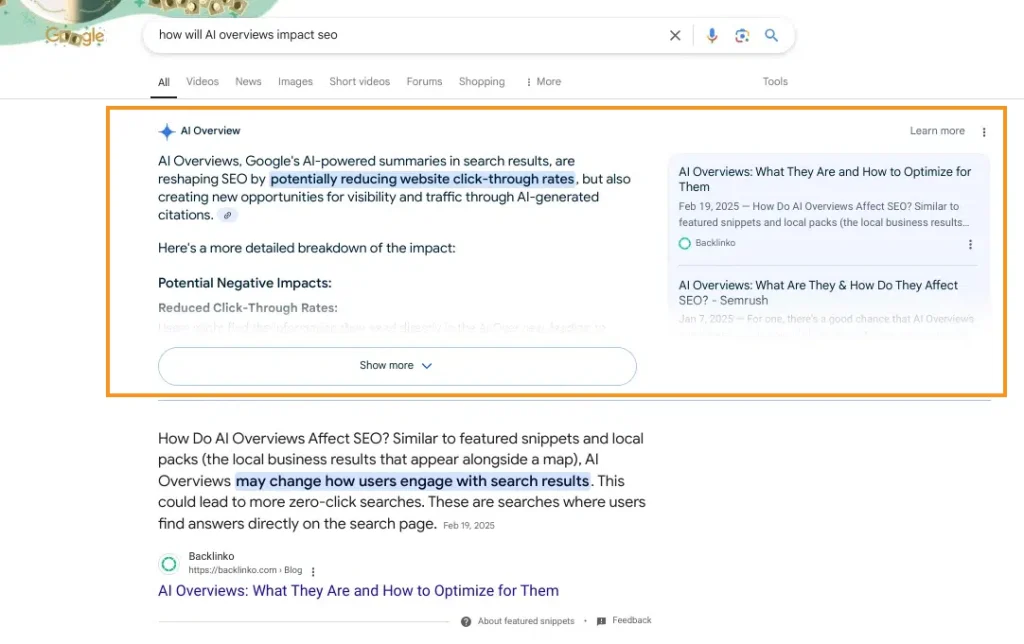

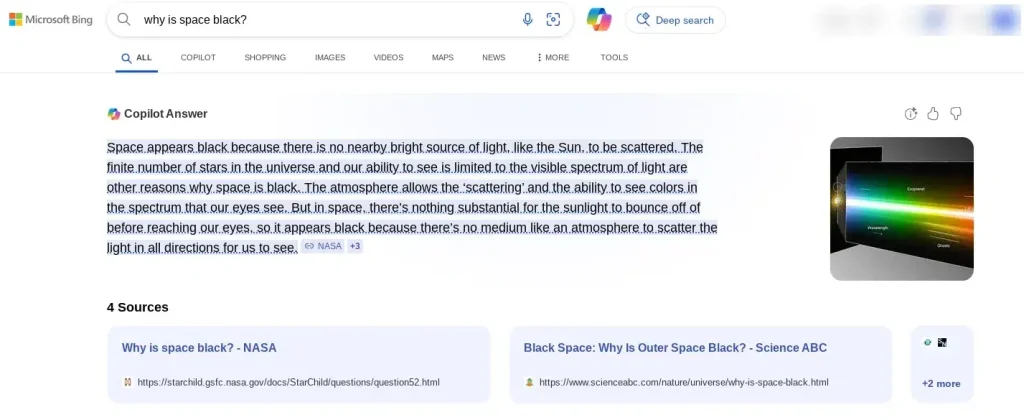

AI Overviews(AIO)がリリースされた際は、Googleの検索結果のすぐ上に配置されました。AIOは、強調スニペットよりも大きく表示され、クリックを奪い、トラフィックに影響を及ぼしました。フランシーヌ・モナハン氏 は過去数年間で50件以上のAIOに関する調査をレビューし、AIOが検索に与えた影響を明らかにしています。AIOをオフにする方法は存在しません。今では、通常の検索の50%以上に、AIOが表示されています。

それでもなお、Googleの自然検索におけるマーケティング力は損なわれおらず、Googleの衰退は大げさに語られ過ぎています。

一方で、AI Modeの使用は、検索者にとってハードルの高い状態です。AI Modeに到達するには、以下のいずれかを行う必要があります。

- デスクトップまたはアプリ版Googleのホームページにあるアイコンをクリック

- 通常の検索後に表示されるAI Modeのタブをクリック

- AIOの下部にある「AI Modeでさらに深く調べる」というリンクをクリック

これらの手順を踏んでAI Mode検索を行う人は、いわゆる通常の検索ユーザーではないでしょう。実際、Similarweb社によれば、AI Modeの初期利用率は全検索の2%未満でした。

- AI Modeをクリックしているアーリーアダプターとは誰か?

- その行動は、一般的なGoogleユーザーとどう異なる可能性があるか?

AI Modeを使用するユーザーは、「おそらくテクノロジーに関心が高く、新機能を試すのが好きな実験好き」あるいは「業界のトレンドを常に把握する必要のあるマーケター」「SEOのプロフェッショナルで、好奇心が強い人物」であると考えられます。

他にも様々な心理的タイプを持つユーザーが存在するかもしれませんが、今回のデータ分析においては、上記で挙げたタイプのユーザーを前提にインサイトを読み解くことが重要です。

関連ページ:AI Modeの仕組みと、SEOが検索の未来にどう備えるべきか

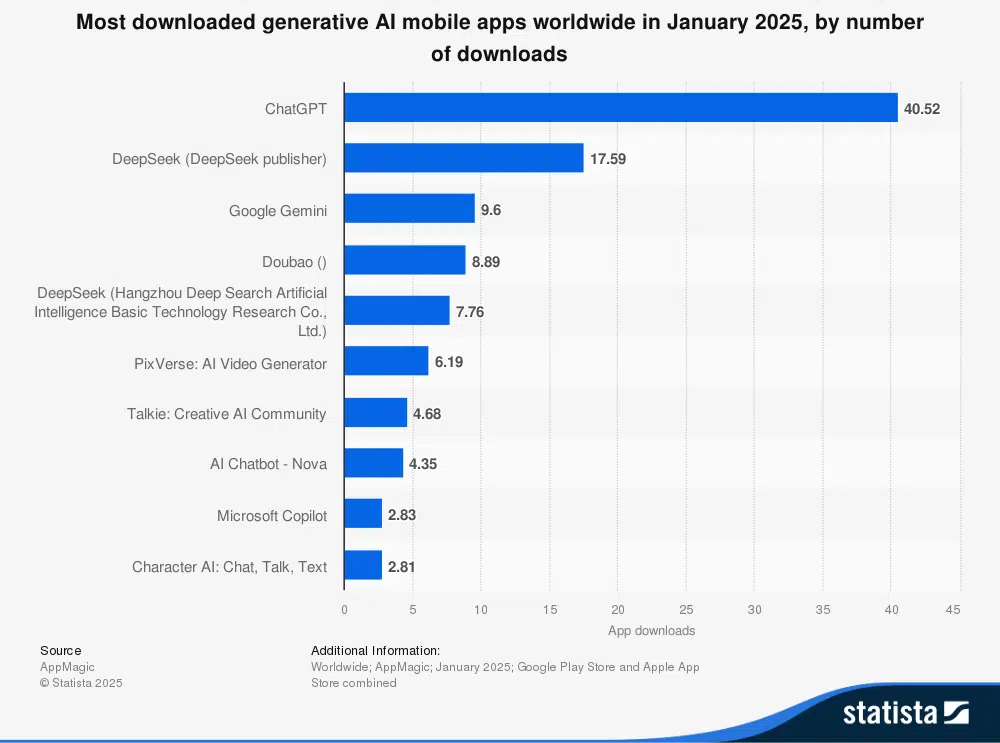

AI Modeの利用状況分析・洞察

このデータセットの中から、最も興味深いデータのいくつかを見ていきましょう。

現在、SEOおよびマーケティングチームにとって最大の関心事はトラフィックに関することです。

- AI Modeでは、従来のGoogle検索と比べてトラフィックが減少するのか?

- 従来のGoogle検索と比べて、AIモードを使ったユーザーは1回の検索でより多くのサイトを訪れるようになるのか?

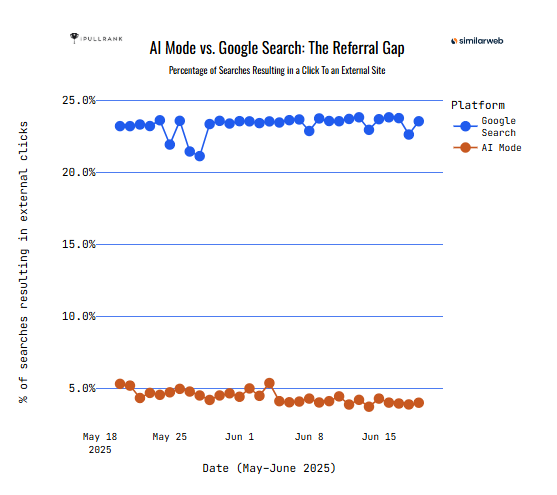

AI Mode vs. Google検索:リファラル経由の流入のギャップ

注視すると、AI Modeのセッションからの平均クリック数が大幅に減少しているという明確な傾向がわかります。

- Google検索のセッションの24%がクリックに至っている

- AI Modeのセッションの4.5%がクリックに至っている

なぜ、これほど大きな差が生じるのでしょうか?

①AI Modeの回答で満たされるケース

- AI Modeは「Query Fan-Out(クエリ拡張)※」技術を用いて、将来的に想定される質問を先回りして回答することで、より包括的かつ満足度の高い回答を提供している可能性がある。

- 問いに対する十分な回答が得られれば、サイトでさらに情報を探す必要はなくなる。AI Overviewsの導入によってクリック数が減少していることも、この点を裏付けている。

※SEO Japan補足:「Query Fan-Out」に分解し、調べ、それらの答えを組み合わせてより網羅的な回答を作る仕組み

AI OverviewsやAI Modeでの検索結果の生成に用いられる技術のこと。

ひとつの質問(クエリ)を、関連する質問(サブクエリ)

検討すべきテーマ

AI Modeで十分な回答がなれるクエリは、しばしば情報収集型や事実確認に関する検索であり、直接的な回答で充足に至るケースが多いのではないか?

②ユーザーの意図と好奇心

- 単にAI Modeを試しているユーザーは、質問への明確な回答を求めているというよりも、インターフェースを探索している可能性がある。つまり、検索よりもAI Modeそのものを試すことが目的となっている。

- ChatGPTやGeminiのような生成AIを使ったことがないユーザーが、AI Modeで「何ができるか」を試しているのかもしれない。

検討すべきテーマ

ユーザーが積極的に情報探索しているのではなく、AI Modeを試していることを示す証拠(非常に短いクエリや試験的なクエリなど)はありますか?

③デザインとUIの障壁

- AI Modeでは、生成された中にアンカーリンク(外部リンク)を埋め込む形式がテストされている。また、従来のGoogleの検索結果と比べて、リンクは目立たないサイドコンテナに配置されている。

- インターフェース自体が外部リンクを目立たなくし、クリックしにくくしている。

検討すべきテーマ

従来のGoogleの検索結果とAI Modeでは、外部リンクの可視性や目立ち方にどのような違いがあるのか?

④アーリーアダプターの行動

- 先述のとおり、AI Modeを使うユーザーは、技術に精通し、自力で回答を得ることに慣れているアーリーアダプターである可能性が高い。

- 彼らは、検索結果に表示されているページをクリックするのではなく、ChatGPTのようなツールを複数使い分けている可能性がある。

検討すべきテーマ

AI Modeのアーリーアダプターは、完結型の回答を好む傾向があるのか?それとも、複数のプラットフォーム(ChatGPTのようなツールの併用)を使って調べる習慣があるのか?

⑤信頼と権威に対する認識

- Googleから生成されたAI回答に、ユーザーが最初から信頼を置くことはあり得るのか?やや疑わしいが、もし信頼されるなら、ユーザーが情報を確認して裏付けを求める必要性は減るでしょう。

検討すべきテーマ

「情報の信頼性」や「権威性の認知」によって、クリック率の違いを説明できるのか?

⑥AI Modeでの初期検索では、購入や取引を意図した検索が少ない

- 現在AI Modeを試しているユーザーは、商用または取引的なクエリ(例:購入、比較)をあまり使っていない可能性がある。こうしたクエリでは、本来外部サイトへのクリックが多い。

- 従来の検索は取引的意図に強く使用されるため、自然にクリック率が高くなる。同様に、ナビゲーショナル(特定のWebサイトに行くことを目的とする)検索でもクリック率は高くなる。ブランドサイトに行くだけなら、わざわざAI Modeを使う理由がないのでは?

検討すべきテーマ

AI Modeにおけるクエリは、従来のGoogle検索と比べて「情報収集目的」と「商用目的」で大きく傾向が異なるのか?

以上のように、AI Modeでクリック数が少なくなる理由はいくつか考えられます。より深い洞察を得るために、以下の2つの質問が繰り返し出てきます。

- クエリの内容がわかれば、クエリの種類によって行動に違いが出るだろうか?

- AI ModeがGoogle検索のデフォルトになり、すべての人が慣れた状態になった場合、行動は大きく変化するだろうか?

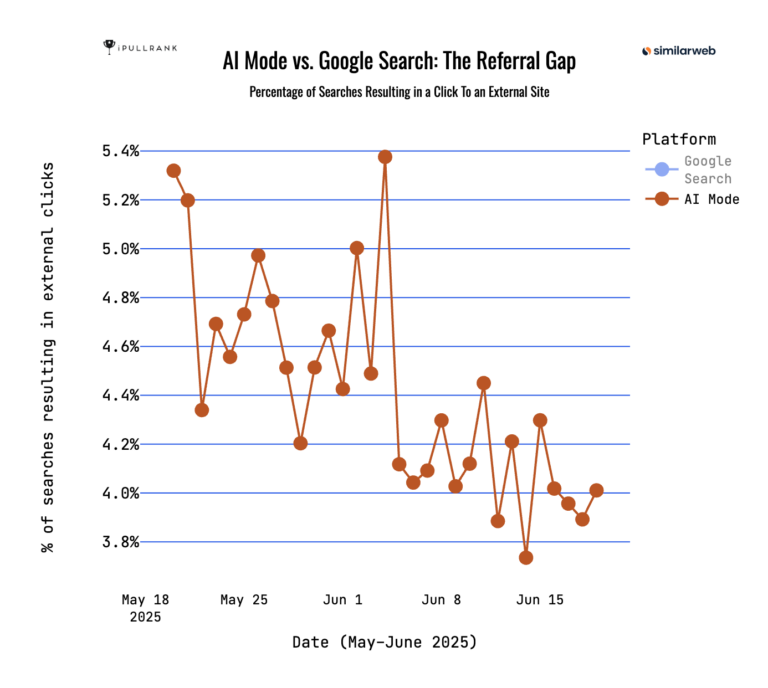

上記グラフはインタラクティブ形式(※)になっており、各データポイントにカーソルを合わせることで日別の外部リンクのクリック数差が表示されます。また、Google検索またはAI Modeのデータを非表示にすることで、AI Modeのリファラルの激しい変動を拡大して確認することもできます。

※掲載しているグラフは元記事のキャプチャです。詳細は元記事をご確認ください。

Google検索は安定している一方、AI Modeのクリック率は5.4%から3.8%までのばらつきが見られます。このクリック率の低下がトレンドを示していると結論づけるにはまだ早いものの、注視する必要はあります。そして、今後6〜12か月以内にAI Modeがデフォルトになれば、クリック率やその推移は大きく変わるでしょう。

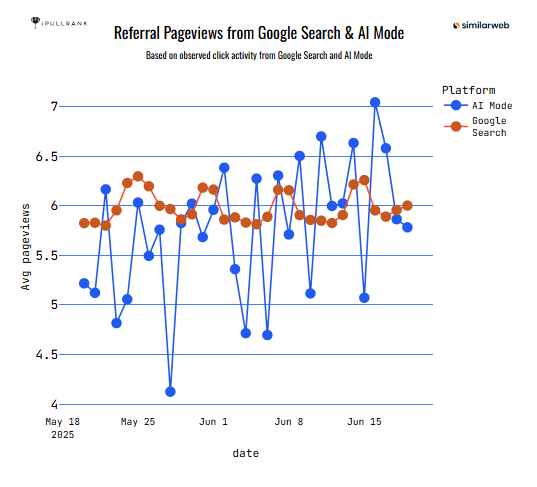

では、セッションあたりのリファラーページビュー数はどうなのでしょうか?

セッションあたりの平均リファラーページビュー数を調べてみると、興味深い2つの傾向が見られます。

- Google検索では1日あたり外部クリックが6回

- AI Modeでは1日あたり外部クリックが5.9回

2か月間の平均では、実際のクリック数に大きな差はありません。

しかしグラフを見ると、Google検索の方は比較的安定していることがわかります。週末にクリックが増え、平日を通して一貫したリファラルクリックが見られるという、よくあるパターンが確認できます。

一方、AI Modeは不安定です。明確なパターンがなく、多いときには7回、少ないときには4回と、クリック数にばらつきが見られます。やはり、初期段階のデータはノイズが多い状態です。

※掲載しているグラフは元記事のキャプチャです。詳細は元記事をご確認ください。

AI Modeのデータのトレンドの今後はどうなるか?

我々の優れたパートナーであるSimilarweb社が提供し、Elias Dabbas氏が分析した初期のAI Modeデータから、より多くの洞察を近々共有する予定です。

私たちは現在もデータを整理している最中ですが、発表予定の詳細レポートでは衝撃的な洞察が得られるはずです。それが確かなものであれば、GoogleがAI Modeからユーザーをどう誘導しているかという見方を根本から変えることになるでしょう。

今回、AI Modeについてどんな第一印象を持ったでしょうか?実際に使ってみたご自身の体験から何か感じることはありましたか?

今回提示したデータは、今後のGEO(生成エンジン最適化)やレリバンス・エンジニアリングにおいて、どのようにAI Modeを位置づけるかという点に影響を与えるかもしれません。

※SEO Japan補足:GEO:生成エンジン最適化(GEO:Generative Engine Optimization)とは、ChatGPTやPerplexityなど、生成AIを活用した検索にて、自社コンテンツが回答として選ばれるようにする情報発信手法

SEOJapan編集部より:

アーリーアダプターが利用していることが前提ですが、AIOと同様に、AI Modeでも従来のGoogle検索よりクリック率が低下傾向はあるようです。情報系の検索に関しては、クリック率の低下は一定覚悟した方が良さそうです。

一方で、AI Modeでのリンク形式やAI Modeがデフォルトになった場合では、リファラル経由の流入が増えたり、指名検索の流入が上記よりも増え、違った示唆となる可能性が残る内容でした。今後もAI Mode関連の情報があれば、積極的に翻訳していきます。

AIO(AI検索最適化)とは?SEOとの違いは?

「SEOの時代は終わったのか?」

生成AIの台頭とともに、そんな問いが飛び交うようになりました。しかし、私たちが向き合うべきは「終わり」ではなく、「進化」です。今、検索は大きな転換点を迎えており、その最前線にあるのが AIO(AI Optimization/AI検索最適化) という新たな概念です。

まだ定義も固まっておらず、LLMOやGEOなど呼称は様々です。

本記事では、AIOとは何か?SEOとの違いは?そして現場レベルで今、何をすべきか?について解説します。

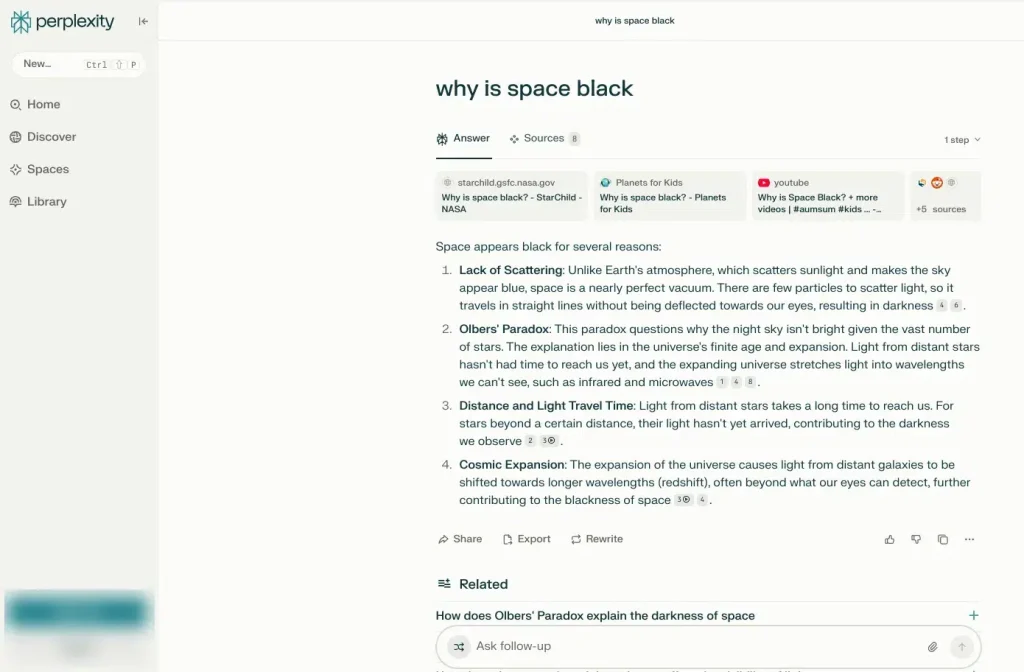

AIOとは?

AIO(AI Optimization) とは、「生成AI(LLMによるAI)を活用した検索体験において、自社のコンテンツやサービスが的確に取り上げられ、ユーザーにリーチするための最適化施策」を指します。

具体的には、以下のような検索体験に対応することが目的です。

- GoogleのAI Overviews(旧SGE)

- BingのAI Chat検索(例:Copilot)

- PerplexityなどのAI検索エンジン

- ChatGPT Plugins/Browse機能を活用したナビゲーション

- 検索意図を抽出してくるAIエージェント(AI Modeを含む)

これらのAIは従来のリンク型SERPとは異なり、「文脈理解」「要約」「推薦」を前提とした応答を返します。つまり、“クリックされる” ではなく “引用される” コンテンツが問われる時代へと突入ました。

従来のSEOとの違い

| 項目 | SEO(従来) | AIO(生成AI検索) |

|---|---|---|

| 対象 | 検索エンジンのランキング (主にGoogle) | AIによる生成検索 (Google AI Overviews, Perplexityなど) |

| 最終出力 | ブルーリンクの一覧(SERP) | 回答文・要約文・情報カードなど |

| 評価基準 | キーワードとの整合性・E-E-A-T・内部外部リンク構造など | 文脈の網羅性・自然言語での信頼性・引用しやすさ・情報の粒度 |

| ユーザー行動 | 検索→クリック→読了・CV | 検索→AI回答の中に自社情報が表示される(クリックされない可能性も) |

AIOが重要な背景には「検索行動の変化」があり

1. 検索エンジンの役割変化

GoogleやPerplexityは、従来の「リンク一覧」から「即答・要約・レコメンド」へと舵を切りつつあります。

特に2024年以降、Googleの AI Overviews(SGE) や Bingの AIチャット検索 は「検索のUX(ユーザー体験)」自体を変えていくものです。

2. 検索行動のフラグメント化

SNS検索・動画検索・ChatGPT・AIエージェントなど、検索のチャネルは多様化しています。

「どこで検索されるか?」が分散してきたため、ユーザー行動全体を捉える必要があります。

3. AIに“引用される”ことの価値

ユーザーが「このサービスが良いらしい」と思うきっかけが、AIによる「推薦文」になる可能性があります。

つまり、AIの引用=現代の“広告枠”であり、そこに入れなければそもそも競合比較の土俵にすら上がれないという構造です。

AIOで必要な対策・施策

1. “自然言語での文脈整合”を意識した構成

AIはキーワード一致よりも、文脈的な意味のつながりを重視します。

「何を伝えたい記事なのか」を一貫性ある構成で示し、自然言語で完結する記述を心がけましょう。

また、日本語の場合、”主語なし”の文章が成り立ちますが、AIが読み込む場合は主語・述語・目的語が明確な文章構造を好みます。「マシンリーダブルな文章」をやや意識する必要があるでしょう。

2. 明示的な一次情報・主観・体験談の記載

AIは中立情報を集約する傾向がありますが、ユニークな視点・主張・実体験は引用対象になりやすいです。

例:「実際に○○カードを3年間使って感じたメリット」など。

また、検索意図や各ページで理解したトピックとの計算技術も上がっており、1ページ=1テーマではなく、複数の派生したテーマを保有できるようになってきています。

水平的に散らばったトピックを横に広く記載したコンテンツよりも、深く・体験に基づいた示唆のある情報の価値を評価する傾向があります。

3. FAQ・定義・比較など“まとめ系要素”の充実

AIOにおいては、「〇〇の場合、○○でしょうか?」「○○とは、○○です」「比較ポイントのまとめ表」などが学習しやすいフォーマットとして好まれる傾向にあります。

Webページの記事構造に取り入れると有効です。

4. Schema.orgや構造化データを活用し“意味”を伝える

AIはクローラーではなく、意味解析で構造を把握するため、FAQPage/Product/HowToなどの構造化データの実装は有効と考えられます。

「マシンリーダブルなコンテンツ構造」を体現し、中でも深度のあるコンテンツが評価されていくでしょう。

5. AI検索エンジンでの“自社名の出現状況”をモニタリング

特にPerplexityやBing、AI Overviewsなどで 自社名やブランド名での応答結果 を定期チェックし、被リンク・引用元・競合との差異を把握しましょう。

言及される機会が少ない場合、指名検索やWebサイトの直接流入が知らない間に減る、といったことも想定されます。

参考:AI Mode時代のSEOと必要な施策・戦術は何なのか?

SEOは終わらず、AIOとして再構築される

AIOの時代においても、SEOの本質は変わりません。

それは「ユーザーに価値ある情報を届け、選ばれる存在になること」です。

ただし、その届け方(インターフェース)と、選ばれる基準(評価指標)がやや変わります。

SEO担当者は単にキーワードを追うだけでなく、ユーザーの検索体験全体をデザインする存在へと進化する必要があります。

AIOはSEOの終焉ではありません。むしろ、SEOの戦場が拡張されたと捉えるべきでしょう。ベースはSEOとなりますので「SEOは出遅れたけど、AIOなら巻き返せる」は難しい状況です。

検索者にとって有益なコンテンツ(わかりやすく、深い情報)を届け、顧客とのエンゲージメントを向上させていきましょう。

SEO業者の取り組みとその歴史~ブラックハットSEO・ホワイトハットSEO~

検索エンジンのアルゴリズムは、その複雑性と非公開性から、ウェブサイトの検索順位を向上させるためには専門的な知識と技術を要します。そのため、SEO(検索エンジン最適化)業者は、この難解な領域において重要な役割を担ってきました。

SEO施策の歴史は、まさにSEO業者とGoogleという二者の間で繰り広げられてきた、終わりのない攻防の歴史であると言えるでしょう。

SEO業者の取り組みとGoogleの攻防

SEOの手法は大きく分けて、検索エンジンのアルゴリズムの「抜け穴」を悪用する「ブラックハットSEO」と、Googleのガイドラインに則り、ユーザーの利便性を追求する「ホワイトハットSEO」の2種類が存在します。両者の違いは、その哲学と手法、そして結果として生まれるユーザー体験にあります。

SEOの手法は大きく分けて、検索エンジンのアルゴリズムの「抜け穴」を悪用する「ブラックハットSEO」と、Googleのガイドラインに則り、ユーザーの利便性を追求する「ホワイトハットSEO」の2種類が存在します。両者の違いは、その哲学と手法、そして結果として生まれるユーザー体験にあります。

ブラックハットSEO:アルゴリズムの盲点を突く悪質な手法

ブラックハットSEOは、検索エンジンのアルゴリズムが未成熟な時代に行われていました。

具体的なブラックハットSEOの例としては、以下のようなものが挙げられます。

クローキング(Cloaking)

クローキングとは、検索エンジンのクローラーと実際のユーザーに対して、それぞれ異なる内容のウェブページを表示させる手法です。例えば、クローラーにはキーワードが大量に詰め込まれた最適化されたページを見せ、ユーザーには通常のコンテンツを見せるといった方法が取られました。これにより、関連性の低い検索クエリで上位表示を狙うことが可能になりました。しかし、Googleは2006年のウェブマスター向けブログでクローキングを「避けるべき手法」として明確に言及し、ガイドライン違反であることを示しています。

ワードサラダ(Keyword Stuffing/Article Spinning)

ワードサラダとは、検索エンジンに特化して、関連するキーワードを過剰に詰め込んだ文章を自動生成させる手法です。意味の通らない文章でも、キーワードの出現頻度を高めることで検索エンジンからの評価を得ようとしました。これは「キーワードの乱用(Keyword Stuffing)」とも呼ばれます。Googleは、その品質評価ガイドラインにおいて、キーワードスタッフィングを低品質なコンテンツの要因として挙げています。また、AI技術の発展と共に、意味のある文章のように見せかける「記事自動生成ツール」が一部で利用されていましたが、これらもGoogleの品質ガイドラインに違反する可能性が高いです。

人為的なリンク構築(Unnatural Link Building)

SEOだけを目的に、意図的に被リンクを増やす手法です。リンクファームからの大量の低品質なリンク購入、相互リンクプログラムへの参加、記事ディレクトリへの過剰な登録などがこれに当たります。かつては被リンクの数が検索順位を決定する上で非常に大きな要素であったため、この手法は広く行われました。しかし、Googleは2012年のペンギンアップデートを皮切りに、不自然なリンクに対する取り締まりを強化しました。このアップデートは、低品質なリンクを持つサイトの順位を大幅に下げることを目的としており、リンクの「量」よりも「質」と「自然さ」を重視する方向に転換しました。

参考:ペンギンが Google のコア アルゴリズムの一部になりました

これらのブラックハットSEOの手法で一時的に検索順位が上がったとしても、そのウェブページの内容が低品質であったり、ユーザーの求めている情報と乖離していたりすれば、ユーザーは検索結果に満足せず、結果としてGoogleの検索エンジンそのものに対する期待値も低下してしまいます。

Googleは、ユーザー体験の向上を最優先事項として掲げており、こうしたユーザーのためにならないブラックハットSEOを排除するために、アルゴリズムのアップデートを何度も重ねてきました。

現在では、これらの過度なブラックハットSEOはスパム行為として厳しく認識されており、検索結果の上位に表示されることはほとんどありません。ウェブマスターツール(現在のGoogle Search Console)を通じた手動ペナルティの通知も行われるようになり、SEO業者はより慎重なアプローチを取ることを余儀なくされました。

ホワイトハットSEO:ユーザーファーストの原則に基づく正しいアプローチ

現在のSEOの主流は、Googleのガイドラインに厳密に沿い、検索ユーザーに対して真に役立つ情報を提供することを目的とする「ホワイトハットSEO」です。これは、ユーザーが検索を通じて最適な情報にたどり着けるよう支援するという、Googleの根本的な目標と完全に合致するアプローチです。

ホワイトハットSEOの具体的な取り組みは多岐にわたりますが、代表的なものとしては以下の点が挙げられます。

サイトのメタ情報の最適化

ウェブページのタイトルタグ(<title>)やメタディスクリプション(<meta name="description" ...>)を適切に設定することで、検索エンジンにコンテンツの内容を正確に伝え、ユーザーが検索結果から内容を把握しやすくします。これは、GoogleのSEOスターターガイドでも推奨されている基本的ながら重要な施策です。

ユーザーの検索意図(インテント)に沿ったコンテンツ発信

ユーザーがどのような情報を求めて検索しているのか(例:情報収集、購買検討、場所の特定など)を深く理解し、そのニーズに応える質の高いコンテンツを作成することが極めて重要です。例えば、「ベストアンサー型」の記事は、ユーザーの疑問を包括的に解決することを目指します。Googleは、検索クエリの背後にあるユーザーの意図を理解する能力を飛躍的に向上させており、E-E-A-T(体験、専門性、権威性、信頼性)の概念にも見られるように、質の高いコンテンツを高く評価する傾向にあります。

Googleが掲げる「検索体験の満足度向上」というユーザーファーストの方針は、今日のSEO施策における最も重要な指針です。いかにこの点を押さえ、ユーザーにとってより良い検索体験を提供できるかどうかが、今後のSEO施策における成否を分ける重要なポイントとなります。

SEO業者はもはや、アルゴリズムの抜け道を探す役割から、ユーザーのニーズを満たし、質の高いコンテンツを提供することでウェブサイトの価値を高めるコンサルタントへとその役割を変化させています。

Googleのアルゴリズムは常に進化し、ユーザーの利便性を追求する方向に進んでいるため、SEOもまた、その変化に適応し、本質的な価値提供に焦点を当てる必要不可欠な取り組みと言えるでしょう。

レバレンスエンジニアリング入門:検索の未来

この記事は、2025年 5月 8日に ipullrank で公開された Francine Monahan氏の「An Introduction to Relevance Engineering: The Future of Search」を翻訳したものです。

検索の次なるステージでは、「どんな種類の検索結果にも自然に表示される、関連性の高いコンテンツ」を“設計(エンジニアリング)”することが求められます。

企業は、生成AIをはじめ、TikTok、Amazon、さらにはアプリストアまで、あらゆるチャネルでの“見つけられやすさ=可視性”を確保しなければなりません。

それぞれのチャネルには固有の特徴がありますが、すべてに共通するのが「関連性(Relevance)」です。

レバレンスエンジニアリング(検索エンジンやAIにおける可視性を“エンジニアリング=設計課題”として扱う手法)は、現代の検索とAIシステムでの可視性を「最適化」という枠組みではなく、エンジニアリングの問題として扱います。

「最適化」ではなく「エンジニアリング」という考え方が適しているのは、何かを調整するよりも、何かを構築しなければならないことが多いからです。それがソフトウェア、コンテンツ、またはインターネット全体での関係であっても、すべてエンジニアリングの一形態として捉えるべきなのです。

AI OverviewsからYouTubeのアルゴリズムまで、ほぼすべてのオーガニック検索システムは、視聴時間、滞在時間、離脱率などの行動シグナルに依然として大きく依存しています。しかし、検索結果として表示されるものは変化しています。検索エンジンは今やクエリ(検索語句)をセマンティック(意味的)に展開し、トピッククラスターを活用しています。それでもSEO業界は、時代遅れのフレームワークに戦略を無理やり当てはめ続けています。

ほぼすべての検索が今や生成AIを使用しているため、このエンジニアリングプロセスはどこでも機能します。

例えば、YouTubeに関しては、動画内の画像や動画で話されている内容の最適化は、依然としてユーザーインタラクション(視聴時間、離脱率など)に大きく依存しています。これはオーガニック検索の仕組みでもありますが、標準的なSEO作業だけでは十分ではありません。

従来型のSEOは、もはや実際には機能しない、また検索エンジンが現在使用していないフレームワークに、すべてを当てはめ、押し込もうとし続けています。

これまでの自然検索では、ページ上の特定のキーワードを探してSERP(検索結果ページ)でのランクを決定するため、一部の無関係なコンテンツが高いエンゲージメントを獲得し、良いパフォーマンスを示すことがあります。一方AIは関連性のあるソースから特定の文章やフレーズを探します。そして、それらを見つけるためにサイトの深くまで入り込みます。実際、Google AI Overviewsの引用の82%は深いページから来ています。

これは何を意味するのでしょうか?私たちはもはや単にコンテンツを最適化するだけではいけません。エンジニアリングする必要があるのです。

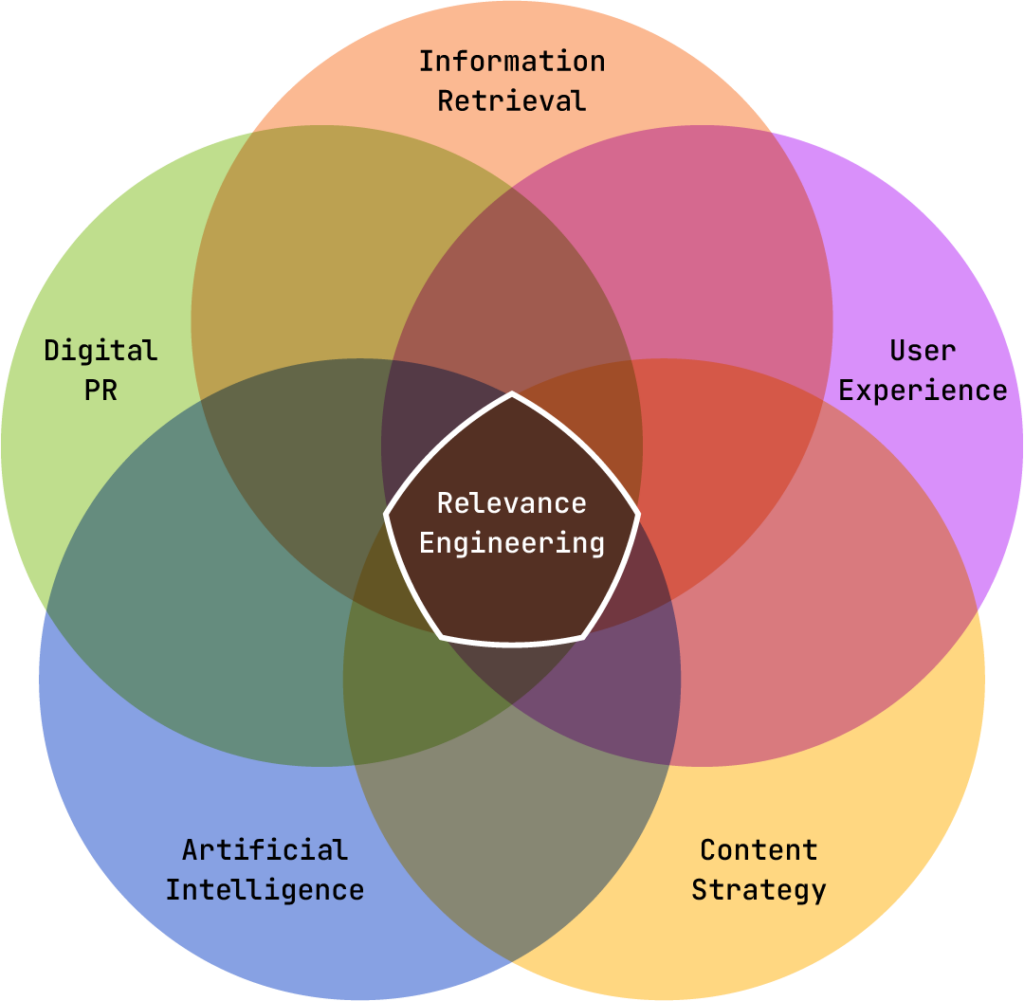

レバレンスエンジニアリングとは何か?

レバレンスエンジニアリングとは、あらゆる検索環境での“可視性”を高めるための、技術と理論の融合です。

情報検索(Information Retrieval:大量の情報の中から関連するものを探す技術)、ユーザー体験(UX)、人工知能(AI)、コンテンツ戦略、デジタルPR(広報活動)の交差点にあるこの考え方は、検索のあらゆる局面において役立ちます。

言い換えれば、これは会社のブランドを構築し、顧客や見込み客のために役立つコンテンツを作成し、わかりやすく、アクセスしやすく、検索者がリピートしたくなるようなサイトを設計するという、長年にわたるSEO担当者のすべての努力の集大成なのです。

これまで私たちが「良きWebサイト」を作るためにやってきた事の延長線上に、レバレンスエンジニアリングはあります。

生成AIを活用した検索(AI Overviews、Perplexity、Geminiなど)の登場により、検索は今や「クリック不要の回答セットをその場で提供する」形に進化しています(これを“強化版スニペット”と呼ぶ人もいます)。

これはSEOの日常的な仕事と生活にどのような影響を与えるのでしょうか?典型的な過去のSEO思考を変える必要があります。ページタイトルやH1タグでキーワードを使用し、常により多くのリンクを構築するといった要素は、生成AI環境では重要ではありません。あなたが実際に行っていることが針を動かすかどうかを検証するために、より技術的な理解が必要です。

レバレンスエンジニアリングは、関連性を定量的で測定可能なものに変えます。

SEOはしばしば曖昧な情報や、Google検索の仕組みについて研究している誰かの意見を参考に実施されますが、レバレンスエンジニアリングは、検索へのより科学的なアプローチ方法です。

しかし、レバレンス(関連性)は主観的ではないため、私たちのツールにはレバレンススコア(関連性を測る指標)が必要です。

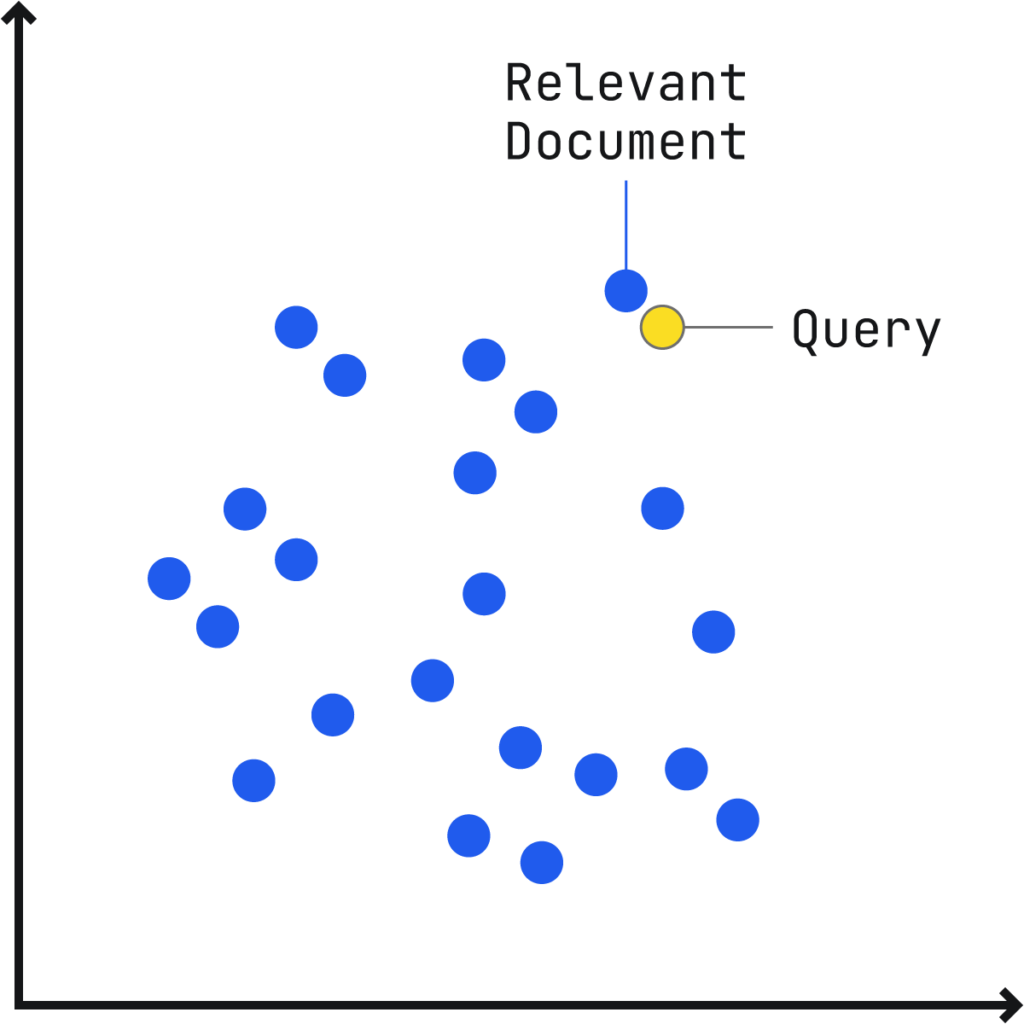

会話型検索(Conversational Search)は主に関連性を重視し、数学的にスコア付けできます。

従来の検索と同様に、検索クエリと関連する文章のつながり(文書)を「多次元ベクトル空間(Multidimensional Vector Space)※」にプロット(配置)し、文書ベクトルがクエリベクトルに近いほど、関連性が高くなります。

※SEOJapan補足:「多次元ベクトル空間」

検索語と文章の内容をそれぞれ「地図の上の点」のように配置し、その距離の近さで関連度を測る仕組みのこと(これを“ベクトル空間”と呼びます)。「意味が似ているほど近くに置かれる」ことで、AIが「この文章はこの質問にピッタリだ」と判断できる。

HubSpotが2005年に「インバウンドマーケティング」という言葉を作ったとき、彼らは孤立して機能すると考えられることが多いチャネル(ブログ、SNS,メールなど)を常に連携させるべきであると提唱しました。

同じように、私たちも「レバレンスエンジニアリング(関連性設計)」という新しい枠組みを提示し、それに取り組む人々は、複数の専門分野にまたがってスキルを高めていくことが求められています。

これまでのSEOの専門家たちは、ベストプラクティスには詳しく、検索エンジンの「熟練ユーザー」ではありました。しかし、現在の「SEO」という言葉は非常にあいまいで、Googleが新しく発表した技術や概念は、すべて自動的に「SEOの仕事」に分類されてしまう傾向があります。

そのため、「レバレンスエンジニアリング」は、従来のSEOを超えて、情報検索・UX・AI・コンテンツ戦略・デジタルPRなど複数の領域を横断した新しいフレームワークとして位置づけられるのです。

また、レバレンスエンジニアリングは、コンテンツをマーケティング戦術ではなく科学的システムの一部として扱い、品質をその中核的方法論に組み込みます。

SEO業界で多くの人が「コンテンツ戦略」と呼ぶものは、実際には理論上だけで組み立てられ、実務には落とし込まれない複雑な計画にとどまることがしばしば見受けられます。

これに対して、レバレンスエンジニアリングは、すべての作業が明確な目的のもとに機能するようなワークフローを取り入れています。そして、これまで行き当たりばったりで進められてきたプロセスに、工学的な規律と科学的な厳密さをもたらすのです。

具体的には:

- 情報は、ユーザーにとって直感的に理解できるような構造で整理されます

- コンテンツに関する意思決定は、測定可能な目標に基づいて行われます

- 成果は、個人的な印象ではなく、体系的に分析されます

- 成功パターンは再現可能であり、拡張することができます

EEAT時代のレバレンスエンジニアリング

レバレンスエンジニアリングは、コンテンツの可視性を高めるための、構造的かつAIを活用した新たなアプローチです。前述のとおり、この手法は【ユーザーエクスペリエンス】、【人工知能(AI)】、【コンテンツ戦略】、【デジタルPR】、【SEO】、そして場合によっては【オーディエンス調査】といった複数の分野を統合し、ユーザーの期待と検索エンジンの評価基準の両方に沿ったコンテンツを設計していきます。

なお、オーディエンス調査がすべての最適化に必須というわけではありませんが、多くのSEO実務者が軽視しがちな非常に重要な要素です。なぜなら、ユーザーの意図を正確に理解することが、真の意味での「レバレンス(関連性)」を実現する上で不可欠だからです。

Googleが重視しているEEAT(Experience, Expertise, Authoritativeness, Trustworthiness:経験・専門性・権威性・信頼性)の観点からも、レバレンスエンジニアリングの手法は、単なるキーワードマッチングを超えた次元へと進化しています。Googleは、ベクトル埋め込み(vector embeddings)と呼ばれる技術を用いて、著者・ウェブサイト・エンティティ(≒明確に識別可能な情報の単位)などのレベルで評価指標を測定し、各ページがユーザーの期待にどの程度応えているかを数値的に判断しています。

たとえば、スニーカーに特化したサイトが、突然バナナに関するコンテンツを掲載し始めた場合、サイトのテーマに一貫性がなくなり、それは「フォーカスの薄さ」として認識され、検索エンジンから「無関係な情報源」とみなされるおそれがあります。同様に、戦略の裏付けもないままAI生成コンテンツに過度に依存すると、Googleのアルゴリズムからネガティブな評価を受ける可能性があります。

ここで誤解してはならないのは、EEATが単に「著者の経歴」を評価する仕組みではないということです。実際、Googleはウェブ上に存在する著者の情報をモデル化し、各著者に対してベクトル(数値的表現)を作成。それを使って、他の著者と相対的に比較しようとしています。

さらに、Googleはウェブサイト単位でもベクトルを生成します。これは、サイト内の各ページをベクトル化し、それらを平均してサイト全体のベクトルを導き出すという方法です。著者に対しても同じ処理が行われ、彼らが書いた全コンテンツを収集し、そのアウトプット全体をベクトル平均で表現するのです。

もちろん、著者紹介ページそのものが無価値というわけではありません。特定の人物として他の執筆者と差別化を図るうえでは、有効に働きます。しかし、本質的な価値は「特定のトピックについて十分な量のコンテンツを書いているかどうか」にあります。たとえば100本の記事のうち60本がSEOについて書かれていれば、数学的に見てその著者は「SEOの専門家」と分類されるわけです。

EEATという言葉は非常に抽象的であり、Googleが実際に行っていることの全体像を表している一方で、SEO業界ではこの概念の理解が単純化されすぎており、かえって誤解の温床になっています。もともとSEOは、技術的な仕組みを理解するウェブマスターや開発者たちの領域でしたが、最近ではテクニカルSEOやリンクビルディング、コンテンツSEOといった細分化された専門分野が生まれた結果、検索エンジンの仕組みを包括的に理解していない人が増えています。こうした分断は、レバレンスエンジニアリングの領域では起こりません。

レバレンスエンジニアリングでは、AIによる分析を活用し、コンテンツ戦略を実行する前の段階で、その施策が成功するかどうかを予測します。これは、Googleが内部で関連性を評価するために使用している可能性のあるロジックに似ており、公開されているツールを通じて実用的にも活用可能です。

たとえば、ターゲットトピックとのコサイン類似度(cosine similarity)※が低いコンテンツを公開したり、トピック的に整合性のないサイトからの被リンクを追求したりするようなことは、もはや行わないでしょう。このようなデータ主導型のアプローチは、これまでのSEOが依存してきた“推測”や“経験則”を最小限にとどめ、マーケターがより精密に、そして確実に成果を得られるよう最適化を進めていくための道を開きます。

※SEOJapan補足:「コサイン類似度」

「コサイン類似度」とは、「2つのベクトルがどの程度同じ方向を向いているか」を角度で測る指標のこと。自然言語処理の分野では、単語や文章の意味の近さを数値化する際に用いられる。

Google検索は悪化しているのか?

ドイツの研究者たちが、1年にわたるGoogle検索の縦断的調査を行った結果、アフィリエイトマーケティングを主目的としたSEOコンテンツが検索体験を悪化させているという実態が明らかになりました。

この種のコンテンツは、ユーザーの役に立つかどうかよりも、お金を稼げるかどうか(マネタイズ)を優先して作られているのが特徴です。研究によれば、現在の検索結果の多くは、ユーザーにとって本当に有益かどうかよりも、検索順位を上げることだけを目的に作られた商業的に最適化されたコンテンツに占められているとのことです。

Googleとしては、高品質で関連性のあるコンテンツと、単にトラフィックを集めるだけのページを見分ける必要があります。

Googleは「人間のために作られたAI生成コンテンツなら問題ない」と公言していますが、実際には“良いAIコンテンツ”と“悪いAIコンテンツ”を大量に区別することが非常に難しいという課題があります。従来型のランキングシグナル(被リンクなど)も依然として使われていますが、「ユーザーが検索体験を成功と感じたかどうか」などの行動指標が、品質を評価するうえでますます重要になってきています。

とはいえ、GoogleがAI生成コンテンツを検出する試みは、まだまだ信頼性に欠けています。たとえばOpenAIは、かつて提供していたAIテキスト検出ツールをわずか25%の精度しかなかったために撤廃しました。他の類似ツールも、本物の文章をAIと誤判定したり、AI文書を見逃したりするといった誤検出が頻発しています。

この不確かさのせいで、実際には学生のレポートがAI検出ツールにかけられて「AIが書いたもの」と誤って判断されてしまう事例も起きています。AIによるコンテンツ生成の検出は今も大きな課題であり、モデルが進化するスピードに対して、検出手法はすぐに陳腐化してしまいます。

こうした問題に対応するには、GoogleはAI検出のみに頼るのではなく、もっと多層的で頑健な評価手法に進化させていく必要があります。検索品質を維持するには、低品質なコンテンツを正しくフィルターし、ユーザーのニーズに合ったコンテンツを正確に見極めることが求められています。

その一環としてGoogleは、検索品質評価ガイドラインを更新し、スパムの定義を拡大しました。これにより、いわゆる「低品質コンテンツ」や、誤解を招いたり誇張された主張を含むページに対しても、価値の低いコンテンツとして対応できるようになりました。

構造化データの重要性

検索エンジンがAIや機械学習への依存を強める中で、構造化データの役割はこれまで以上に重要になっています。構造化データは、検索エンジンが情報を理解・分類・関連付けしやすくするための仕組みであり、コンテンツをユーザーにとってよりアクセスしやすく、関連性のあるものにする手助けをします。

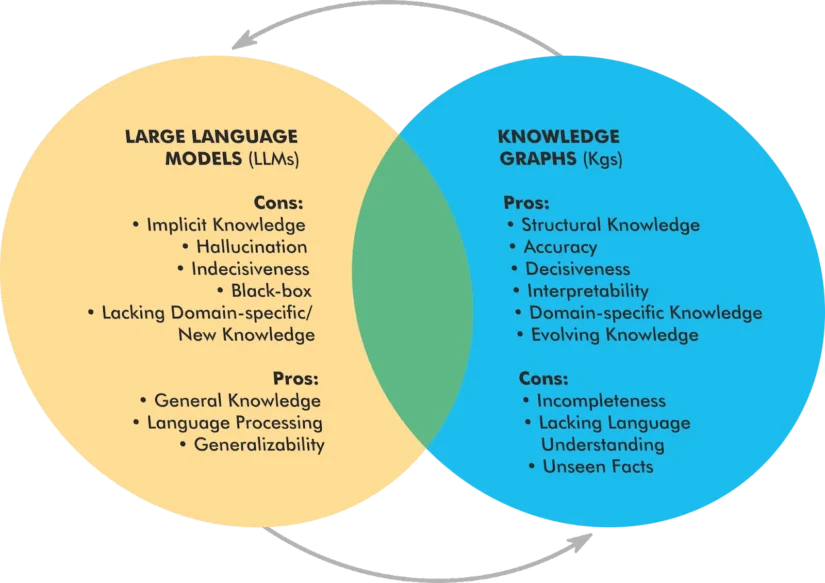

データを機械が読み取れる形式で整理することで、企業は検索結果や音声検索、さらにはAIによって強化されたあらゆる体験において、自社の可視性を高めることができます。

最近の技術進展により、構造化データはAIと並行して進化していることが明らかになってきました。特に、ナレッジグラフ(Knowledge Graph:KG)※と大規模言語モデル(Large Language Models:LLM)を統合する以下の3つの新しいモデルの登場が注目されています。

※SEOJapan補足:「SEOにおけるナレッジグラフ」

SEOにおける「ナレッジグラフ」とは、Googleなどの検索エンジンがウェブ上の情報を「人・場所・物事」などの“実体(エンティティ)”として整理・理解し、それらの関係性を構造化してデータベース化したものを指します。

参考:ナレッジグラフとは?3分で分かるナレッジグラフ講座

この多層構造のシステムでは、LLMとナレッジグラフが動的に連携しながら、それぞれの強みを活かして知識の検索精度や推論力を高めていきます。

このように、構造化データを活用することは、検索可視性の向上だけでなく、AI主導の検索環境におけるコンテンツの将来性を保証することにもつながります。Googleの検索アルゴリズムが今後さらにLLMを取り入れていく中で、構造化データはコンテンツを正確に解釈し、文脈的に適切に処理するための鍵となるでしょう。

構造化データの活用により、企業は従来の検索における可視性向上だけでなく、AIを活用した新しい検索環境においても競争力のあるコンテンツを提供し続けることが可能になります。Googleの検索アルゴリズムが今後ますますLLMとの統合を進めていく中で、構造化データは、コンテンツを正しく解釈し、文脈的に関連性があることを保証する上で、さらに重要な役割を果たすようになるでしょう。

関連性を設計するという考え方

自社ブランドのコンテンツをより目立たせ、AIと対立するのではなく協調して機能させるためには、他にもさまざまな工夫があります。

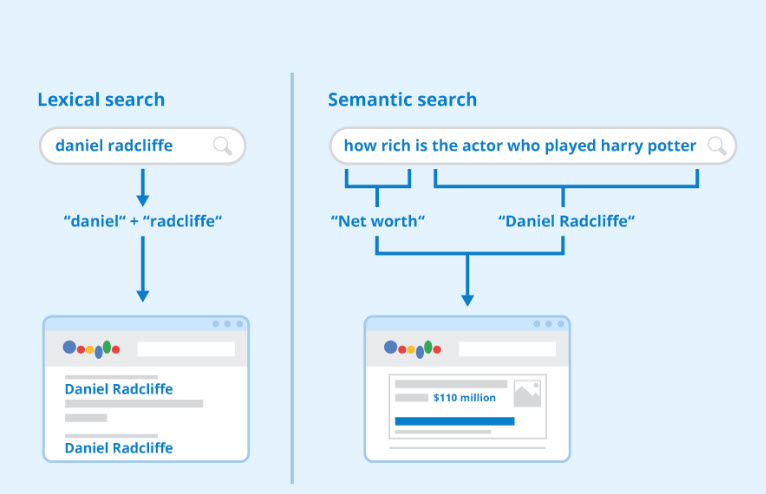

Googleは約10年前、ハミングバード(Hummingbird)アップデートによって検索エンジンの仕組みを「語彙的検索(lexical search)」から「意味的検索(semantic search)」へと転換しました。しかし、それ以降の多くのSEOソフトウェアはこの変化に追いついていません。

語彙的検索とは、単語の出現や分布をカウントするモデルです。一方で意味的検索は、言葉の「意味」を捉えることを重視しています。この意味的検索の基盤となったのが、Word2Vec(単語の意味をベクトルで表現する手法)です。

語彙的検索対セマンティック検索

フラグル(Fraggles)の重要性

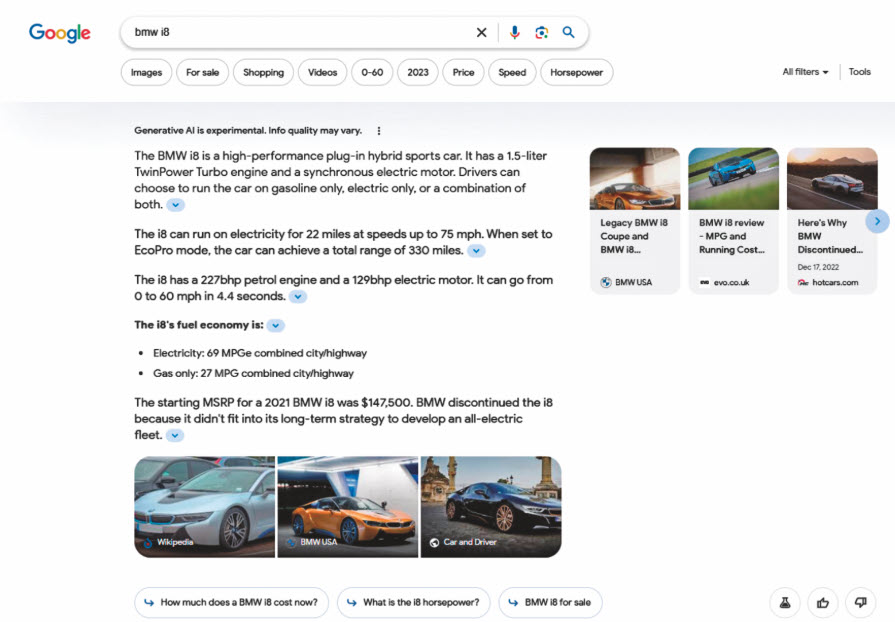

AI Overviews(GoogleなどのAIが生成する検索結果の要約)に表示されるための鍵となるのが、フラグル(fraggles)と呼ばれる要素です。フラグルとは、AI Overviewsを構成する断片的な文章のことを指します。

たとえば、検索結果(SERP)内のAI Overviewsには、Webサイトから切り出されたフレーズ(フラグル)が使われています。

あなたのWebサイト上のコンテンツが、特定の質問に対するシンプルで分かりやすいフレーズとして整理されている場合、それがAI Overviewsに採用される可能性が高まります。

コンテンツの関連性を高めるためのセマンティック提案

AI検索において表示される可能性を高めるために、以下のようにコンテンツを構造化することが効果的です。

コンテンツを意味単位で明確に構造化する

内容を明確に定義されたトピックごとに、簡潔な段落やセクションに分けましょう。長すぎる段落は複数のアイデアを混在させ、ベクトル化された意味が曖昧になります。通常、50〜150語程度の短い段落が、意味的に明確なアイデアを捉えやすくなります。また、見出しや小見出しを使ってセクションを区切ることも重要です。

意味的3要素「主語-述語-目的語」の明確な文構造を使用する

埋め込みモデル(embedding model)は、コンテンツ内に明示された関係性をもとに意味を捉えるため、こうした文構造は検索精度や関連性の向上に効果的です。

豊富な文脈キーワードやエンティティを組み込む

関連するキーワードや同義語、実在のエンティティ(固有名詞・概念など)を積極的に明示しましょう。これにより、検索でのヒット率や引用される可能性が高まります。

独自で高度に特化した、または限定的なインサイトを提供する

オリジナルのデータや独自視点の情報は、あなたのページが信頼性の高い情報源として引用される可能性を高めます。

曖昧な表現を避ける

はっきりとしたシンプルな文章は、ノイズを減らし、検索精度の向上に繋がります。

SEOの未来はレバレンスエンジニアリングへ

検索技術が進化する中で、レバレンスエンジニアリングは、コンテンツがユーザーの意図と検索エンジンの評価基準の両方に合致することを保証するために不可欠なアプローチとなっています。

EEATの重視、AIによるコンテンツ生成、構造化データの普及といった潮流は、推測に頼るSEOから、科学的かつデータに基づいたSEOへと移行する必要性を示しています。

一方で、検索品質の低下に対する懸念も残っています。たとえば、SEO主導のアフィリエイトコンテンツの増加や、AIによる「ハルシネーション情報」、そしてAI生成コンテンツの検出の難しさといった問題です。

Googleは、こうした課題に対応するために、従来のランキングシグナルに加え、ユーザーのエンゲージメント(検索体験が成功したかどうか)や構造化された知識に基づいて、より高度な評価指標を導入しつつあります。

SEOJapan編集部より:Webサイトをより良いものにするために、目指すべきゴールや本質はこれまでと変わっていません。その過程として意識すべきものが「レバレンスエンジニアリング」として、言語化されたと捉えられます。また、再現性の高いフレームワークが出来上がるということは、この先にコモディティ化が待っているということでもあります。

AI時代において、我々SEO担当者は新しいフレームワークに適応し、実践する能力が求められます。

【2025年版】SEOとは? 企業が実施するSEOの目的・内容とメリット・デメリット

SEOとは、検索エンジンで上位に表示されるようWebサイトを最適化する取り組みです。近年はAI Overviews(旧SGE)などの生成AIによる検索結果表示が進化し、従来の順位よりも「AIに引用されやすい情報設計」が重要になっています。キーワードだけでなく「意味」や「構造」、そして「信頼性」がSEO成功のカギです。

Googleの生成AI 機能『AI Overviews』がデフォルト表示になり、従来の“順位”だけでなく『AI 回答に引用されるか』もSEO成果を左右します。

参考:AI Mode時代のSEOと必要な施策・戦術は何なのか?

SEOとは

SEOは「検索エンジン最適化」Search Engine Optimizationの略称です。

検索エンジンのしくみ、検索エンジンの動作を決定するコンピュータプログラムのアルゴリズムを理解し、ランキングの向上、検索エンジンの認知度の向上、自然検索の流入拡大の為に必要な技術的手法であり、マーケティングプロセスです。

「SEO対策」とは、一般的に検索エンジンへの最適化によりサイトを検索結果で上位表示させるための、様々な施策のことを指しています。

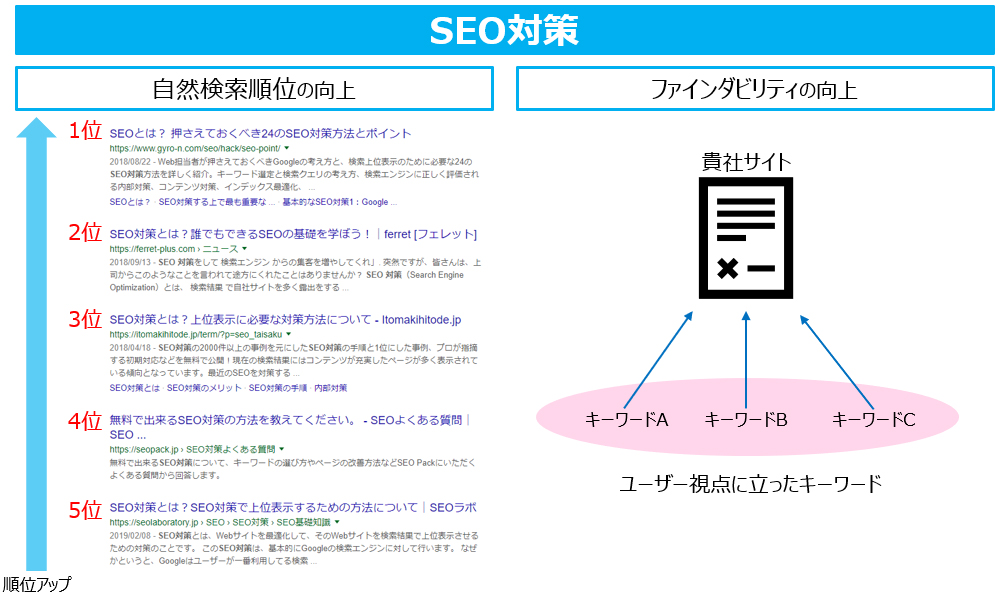

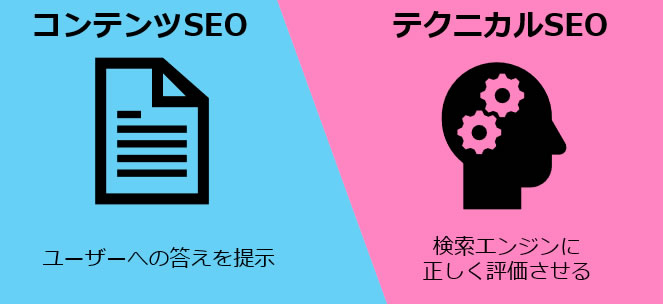

SEOの目的は、順位向上と検索結果上での見つけやすさ向上による事業への貢献

SEOを行うモチベーションは、多くの場合、サイトにユーザーを集客し商品購入などのアクションを行ってもらうことです。

なぜなら、サイトを作成しSEOが成功した場合、ある程度放置をしてもユーザーのサイト訪問が期待でき、継続的な収益が見込めるからです。 SEOを成功させてサイトの価値を高めることは、貴社ビジネスの成長に大きく貢献するでしょう。

サイトの価値の高め方 サイトの価値を高めるためには、2つの考え方があります。

検索順位を高めることで検索エンジンからアクセス数を増やす

検索結果の表示は「広告枠」と「自然検索(オーガニック検索)枠」に分かれており、SEOは「自然検索枠」における露出を高める、つまりは上位表示させるために行う施策です。

自然検索での順位が高ければ高いほど検索ユーザーのクリック率が高まるため、Googleなどの検索エンジンの検索結果でより上位に表示させることにより、自社サイトへとアクセスするユーザーを増やすことができます。

参考:SEMとは?SEO・リスティング広告との違いや使い分けて成果を出すコツ

見つけてもらう「ファインダビリティ」の向上

SEOでは、指標として利用しやすいということもあり、特定のターゲットキーワードの順位が気になるものです。 ここで、SEOの本来の目的は何か?ということを考えてみましょう。

あなたはなぜサイトを運営し、SEOによって集客したいと考えているのでしょうか?

それは、ユーザーにウェブサイトを見つけてもらい、ウェブサイトに来てもらうことです。この見つけてもらいやすさのことを「ファインダビリティ」といいます。

単なる順位上昇と何が違うの?と思うかもしれません。

SEO Japanの例

当SEOJapanを例にしてみます。当サイトではSEO関連、コンバージョン改善を中心としたコンテンツを発信しています。ターゲットとしているビッグキーワードは「SEO」や「SEO対策」です。

「SEO」や「SEO対策」といったキーワードを狙うだけなら、それらの順位上昇に寄与するキーワードのみでコンテンツを発信すればいいのですが、当サイトとしては、他にもユーザーが知りたいと考えているであろう有益な情報を発信したいと考えています。

そのため、単に自社のことだけを考えたSEO用のコンテンツだけではなく、SEO会社として発信すべき情報が何かを厳選し、ユーザーが検索するであろうキーワードを用いてコンテンツを作成しています。結果として、「SEO」や「SEO対策」以外のキーワードでも流入を獲得できており、ファインダビリティの向上につながっています。

この施策のメリットは、ビッグキーワードを狙うわけではないため、順位上昇が比較的容易なことです。また、まだ世の中にないキーワードを作成して社会に認知させていきたいという場合も、このファインダビリティの考え方は有効です。

デメリットは、ビッグキーワードの順位上昇に貢献しにくいことと、流入数の上昇が緩やかであることです。 ファインダビリティを成果指標とする場合は、最適な指標はサイトごとに異なるものの、流入キーワードの数や流入数を指標にするとよいでしょう。

SEOを行う場合、ターゲットキーワードはビッグキーワードであることが多いため、上位表示したときのインパクトや達成感はひとしおです。しかし、サイトのあり方を今一度考え、発信すべき情報や貴社の事業的に獲得すべきキーワードを見つめ直してもよいかもしれません。

少し遠回りに思えるかもしれませんが、その施策がサイトの価値を高め、ビッグキーワードを狙うための下地作りにもなります。

SEOのメリットとデメリット

SEOのメリット

SEOの主なメリットとしてあげられるのが、

- 顧客の潜在層に幅広く露出できる

- ストック資産化による費用対効果の高さ

の2点です。

ユーザーは購買行動の過程において、購入・申し込みを行う前に認知、検討、調査といった段階を踏みます。この潜在層のユーザーが検索エンジンを利用して調べるため、SEOによって顧客の潜在層へと幅広くアプローチできるようになるのです。

また、リスティング広告や一般的な広告は都度費用が発生し、効果を上げるためにはコストを払い続ける必要があります。 特に、リスティング広告の場合、アクセスごとに費用が発生するために費用がかさみやすい、コストコントロールの難易度が高いといった課題もあります。

これに対して、SEOにより検索上位に表示されるようになったサイトは、アクセス獲得のための直接的な費用が発生しません。

サイトおよび施したSEOはストック資産となり、高い費用対効果が期待できます(ただし、定期的にメンテナンスをしなければ、順位が下がっていくリスクがあります)。

SEOのデメリット

一方で、SEOにはデメリットあるいは苦手な分野も存在しています。

例えば、SEOはどうしても中長期的な取り組みが必要となるため、広告のように短期で成果を出すことにはあまり向いていません。

短期的に成果を上げたい場合や、トレンド性の高いキーワードに対して能動的にアプローチすることは、検索エンジンの特性上難しいといえます。

ただし、上記はどちらかといえば、メリット・デメリットというよりも性質の違いと捉えるべきであり、広告枠を購入するリスティング広告と自然検索結果からの流入は、それぞれ異なる目的を持って施策するのがよいでしょう。

成果を出すための具体的なSEO施策の種類や方法

SEO施策は闇雲に行っても効果がありません。成果を出すためには、いくつかの具体的な定石に従って施策を行う必要があります。

特にAIOでは『表形式・箇条書き・引用元リンク』が抽出対象になりやすく、コンテンツ設計段階で“要約されても誤解されない構造”を意識する必要があります。

ここでは、基本となる「内部対策」と「外部対策」について説明します。

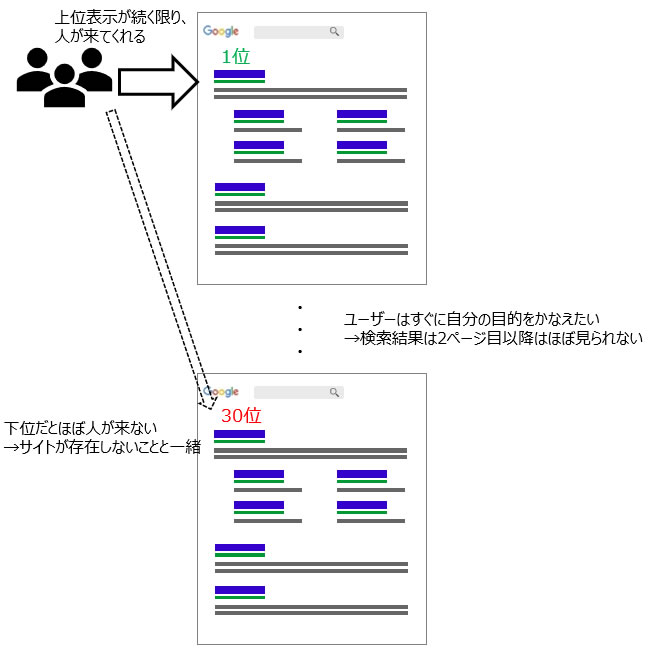

内部対策|コンテンツSEOとテクニカルSEO

内部対策には、大きく分けてコンテンツSEOとテクニカルSEOの2つがあります。

内部対策には、大きく分けてコンテンツSEOとテクニカルSEOの2つがあります。

コンテンツSEOは「検索ユーザーのニーズに対応するコンテンツを導入することでサイト価値の向上を行う」というコンテンツ面からのアプローチであり、いかにユーザーの検索意図(インテント)に沿い、わかりやすくかつ信頼性が高い情報を適切に届けられるかという施策です。

ユーザーにとっては、検索という行動自体は目的ではなく、あくまでも「何らかの課題を解決したい」「何らかの要望を満たしたい」といった目的のために検索を行っています。

コンテンツを制作する際は、検索ユーザーの目的や意図を深掘りした上で、ユーザーの検索リテラシー(以下、リテラシー:検索によって情報を収集する能力)に見合った伝え方を設計する必要があります。

一方のテクニカルSEOは、「HTML要素やサイトの内部構造を最適化することで、検索エンジンに正しく評価される状態を整える」という技術的なアプローチです。

ただし、HTML要素やサイトの内部構造の最適化には、ある程度定石化されたルールがあるものの、決まった正解というものはありません。ターゲットユーザーの属性やサイトの立ち位置などにより、柔軟に施策内容を変えることが求められます。

重複コンテンツがあったとしても、ECサイトならページを残しておきたい場合もあるため(その状況が発生することは検索エンジンも理解しているので)、canonicalを使用することになります。

その状況において、どのページにcanonicalを向けるかは状況やサイトによりますし、SEO担当者の考え方でも変わってきます。

様々なタグの役割と、ページごとの目的、サイトの状況を鑑みて、適切な施策を行うことが重要です。

参考:SEOにおいて内部対策と外部対策はどちらが重要?優先順位やメリットについて解説

外部対策|外部リンクとメンション

外部対策とはその名の通り、対象となるサイト内そのものではなく、外部との関係において評価を高める施策です。 サイト内のコンテンツがユーザーにとって有益な場合、それを見たユーザーが自分のブログやサイト内で紹介し、リンクを貼ってくれるケースがあります。

この外部サイトからのリンクは、実際に読んだ人が良いサイトだと思ったからリンクされるので、検索エンジンはこの指標を高く評価しています。

かつては、自分で複数のサイトを作成し、上位表示を実現したいサイトへリンクすることで、上位表示できた時期もありました。

しかし、現在、その手法はほとんど通じません。

現在のSEO施策の本質は、ユーザーにとって良いサイトを育てていくことです。外部評価はその過程で、結果的に増えていくものです。ユーザーにとって良いサイトを育てていった結果、サイト内部も外部も強力なサイトになり、様々なキーワードで上位表示されるようになります。

また、単にリンクを集めているだけでなく、どのような評判を獲得しているかというメンション(Mention:言及)も重要です。

サイトやブログ、SNSなどでどれだけポジティブなメンションを集めているかによっても、サイトの評価が高まります。

Google(検索エンジン)の仕組みとSEOにおける基本の考え方

日本におけるSEOは、実質的にはGoogleを意識した施策とほぼ同義になっています。

というのも、日本における検索エンジンのシェアはGoogleが約65%を、Yahoo!が約30%を占めており、さらにYahoo!の検索エンジンはGoogleのアルゴリズムを採用しているからです。

Yahoo!は独自のアレンジを若干加えてはいるものの、検索順位はGoogleのものとほぼ一致します。

そのため、SEOを適切に実施するためにも、Googleの基本的な仕組みや考え方について理解しておきましょう。

Googleの目的とビジネスモデル

いまや誰にとっても当たり前の存在となりつつあるGoogleは、1998年9月4日に当時スタンフォード大学に在籍していたラリー・ペイジとセルゲイ・ブリンによって創業されました。

そのGoogleが掲げる最大の目的は「世界中の情報を整理し、世界中の人々がアクセスできて使えるようにすること」であり、創業以来これをミッション・ステートメントとして検索エンジンをはじめとしたインターネット関連のサービスや製品を提供しています。

Googleでの検索自体は無料で利用できるようになっており、代わりにGoogleでは、サイト運営者向けの広告配信サービスであるGoogle広告(旧Google Adwords)を提供しています。

これは、冒頭で述べたGoogleの広告枠に費用を対価として自社サイトを掲載する仕組みです。

Google広告で自社サイトの広告を出稿すると、特定のキーワードで検索したときに広告枠に自社サイトへのリンクが表示されます。そのリンクが検索結果画面上でクリックされるとGoogleに所定の金額を支払うことになります。

ここからの広告収入が全体の60%以上を占めています。

つまり、Googleを通じて検索を行うユーザーが増えれば増えるほど、Googleのビジネス自体が拡大する仕組みとなっています。

念のために付け加えておきますが、自然検索枠においては、自社サイトへのリンクがクリックされても費用が発生することはありません。

Googleが評価するサイトは「ユーザーに必要とされるサイト」

Googleは、検索キーワードを「質問」、検索ボックスを「質問箱」、サイトを「答え」と位置付けており、ユーザーに的確な答えやユーザーが探している情報を提示できるサイトをより高く評価します。

Googleにとっては、より多くのユーザーにGoogleでの検索を利用してもらう必要があり、そのためには「Googleの検索は便利、役に立つ、満足できる」とユーザーに感じてもらうことが欠かせません。

こうした理由から、Googleは検索ユーザーが納得できる検索体験を提供することを目指して、現在も検索エンジンの改良を行っています。

そして、ユーザーの検索体験の満足度を重視するGoogleでは、「ユーザーに必要とされるサイト」を高く評価するためのアルゴリズムを追及しています。実際にそのような満足度の高いサイトの多くが上位表示されています。

ユーザーに必要とされるサイトには様々な要素があります。

例えば、「検索キーワードの関連情報が網羅されている」「正確で信頼性の高い情報が掲載されている」「サイト内で目的の情報に到達しやすい」「サイトが見やすく文章も読みやすい」など、ユーザーごとにいろいろなニーズがあるでしょう。

より多くの検索ユーザーに対して最適な検索結果(答え)を返すことに注力して、Googleはサイトの評価を行っているのです。

そして将来的には、「究極のパーソナルアシスタント」となることがGoogleの目指す姿であり、ユーザーが知りたいことを先回りして提案する執事のようなプロダクトを目指しているといわれています。

サイトが上位表示される仕組み

Googleの検索エンジンがサイトの評価を決めるためのプロセスは、

の3つのステップから成り立っています。

まずは、クローラーがリンクやすでに把握しているサイトリストなどをたどってWebページを巡回(クローリング)します。

次に、クローリングで取得したデータをGoogleのインデックスサーバーに蓄積(インデキシング)します。この2つのプロセスを経てから、蓄積したデータを対象に独自のアルゴリズムにより順位付け(ランキング)を行います。

ユーザーはインターネット上のサイトを直接検索するわけではなく、Googleによって集められ、評価されたデータを対象に検索を行っているのです。

そして、上位表示に直接関わってくるランキングは、検索キーワードおよび検索ユーザーの知りたい情報に最も関連性の高いページを表示できるように、様々な要素を用いて行われています。

SEOにおいては、200を超えるランキング要素(Ranking Factors)をより多く満たすページほど、検索結果で上位表示されているといわれていますが、Googleはそのランキング要素の詳細を明らかにはしていません。

ただし、アルゴリズムのアップデートにおいて、その方針自体は明らかにされています。

【関連記事】

Search Engine Landによるランキングファクターの一覧表とその読み方

AI Overviews(旧SGE)の登場とSERPの変化

AI OverviewsはGeminiモデルが複数サイトを統合して要約を生成する検索機能です。2024年5月から米国でデフォルト提供が始まり2025年までに世界10億ユーザーへ拡大予定となっています。

米Ahrefs調査では、AIO表示クエリが半年で2倍に増え、クリック数は平均34%減少したとの報告もあり、また別の調査では生成枠内に引用されるページは概ね「上位12位以内」「構造化済み」「権威サイト」の傾向が強いとのレポートもあります。

SEOにおける3つの重要な要素:キーワード設定、ドメインの強さ、ユーザー体験

検索結果で上位表示されるために大切な要素として挙げられるのが次の3つです。

どんなキーワードで上位表示したいかを決定し、どのようにサイトを育てていくかを考え(ドメインの増強)、サイト内でユーザーにストレスなく何らかの行動(購入や申し込み)を行ってもらうことが大事です。

それぞれどのようなものかを見ていきましょう。

①キーワード設定

ユーザーはキーワードを用いて検索を行うため、どのようなキーワード(検索クエリ)をどのように設定するかが重要になってきます。 キーワードをページタイトルに含めることはよくあるSEOの施策であり、タイトルにキーワードを入れるということは、検索結果上で検索したユーザーの目に留まるということにつながります。

これは検索エンジンへの最適化だけでなく、直接目にしたユーザーの印象も踏まえて設定する必要があります。

キーワードをしっかりとタイトルに含めてサイトの内容を想定しやすくする、記事内にもキーワードを入れた上でタイトルとの整合性を保つといった対策を行うようにしましょう。

②ドメインの強さ

ドメインの強さとは、その名の通りドメインすなわちサイトの持つ力を指しています。

ドメインの強さとは、その名の通りドメインすなわちサイトの持つ力を指しています。

サイト内外の評価、アクセス数、運営機関などの評価指標がありますが、これらが優れている場合、俗に「ドメインパワーが強い」と表現します。 例えば、Yahoo!のようなサイトはドメインの強さがものすごく高いわけです。

このドメインパワーが高ければ高いほど上位表示されやすい傾向があるため、競合サイトよりもドメインパワーが高い状態を目指すことがSEO施策の目標の1つとなります。

③ユーザー体験

最近になって注目が集まっているのが、ユーザー体験(UX)という指標です。 検索ユーザーの役に立つというGoogleの「ユーザーファースト」の考えに基づき、使いやすくユーザーの目的が達成しやすいサイト設計が重要です。 それは、例えば、下記のようなことが挙げられます。

最近になって注目が集まっているのが、ユーザー体験(UX)という指標です。 検索ユーザーの役に立つというGoogleの「ユーザーファースト」の考えに基づき、使いやすくユーザーの目的が達成しやすいサイト設計が重要です。 それは、例えば、下記のようなことが挙げられます。

- 検索意図に沿ったコンテンツ内容になっているか?

- 読みやすさやサイト内の使いやすさは十分か?

- 表示速度は遅すぎないか?

ユーザー体験自体はランキングアルゴリズムに組み込まれていませんが、アルゴリズムの評価には使用されています。

また、AI Overviews時代は“クリックされずとも引用される体験”が新しいUX指標になります。段落単位で完結した解説、FAQ構造、一次データの明示、著者情報の構造化は必須と考えた方が良いでしょう。

【関連記事】

SEO業者の取り組みとその歴史

検索エンジンのアルゴリズムという難解かつ詳細が明らかにされないものに対しては、専門家となるSEO業者の力を借りることが重要な位置を占めてきました。同時に、SEO施策の歴史はSEO業者とGoogleとの攻防の歴史でもあります。

ここでは、両者の関係がどのように変わってきたのかを見てみましょう。

SEO業者の取り組みとGoogleの攻防

SEOには、検索エンジンのアルゴリズムの裏をついたスパム的な手法によって検索順位を上げようとする「ブラックハットSEO」と、Googleのガイドラインに沿って検索順位を上げようとする「ホワイトハットSEO」という大きく2つのアプローチ方法があります。

SEOには、検索エンジンのアルゴリズムの裏をついたスパム的な手法によって検索順位を上げようとする「ブラックハットSEO」と、Googleのガイドラインに沿って検索順位を上げようとする「ホワイトハットSEO」という大きく2つのアプローチ方法があります。

ブラックハットSEO

ブラックハットSEOは、検索エンジンのアルゴリズムが未成熟な時代に行われていました。

例としては、検索エンジンと検索ユーザーにそれぞれ異なる内容のWebページを閲覧させる「クローキング」や、検索エンジンに特化して関連するキーワードを詰め込んだ文章を自動生成させる「ワードサラダ」、SEOだけを目的にした被リンクを構築する「人為的なリンク構築」などが挙げられます。

しかし、これらの方法で検索順位が上がったとしても、低品質な内容であったり間違った内容だったりすれば、ユーザーは検索結果に満足せず、さらにはGoogleの検索そのものに対する期待値も下がってしまいます。

そこでGoogleは、これらの抜け道を小さくするようなアップデートを何度も重ねて、「検索ユーザーのためにならない」ブラックハットSEOを排除してきました。現在では、こうした過度なブラックハットSEOはスパム行為として、検索結果の上位には見られなくなりました。

ホワイトハットSEO

そして現在のSEOは、検索エンジンのガイドラインに沿い、検索ユーザーに対して役立つ情報を提供する「ホワイトハットSEO」が主流となっています。

例えば、サイトのメタ情報の最適化やユーザーの検索意図(インテント)に沿ったコンテンツ発信などもホワイトハットSEOに当たります。 検索体験の満足度向上という、ユーザーファーストを掲げたGoogleの方針。

いかにこの点を押さえ、ユーザーにとってより良い検索体験を提供できるかどうかが、今後のSEO施策における重要なポイントになっていくでしょう。

今までのSEOとこれからのSEO|AI時代を乗り切るためには?

AI Overviews常設化で“ゼロクリック検索”が一段と増加し、ブランド想起と上位の確保、そして引用フォーマット最適化が生死を分けます。

生成AIとLLMの急進が、検索体験そのものを“意味空間”へ引き上げています。米国で導入されている「AI Mode」ではクエリがベクトル化され、関連パッセージが再評価されて回答に合成される――もはや“ページ”単位でなく“意味”単位で競う時代です。では、これからのSEOは何を磨くべきでしょうか?

意味の設計を行う

まずは事業のターゲットと売る商材の強みなどの理解、言語化に勤め、「誰に何を伝えるか」の解像度を上げましょう。次にサイトの「意味設計」です。FAQ・要点見出し・短段落など、AIが切り出しやすい粒度でコンテンツを再構築し、Passage Re-ranking で選ばれやすい形に整えます。

| ステップ | やること | ポイント |

|---|---|---|

| 1. Who-What-How把握 | ペルソナと検索モーメントを特定 | 営業現場の“生の悩み”を拾い、顧客像をブレさせない |

| 2. 意図グルーピング | 検索意図を1テーマ1グループで束ねる | 同じ意図はまとめ、異なる意図はページ分け |

| 3. 段落チューニング | 一問一答・FAQ・短段落で完結 | パッセージ re-ranking で抽出されやすい形=一問一答/FAQ/見出しで要点先出し |

| 4. 構造ラベル付け | H2-H3 と Schema.org で意味を宣言 | “住宅ローンの組み方”なら <h2>住宅ローンの組み方</h2>+FAQPage |

| 5. トピッククラスタ化 | 関連記事を階層化し内部リンク | サイト全体をその領域の“コーパス”にする |

| 6. 一次情報&監修 | データ・図表・専門家コメントを注入 | E-E-A-Tを強化し、引用される確度を底上げ |

検索意図を整理の上、トピッククラスターモデルでテーマを階層化し、内部リンクとスキーマで“このサイトはこの領域のコーパスだ”と示すことで、クローラビリティと網羅性を両立させます。

最後に「E-E-A-T の経験値」。独自データや実証実験、専門家の監修など一次情報を増やし、AIが引用したくなる確からしさを担保します。

計測指標の変更

成果計測も変わります。クリックされない“見えない貢献”を指名検索やCVRの微増、LLMへの引用調査など複数指標で捉え、施策と結び付けて説明する言語化能力が問われます。

つまり「ページを作る仕事」から「意味をデザインし、その価値を証明する仕事」への変化が訪れています。検索が“探す”行為から“答えを受け取る”体験へ転換する今こそ、SEOの本質「ユーザーの問いに誰より深く、速く、確かに応える設計力」が試されています。

自社SEO(インハウスSEO)に限界を感じたら?SEOコンサル会社の選び方

社内でSEO施策を行うインハウスSEOには、コストの節約や管理性の高さというメリットがあります。

その一方で、SEO施策は継続的に行う必要があるため、メンテナンスや管理にかかる労力が負担となります。 また、日々更新されていくアルゴリズムへの適切な最適化手法を学ぶためのハードルも高いといえるでしょう。

こうした理由でインハウスSEOに限界を感じた場合は、SEO会社への外注も検討してみることをおすすめします。

外注コストや業者選定の手間もありますが、信頼できるSEO会社をパートナーにできれば十分な効果も期待できます。

自身は本来のコア業務に集中しつつ、適切な知識やツール、リソースを備えたプロ集団であるSEO会社に協力してもらうことで、SEO施策に満足できる効果が得られるでしょう。

参考:SEOを外注する際のチェックリスト(資料ダウンロード)

SEO施策会社の選び方で最低限おさえておきたいポイント

これまでのSEO業者とGoogleとの攻防に見られるように、スパム的な手法で目先の結果だけを出そうとする業者も、残念ながらゼロではないからです。 そこで、選定にあたっては、以下のような業者は除外する必要があります。

- 現在もなおブラックハットやスパム的な手法を用いている

- 必要なサービスが欠けている

- 予算をオーバーする料金を請求する

その上で、知り合いのSEOに取り組んだ方に紹介をもらったり、これまでの実績や評判などを調べたりして、信頼できるSEO業者を探していきましょう。

AI×SEO時代を生き抜くキャリア戦略セミナー開催レポート

AI技術の急速な発展により、SEO業界は歴史的な転換点を迎えています。

- 「従来のやり方が通用しなくなる」

- 「個人のスキルだけでは限界がある」

そんな不安を抱えている方も多いのではないでしょうか。

当社アイオイクスでは、創業20年以上の実績と業界での信頼を基盤に、この変革期をチャンスと捉え、新しい働き方とキャリア戦略を模索しています。

今回のセミナーでは、そうした取り組みの一端をご紹介するとともに、AI時代に理想的なキャリアを築ける環境について、実際の事例を交えてお話しします。

開催概要

開催日時: 2025年6月23日 18:00-19:30

テーマ: AI×SEO時代のキャリア戦略

登壇者: 遠藤 幸三郎(アイオイクス Webコンサルティング事業部長)× 豊藏 翔太 氏(シンクムーブ代表・アイオイクス Webコンサルティング事業部フェロー)

本記事のまとめ

- AI技術の台頭により、SEO業界が根本的な変革期を迎えている中で、SEO担当者が生き残り・成長するためのキャリア戦略とは?

- 従来の「作る主体」から「意味を設計する仕事」への転換が重要であり、ブランドや事業の深い理解が求められる時代に

- 独立か会社員かの二択ではなく、「自由と責任があるカルチャーでの会社員」という第三の選択肢にアイオイクスも候補に入れてほしい

- AI時代にチームで働く意味としては、組織で学習加速することと実験機会の数が重要

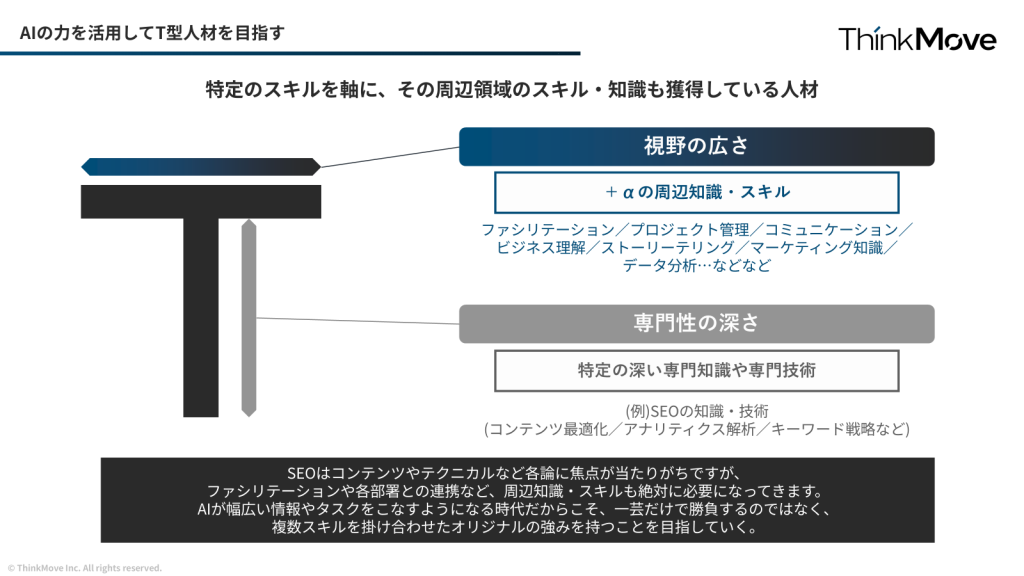

- 深い専門性(縦軸)とAIを活用した横断的スキル(横軸)を合わせたT型人材を目指すのが理想

遠藤氏パート:AI×SEO時代の新しいキャリア戦略

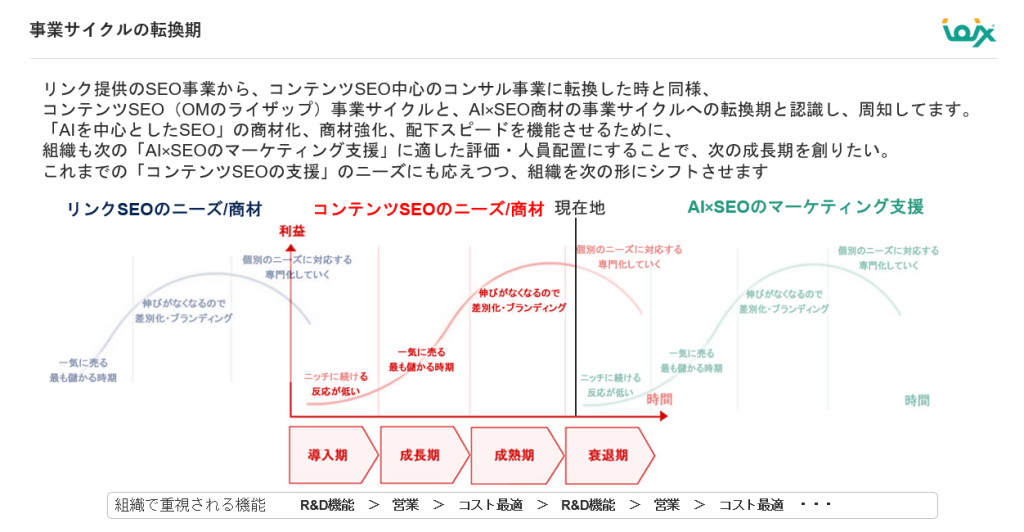

当社アイオイクスの遠藤氏は、SEO業界の変遷を3つの時代に分けて説明しました。

■SEO業界の歴史的変遷

- 2002-2010年: リンク主体のSEO時代

- 2010年代: コンテンツSEO時代(ペンギンアップデート以降)

- 現在: AI×SEO時代への移行

「今回のAIの流れは、過去のリンクSEOからコンテンツSEOへの転換と似たゲームチェンジの要素があります。だからこそ、事業のあり方や組織としての価値の置き方、人事評価制度、働くメンバーの強みも見直して再編成する必要があると考えました」

アイオイクスは、2002年とSEO黎明期から業界の大きな変化を20年以上見続けてきました。だからこそ、私たちは変化を恐れるのではなく、チャンスとして捉える文化が築かれています。

「何かを制作する」時代から「意味を設計する仕事」への転換を感じている。

遠藤氏は、SEOは従来の「何かを制作する時代」から「意味を設計する仕事」への転換が重要であると強調されました。

AI時代に求められる新しいSEO担当者の視点

- ブランドや事業の深い理解

- 生成AIに選ばれるサイト・ブランドの設計

- 多様化する検索行動への対応(動画、画像、音声など)

- 複数プラットフォーム(検索エンジン、SNS、動画プラットフォーム)を意識したコンテンツ設計

「これからのSEOの業務は、「ライティングだけ」では難しく、企業のブランドの文脈に沿って、どういった意味を訴求をしていくか。そして、それをどういうユーザーに対して、どのような接点で届けるかを設計する仕事が重宝されるようになると考えています」

実験重視の組織設計にシフト

AI時代の不確実性に対応するため、アイオイクスでは実験的な取り組みを重視していることが説明されました。

- 実験を行い、効果的な施策のみを展開

- 各社の施策効果を指標化し、有効性を検証

- 商材の形や提供価値を探求する継続的な改善

「AIにどういった形だったら好まれるか、それがどういうふうに取り上げられるのか、具体的に企業のビジネスでどんな数字に落ちるのかをファシリテートしていくことが求められています。SEOはかつてないくらい不透明な時代となりましたが、そんな中で新たなキャリアの選択肢として、SEO Japanを検討してもらえたら嬉しいです。」

豊藏氏パート:AI時代のキャリア戦略の実践例

豊藏氏は、AI時代のキャリア戦略について独自の視点を提示しました。

「AI時代のキャリア戦略を考える上で、独立するか会社員として働くか分かれると思います。個人的には、会社員として取り組むならアイオイクスのような自由と責任があるカルチャーで働くのも良い選択だと思います」

AI時代に会社員として働く場合の、自由と責任のバランス

豊藏氏自身の経験は、この「第三の選択肢」の実例となっています。

豊藏氏の過去の活動例

- 本業での挑戦: 営業からコンサル、事業推進、商材開発まで幅広い経験

- 副業での実験:アフィリエイト・転職サービス・レンタルスペース・広告運用など

「副業で得た経験、例えばInstagram広告を自身の副業で取り組んだ経験を、アイオイクスのセミナー集客に活用することもできました。逆に、アイオイクスで培った解像度の高いマーケティング視点を、自分のビジネスに応用することで成果を出せています」

AI時代に求められる「T型人材」はキャリアの選択肢が大きく広がる

豊藏氏は、AI時代における人材戦略について「T型人材」の重要性を強調しました。

「今はAIにより、自分の専門外の知識も取り込みやすくなった時代と考えています。だからこそ、自分の芯のある専門性と両立できると強い時代だと思ってます。縦の軸と横の軸両方を兼ね揃える事で、生成AIで5割、6割、7割ぐらいまで一定の品質が作れるようになりました。だからこそ、自分の専門分野を越境していくことでより広範なスキルが身に付きます。」

T型人材の構成要素

- 縦軸(専門性): SEOやマーケティングなど、深い専門知識

- 横軸(応用力): AIを活用して他領域の知識を効率的に習得

「マーケティングの根本は差別化の仕事です。だからこそ、生成AIで形にされたものから、81点、82点、83点と一点刻みで積み上げていくのが人間の役割と考えています。」

アイオイクスの仕事環境はAI時代に強みとなるか?

両登壇者のクロストークでは、AI時代におけるアイオイクスの強みについて詳しく言及されました。

- 20年以上の実績と信頼

- 創業: 2002年、SEO業界のパイオニア

- SEO Japan: 業界標準の情報発信プラットフォーム運営

- 大手企業実績: SMBC、パソナグループなど有名企業との取引

- 業界認知: 「SEO業界の歴史と権威がある」

「こうしたブランド資産は、AI時代に急に生まれるものではありません。SEO Japanの得てきた歴史は、中長期的なブランド資産として大きな強みになると考えています。」

AI時代のSEOコンサルティングは求められることが増える。個人対応の限界と組織の価値

遠藤氏は、AI時代のSEO案件について以下のように分析しました。

- (AI活用やAI対応の整理・検討など)やることが大幅に増加

- 従来のコンテンツ制作・テクニカルSEOも重要

- LLM最適化対応

- AI活用による業務効率化

- 多様化する検索プラットフォームへの対応

- 組織内AI導入支援

「SEOに取り組むには個人で対応すると、イチロー以上の守備範囲を求められます。(笑)すべてをカバーするのは現実的ではありません。だからこそ、AIの力を借りながら強い組織を作っていきたいと考えています。」

学習スピードが加速し、視座が向上するチームを作りたい。

AI時代のチーム戦略の優位性

- 学習スピードの加速: 優秀な人のAI活用方法を間近で学べる

- 視座が向上する: より高い視点でのAI活用方法を習得

- 実験機会がある: 組織リソースを活用した大規模な試行錯誤

「いきなりスーパーマンになるのは難しいですが、経験を吸収するには、チームの方が断然有利です。AIを使うことによって業務のスピードが速くなるからこそ、そのスピード感の中でチームに属して、スピード感の中でキャッチアップもよりスピードを持って進化できると考えます」

アイオイクスでの実践例

私たちのチームでは、ChatGPTなどのAIツールの利用を経費でサポートし、最新のAI活用ノウハウを全社で共有する文化があります。一人の発見が、チーム全体の成長につながる環境です。

アイオイクスのカルチャーと生成AIの考え方

アイオイクスのカルチャーには以下のような特徴があります。

- 実験推奨: 「これよりいいじゃん、やろう」という前向きな姿勢

- 失敗許容: 完璧性より実験精神を重視

- AIツール活用: ChatGPT等の経費利用可能

- 柔軟な意思決定: 現場の提案を積極的に採用

「セクショナリズムがある会社とは違って、『今はこの形で進めてるけど、こういう会社さんと連携したらもっといい価値を顧客に提供できるのでは?』といった試行錯誤ができる環境です」(豊藏氏)

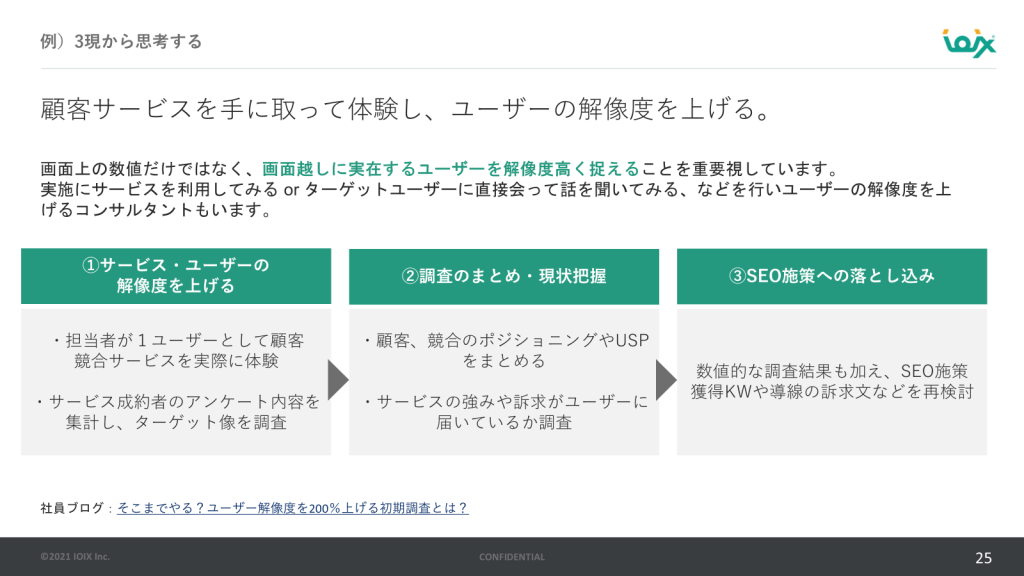

また、遠藤氏はコンサルティングをする上で以下の観点を重視しているという話をしました。

- 現場: 実店舗視察、顧客体験の直接確認

- 現物: 実際のデータに基づく施策立案

- 現実: 机上の空論ではない実践的アプローチ

「実店舗がある企業の支援では、単純にウェブサイトを見るだけじゃなくて、実店舗に行って、どこのどういうシーンで、何をどうしゃべってるかとか、実体験を目にして、それを施策にどう落とすかを考えます」(遠藤氏)

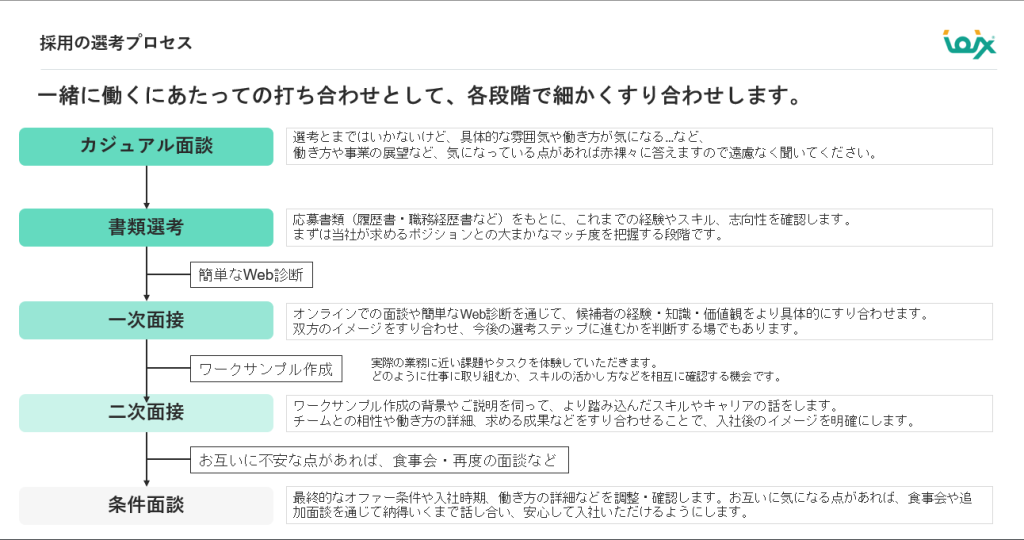

採用情報:あなたも一緒に挑戦しませんか?

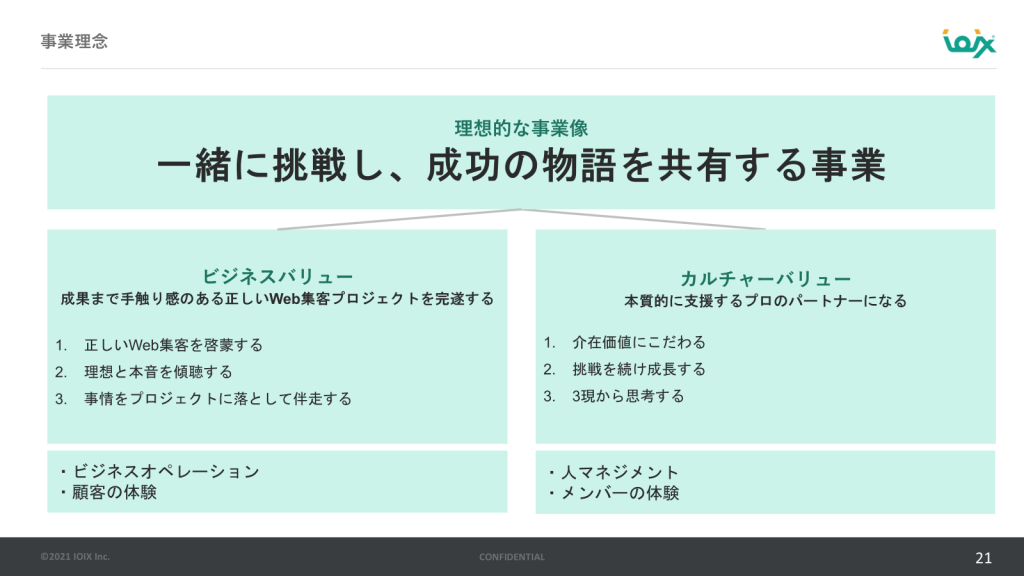

遠藤氏は求める人材像とカルチャーを以下のように話します。

ビジネスバリュー(お客様への価値提供)

- 正しいWeb集客を啓蒙する

- 理想と本音を傾聴する

- 事情をプロジェクトに落として伴走する

「知的好奇心、チーム思考、そして先々通じる汎用的なビジネススキルを重視しています。SEOをやるというよりかは、SEOをお客様のビジネスに活用するという視点が重要です。ビジネスバリューに共感いただけるパートナー(フリーランス、法人パートナー等)の方を募集しています。」(遠藤氏)

カルチャーバリュー(組織文化)

- 介在価値にこだわる

- 挑戦を続け成長する

- 3現から思考する

加えて、社内のカルチャーから生まれるバリューは上記3つの通り。ビジネスバリューのみならず、カルチャーバリューにも共感いただける方は、ぜひ一緒に働きましょう。

採用プロセスはカジュアルな対話重視

「面接官と受ける側という関係ではなく、ざっくばらんに話しながら、気が合えば一緒に働きましょうという感じです」(遠藤氏)

採用プロセスの特徴

- 複数回面談: 不安解消まで丁寧に対話

- 柔軟な形式: オンライン・オフライン両方対応

- インフォーマルな場: 食事会等での自然な対話