緊急事態宣言が出て、先もなかなか見えない中ではありますが、暗くなってばかりいても仕方ありません。止まない雨はないと信じて、雨が止んだときに楽しめるようにこういうときだからこそできるSEOの施策をいくつかやっておこうと個人的に考えています。

リモートワークになり出張や外出が減り、ミーティングも減っていつもよりも考える時間があるという方もいらっしゃると思います。普段は忙殺されていてなかなか整理したいことやじっくり考えたいことが後回しになっている人も、今時間が空いているようであれば自サイトのSEOについて再度整理してみるのはいかがでしょうか?

いざ整理してみるとしてもサイトの規模や運営体制、いまおかれている状況によってそのポイントはさまざまだと思います。

そのため、今回はあくまで私の場合です。

私が見ているサイトの多くは大規模サイトなので中小規模のウェブサイトには不要なこともたくさんありますし、逆に中小規模サイトのSEOに必要なところが抜けることもあるかもしれませんがご了承ください。

1,サイトのコンテンツの見直し

1-1,不要なコンテンツの削除や統合

特に大規模サイトにおいては不要なコンテンツや内容に乏しい品質の低いコンテンツを削除することによってSEOの効果が高まることがあります。

これは大規模なサイトにつきもののクロールバジェットの問題が軽減されることによって、重要なコンテンツによりクロールがなされるようになることが原因のこともあれば、ユーザー行動が改善されることが原因のこともあれば、サイト全体としてのコンテンツ品質が低いと見られているものが解消されることが原因のこともあるでしょう。

今までの私のたいして多くない経験の中でも、

- スパムコンテンツの大量削除

- システムによる自動生成コンテンツの削除

- 重複コンテンツの大量削除またはcanonicalによる正規化

等によって検索流入がサイト全体として増加したケースがあります。

一点注意が必要で、検索流入がないページがすべて不要なわけではなくユーザーにとって必要なページは残しておくべきです。

その中で検索者には役立たなそうなものはクローラーをブロックしたりnoindexしたりということが考えられます。

検索流入はないけれど、検索流入したひとが回遊して役立ちそうなものは残しておくべきだと思います。

例えばECサイトで「商品ページが検索上位に上がってくるからオウンドメディアでその商品の上手な使い方を作っていたけど削除したもいいや」というのは間違いです。

商品ページから回遊して役立つページになると思いますので、そういったページは削除しないようにしましょう。

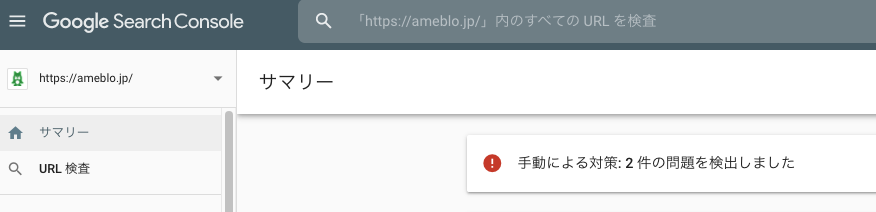

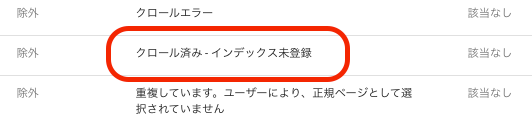

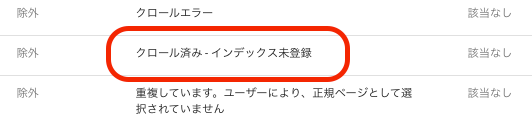

個人的には、Search Consoleのカバレッジ>除外の

クロール済みインデックス未登録のリストを見て、どんなものがGoogleから「indexしても意味がない」と思われているかを確認して、基準作りの参考にするようにしています。

1-2,必要なコンテンツの作成

別にこういうときでなくても必要なコンテンツは作らないといけないのですが、やれ無駄なミーティングだ、やれ上司に無駄な報告だ、やれ無駄なレポート作成だ、やれ有用な飲み会だと何かと忙しくて、わかっちゃいるけど作れないという方もいらっしゃると思います。

これは何も狙うべきキーワードのコンテンツが作れていない!という情報メディアによくありがちな話だけではありません。

意外とあるのが、メーカーさん等で商品の魅力を伝えきれていないものです。

画像等でビジュアルではその商品の魅力が伝わるものの、どういう人に合っているのか、どういうシチュエーションで使うと良いのか?使い勝手は?使い方は?などユーザーが知りたいことに応えられていないケースがときどき見られます。

Webサービスでもよくあります。特に競合の商品がある場合にはそこと差別化できる「強み」を伝えられているかチェックする必要があると思います。

また、商品について細かく伝えたいときはFAQコンテンツを作るのも良いでしょう。

QuestionとAnswerで1ページずつコンテンツを作れるくらいボリュームができると質問に関するロングテールのクエリで検索流入が得られることもあると思います。

(薄っぺらいコンテツになるなら1ページずつ独立しないほうが良いと思います)

2,ページやサイトの作りについて見直す

2-1,構造化データが正しく使えているか見直す

構造化データがしっかり使われているサイトはかなり増えてきていますが、古くから運用されているサイトではまだ導入されていないサイトもあるでしょう。

このタイミングでもしリソースが空いているようであれば、構造化データをしっかりセットしておくのも良いと思います。

構造化データがSEOにどう寄与するのか、リッチスニペットに反映されること以外はあまりはっきりしたことは言えませんが、今構造化データをなんらかのヒントにしている可能性はありますし、今使っていなくても今後ヒントに使うかもしれないと思います。

リソースに余裕があるときでないと、SEOに保険をかけることはなかなかできないと思いますので、リソースに余裕があれば保険をかけておくと良いのではないでしょうか?

Googleのドキュメントとしては「構造化データの仕組みについて」、正しく使えているかどうは、Search Consoleや「構造化データテスト」を活用しましょう。

2-2,<title>,<h1>等がコンテンツ内容を正しく伝えられているか確認する

titleもh1もSEOには不要という人もたまにいらっしゃいますが、、、、やはり検索エンジンにはヒントになるものだと思っていいと思います。

そしてユーザーが見出しを見たときに、そこに何がかかれているのかを一目でわかるようにすることは重要だと思います。

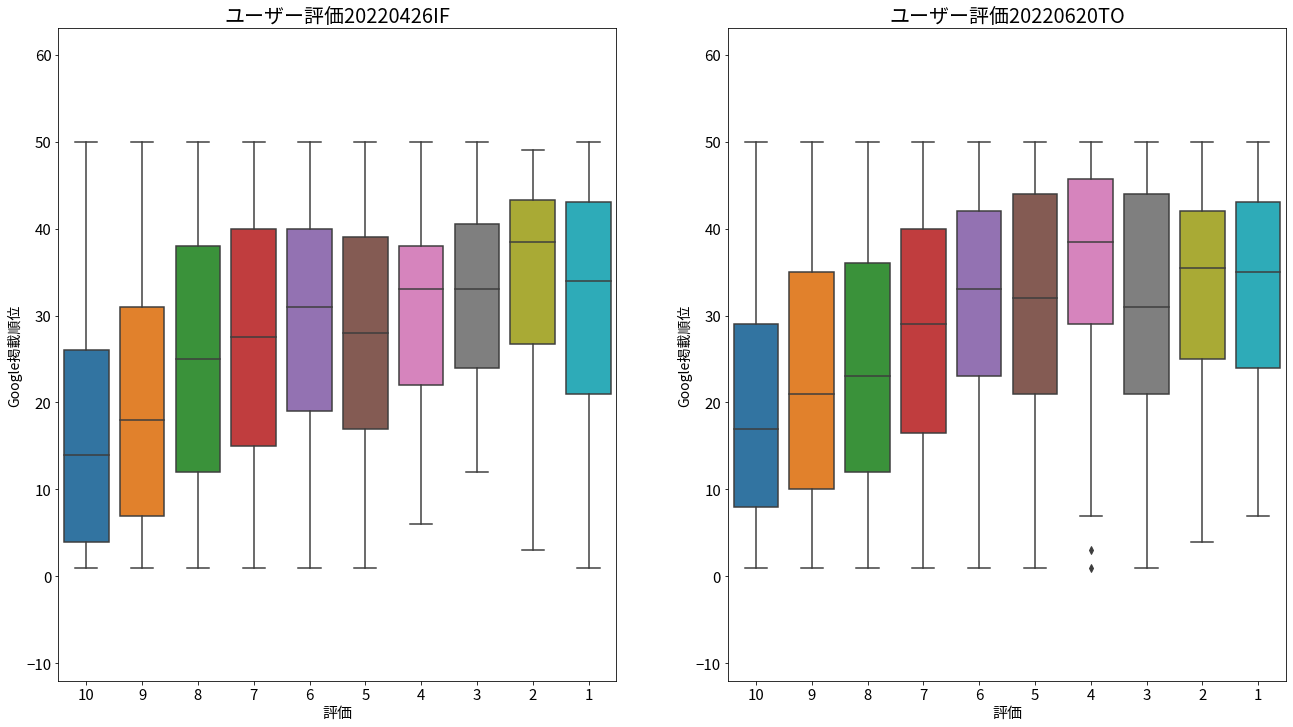

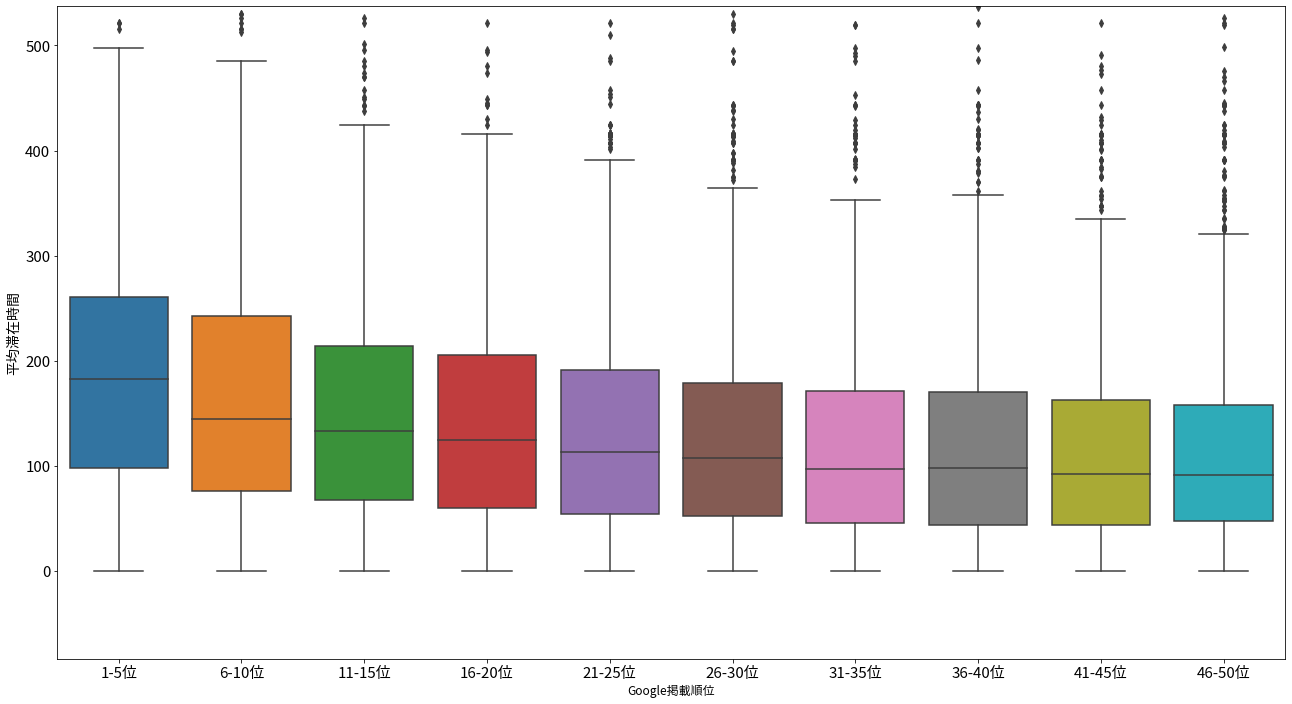

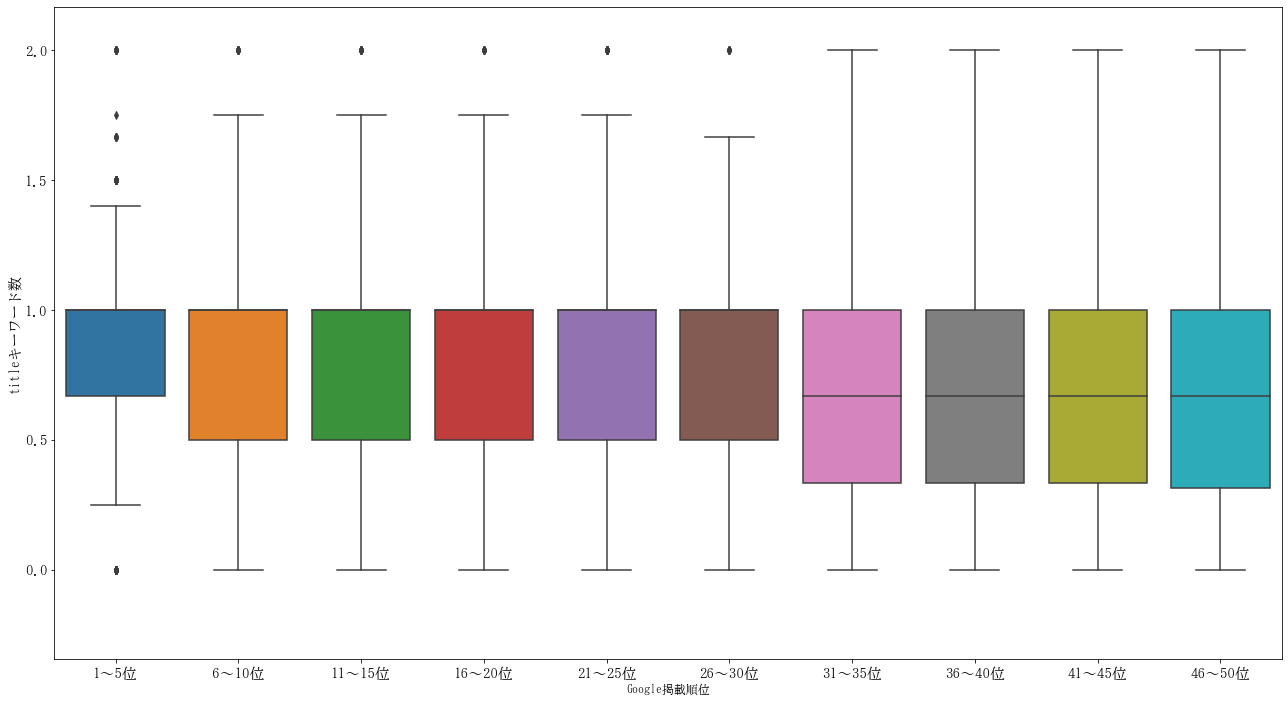

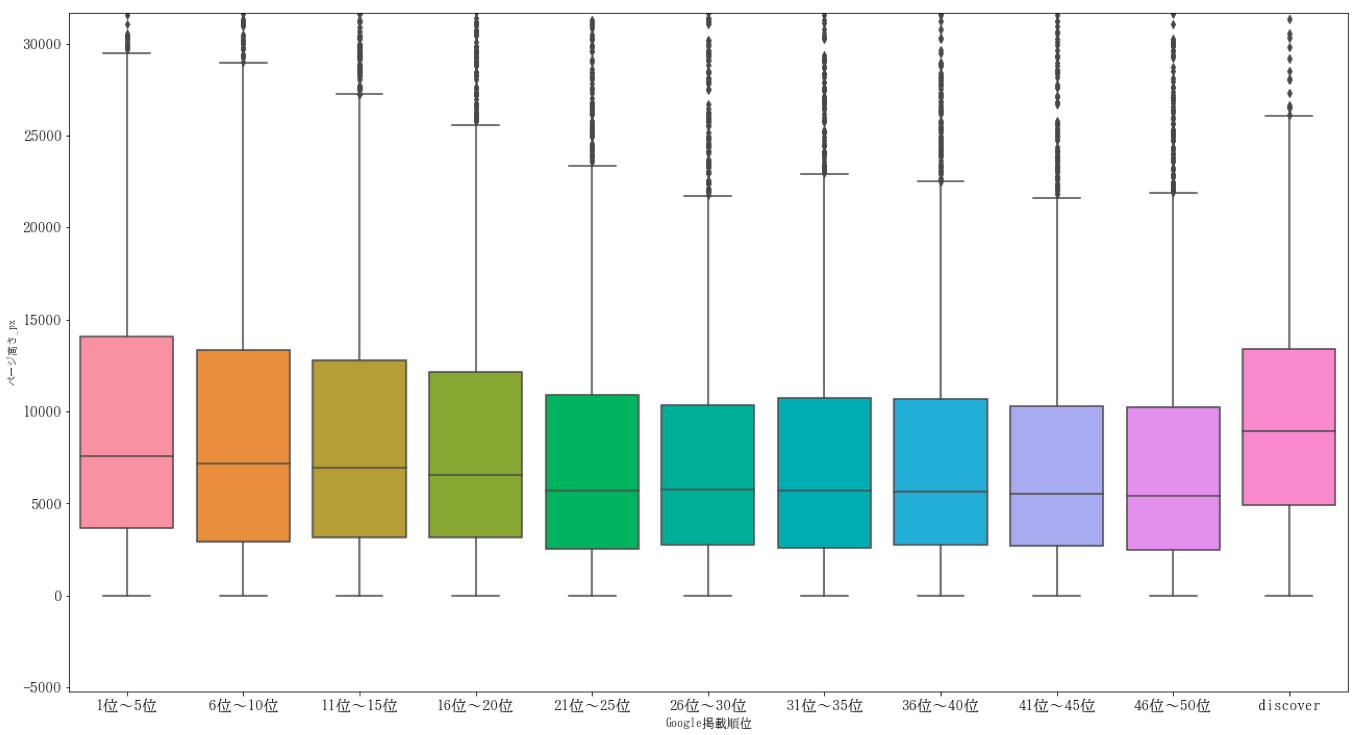

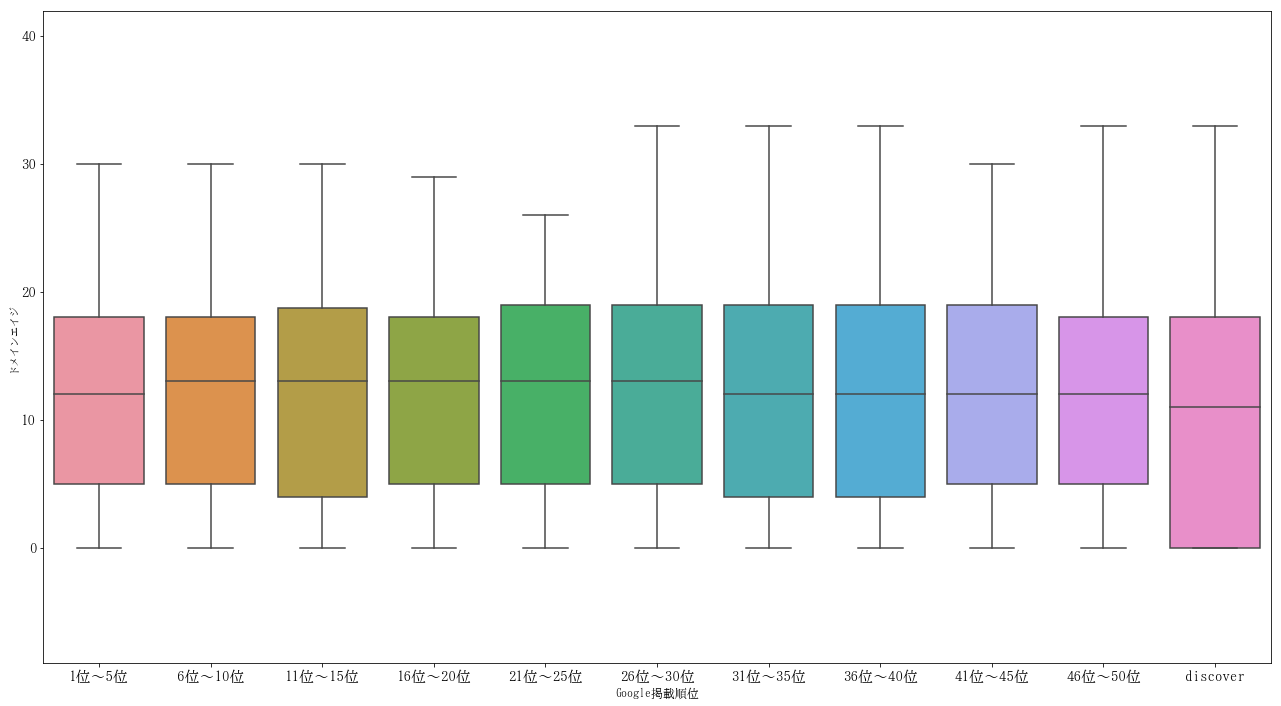

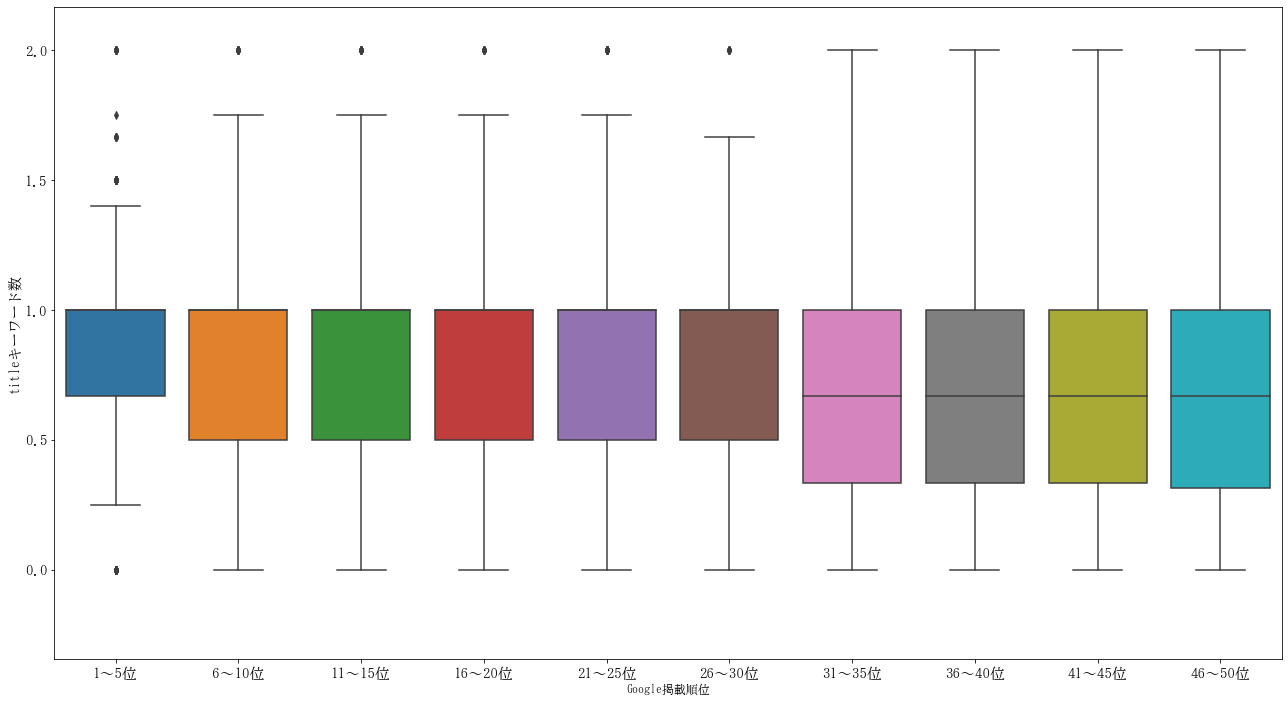

上位50位に入っているもののほとんどはしっかりキーワードが入っています。

(5位ずつの箱ひげ、縦軸はキーワードの出現回数、複合ワードの場合に例えば2語の複合で片方しかtitleに入っていない場合は0.5として算出する)

2-3,パフォーマンス(表示速度)改善をする

これは普段から取り組んでいる方が多いと思いますが、たまたまエンジニアの方の手が空いている!なんてことがある方はトライすると良いと思います。

コロナウイルスが流行してから検索結果がおかしな方向に変わることを避けるためか、Googleには大きな順位変動はありません。コアアルゴリズムアップデートも発表されていません。

それでもいつかコアアルゴリズムアップデートがあったときに、どのサイトであっても大きく検索流入を下落させる可能性があり得ます。

そしてコアアルゴリズムアップデートによる検索流入低下時には、運営者のなんらかの努力でその流入数を元に戻すことは現時的ではありません。

となると、訪問してくれるユーザーさん一人一人をより大切にしなければいけないわけです。

パフォーマンス改善はこのような有事の際の保険にもなりますので、ぜひ取り組んでおきたいものです。

実際の表示速度とは必ずしも一致しないかもしれませんが、"検索から来た人のUXを改善する"という意味ではPageSpeed Insightsは外せないと思います。

私も頑張ります(汗

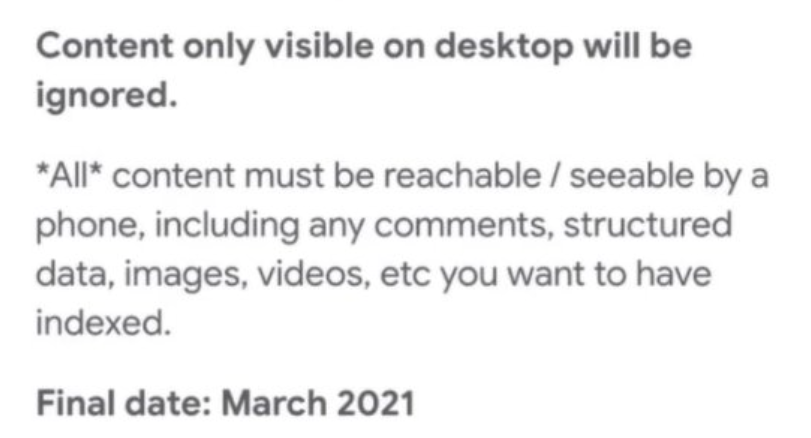

2-4,MFI対応に問題がないか確認する

先日、9月以降にMFIへの強制移行がはじまるとの告知(英語)がありました。

まだMFI移行されていないサイトは、このタミングでMFIが来ても問題がないかチェックする必要があるでしょう。

詳細は先日投稿した記事をご覧ください。

もう一度モバイルファーストインデックス(MFI)について振り返ってみた

3,クロールの最適化について見直す

大規模サイトにしか必要ではないと思いますが、大規模サイトのSEOだと取り組まなければいけない課題になることが多いと思います。

3-1,ページの重要度において傾斜をつける

SEOにおいて重要なページとそうでもないページがあると思います。

- Landing Pageになり得るページ

- Landing Pageをあげることをアシストするページ

- SEOには役立たそうなページ

があったときに、1 > 2 > 3の順にクローラーに積極的にプッシュしていきます。

1はsitemapに掲載する、2は何もしない、3はクローラーを回さないなど、ここはサイトそれぞれにカスタマイズする必要がありますが、大事なものはクローラーが見つけやすいようにし、不要なものはクローラーに見つからないようにするという意識が必要だと思います。

(ここは中途半端に書くと誤った方法で大失敗してしまうケースがあると思いますので、敢えてざっくりした表現に留めます。

慣れていない方は専門家に相談されることをおすすめします。)

3-2,不要なページへのクロールを回避する

先ほど記述したようにSEOに役立たない、むしろクロールバジェットなどの観点からマイナスになり得るようなものはクローラーを回さないようにすることが有効なケースが大規模サイトの場合あります。

noindexにしてもindexが回避されるだけでクローラーは回ってきますので注意してください。

(クロールの頻度は下がるように思いますが)

クロールの回避には、サイト内リンクでそのページへのリンクに rel="nofollow" を設定するというのがありますが、それよりもクロールさせたくないURLを特定のURLパターンにして、robots.txtにてdisllowするというのが確実性が高いと思います。

本当は品質の低いコンテンツは作らないのが一番ですが、どうしてもそれが回避できない場合に、かつて特定のディレクトリに格納してクローラーをブロックするという方法をとったことがあります。ブロックしたいものや無駄なものを別のサブドメインに逃すというのでも良いでしょう。

4,被リンクやサイテーションついて見直す

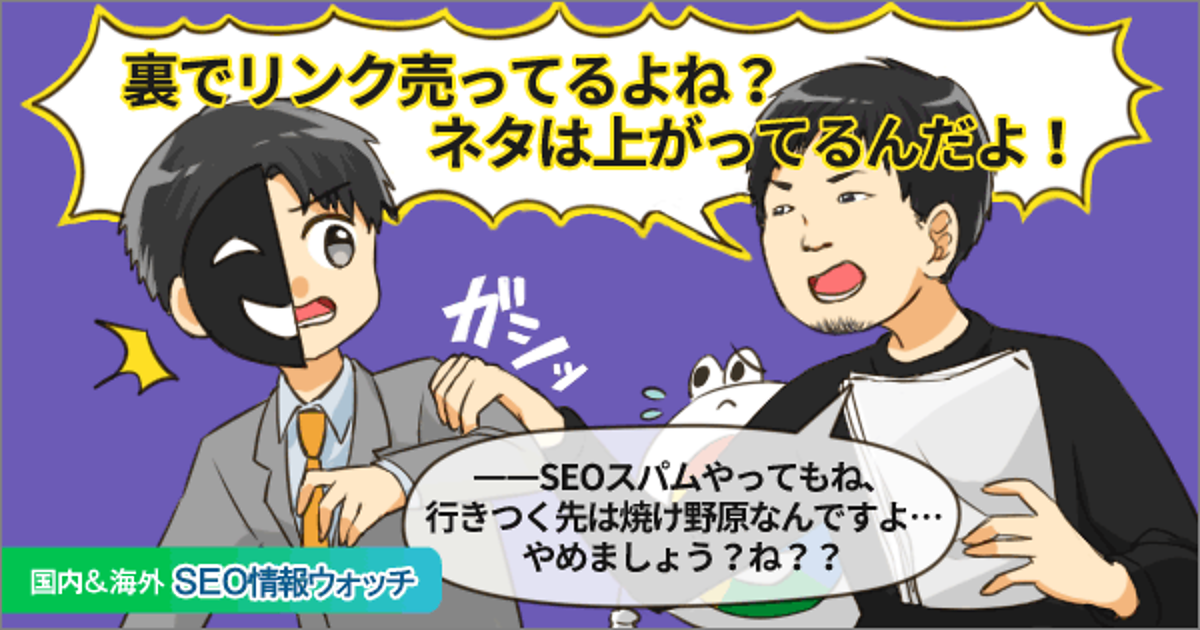

まずいないとは思いますが、有料リンクをまだ購入しているという人はこのタイミングできっぱりとやめましょう(笑)

4-1,被リンクが獲得できないか検討する

被リンクというのは非常に獲得し辛いものです。特にSNSからではないdofollowのリンクは獲得が難しい時代になっています。その分SEO効果が期待できるということもあり、それで有料リンクがなくならないというのはあると思いますが、当然バレれば厳しいペナルティ(手動対策)が待っていますので気をつけましょう。

被リンクでこういうときだからこそチェックしておきたい例としてもらえるはずのリンクがもらえていないケースです。

例えば

「グルメサイトAを運営しているとして居酒屋αが掲載されている。αの公式サイトからはグルメサイトB,Cに掲載されている旨は書いてあってリンクもあるが、Aにはない」

とか

「宿泊予約サイトAを運営しているとして、ある観光情報サイトに旅館αの情報が記述されている。そこからは宿泊予約サイトBとCの予約ができる詳細ページにリンクされているがAにはない」

こういうときに「うちにもリンクしてください!」とお願いをしてみるのはありだと思います。

特に後者で公共性の高い機関(観光協会のようなところ)がやっている場合はそういう機関だからこそ中立性担保のためにリンクしてくれることが多いです。

最近でも一社スタートアップの会社がそれでリンクを獲得していました。

海外では、「SEMrushとかAhrefsとかMajesticなどを使って競合の被リンクを調べてギャップを埋めましょう」なのが多い気がしますが、基本的には上記と同じようなことになるかなと思います。

メディアだと"被リンクが集まるコンテンツを作ろう"的考え方になると思いますが、どうやったら被リンクがもらえるコンテンツになるのかは私には分かりませんし、被リンクを目的にコンテンツを作るのもなんだかなあと思いますので、まずは被リンクする価値があるようなそこにしかない情報が含まれて高品質なコンテンツを作るということになると思います。

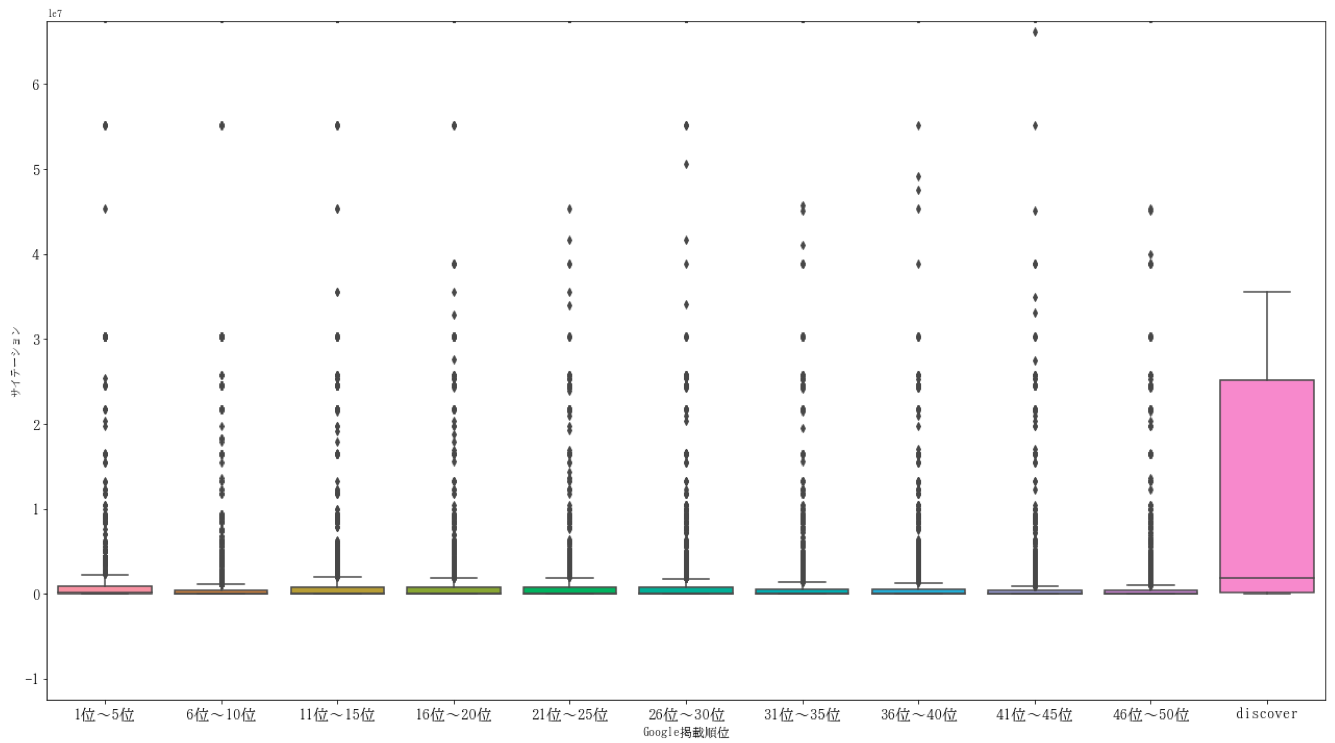

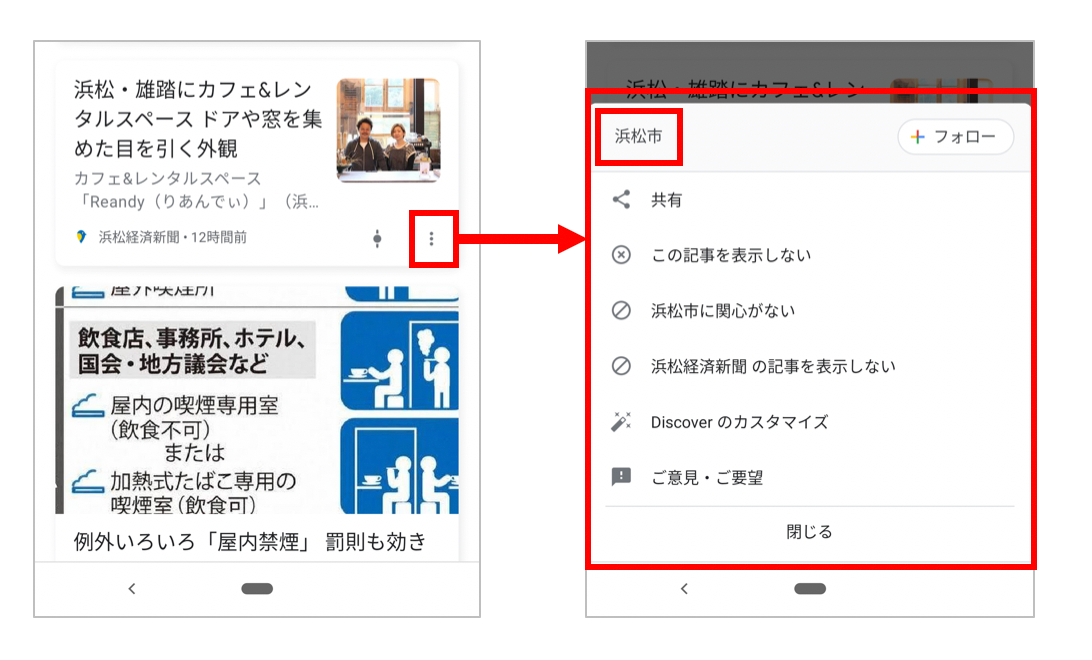

4-2,サイテーションが獲得できないか検討する

ここで言うサイテーションは、被リンクがあろうがなかろうが、そのサイトや会社や製品についてオンライン上で言及されるとか、指名検索されると考えてください。

先の被リンクの話がそのままサイテーション獲得に結び付くと思いますが、サイテーションだとSNSに対しての意識をより強めたほうが良いと思います。

このタイミングでSNS運用に力を入れてみるというのもできるのであればアリだと思います。

個人的にSNS運用がうまい(強い)ところはSEOが成功する可能性はかなり高まると思います。

強力なSNSアカウントでシェアされたコンテンツは自社コンテンツであっても伝播する可能性が高まるでしょう。

そのようなものが直接的にオーガニック検索で上位になるかどうかは別として、多くの人に見てもらうことによってリンクしてくれる人がいるかもしれませんし、様々なシグナルがGoogleに送られる可能性が出てくると思います。

とは言え、SNS運用には組織の理解が必要なので組織によってはこの時期だからこそやりにくいというのはあると思いますし、このような時期は炎上リスクが高まる時期とも言えるので慎重に運用する必要はあると思います。

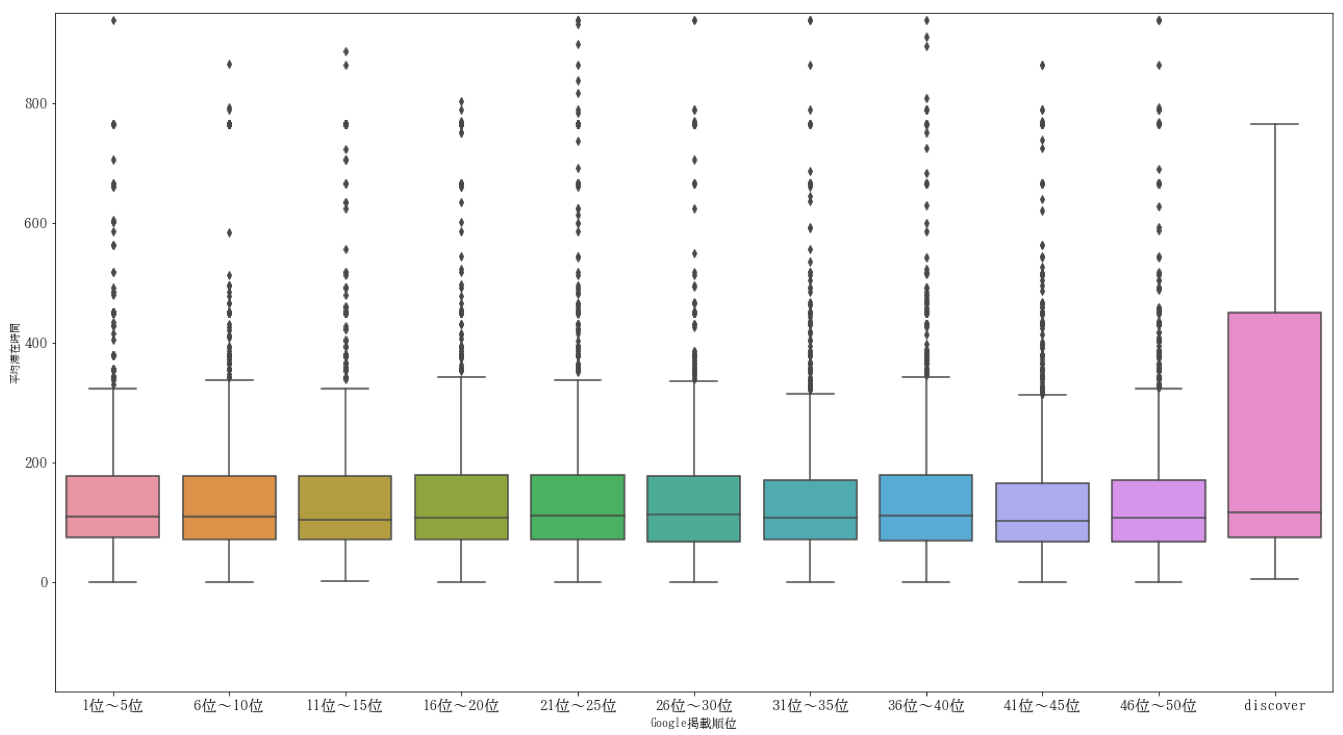

5,ユーザー行動におけるボトルネックを見直す

5-1,まずは理想的なユーザー行動について考える

理想的なユーザー行動はそのサイトやコンテンツによって変わります。

この理想的なユーザーはサイト運営者都合で考えすぎないことです。特に日本ではPVが重要視される傾向にあります。

そのため、情報コンテンツだと頭の部分だけ少し見せてから「もっと見る」「この記事をもっと読む」「全文を表示する」などで1ページ目を初めて表示するなどのUXが多くなっています。

また、情報コンテンツではそのコンテンツからいかに回遊するかで頭を悩ませる人も多いと思います。

これは、広告収益で運営しているサイトにとっては生命線なので理解できることではありますが、ユーザー側の視点に立つと情報コンテンツはそのページで課題解決できることが理想なわけです。

「換気扇掃除」のコンテンツがあり、

"そのページを読んだけど、いまいちしっくりこなくて別のページも探してやっと自分にあいそうな方法を見つける"

よりも

"そのページに自分にぴったりのものがあってそこから掃除をはじめる"

ほうが理想的なわけです。

一方で先に記した通りPVを稼がないといけない事情もあるでしょうから、ここはバランスをとる必要があると思います。

5-2,理想的なユーザー行動のためのボトルネックを見つけて修正する

理想的なユーザー行動が定義できたら、理想的なユーザー行動を阻害するものを仮説だったりツールを使った検証で発見して修正する必要があります。

表示が遅くて即離脱ばかりとか、(クリックされず収益にもならない)広告が多すぎるとか色々見えてくると思いますので、ひとつひとつ改善していく必要があるでしょう。

SEOの担当者だけでできないこともあるかもしれませんが、協力を仰ぐためにも可能な限り仮説と検証を行なっておきたいところです。

6,Googleの品質評価ガイドラインを読み直す

一番現実的なのがこれかもしれません(笑)

時間がある方かつ今までちゃんと読んだことがない方は本当に読んだほうがいいと思います。

読んだのが2年前だみたいな方も読み直したほうが良いと思います。

複数回読んだことがある人は個人的には評価例を見ると面白いと思います。

"Googleはこういうものを良いコンテンツだと考えているのか!"

というのが具体的に分かると思います。

長期戦になりそうですし、仮にかなりの長期戦になった場合で一時的にSEOがストップされるみたいなことがあったとしても、長期戦が明けたあとのSEOに必ず役立つと思います。

個人的には品質評価ガイドラインを読むと、そのたびにSEOレベルが1上がるような感覚があります。英語で読むのは大変ですが、読後の満足感も高いので悶々としやすいこの時期に読み切れると精神的にも良いのではないでしょうか?(謎)

Google 品質評価ガイドライン (General Guidelines) [PDF]

7,サイトやサービス、製品そのものの見直し

JADE長山さんが、昨年のWebmaster Conferenceで言われていたことと同じです。

今のSEOはウェブサイト上だけで完結しないことが多くなっています。

SEOで成功するには、そのプロダクトそのものが評判になったり、好意的に受け止められたり、人が紹介してくれることが必要なことが多くなっています。

また、コンテンツだけとってみても、既視感のあるものは上がりにくくなっています。

どれだけ人を惹きつけられる魅力的な、ユニークな、オリジナルな要素があるかというのがこれまでになく重要になっているはずです。

そして、ユーザーが使いやすいこと、良いユーザー体験を提供することもSEOには直接的か間接的かは別として重要になっているはずです。

既存のSEOという概念に囚われず、このタイミングで一度、より広い視点で考えてみると良いと思います。

おわりに

個人的にはセミナーができないとかミーティングが一部なくなったりとかで普段よりは時間がありますので、これらのことを考えてみたいと思っています。

皆さんはいかがでしょうか?ここに出ているものは私がここで考えてみようと思っていることです。

皆さんの置かれた環境、いまの状況によって考えるべきことは異なると思いますが、少しでも"考えるきっかけ"になったら嬉しいです。

先が見えない時代ですが、そもそもSEOなんて先が見えないことが多いので(笑)この状況でもやれることをやっていきたいものです。

@kimuyan